在《达摩院2022十大科技趋势》报告中,AI for Science被列为年度十大趋势之一,达摩院认为,“人工智能与科研深度结合,将成为科学家继计算机之后的新生产工具”。这意味着,如果科学家拥有超级智能助手“贾维斯”,人类的科学发展将进入新世代。日前闭幕的2022北京智源大会,阿里云基础设施大计算集群部总监曹政,从云端算力供给、科研开发平台入手,探讨云上的“AI for Science”。

科学活动分为三种:理论、实验和计算,这三驾马车相辅相成。如果说用AI模拟科学家的智能还太难,那么用AI代替传统的计算方法,对求解的科学问题进行快速建模则非常有效。近年来,人工智能在蛋白质结构预测、药物研发、材料研发等领域已积累了丰硕的应用成果。

AI与HPC加速融合,催生科研新范式

如DeepMD以神经网络代替经典科研计算手段(薛定谔方程/密度泛函求解),使计算复杂度从O(n³)降低到O(n),显著加速分子动力模拟的过程,同时大幅度降低了复杂问题解决的门槛,提升科研效率,促进更广泛的创新;类似的应用案例还有蛋白质空间结构预测、短临预报(中小尺度天气系统)等。

图 | 融合计算常见流程

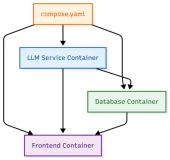

HPC(高性能计算集群)的计算结果作为输入,让AI从中自主学习规律,形成的神经网络再与HPC协同输出,多次迭代以获取高精度结果。

曹政认为:“AI for Science 是AI和HPC的‘化学反应’,HPC的计算和AI的计算过程紧密耦合,计算负载与通用计算有显著的差异。”

面向数据和应用,全链路优化计算效率

AI for Science对计算有全新的要求,不仅是更高性能的计算服务,还要考虑不同工具链和开发者生态的支持,阿里云从计算效率、开发协同效率、资源效率,三方面提供支持。

针对应用,提升计算效率

AI for Science的计算底座该如何构建?计算方案的设计需要从数据和应用出发,下面这个典型场景可以让我们了解科研场景的“计算负载”特征。

图 | 融合计算应用场景示例

以分子动力学应用为例,整个计算过程为搜索(Exploration)、高精度标注(Labeling)、深度学习(Training)三种环节,HPC、AI应用融合循环以进行迭代,直到获得达到目标精准度的分子动力学模型。过程中的应用会涉及CPU/GPU不同的计算芯片,计算效率的提升,第一个要解决的问题就是对多芯算力的融合。

面向未来:共中心架构

由于引入了配比多样的CPU/GPU异构计算系统,使得以CPU为中心的传统架构会遇到性能瓶颈、资源效率低下等问题。

从系统层面分析不同应用的计算负载差异:HPC应用主打高精度迭代计算(逻辑),需要面向小消息和低密度数据的通信特征,降低局部服务器节点间通信时延,以CPU多机计算为主,GPU仅作单机内辅助加速;在深度学习为代表的AI训练场景,不仅需要低延时保障,同时也对带宽有更高的要求,为了快速完成训练任务,对集群的通信性能要求更高。

为满足不同应用的计算负载,阿里云设计“共中心架构”,为集群构建融合网络层,资源深度共享,打造数据与算力之间的智能加速通道。

图 | 共中心架构

曹政认为:面向融合计算场景,“共中心”是未来系统架构的演进方向,即“不分主从”和“资源共有”,加速器和CPU不分主从,面向不同业务按需结合,通过软硬件的协同,实现全资源“中台化”/池化,为数据提供更智能的计算服务。

● 在HPC场景中,CPU是计算的核心,而在AI场景,GPU才是核心“生产力”。为了充分提升计算效率,阿里云于2018年提出“共中心集群架构”,存储/IO/网络等资源成为“中台”,并且保障高效的QoS(通信效率),不同的计算部件可按需“调用”,实现计算集群层面的“生产关系与生产力的适配”。

● 面向应用和数据,阿里云通过融合计算资源调度、融合通信库、融合存储等自研集群系统软件,实现资源层、计算层、数据层全局效率的优化,当前单集群算力最高可达3Exa-Flops,已经在内外部多个超大规模AI项目中得到验证。

共中心架构让云具备更高效的计算能力,以满足更复杂的计算需求,为科技创新提供云原生基础设施和平台服务。

促进协同,提升开发效率

在科研场景,数据和算力是核心资源。以开发者视角,通过高效的算力、工具链、工作平台提供研发支持,可以促进HPC和AI的开发生态互通,让开发者提升数据处理和模型开发效率,同时催化协同效应,加速创新效率。

阿里云具备丰富的数据和AI开发工具,可以完整支持AI研发生命周期和高效的数据管理能力,各种结构化和非结构化的数据都可以统一管理和分析,可视化的交互,使得不同规模机器学习任务都可以简单而高效地构建。

机器学习平台PAI

支持精细化团队协同的AI工作空间和AI资产管理平台,可以实现超大规模模型构建,支持面向应用层的全方位AI性能优化。PAI集成开源autoML框架NNI。PAI-DSW以jupyter插件形式集成NNI,让自动机器学习能力变得唾手可得;PAI-DLC分布式集群可进行NNI HPO分布式训练,提升使用效果。

普惠计算,提升资源效率

“当今云计算正处于一个新的发展阶段,越来越多数据密集型的计算,对算力提出了新的要求:即能满足弹性资源的需求,也保障并行计算效率,阿里云从软硬件自研技术入手,在一个超大规模高性能网络中,构建一个可以持续进化的“智能”算力系统,提升通信IO效率,消除“虚拟化税”,为社会提供普惠的智能计算服务。”曹政认为。

一个全新的云计算时代即将到来,全新的应用生态和全新的云计算基础设施正在被定义,以AI为代表的密集计算应用生态,需要高带宽、低时延的并行计算性能。阿里云通过深耕自研技术,为数智驱动型企业和机构,提供兼顾规模和效率的云计算服务,并且从开发者生态层促进社区和产业融合。相关产品具备混合云和公有云等灵活的部署形态,具备一致性用云体验,已经在车辆智能、新药研发、金融智能、城市智能等场景落地应用。