Qwen3:小而强,思深,行速

Qwen3(千问3)于北京时间4月29日凌晨发布,是Qwen系列大型语言模型的最新成员,具备全系列、开源最强、混合推理等特性。它包括两款MoE模型(Qwen3-235B-A22B和Qwen3-30B-A3B)及六个Dense模型,支持119种语言。Qwen3在代码、数学和通用能力测试中超越行业顶尖模型,如DeepSeek-R1和Grok-3。其旗舰版Qwen3-235B-A22B仅需4张H20即可本地部署,成本为DeepSeek-R1的35%。此外,Qwen3原生支持思考模式与非思考模式切换,降低复杂任务门槛,并支持MCP协议优化Agent架构。

全新开源通义千问Qwen3,它来了!

Qwen3是通义千问系列的最新模型,融合推理与非推理模式,兼具QwQ和Instruct模型能力。提供多种尺寸,包括235B-A22B、30B-A3B及六个Dense模型,大幅提升数学、代码、逻辑推理和对话能力,达到业界领先水平。旗舰模型Qwen3-235B-A22B在多场景测试中表现优异,小型模型如Qwen3-4B性能媲美大模型。用户可在阿里云百炼平台免费体验各100万Token。

大模型应用:大模型与智能体(Agent)的核心差异:从定义到实践全解析.34

本文深入解析大模型(LLM)与智能体(AI Agent)的本质区别:大模型是“智能大脑”,专注语言理解与生成,被动响应、无记忆、无工具调用;智能体是“闭环系统”,以大模型为核心,集成规划、记忆、工具调用与反思能力,可主动执行复杂现实任务。通过概念、流程、实例多维对比,厘清二者在技术定位、能力边界与应用场景上的根本差异。

2026年OpenClaw(养龙虾)+ 钉钉对接:保姆级全链路操作指南

本指南详解2026年OpenClaw(AI智能体)与钉钉深度对接的全链路实践:从环境搭建、钉钉应用配置、OpenClaw本地部署,到中间件开发与内网穿透,实现“钉钉发令—龙虾执行—自动回传”的24小时数字员工闭环。安全、可控、零数据出域。

Docker+vLLM内网离线部署Qwen3 流程

本教程详解如何在A10四卡内网环境中,通过Docker+ vLLM离线部署Qwen3-32B/Qwen3-VL-30B-Instruct大模型。涵盖环境准备、镜像离线导入、模型下载、容器启动及参数调优,支持FP8/KV缓存/张量并行等高性能配置,助力安全高效私有化推理

ollama + qwen2.5-coder + VS Code + Continue 实现本地AI 辅助写代码

本文介绍在Apple M4 MacOS环境下搭建Ollama和qwen2.5-coder模型的过程。首先通过官网或Brew安装Ollama,然后下载qwen2.5-coder模型,可通过终端命令`ollama run qwen2.5-coder`启动模型进行测试。最后,在VS Code中安装Continue插件,并配置qwen2.5-coder模型用于代码开发辅助。

MNN × Qwen 实战:离线运行大模型的正确姿势

本期教程带你用MNN+Qwen在手机端部署大模型,从安装MNN Chat体验离线对话,到源码编译、模型转换与推理测试,再到Android/iOS移动端部署全流程实战,并提供精度与性能调优秘籍,助力端侧AI创新挑战赛。

2026年智能体(Agent)怎么学?从入门到实战的全景避坑指南

2026年,AI进入“智能体元年”。本文系统解析智能体四大核心架构与Agentic Workflow设计模式,涵盖开发者、产品经理到业务人员的实战路径,助力把握AI代理红利期,实现从工具应用到架构创新的跃迁。

AI学习全景图:从大模型到RAG,从工具到变现,一条从0到1的路线

告别碎片化学习!本文系统梳理AI知识五层结构:从基础认知到商业变现,提供完整学习路径与优质资源链接。帮你构建AI知识网络,实现从工具使用到能力落地的跃迁。

通过API调用通义千问时出现DataInspectionFailed的解决办法(玄学版)

在使用qwen-plus API进行长文本翻译时,遇到了DataInspectionFailed错误,提示输入数据可能包含不当内容。尽管确认文本无敏感内容,但误判依然发生。通过将每个分段的字符数从1000降低到700,问题得以解决。建议在处理长文本时,减少每次请求的字符数以避免误判。

Agent与大模型的区别

本文详细对比了人工智能领域的两个重要概念——Agent和大模型。大模型如GPT-3、BERT等,擅长自然语言处理任务,如文本生成、翻译等;Agent则是自主的软件实体,能够在特定环境中感知、决策并执行任务,如管理日程、控制智能家居等。文章介绍了它们的定义、功能、技术架构及应用场景,并总结了两者的核心差异和未来发展方向。

阿里云千问3.5版本活动,Qwen3.5-Plus入门套餐4.5折起,每百万tokens价格低至0.8元

阿里云推出千问3.5版本活动,Qwen3.5-Plus实现原生多模态革新,性能提升且成本降低,支持1M token视频输入。千问3.5入门套餐首购低至4.5折,可抵扣全系大模型,阿里云提供先进GPU算力,支持大模型推理。企业级AI开发平台PAI,支持一键部署。此外,阿里云还推出了9.9元定制AI助理活动,展现AI领域成果。

DeepSeek——DeepSeek模型部署实战

本文介绍了DeepSeek大模型的本地部署方法、使用方式及API接入。首先,通过下载Ollama平台部署DeepSeek-R1模型,提供7种不同参数版本(1.5b至671b),用户可根据硬件选择合适的模型大小。接着,文章详细描述了如何在终端运行命令启动模型,并通过Chatbox官网下载并接入DeepSeek API,实现本地和云端模型的交互。最后,提及了DeepSeek官网和集成工具如POE的使用,帮助用户更好地利用DeepSeek进行开发和应用。

三分钟让Dify接入Ollama部署的本地大模型!

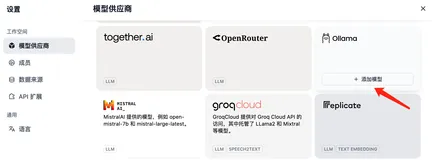

本文详细介绍了如何在 Dify 中接入 Ollama 模型,包括模型添加、参数配置及常见问题解决。通过运行 Ollama 服务并与 qwen2:0.5b 模型交互,实现本地化大模型应用开发。同时提供了 Docker、Mac、Linux 和 Windows 平台上 Ollama 的部署与环境变量设置指南,帮助开发者快速上手。更多实战技巧可访问[编程严选网](http://www.javaedge.cn/)或关注作者的 Github 仓库。

【完全免费】VS Code 最好用的 12 款 AI 代码提示插件!!!

🎉 探索12款免费VSCode AI代码提示插件:Codeium、Codegeex、CodeFuse、TONGYI Lingma、Comate、iFlyCode、Fitten Code、Bito AI、Mintlify Doc Writer、Kodezi AI、aiXcoder、IntelliCode。这些插件提供智能补全、代码生成、注释、优化,支持多种语言,提升编程效率!🚀👩💻👨💻

大模型应用:大模型本地化部署与API调用:打包迁移到服务器的多种方式实践.47

本文详解大模型从本地运行到云端API服务的全链路部署:涵盖硬件要求(GPU/CPU/内存)、软件环境(Python/FastAPI/Transformers)、模型选型(Qwen/ChatGLM等),并提供脚本部署、EXE打包(PyInstaller)和Docker容器化三种方案,支持局域网调用与接口文档自动生成,助力零基础用户快速实现“开箱即用”的稳定API服务。

深度解析智能体工作流(Agentic Workflows):核心概念、模式与应用

本文系统解析智能体工作流(Agentic Workflow),结合AI智能体的推理、工具与记忆能力,实现复杂任务的动态执行。内容涵盖核心概念、关键模式及实际应用,帮助读者全面理解其价值与挑战。

AgentScope 1.0 全面进化,从原型走向产业落地!

AgentScope全新升级,打造生产级智能体生态:推出开箱即用的Alias、EvoTraders等应用,支持多场景落地;强化基建,实现动态技能扩展、白盒化运行与多语言支持;集成语音交互、数据工程等能力,提供从开发到部署的全链路解决方案。

基于Spring AI Alibaba + Spring Boot + Ollama搭建本地AI对话机器人API

Spring AI Alibaba集成Ollama,基于Java构建本地大模型应用,支持流式对话、knife4j接口可视化,实现高隐私、免API密钥的离线AI服务。

阿里千问“驻桌”,阿里重构PC生产力

2025年11月26日,阿里巴巴宣布其AI大模型千问与夸克AI浏览器完成深度融合,做到了从手机端到PC端的无缝衔接,办公效率大大提升,同时夸克AI浏览器也释放了千问模型的能力。

最新版matlab r2025b安装图文教程(附安装包下载)方法

MATLAB R2025b发布:聚焦质量与稳定性提升,优化工具箱性能,修复R2025a已知Bug,增强可靠性。安装包已整合,可前往xu5软件库(www.xu5.cc)一键下载,附详细图文安装及激活教程。

大模型应用:CLIP 模型全维度解析:理解理论基础强化基础范例.16

CLIP是OpenAI提出的跨模态模型,通过对比学习将图像与文本映射至统一语义空间,实现零样本图文对齐。无需微调即可完成图像分类、图文检索等任务,显著降低标注成本,成为多模态AI的核心基础。

一句话生成拓扑图!AI+Draw.io 封神开源组合,工具让你的效率爆炸

一句话生成拓扑图!next-ai-draw-io 结合 AI 与 Draw.io,通过自然语言秒出架构图,支持私有部署、免费大模型接口,彻底解放生产力,绘图效率直接爆炸。

MCP详解:背景、架构与应用

模型上下文协议(MCP)是由Anthropic提出的开源标准,旨在解决大语言模型与外部数据源和工具集成的难题。作为AI领域的“USB-C接口”,MCP通过标准化、双向通信通道连接模型与外部服务,支持资源访问、工具调用及提示模板交互。其架构基于客户端-服务器模型,提供Python、TypeScript等多语言SDK,方便开发者快速构建服务。MCP已广泛应用于文件系统、数据库、网页浏览等领域,并被阿里云百炼平台引入,助力快速搭建智能助手。未来,MCP有望成为连接大模型与现实世界的通用标准,推动AI生态繁荣发展。

千问APP来咯!会聊天,能办事,还免费!!

千问APP公测上线!基于全新Qwen3模型,打造全能AI助手,覆盖办公、地图、健康、购物等多场景,免费畅享智能聊天与办事体验。即刻下载,让AI成为你的日常伙伴。

vLLM 架构学习指南

本指南深入解析vLLM高性能推理引擎架构,涵盖核心创新PagedAttention与连续批处理技术,结合代码结构、学习路径与实践建议,系统指导用户从入门到贡献源码的全过程。

一个提示词模板,搞定抖音短视频脚本创作

专为技术人打造的抖音脚本提示词模板,结构化拆解短视频创作套路,结合DeepSeek、通义千问等AI工具,快速生成可执行脚本框架,助力技术分享、产品演示高效落地,30秒讲清重点,开头抓人、节奏紧凑、完播率提升。

构建AI智能体:九十八、实践出真知:本地AI大模型部署的核心要点与经验总结

本文介绍了如何在个人电脑上加载和运行轻量级AI大语言模型。首先解析了大语言模型的基本概念和工作原理,包括Tokenizer、Prompt等关键术语。然后详细演示了三种模型加载方式:通过ModelSpace下载Qwen模型、使用HuggingFace加载BERT模型、利用SentenceTransformer获取句子嵌入。特别强调了在CPU环境下的配置技巧,如设置torch.float32数据类型和优化内存使用。文章还提供了完整的中文对话生成示例代码,展示了Qwen1.5-1.8B-Chat模型的实际应用效果

通义万相2.5-图生视频-Preview,模型使用指南

该表格展示了多个设计场景,包括模型选择、复制粘贴提示词与图片、一键生成视频等步骤。每个步骤配有详细描述及示意图,呈现了不同主题和风格的设计构思与实现方式。

大模型应用:大模型的本地 API 服务:FastAPI 封装与接口鉴权.44

本文详解本地大模型API的接口发布与鉴权调试,重点介绍Postman工具实操。涵盖FastAPI封装原理、API Key与极简JWT两种鉴权方式,深入解析JWT结构(Header/Payload/Signature)、无状态验证、过期机制及完整调用流程,助开发者安全、高效调试本地大模型服务。

从入门到精通:手把手教你用LLaMA Factory微调专属大模型

大家好,我是AI博主maoku老师。你是否觉得大模型“懂王”式回答不够专业?微调正是破局关键!本文带你深入浅出理解微调原理,掌握LoRA、量化、对话模板三大核心技术,并手把手教你用LLaMA Factory零代码实践,四步打造专属Web安全专家模型。从数据准备到部署应用,全程实战,助你将大模型从“通才”炼成“专才”,实现个性化、低成本、高效率的AI赋能。

大模型应用:大模型驱动智能体协同实现:技术原理与实战落地全解析.35

本文详解大模型与智能体融合机制:大模型作为“大脑”负责理解与规划,智能体作为“手脚”执行工具调用,通过Prompt驱动实现“感知→规划→执行→整合”闭环。以销售分析智能体为例,完整呈现端到端自动化实践,显著提升任务落地能力、结果准确性与业务实用性。

Cursor + qwen2.5-coder 32b 的配置方式

安装Cursor后,进入设置修改OpenAI基础URL为阿里云的DashScope接口,并添加Qwen2.5-Coder 32B模型。需先访问阿里云百灵控制台申请免费Key。配置完成后,即可使用该模型进行开发和测试。

Qwen3技术报告首次全公开!“混合推理模型”是这样炼成的

近日,通义千问Qwen3系列模型已开源,其技术报告也正式发布。Qwen3系列包含密集模型和混合专家(MoE)模型,参数规模从0.6B到235B不等。该模型引入了“思考模式”与“非思考模式”的动态切换机制,并采用思考预算机制优化推理性能。Qwen3支持119种语言及方言,较前代显著提升多语言能力,在多个基准测试中表现领先。此外,通过强到弱蒸馏技术,轻量级模型性能优异,且计算资源需求更低。所有Qwen3模型均采用Apache 2.0协议开源,便于社区开发与应用。

向量数据库终极指南:AI开发者的进阶手册

本文深入解析向量数据库的原理与实战应用,涵盖其在AI系统中的核心作用、关键技术(如HNSW、PQ、LSH)、相似性搜索、元数据过滤及无服务器架构优势。适合开发者和AI从业者学习提升。

2026年的企业级 AI 应用:工作流的边界,与 Coding 的回归

2026年,企业级AI应用进入新分水岭:工作流解决启动快,代码承载长期复杂性。Dify、n8n等平台正补工程能力,LangGraph等框架则增强编排性。核心命题已非“二选一”,而是——**Workflow管编排,Code管核心**:低风险场景用可视化,高可靠需求回归代码优先。(239字)

使用 yt-dlp 二次开发, 快速下载 YouTube等平台高清视频工具开发

想从多个平台下载高清无水印视频?本文教你使用 `yt-dlp` 工具轻松实现!支持 YouTube、B站、抖音等主流平台,提供代码示例与解析,涵盖批量下载、字幕提取、音频分离等高级功能。无论你是开发者还是普通用户,都能快速上手,高效获取所需视频资源。

基于NVIDIA A30 加速卡推理部署通义千问-72B-Chat测试过程

本文介绍了基于阿里云通义千问72B大模型(Qwen-72B-Chat)的性能基准测试,包括测试环境准备、模型部署、API测试等内容。测试环境配置为32核128G内存的ECS云主机,配备8块NVIDIA A30 GPU加速卡。软件环境包括Ubuntu 22.04、CUDA 12.4.0、PyTorch 2.4.0等。详细介绍了模型下载、部署命令及常见问题解决方法,并展示了API测试结果和性能分析。

大模型应用:混合专家模型(MoE):大模型性能提升的关键技术拆解.37

MoE(混合专家模型)是一种高效大模型架构,通过“智能调度+稀疏激活”机制,让多个专业化子网络(专家)按需协作。它兼顾性能与效率:参数规模大但推理仅激活2-4个专家,显著降本提速;既保持通用能力,又在医疗、法律等细分领域更专精,是当前大模型落地的关键技术。

深度测评:DeepSeek 对话导出工具 Top 3,公式不乱码、排版零折损的终极方案

本文为AI技术博主推荐三款高效导出DeepSeek对话的工具:专为iOS/macOS设计的“DS随心转”App,支持多格式且完美保留代码高亮与公式;轻量便捷的浏览器扩展“DeepSeek Share”,适用于Chrome等主流浏览器;以及内置在QQ浏览器中的导出功能,无需额外安装,适合日常快速存档。结合官方导出方式与使用建议,帮助用户根据设备与需求选择最佳方案,同时提醒注意数据隐私与兼容性问题。

高效部署通义万相Wan2.1:ComfyUI文生/图生视频实战,工作流直取!

通义万相Wan2.1开源不到一周,已登顶HuggingFace Model 和 Space 榜双榜首,在HuggingFace和ModelScope平台的累计下载量突破100万次,社区热度持续攀升!为响应小伙伴们对ComfyUI工作流运行Wan2.1的强烈需求,社区开发者整理了实战教程👇

大模型应用:本地大模型部署中的Token效率优化与性能分析.9

本文基于Qwen1.5-1.8B-Chat模型,构建了完整的Token监控与优化系统,深入分析对话中Token消耗模式,涵盖分词原理、多轮累积统计、上下文压缩、Prompt精简及响应长度控制等策略,为中小规模大模型的高效、低成本部署提供可复用方案。

在openclaw(原Clawdbot)中配置 智增增API

OpenClaw(原Clawdbot)火爆出圈!本文提供一键部署教程及QQ/企微/钉钉/飞书/Discord等多平台接入方案,助你快速打造专属云AI助理。支持DeepSeek、阿里、百度、腾讯、OpenAI等全主流大模型,配置智增增API即可即刻启用!