2023年初,ChatGPT 人工智能对话模型火爆全球,仅两个月的时间就突破一亿月活用户,成为有史以来应用速度最快的技术之一。

ChatGPT 的大热引发了全球科技巨头之间的“军备竞赛”,中国本土的“中国版 ChatGPT ”也随之展开了激烈角逐。在中国多家科技公司中,百度于3月上线的对话 AI 产品“文心一言”最先开火。

近日复旦大学自然语言处理实验室邱锡鹏教授团队研发的大语言模型 MOSS 也已公开发布并开源。MOSS 的公开发布无疑加剧了国内 ChatGPT 式产品的竞争。

MOSS 是什么?

MOSS 是一个支持中英双语和多种插件的开源对话语言模型,moss-moon系列模型具有160亿参数,在 FP16 精度下可在单张 A100/A800 或两张 3090 显卡运行,在 INT4/8 精度下可在单张 3090 显卡运行。MOSS 基座语言模型在约七千亿中英文以及代码单词上预训练得到,后续经过对话指令微调、插件增强学习和人类偏好训练具备多轮对话能力及使用多种插件的能力。

申请服务器

这里使用阿里云免费的 GPU 服务器进行部署,免费试用活动页 https://free.aliyun.com/ 。

只要没有申请过 PAI-DSW 资源的新老用户皆可申请 5000CU 的免费额度,3个月内使用。

点击试用,完成注册、实名、领取产品后进入如下页面。

创建工作空间并授权。

授权完成,前往默认工作空间。

创建交互式建模(DWS)实例。

输入实例名称,就叫它 550W 吧~,GPU 选择 A10 或者 V100 都行,这俩是支持资源包抵扣的,其他的不支持,这里注意!V100 性能更好,但我们测试使用没必要,就选 A10 就行,A10 显卡每小时消耗6.991计算时,如果不关机持续使用大概可以使用30天。

数据集是可选的,如果想闲时关机建议使用数据集,可以把数据保存,不然每次关机后启动都得重新部署。

选择镜像 URL,填入与地区对应的镜像地址。

杭州地域:dsw-registry-vpc.cn-hangzhou.cr.aliyuncs.com/cloud-dsw/eas-service:aigc-torch113-cu117-ubuntu22.04-v0.2.1_accelerated

北京地域:dsw-registry-vpc.cn-beijing.cr.aliyuncs.com/cloud-dsw/eas-service:aigc-torch113-cu117-ubuntu22.04-v0.2.1_accelerated

上海地域:dsw-registry-vpc.cn-shanghai.cr.aliyuncs.com/cloud-dsw/eas-service:aigc-torch113-cu117-ubuntu22.04-v0.2.1_accelerated

深圳地域:dsw-registry-vpc.cn-shenzhen.cr.aliyuncs.com/cloud-dsw/eas-service:aigc-torch113-cu117-ubuntu22.04-v0.2.1_accelerated

然后点击下一步,耐心等待实例创建,这个过程还是比较耗时的。

部署 MOSS

实例创建成功后,点击打开,进入控制台。

进入下面这个页面后,点击 “Terminal” 进入命令行。

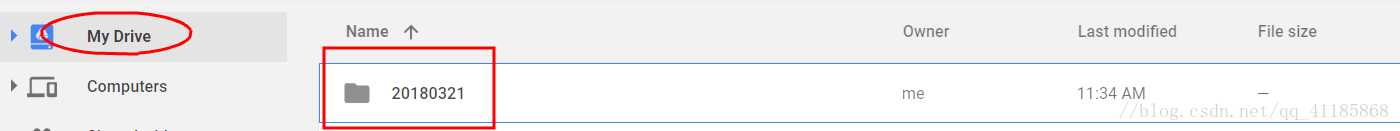

1、下载仓库内容到本地

# git clone https://github.com/OpenLMLab/MOSS.git

2、进入MOSS文件夹

# cd MOSS

3、修改 requirements.txt

torch==1.10.1 改为 torch==1.13.1

4、安装依赖

# pip install -r requirements.txt

5、修改 moss_cli_demo.py 文件第 31 至 33 行

model = load_checkpoint_and_dispatch(

raw_model, model_path, device_map="auto", no_split_module_classes=["MossBlock"], dtype=torch.float16, max_memory={0: "18GiB", "cpu": "26GiB"}

)

6、启动服务,第一次启动需要下载模型,耐心等待

# python moss_cli_demo.py

等待一段时间后,出现以下对话框就是安装成功了,你就可以跟MOSS对话啦~

总结

MOSS 的公开无异于宣告与百度对话模型的“正面竞争”,这场人工智能的“决战”注定轰动一时。未来几个月, ChatGPT 式对话产品将在中国大行其道,而 MOSS 和“文心一言”的 PK 则成为行业和公众最关心的话题。这场竞赛的结果,将对中国在人工智能领域的地位产生重大影响。人工智能时代的创新,正在以前所未有的速度在中国大陆蔓延。

MOSS 和“文心一言”的竞逐,只是 AI 产业发展的序章。随着竞争不断升级,未来的 AI 产品将更加智能,技术创新更加频繁。中国终将在这场科技革命的浪潮中,占领一席之地。