1.算法仿真效果

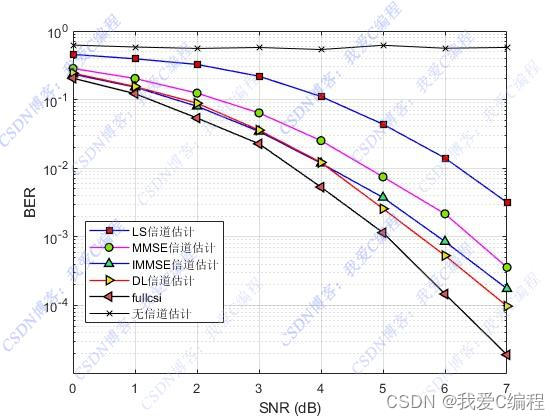

本程序系统是《m基于深度学习的OFDM信道估计和均衡算法误码率matlab仿真,对比了LS,MMSE以及LMMSE等传统的信道估计算法》的的升级。

升级前原文章链接

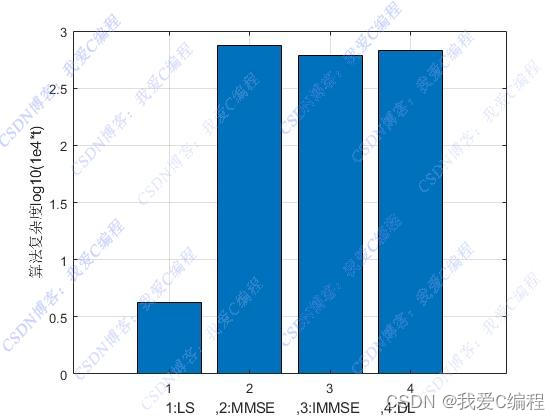

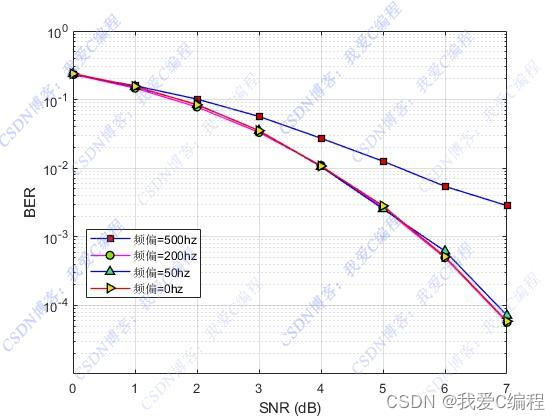

增加了训练样本自动产生功能,算法复杂度对比功能,算法抗频偏性能分析功能。

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

随着无线通信的快速发展,5G正逐渐成长为支撑全社会各行业运作的大型基础性互联网络,其服务范围的大幅扩展对底层技术提出了诸多挑战,尤其是作为物理层关键技术之一的正交频分复用(Orthogonal Frequency Division Multiplexing,OFDM)。近来,深度学习因其在计算机视觉以及自然语言处理领域中的优异表现而备受关注,其极强的普适性也为传统通信提供了新的发展空间。就OFDM系统中的信道估计问题展开深入研究,探索深度学习在该领域的应用可能。

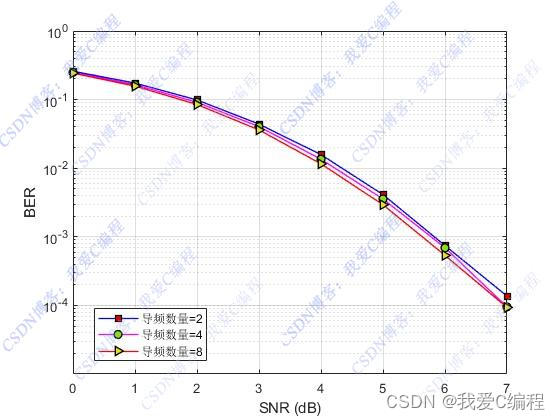

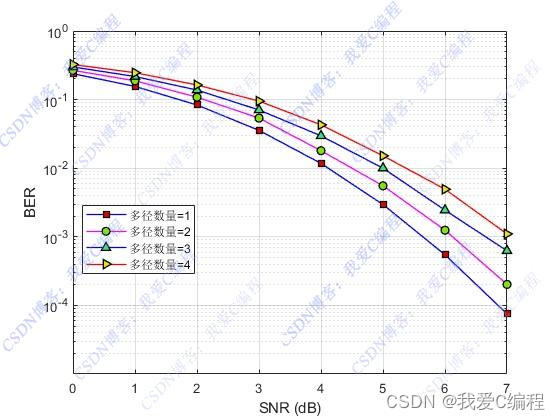

信道估计器是接收机一个很重要的组成部分。在OFDM系统中,信道估计器的设计上要有两个问题:一是导频信息的选择,由于无线信道的时变特性,需要接收机不断对信道进行跟踪,因此导频信息也必须不断的传送: 二是既有较低的复杂度又有良好的导频跟踪能力的信道估计器的设计,在确定导频发送方式和信道估计准则条件下,寻找最佳的信道估计器结构。 **在实际设计中,导频信息的选择和最佳估计器的设计通常又是相互关联的,因为估计器的性能与导频信息的传输方式有关。

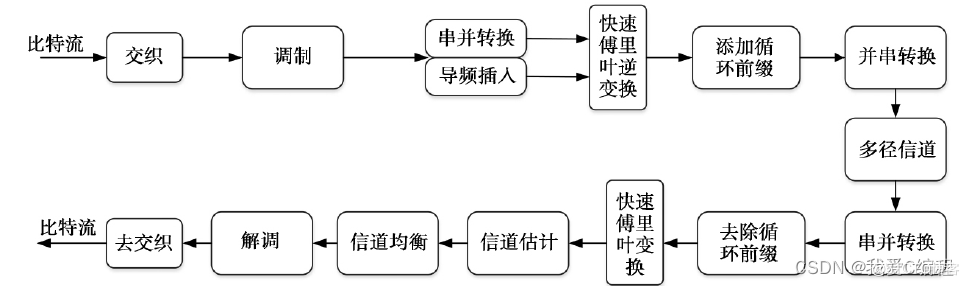

基于OFDM 的通信系统如下:

基于深度学习的信道估计:

深度学习(英语:deep learning),是一个多层神经网络是一种机器学习方法。在深度学习出现之前,由于诸如局部最优解和梯度消失之类的技术问题,没有对具有四层或更多层的深度神经网络进行充分的训练,并且其性能也不佳。但是,近年来,Hinton等人通过研究多层神经网络,提高学习所需的计算机功能以及通过Web的开发促进培训数据的采购,使充分学习成为可能。结果,它显示出高性能,压倒了其他方法,解决了与语音,图像和自然语言有关的问题,并在2010年代流行。

深度学习(Deep Learning, DL),由Hinton等人于2006年提出,是机器学习(MachineLearning, ML)的一个新领域。深度学习被引入机器学习使其更接近于最初的目标----人工智能(AI,Artificial Intelligence)。深度学习是学习样本数据的内在规律和表示层次,这些学习过程中获得的信息对诸如文字、图像和声音等数据的解释有很大的帮助。它的最终目标是让机器能够像人一样具有分析学习能力,能够识别文字、图像和声音等数据。深度学习是一个复杂的机器学习算法,在语言和图像识别方面取得的效果,远远超过先前相关技术。它在搜索技术、数据挖掘、机器学习、机器翻译、自然语言处理、多媒体学习、语音、推荐和个性化技术,以及其它相关领域都取得了很多成果。深度学习使机器模仿视听和思考等人类的活动,解决了很多复杂的模式识别难题,使得人工智能相关技术取得了很大进步。 基于深度学习的参数估计方法DL-CE,采用LS方法获取导频位置处的CFR,再通过所设计的深度学习估计网络获取各个数据符号位置的信道响应。由于在多径环境下,信道呈现频域选择性衰落,传统的线性插值方法无法跟踪信道的变化。基于深度学习的信道估计方法,同时估计信道响应与信道的频域相关系数,可以实时追踪信道的频域变化。

3.MATLAB核心程序```load DL_train\dl.mat

for i=1:length(SNR_dB)

i

Error = 0;

err_all = 0;

for iii=1:nloop(i)

%%

%以单天线方式产生测试信号

msg = rand(LenNc/4,1)>=0.5;

%turbo编码

seridata1 = func_turbo_code(msg,N,M);

seridata = [seridata1,zeros(1,LenNc-length(seridata1))]';

%QPSK映射

[Qpsk0,Dqpsk_pilot,symbol_bit] = func_piQPSK_mod(seridata);

%变换为矩阵

Qpsk_matrix = reshape(Qpsk0,fftlen,Nc);

[Pilot_in,pilot_num,Pilot_seq,pilot_space] = func_insert_pilot(Dqpsk_pilot,Qpsk_matrix,pilot_type,T,TG);

Pilot_in = fft(Pilot_in);

%sub carrier mapping

Pilot_in = func_subcarrierMap(Pilot_in);

%IFFT transform,产生OFDM信号

ifft_out = ifft(Pilot_in);

%插入包含间隔 ,循环前缀

Guard_int = ceil(BWs/fftlen);

Guard_int_ofdm = func_guard_interval_insert(ifft_out,fftlen,Guard_int);

%将矩阵数据转换为串行进行输出

Guard_int_ofdm_out = reshape(Guard_int_ofdm,1,(fftlen+Guard_int)*(Nc+pilot_num));

%%

%Step1:大规模MIMO信道

[Hm,Hmmatrix] = func_mychannels(Radius,Scale1,Scale2,Nh,Nv);

%Step2:多径参数和大规模MIMO参数输入到信道模型中

%信道采样点数,每个调制符号采一个点

[passchan_ofdm_symbol] = func_conv_channels(Hmmatrix,Guard_int_ofdm_out,Nmultipath,Pow_avg,delay_multi,Fre_offset,timeval,iii);

%Step3:噪声信道

Rec_ofdm_symbol = awgn(passchan_ofdm_symbol,SNR_dB(i),'measured');

%%

%开始接收

Guard_int_remove = func_guard_interval_remove(Rec_ofdm_symbol,(fftlen+Guard_int),Guard_int,(Nc+pilot_num));

%FFT

fft_out = fft(Guard_int_remove);

%sub carrier demapping

fft_out = func_desubcarrierMap(fft_out);

fft_out = ifft(fft_out);

%信道估计

%func_DL_est

[Sig_Lrmmse,Hs] = func_DLest(fft_out,pilot_space,Pilot_seq,pilot_num,delay_avg/timeval,4e-6/timeval,10^(SNR_dB(i)/10),Guard_int);

%解调

Dqpsk = func_pideMapping(Sig_Lrmmse,fftlen*Nc);

%turbo解码

Dqpsk_decode = [func_turbo_decode(2*Dqpsk(1:end-(Len*Nc-length(seridata1)))-1,N,M)]';

%计算误码率

err_num = Len*Nc/4-length(find(msg==Dqpsk_decode(1:Len*Nc/4)));

Error = Error + err_num;

end

%计算误码率

err_all = err_all+Len*Nc/4;

Err_Rate(i) = Error/err_all/nloop(i);

end

......................................

0sj_001m

```