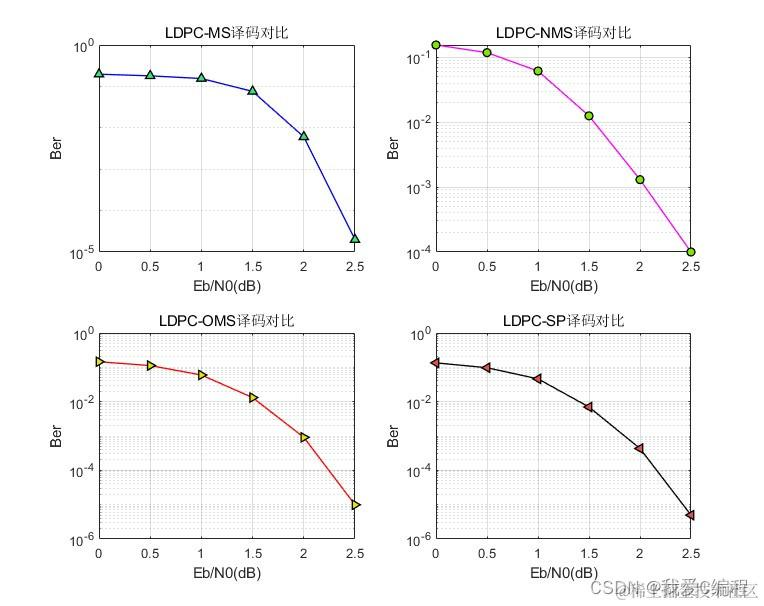

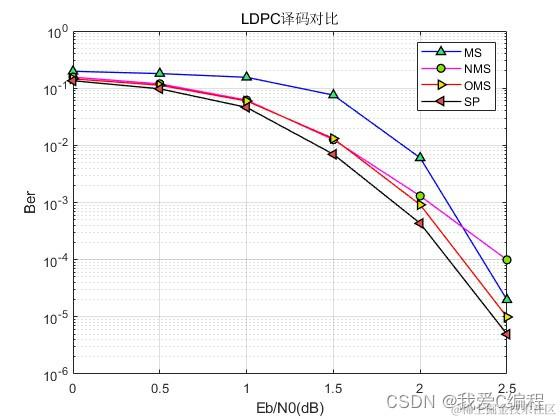

1.算法仿真效果

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

低密度奇偶校验码(LDPC)译码是现代通信系统中一种高效的错误校正技术,广泛应用于无线通信、卫星通信和数据存储等领域。LDPC码因其良好的纠错性能和接近香农极限的潜力而受到重视。本文将详细对比四种主流的迭代译码算法:Sum-Product (SP)、Min-Sum (MS)、Normalized Min-Sum (NMS) 和 Offset Min-Sum (OMS)。

2.1 Sum-Product (SP) 算法

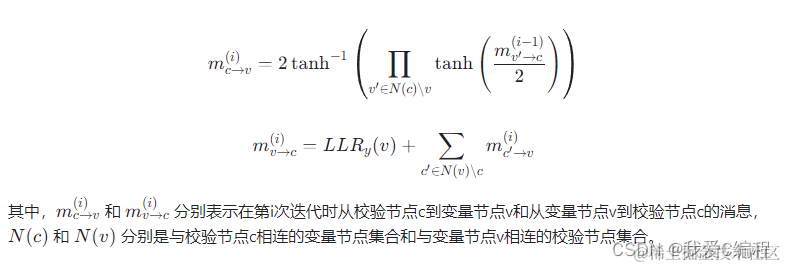

SP算法基于概率论中的信念传播思想,通过迭代的方式逐步修正对每个码字位的估计。它利用校验节点和变量节点之间的消息传递来更新对每个位的置信度。设H为校验矩阵,LLR_y为接收到的软判决信息(对数似然比),消息通过校验节点到变量节点(CN→VN)和变量节点到校验节点(VN→CN)的传递分别表示为:

2.2 Min-Sum (MS)算法

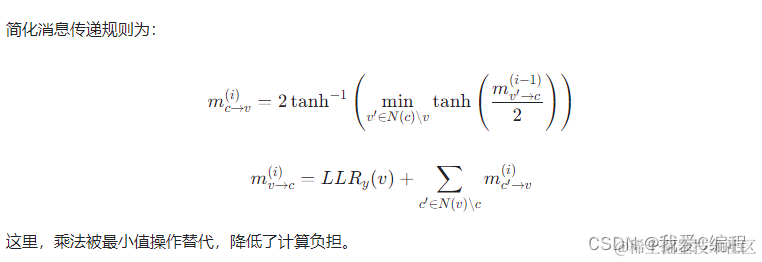

MS算法是对SP算法的一种简化,它放弃了乘法运算,转而使用最小值操作来近似概率乘积,降低了计算复杂度,但牺牲了一定的性能。

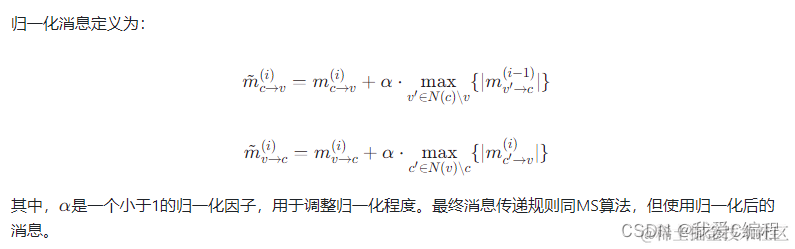

2.3 Normalized Min-Sum (NMS) 算法

NMS算法是对MS算法的改进,通过引入归一化因子来补偿由于最小值操作导致的性能损失,提高了算法的准确性。

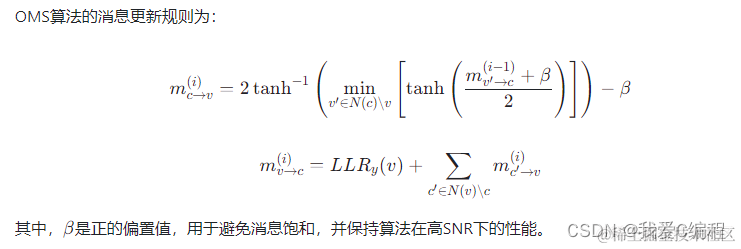

2.4 Offset Min-Sum (OMS)算法

OMS算法通过引入偏置项(offset)来解决MS算法在高信噪比条件下性能下降的问题,提高了算法的稳健性。

准确度:SP算法理论上最准确,但计算成本最高。NMS和OMS通过不同机制改进了MS算法的性能,NMS通过归一化提升了低SNR下的性能,而OMS通过偏置项优化了高SNR下的性能。

计算复杂度:MS算法最低,NMS和OMS虽然增加了计算复杂度,但相比SP仍显著降低。

适用场景:对于资源有限的应用,MS和OMS因其较低的复杂度而更受欢迎;在对性能要求极高的场合,NMS或SP可能更合适。

3.MATLAB核心程序

```for jj = 1:1:length(SNR)

%仿真帧

Frames = 50;

error1 = 0;

cout = 0;

sigma = sqrt(1/10^(SNR(jj)/10));

for i = 1:1:Frames

[i,SNR(jj) ]

%编码

msg = randi([0, 1], 1, 1008);

msg_encode = func_Encoder(Hs, msg);

%调制

bpsk_encode = 1 - 2.*msg_encode;

%AWGN

bpsk_N = awgn(bpsk_encode,SNR(jj),'measured');

%接收

llr = 2*bpsk_N/(sigma^2);

ydecode = func_MS( H, llr, Iters );

errs = sum(msg ~= ydecode);

error1 = error1 + errs;

cout = cout + 1;

end

Ber(1, jj) = error1/(K * cout);

end

figure

semilogy(SNR, Ber,'-b^',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.2,0.9,0.5]);

xlabel('Eb/N0(dB)');

ylabel('Ber');

title('最小和MS')

grid on;

save MS.mat SNR Ber

```