问题一:请教下,使用flink cdc同步数据到hudi ,如果mysql 字段有新增,怎么弄

请教下,使用flink cdc同步数据到hudi ,如果mysql 字段有新增,怎么弄

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/503721?spm=a2c6h.13066369.question.16.2ac075ebuSZId5

问题二:Flink CDC mysql同步到doris,从哪里出来的?想问下有什么思路么?

Flink CDC mysql同步到doris,报数据类型转换错误 Caused by: java.lang.NumberFormatException: For input string: "UTF8MB4'0",分析不出来这个 "UTF8MB4'0" 从哪里出来的?想问下有什么思路么?CREATE TABLE mysql表 (

id int(11) unsigned NOT NULL AUTO_INCREMENT ,

project_id int(11) unsigned NOT NULL DEFAULT '0' ,

faq_id int(11) unsigned NOT NULL DEFAULT '0',

elasticsearch_id varchar(30) DEFAULT NULL,

question longtext NOT NULL COMMENT,

created_time int(11) unsigned NOT NULL DEFAULT '0' ,

updated_time int(11) unsigned NOT NULL DEFAULT '0',

PRIMARY KEY (id) USING BTREE,

KEY idx_faq_id (faq_id) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=13540 DEFAULT CHARSET=utf8mb4 ROW_FORMAT=DYNAMIC ;

参考答案:

根据您提供的错误信息和建表语句,错误出现在数据类型转换上,具体是因为无法将字符串 "UTF8MB4'0" 转换为数字类型。

从您提供的建表语句来看,这个错误可能是由于在 DEFAULT 子句中的默认值设置出现了问题。在您的建表语句中,project_id、faq_id、created_time 和 updated_time 字段的默认值都被设置为 '0'。

然而,根据您提供的错误信息,看起来 project_id 字段的默认值被解析为了 "UTF8MB4'0",这是一个非法的数字格式,导致了数据类型转换错误。

解决这个问题的思路如下:

检查数据源表中的数据,确保这些字段的默认值都是合法的数字格式。可能存在某些数据不符合预期,导致了该错误。您可以检查数据表中的默认值,并确保它们都是数字类型,没有包含非法字符。

检查 Flink CDC Connector 的配置,确保正确解析和传输数据。请确认 Flink CDC Connector 的源表和目标表的字段映射关系是否正确,以及是否正确解析和转换数据类型。

检查目标表的定义,确保目标表的字段类型和源表的字段类型匹配。您提到数据同步到 Doris 数据库,因此请确保目标表的字段类型与源表的字段类型相匹配,特别是默认值的类型和格式。

以上是解决问题的一些思路和建议。如果问题仍然存在,请提供更多的错误信息、完整的配置和代码,以便我能够更准确地帮助您解决问题。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/550899?spm=a2c6h.13066369.question.17.2ac075eb2ZYaqk

问题三:大佬请教个有关flink cdc 同步数据的报错有遇到过的吗?好像只有这个最新版本的才支持db2吧,

大佬请教个有关flink cdc 同步数据的报错有遇到过的吗?好像只有这个最新版本的才支持db2吧,现在又不能确定是版本的问题,也没有说新版本修复这个问题呀

参考答案:

db2不熟呀,这应该是debezium的问题吧,数据转换格式的问题在debezium,你搜搜下,是不是在高阶版本修复了,我的意思是debezium的版本。和cdc没关系,不清楚能,国内用DB2的还是比较少,你去stackoverflow搜搜看,

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/514125?spm=a2c6h.13066369.question.20.2ac075ebu4w5WI

问题四:Flink CDC我是在程序里面把整库同步进行了集成,用savepoint重启任务就是报错?

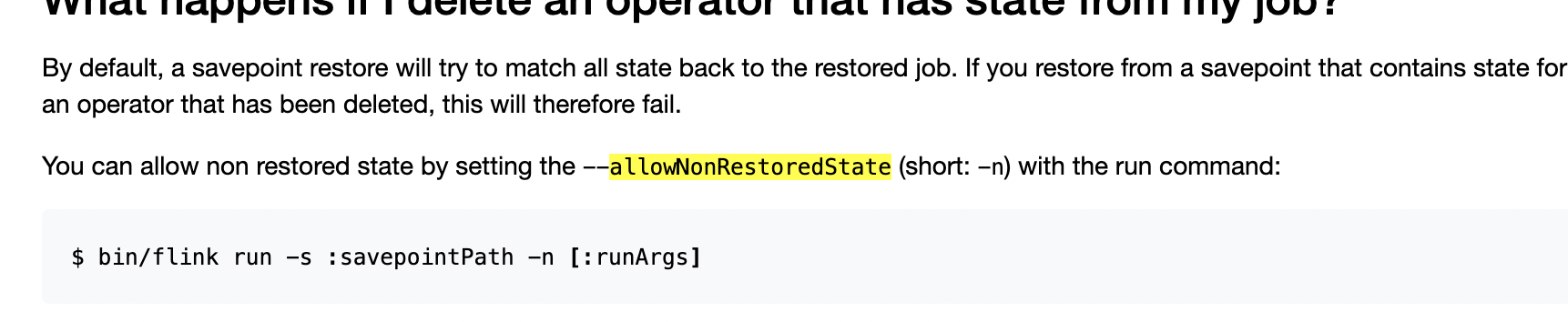

问题1:Flink CDC我是在程序里面把整库同步进行了集成,程序里启停任务,现在问题是同步数据时候,以前是5张表,一个任务,现在改为7张表一个任务后,用savepoint重启任务就是报错?需要设置allowNonRestoredState参数

问题2:命令方式,我也看到有,就是程序里配置,一直找不到

参考答案:

回答1:

回答2:程序代码方面找不到,命令行启动就行或者有web-ui界面,去启动,

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/550824?spm=a2c6h.13066369.question.19.2ac075ebpBwaUN

问题五:大佬们 FLink CDC同步数据的时候 Checkpoint 一直在增大,有什么好的处理方式吗? 用的RocksDB

大佬们 FLink CDC同步数据的时候 Checkpoint 一直在增大,有什么好的处理方式吗? 用的RocksDB

参考答案:

换后端类型,换成rocksdb 状态后端。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/497221?spm=a2c6h.13066369.question.20.2ac075ebo1knAu