从 Image-to-LoRA 到 In-Context Edit

阿里发布Qwen-Image-Edit-2511-ICEdit-LoRA模型,通过上下文内编辑技术,利用“编辑前后图像对”实现图像编辑能力迁移。该模型仅需少量样本即可训练,支持风格、光照、表情等复杂编辑,并可拓展至图像分割等视觉任务,未来将持续优化与应用探索。

Python 微服务架构实践:从模块化到轻量级分布式

本文详解Python微服务落地路径:从模块化拆分、轻量框架封装,到服务通信、注册发现,再到Docker容器化部署与监控运维,系统阐述中小团队如何以低成本实现“低耦合、快迭代”的分布式架构。

Linux 项目实战入门:从 0 到 1 搭建 LNMP 网站环境

本文手把手教你从零搭建LNMP网站环境,涵盖CentOS 7虚拟机配置、Nginx+MySQL+PHP安装与联动设置,提供详细命令与排错指南,并扩展部署WordPress实战,助你快速掌握Linux Web环境核心技能。

Java 学习资源精选:从入门到精通的高效资源清单

本文为Java学习者提供从入门到精通的完整资源指南,涵盖各阶段所需视频、书籍、博客、开源项目等优质资源。针对基础语法、核心原理、主流框架及项目实战,精选高效学习路径,帮助初学者摆脱“资源焦虑”,少走弯路,提升学习效率,系统掌握Java开发能力,实现技术进阶。

智谱开源GLM-ASR:动动嘴,活就干了

智谱发布并开源GLM-ASR系列语音识别模型,推出桌面端AI输入法。包含云端旗舰模型GLM-ASR-2512与端侧轻量版GLM-ASR-Nano-2512(仅1.5B参数),实现高精度、低延迟、强隐私保护的语音转写。输入法集成大模型能力,支持语音指令、翻译、改写、人设切换、Vibe Coding等功能,让用户“动嘴干活”,提升办公效率。现已免费开放体验。

告别 GUI Agent 工程基建噩梦!阶跃星辰开源 4B 模型,本地轻松部署,玩转安卓应用

阶跃星辰开源GELab-Zero,首发4B GUI Agent模型及完整基建,支持一键部署,在多端性能达SOTA。同步推出真实场景评测基准AndroidDaily,推动GUI智能体规模化落地。

LET数据集来魔搭了!开源首批超60,000分钟全尺寸人形机器人真机数据

国内最大全尺寸人形机器人真机数据集“LET数据集”正式发布,首批开源超6万分钟高质量数据,覆盖6大真实场景,支持多模态融合与标准化应用,助力具身智能研发,已在魔搭社区开放共享。

【Github热门项目】DeepSeek-OCR项目上线即突破7k+星!突破10倍无损压缩,重新定义文本-视觉信息处理

DeepSeek-OCR开源即获7k+星,首创“上下文光学压缩”技术,仅用100视觉token超越传统OCR模型256token性能,压缩比达10-20倍,精度仍超97%。30亿参数实现单卡日处理20万页,显著降低大模型长文本输入成本,重新定义高效文档理解新范式。

101_参数高效微调_QLoRA技术深度解析与实践

在大型语言模型(LLM)时代,高效微调成为降低大模型应用门槛的关键技术。随着模型规模的不断扩大,传统的全参数微调方法面临着巨大的计算资源消耗和内存需求挑战。QLoRA(Quantized Low-Rank Adaptation)作为一种创新的参数高效微调技术,以其独特的量化+低秩适应双重策略,成功地在大幅降低资源消耗的同时保持了接近全精度微调的性能。本文将深入剖析QLoRA的技术原理、实现细节、性能特点,并提供丰富的实践案例,帮助读者全面掌握这一2025年仍然广泛应用的高效微调方法。

104_持续预训练与领域适应:大模型专业能力提升指南

在人工智能领域快速发展的今天,大语言模型(LLM)已经成为自然语言处理的核心驱动力。随着GPT系列、PaLM、LLaMA等模型的涌现,大模型的通用能力得到了显著提升。然而,在实际应用中,我们经常面临一个关键挑战:如何使通用大模型更好地适应特定领域的专业知识和任务需求?持续预训练(Continual Pre-training)与领域适应(Domain Adaptation)技术正是解决这一问题的关键路径。

46_LLM幻觉问题:来源与早期研究_深度解析

大型语言模型(LLM)在自然语言处理领域展现出了令人惊叹的能力,能够生成连贯的文本、回答复杂问题、进行创意写作,甚至在某些专业领域提供见解。然而,这些强大模型的一个根本性缺陷——幻觉问题,正成为限制其在关键应用中广泛部署的主要障碍。幻觉(Hallucination)指的是LLM生成的内容与事实不符、上下文矛盾、逻辑错误,或者完全虚构信息的现象。

67_Transformers库进阶:模型加载与配置优化

随着大型语言模型(LLM)技术的迅速发展,Hugging Face的Transformers库已经成为LLM开发和应用的标准工具包。作为一个开源的深度学习库,Transformers提供了丰富的预训练模型、统一的接口设计以及强大的生态系统,使得研究人员和开发者能够便捷地构建、训练和部署各类语言模型。2025年,Transformers库已经发展到5.x系列,不仅支持最新的GPU架构和量化技术,还提供了更完善的分布式训练能力和内存优化方案。

ModelScope魔搭25年8月发布月报

🔥 这个夏天,开源热潮比气温更燃!Qwen3、GLM4.5、混元、Wan2.2、Qwen-Image等重磅模型密集发布,MoE、多模态、Agent、生图视频全爆发,ModelScope 全程 Day0 支持,生态持续进化中!

ms-swift 部分命令行参数说明

本资源介绍了机器学习训练中的关键参数设置及其影响,包括训练轮数、批量大小、学习率、梯度累积、模型微调等,并提供了针对不同任务和硬件配置的推荐值,帮助提升模型训练效率与性能。

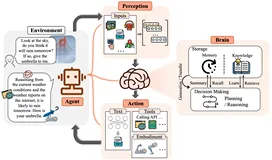

AI Agent

本文介绍了AI Agent的概念及其在云计算3.0时代的焦点地位,强调了其与大语言模型(LLM)的紧密联系。AI Agent由控制端(Brain)、感知端(Perception)和行动端(Action)组成,能够通过LLMs实现复杂的任务分解、记忆管理及工具使用。文章探讨了单代理、多代理及人机交互的应用场景,并分析了钢铁侠中贾维斯的现实版——微软开源JARVIS项目。此外,还提及了国内外多个开源平台及Python在AI领域的核心地位,同时提出了关于智能代理发展的开放问题,如安全性、群体智能演化及代理服务化等。最后提供了丰富的参考资料以供深入研究。

B站开源SOTA动画视频生成模型 Index-AniSora!

B站升级动画视频生成模型Index-AniSora技术并开源,支持番剧、国创、漫改动画、VTuber、动画PV、鬼畜动画等多种二次元风格视频镜头一键生成!

AI赋能大学计划·大模型技术与应用实战学生训练营——华东师范大学站圆满结营

4月24日,由中国软件行业校园招聘与实习公共服务平台携手阿里魔搭社区共同举办的AI赋能大学计划·大模型技术与产业趋势高校行大模型应用实战学生训练营——华东师范大学站圆满结营。

开源8B参数全能扩散模型Flex.2-preview:把线稿变商稿,还能边画边改!

Flex.2-preview是Ostris开源的80亿参数文本到图像扩散模型,支持512token长文本输入和多类型控制引导,内置修复功能并兼容主流AI绘画工具链。

多模态交互3D建模革命!Neural4D 2o:文本+图像一键生成高精度3D内容

Neural4D 2o是DreamTech推出的突破性3D大模型,通过文本、图像、3D和运动数据的联合训练,实现高精度3D生成与智能编辑,为创作者提供全新的多模态交互体验。

模型手动绑骨3天,AI花3分钟搞定!UniRig:清华开源通用骨骼自动绑定框架,助力3D动画制作

UniRig是清华大学与VAST联合研发的自动骨骼绑定框架,基于自回归模型与交叉注意力机制,支持多样化3D模型的骨骼生成与蒙皮权重预测,其创新的骨骼树标记化技术显著提升动画制作效率。

别让创意卡在工具链!MiniMax MCP Server:MiniMax 开源 MCP 服务打通多模态生成能力,视频语音图像一键全搞定

MiniMax MCP Server 是基于模型上下文协议的多模态生成中间件,支持通过文本指令调用视频生成、图像创作、语音合成及声音克隆等能力,兼容主流客户端实现跨平台调用,采用检索增强生成技术保障内容准确性。

【内附榜单】评估AI大模型的代码修复能力!Multi-SWE-bench:字节开源代码修复能力评估基准,覆盖7大主流编程语言

Multi-SWE-bench是首个覆盖Python外7种主流编程语言的代码修复基准,包含1632个真实GitHub问题样本,通过严格筛选与人工验证确保数据质量。

OpenRouter 推出百万 token 上下文 AI 模型!Quasar Alpha:提供完全免费的 API 服务,同时支持联网搜索和多模态交互

Quasar Alpha 是 OpenRouter 推出的预发布 AI 模型,具备百万级 token 上下文处理能力,在代码生成、指令遵循和低延迟响应方面表现卓越,同时支持联网搜索和多模态交互。

开箱即用的可视化AI应用编排工具 Langflow,可调用魔搭免费API作为tool

ModelScope 社区基于优秀的开源可视化AI应用编排工具 Langflow 搭建了创空间,以方便社区开发者基于社区开源模型及免费魔搭 API-Inference,快速创建Agent应用、RAG应用并将其部署为API服务。

YT Navigator:AI秒搜YouTube!自然语言直达视频关键帧

YT Navigator 是一款 AI 驱动的 YouTube 内容搜索工具,通过自然语言查询快速定位视频中的关键信息,支持与视频内容对话,适用于研究人员、学生和内容创作者。

Hunyuan3D 2.0:腾讯混元开源3D生成大模型!图生/文生秒建高精度模型,细节纹理自动合成

Hunyuan3D 2.0 是腾讯推出的大规模 3D 资产生成系统,专注于从文本和图像生成高分辨率的 3D 模型,支持几何生成和纹理合成。

使用DeepSeek快速创建的个人网站

这是一份使用DeepSeek快速创建个人网站的10分钟指南。内容分为四个步骤:搭建基础架构(HTML框架)、设计核心内容区块(关于我、作品展示等)、快速配置样式(CSS美化页面)以及添加联系表单并部署到GitHub Pages。通过简单的代码和DeepSeek的智能辅助功能,用户可以轻松实现个性化调整,如更换主题色、增加模块或优化响应式设计。虽然整体流程简单高效,但可能因功能有限或美观度不足而需进一步扩展与改进。

还在蹲Manus的邀请码?别等了!开源版Manus为你快速创建AI工位,给AI一台电脑,然后你就玩去吧!

OpenManus 是 MetaGPT 的开源 AI 平台,支持多语言模型和工具链,执行代码、处理文件等任务,具备实时反馈。OWL 基于 CAMEL-AI,支持角色分配、任务分解和记忆功能,实现高效任务自动化。

SepLLM:开源大模型加速神器!400万Token长文本推理提速50%,告别OOM噩梦

SepLLM 是一个用于加速大语言模型的高效框架,通过压缩段落信息并消除冗余标记,显著提高了模型的推理速度和计算效率,适用于长文本处理和多场景部署。

MME-CoT:多模态模型推理能力终极评测!六大领域细粒度评估,港中大等机构联合推出

MME-CoT 是由港中文等机构推出的用于评估大型多模态模型链式思维推理能力的基准测试框架,涵盖数学、科学、OCR、逻辑、时空和一般场景等六个领域,提供细粒度的推理质量、鲁棒性和效率评估。

Evo 2:基因编程AI革命!!DNA版GPT-4问世:100万碱基全解析,自动设计基因编辑器

Evo 2 是一款由 Acr 研究所、英伟达和斯坦福大学联合开发的 DNA 语言模型,可处理长达百万碱基对的序列,支持基因组设计、变异预测及合成生物学研究。

Omnitool:开发者桌面革命!开源神器一键整合ChatGPT+Stable Diffusion等主流AI平台,本地运行不联网

Omnitool 是一款开源的 AI 桌面环境,支持本地运行,提供统一交互界面,快速接入 OpenAI、Stable Diffusion、Hugging Face 等主流 AI 平台,具备高度扩展性。

Light-A-Video:好莱坞级打光自由!上海AI Lab开源视频打光AI,无需训练秒改画面氛围,3步让阴天变夕阳

Light-A-Video 是由上海AI Lab联合交大等高校推出的无需训练的视频重照明方法,支持高质量、时间一致的光照控制,零样本生成和前景背景分离处理。

从架构师和产品经理角度来看 A2UI 的企业级应用

A2UI(Architect-to-UI)是面向企业级应用的AI驱动开发范式,通过ooderAgent实现架构设计到用户界面的直接转换。它 bridging 架构师与产品经理需求:保障架构一致性、提升开发效率、强化质量与安全,支持云原生、低代码及行业定制化演进。(239字)

不读完这3000篇文献就没法写论文?你的"穷举法"正在拖垮你的科研生涯

针对科研人员面临的"文献海量增长"困境,本文提出了一种基于系统性综述方法论的AI指令方案。通过"认知跃迁"和"三种实战模式",帮助研究者从机械阅读转向精密过滤,利用AI构建高质量的学术综述框架。

C 语言项目实战入门:从 0 到 1 搭建简易学生信息管理系统

本文以“简易学生信息管理系统”为例,系统讲解C语言项目开发全流程,涵盖需求分析、数据结构设计、模块化编码、文件操作与调试优化,帮助初学者掌握结构体、指针、动态内存管理等核心技能,实现学生信息的增删改查与持久化存储,夯实C语言实战基础。

Python 开发进阶:从初级到全栈工程师的能力提升路径

本文系统梳理了Python开发者从初级到全栈的进阶路径,涵盖框架深度应用、性能优化、架构设计、容器化部署及DevOps实践。通过分阶段技能升级与真实项目落地,助力开发者突破“脚本思维”,构建全链路工程能力,实现从“会编码”到“能交付完整系统”的质变跨越。(238字)

NeurlPS 2025!多伦多大学TIRE助力3D/4D 生成精准保留主体身份

TIRE提出“追踪-补全-重投影”三阶段方法,实现主体驱动的3D/4D生成。通过视频跟踪识别缺失区域,定制2D模型补全纹理,并重投影至3D空间,提升生成一致性与质量,推动动态场景生成新进展。

119_LLM训练的高效内存管理与优化技术:从ZeRO到Flash Attention

大型语言模型(LLM)的训练面临着前所未有的计算和内存挑战。随着模型规模达到数百亿甚至数千亿参数,高效的内存管理成为训练成功的关键因素之一。2025年,LLM训练的内存优化技术已经取得了显著进展,从ZeRO优化器到Flash Attention等创新技术,为训练超大规模模型提供了可能。

139_剪枝优化:稀疏模型压缩 - 分析结构化剪枝的独特速度提升与LLM部署加速实践

随着大语言模型(LLM)规模的不断增长,模型参数量已从最初的数亿扩展到数千亿甚至万亿级别。这种规模的模型在推理过程中面临着巨大的计算和内存挑战,即使在最先进的硬件上也难以高效部署。剪枝优化作为一种有效的模型压缩技术,通过移除冗余或不重要的参数,在保持模型性能的同时显著减少计算资源需求。

88_多模态提示:图像与文本融合

在人工智能领域的快速发展中,多模态融合已成为突破单一模态限制、实现更全面智能理解的关键技术方向。人类理解世界的方式天然是多模态的——我们同时通过视觉、听觉、语言等多种感官获取信息并进行综合分析。例如,在餐厅点餐时,我们会同时处理菜单上的图片、服务员的介绍和菜品的文字描述,最终做出决策。这种自然的多模态信息整合能力,正是人工智能系统长期以来努力追求的目标。

73_安全配置:LLM开发环境的全面防护指南

在2025年的AI开发环境中,大型语言模型(LLM)已成为核心技术,但伴随其广泛应用的是日益严峻的安全挑战。据统计,2025年第一季度发生的AI安全事件中,LLM环境配置不当导致的漏洞占比高达43%,造成的损失超过2.1亿美元。本文将深入探讨LLM开发环境的安全配置最佳实践,帮助开发者构建一个安全、可靠的开发环境。

54_模型优化:大模型的压缩与量化

随着大型语言模型(LLM)的快速发展,模型规模呈指数级增长,从最初的数亿参数到如今的数千亿甚至万亿参数。这种规模扩张带来了惊人的能源消耗和训练成本,同时也给部署和推理带来了巨大挑战。2025年,大模型的"瘦身"已成为行业发展的必然趋势。本文将深入剖析大模型压缩与量化的核心技术、最新进展及工程实践,探讨如何通过创新技术让大模型在保持高性能的同时实现轻量化部署,为企业和开发者提供全面的技术指导。

74_调试技巧:OOM与性能瓶颈

在大型语言模型(LLM)的开发与部署过程中,内存溢出(Out of Memory,简称OOM)错误和性能瓶颈问题是开发者经常面临的两大挑战。随着模型规模的不断扩大(从最初的BERT、GPT-2到现在的GPT-4、Claude 3等千亿甚至万亿参数的模型),这些问题变得更加突出。据2025年最新的开发者调查报告显示,超过78%的LLM开发者在模型训练或推理过程中遇到过OOM错误,而性能瓶颈则影响了约65%的生产环境部署。

Jina Embeddings V4: 为搜索而生,多模态多语言向量模型

近日,Jina AI 正式发布 jina-embeddings-v4,一款全新的多模态向量模型,参数规模达到 38 亿,并首次实现了对文本与图像的同步处理。