本文来自 企业网D1net公众号

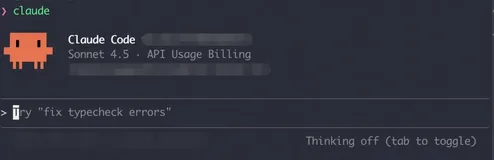

周一,Anthropic发布了Claude 3,这是一个AI语言模型,与支持ChatGPT的模型相似。Anthropic声称,这些模型在一系列认知任务中设定了新的行业基准,在某些情况下甚至拥有接近人类的能力,它现在可以通过Anthropic的网站购买,最强大的模型只提供订阅模式,开发者也可以通过API获取。

Anthropic最新发布的Claude 3 的三种模式代表着日益增长的复杂性和参数计数:Claude 3 Haiku、Claude 3 Sonnet和Claude 3 Opus。Sonnet现在可以通过电子邮件登录免费为Claude.ai聊天机器人提供动力,但如上所述,Opus只有在你每月支付20美元购买“Claude Pro”的情况下才能通过Anthropic的网络聊天界面访问,这是一项通过Anthropic网站提供的订阅服务。这三种模式都有一个200000个令牌的上下文窗口,上下文窗口是人工智能语言模型可以一次处理的标记数量——单词的片段。

Claude在2023年3月发布,Claude 2在同年7月的发布。每一次,Anthropic在性能上都略低于OpenAI最好的模型,但在上下文窗口长度方面却超过了它们。凭借Claude 3,Anthropic可能终于在性能方面赶上了OpenAI发布的模型,尽管专家们还没有达成共识。

据报道,Claude 3在各种认知任务中表现出了超凡的表现,包括推理、专业知识、数学和语言流利性,尽管对于大型语言模型是否“知道”或“理性”缺乏共识,但人工智能研究界通常使用这些术语。该公司声称,Opus模型是这三个模型中最有能力的,它展示了“在复杂任务上的近乎人类的理解和流利程度”。

这是一个相当令人兴奋的说法,值得更仔细地分析。在某些特定的基准上,Opus可能是“近乎人类”的,但这并不意味着Opus是像人类一样的一般智力,考虑到袖珍计算器在数学方面是超人的,因此,这是一个刻意吸引眼球的说法,但可以用资格证书来淡化。

根据Anthropic的数据,Claude 3 Opus在10个人工智能基准上击败了GPT-4,包括MMLU(本科水平知识)、GSM8K(小学数学)、HumanEval(编码)和色彩丰富的HellaSwg(常识)。有几场比赛的胜率非常小,比如Opus的支持率为86.8%,而MMLU的五杆测试赛的支持率为86.4%,还有一些差距很大,比如人文评价的90.7%高于GPT-4的67.0%,但是,作为一名客户,这对你到底意味着什么,很难说。

人工智能研究Simon Willison在接受采访时谈到了Claude 3,他说:“和往常一样,LLM基准测试应该受到一点怀疑,一个模型在基准测试中的表现如何,并不能告诉你该模型的使用‘感觉’如何,但这仍然是一个巨大的问题——没有其他模型在一系列广泛使用的基准测试中击败GPT-4”。

价格和性能的广泛范围

与它的前身相比,Claude 3模型在分析、预测、内容创建、代码生成和多语言对话等方面都比Claude 2有了改进。据报道,这些模型还具有增强的视觉功能,支持模型处理照片、图表和图表等视觉格式,类似于GPT-4和谷歌的Gemini。

Anthropic强调,与前几代模型相比,这三种模型的速度和成本效益都有所提高。Opus (最大模型)为15美元/百万个输入令牌,75美元/百万个输出令牌,Sonnet (中间模型)为3美元/百万个输入令牌,15美元/百万个输出令牌,Haiku (最小最快模型)为0.25美元/百万个输入令牌,1.25美元/百万个输出令牌。相比之下,OpenAI的GPT-4 Turbo Via API为每百万个输入令牌10美元,每百万个输出令牌30美元,GPT-3.5 Turbo是每百万个输入令牌0.5美元,每百万个输出令牌1.5美元。

当我们问Willison对Claude 3的表现有何感想时,他说他还没有感受到这一点,但每种模型的API定价立即引起了他的注意。Willison说:“未发布的最便宜的那款看起来极具竞争力,质量最好的也是超级贵的”。

据报道,Claude 3模型可以为特定客户处理多达100万枚代币(类似于Gemini Pro 1.5),Anthropic声称Opus模型在一次基准测试中实现了近乎完美的召回,在如此庞大的上下文大小下,准确率超过99%,此外,该公司表示,Claude 3模型不太可能拒绝无害的提示,并在减少错误答案的同时表现出更高的准确性。

根据与模型一起发布的模型卡,Anthropic在训练过程中通过使用合成数据获得了Claude 3的部分能力。合成数据是指使用另一种人工智能语言模型在内部生成的数据,该技术可以作为一种方式来扩大训练数据的深度,以表示抓取的数据集中可能缺少的场景。Willison说:“合成数据是一件大事”。

Anthropic计划在接下来的几个月里发布Claude 3模型家族的频繁更新,以及工具使用、交互式编码和“高级代理功能”等新功能,该公司表示,它将继续致力于确保安全措施与人工智能性能的进步保持同步,并确保Claude 3模型“目前对灾难性风险的潜在影响可以忽略不计”。

Opus和Sonnet模型现在可以通过Anthropic的API购买,Haiku也将紧随其后。Sonnet也可以通过亚马逊Bedrock访问,也可以在谷歌云的Vertex AI模型Garden中以私有模式预览。

简单介绍一下LLM基准

我们与Claude Pro签约,通过一些非正式的测试来亲自试用Opus。Opus在性能上感觉与ChatGPT-4相似,它不能写出原创的笑话(似乎都是从网络上抄袭来的),它很擅长总结信息和用各种风格撰写文本,它在文字问题的逻辑分析方面表现得很好,而且虚构确实看起来相对较低(但我们在询问更多晦涩的话题时看到了一些疏忽)。

所有这些都不是最终的通过或失败,在一个计算机产品通常会输出硬数字和可量化基准的世界里,这可能会令人沮丧。正如Willison告诉我们的,“作为现代人工智能的一个关键概念,‘共鸣’又是一个例子”。

人工智能基准是棘手的,因为任何人工智能助手的有效性都是基于所使用的提示和底层人工智能模型的条件而高度可变的。人工智能模型可以在“测试”(所谓的测试)上表现良好,但无法将这些能力推广到新的情况。

此外,人工智能助手的有效性是高度主观的,这是因为,当你交给它的任务可能是地球上任何智力领域的任何任务时,让人工智能模型成功地完成你想做的事情是很难量化的(比如,在基准指标中)。有些模型对某些任务效果很好,而对其他任务效果不佳,这可能会因任务和提示方式的不同而有所不同。

这适用于谷歌、OpenAI和Meta等供应商的每一个大型语言模型——不仅仅是Claude 3。随着时间的推移,人们发现每个模型都有自己的特点,每个模型的优缺点都可以使用某些提示技术来接受或解决。目前,主要的人工智能助手似乎正在适应一套非常相似的功能。

因此,关键是,当Anthropic说Claude 3可以超过GPT-4 Turbo,目前GPT-4 Turbo在一般能力和低幻觉方面仍被广泛视为市场领先者时,人们需要对此持保留态度——或者说是某种程度的共鸣。如果你正在考虑不同的模型,关键是亲自测试每个模型,看看它是否适合你的应用程序,因为很可能没有其他人可以复制你将在其中使用它的确切环境。