生成对抗网络(Generative Adversarial Network,简称 GAN)是一种深度学习模型,自 2014 年由 Ian Goodfellow 等人提出以来,迅速成为了人工智能领域的一个热门话题。

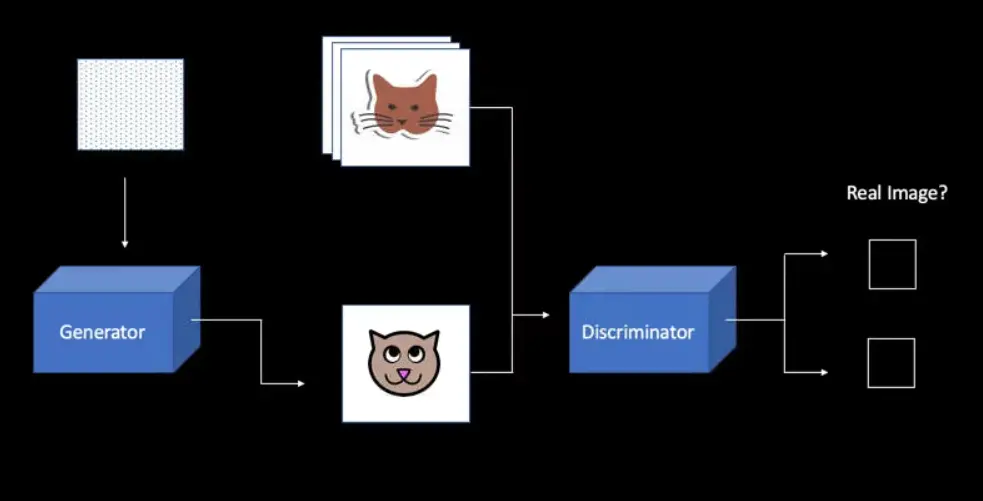

GAN 的核心思想是通过对抗的方式,使得生成网络(Generator)能够产生越来越接近真实数据的假数据。它主要包含两个部分:生成器(Generator)和判别器(Discriminator)。生成器的任务是产生看起来像是来自真实数据分布的数据,而判别器的任务则是区分输入的数据是来自真实数据分布还是生成器产生的。这两个网络在训练过程中相互竞争,生成器不断学习如何产生更加逼真的数据,而判别器则不断学习如何更准确地判断数据的真伪。通过这种方式,生成器和判别器逐渐达到平衡,生成器能够产生高质量的数据。

GAN 的应用场合非常广泛,包括但不限于图像生成、图像编辑、风格转换、数据增强、图像超分辨率和文本到图像的转换等。下面通过几个具体的例子来进一步解释 GAN 的使用场合:

图像生成

GAN 能够学习特定类型的图像数据分布,如人脸、室内场景或艺术品等,并生成新的图像,这些图像在视觉上与训练集中的真实图像难以区分。这种能力使 GAN 成为创造新艺术品、游戏角色或虚拟环境设计的有力工具。

风格转换

通过 GAN,我们可以将一幅图像的风格转换成另一种风格,例如将日常照片转换成梵高或毕加索的画风。这种技术广泛应用于艺术创作和娱乐产业,为用户提供了丰富的个性化内容。

数据增强

在机器学习和深度学习领域,数据是非常宝贵的资源。GAN 能够生成新的数据样本,帮助增加数据集的多样性,特别是在数据稀缺的情况下,通过生成的数据来增强原有数据集,从而提高模型的泛化能力。

图像超分辨率

GAN 还可以用于图像超分辨率任务,即将低分辨率的图像转换为高分辨率版本。这对于恢复老照片、提高视频质量或改善医疗成像等领域具有重要意义。

生成对抗网络的工作机制可以简化为以下几个步骤:

- 初始化:选择一个随机噪声作为生成器的输入,同时从真实数据集中随机选择一些样本。

- 生成假数据:生成器接收随机噪声,通过前向传播产生假数据。

- 判别真假:判别器分别对来自生成器的假数据和真实数据集的数据进行判别,试图区分哪些是真实的,哪些是生成的。

- 计算损失并反向传播:根据判别器的判断结果,计算生成器和判别器的损失,并通过反向传播算法更新它们的参数。

- 重复迭代:重复步骤 2 至 4,直至生成器产生的假数据足够逼真,判别器难以区分真假。

在实际应用中,调整 GAN 的结构和参数是一项复杂的任务,需要深厚的专业知识和丰富的实践经验。例如,为了提高生成器的生成质量,可能需要尝试不同的网络结构(如卷积神经网络、循环神经网络等),或者调整学习率、批次大小等超参数。此外,GAN 训练过程中的模式崩溃(mode collapse)问题也是一个需要解决的难题,这种情况下生成器会生成极少样式的数据,失去了多样性。

生成对抗网络自提出以来,已经衍生出许多变体,如条件 GAN(cGAN)、循环 GAN(CycleGAN)和进化 GAN(Progressive GAN)等,这些变体通过在原有 GAN 结构上的创新和优化,使其在特定应用场景下表现得更加出色。

以上是理论介绍,下面我们提供一段用 python 代码实现的,基于 GAN 理论的低分辨率图片转换成高分辨率图片的实用工具。

要基于 GAN 技术完成低分辨率图片生成高分辨率图片的任务,我们可以参考一种称为超分辨率生成对抗网络(Super-Resolution Generative Adversarial Network,简称 SRGAN)的模型。这里提供一个简化版本的代码框架,以便理解整个过程。请注意,这个示例需要有 TensorFlow 和 Keras 的环境才能正常运行。

import tensorflow as tf from tensorflow.keras.layers import Input, Dense, Conv2D, BatchNormalization, LeakyReLU, Add, UpSampling2D from tensorflow.keras.models import Model from tensorflow.keras.applications import VGG19 from tensorflow.keras.optimizers import Adam def build_generator(): """构建生成器模型""" input_layer = Input(shape=(None, None, 3)) # 假设输入低分辨率图片是彩色的,所以通道数为3 x = Conv2D(64, kernel_size=9, padding='same')(input_layer) x = LeakyReLU(alpha=0.2)(x) skip_connection = x for _ in range(16): x = residual_block(x) x = Conv2D(64, kernel_size=3, padding='same')(x) x = BatchNormalization()(x) x = Add()([x, skip_connection]) # 上采样 x = UpSampling2D(size=2)(x) x = Conv2D(256, kernel_size=3, padding='same')(x) x = LeakyReLU(alpha=0.2)(x) x = Conv2D(3, kernel_size=9, padding='same', activation='tanh')(x) model = Model(input_layer, x) return model def residual_block(x): """构建残差块""" skip = x x = Conv2D(64, kernel_size=3, padding='same')(x) x = BatchNormalization()(x) x = LeakyReLU(alpha=0.2)(x) x = Conv2D(64, kernel_size=3, padding='same')(x) x = BatchNormalization()(x) x = Add()([x, skip]) return x def build_discriminator(): """构建判别器模型""" input_layer = Input(shape=(None, None, 3)) x = Conv2D(64, kernel_size=3, padding='same')(input_layer) x = LeakyReLU(alpha=0.2)(x) x = Conv2D(64, kernel_size=3, padding='same', strides=2)(x) x = LeakyReLU(alpha=0.2)(x) # 添加更多卷积层 # ... x = Dense(1024)(x) x = LeakyReLU(alpha=0.2)(x) x = Dense(1, activation='sigmoid')(x) model = Model(input_layer, x) return model def build_srgan(generator, discriminator): """构建 SRGAN 模型""" discriminator.trainable = False input_low_resolution = Input(shape=(None, None, 3)) fake_high_resolution = generator(input_low_resolution) fake_output = discriminator(fake_high_resolution) srgan = Model(input_low_resolution, [fake_high_resolution, fake_output]) return srgan # 构建模型 generator = build_generator() discriminator = build_discriminator() # 编译判别器 discriminator.compile(loss='binary_crossentropy', optimizer=Adam(0.0002, 0.5)) # 构建并编译 SRGAN srgan = build_srgan(generator, discriminator) srgan.compile(loss=['binary_crossentropy', 'mse'], loss_weights=[1e-3, 1], optimizer=Adam(0.0002, 0.5))

这段代码提供了 SRGAN 的基本结构,包括生成器、判别器以及将两者结合起来的完整模型。生成器通过学习将低分辨率图片转换为高分辨率图片,判别器则负责评估生成的图片与真实高分辨率图片的区别。

总之,无论是在学术研究还是商业应用中,GAN 都展现出了巨大的潜力和广泛的应用前景。