1.算法运行效果图预览

2.算法运行软件版本

matlab2022a

3.算法理论概述

在室内三维全景图的构建中,Harris角点检测算法扮演着关键的角色,用于识别场景中的特征点以实现图像间的匹配和对齐。该过程通常包括以下几个步骤:图像获取、角点检测、特征描述、匹配以及基于这些匹配信息的图像拼接。

3.1Harris角点检测原理

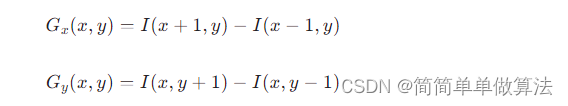

对于一个灰度图像 (x,y),我们需要计算每个像素点(x,y) 的梯度强度和方向。通常使用 Sobel 滤波器或其他微分算子来得到水平 Gx 和垂直Gy 方向上的梯度:

这里简化了Sobel算子的形式,实际应用中可能需要考虑更大范围的邻域计算。

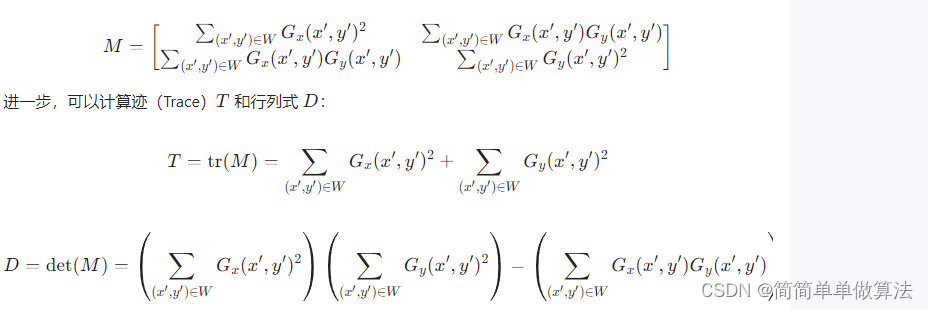

定义图像局部窗口W 内的协方差矩阵(结构张量)为:

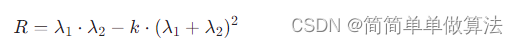

3.2 Harris响应函数

Harris等人提出的响应函数R 结合了迹和行列式的特性,用于衡量区域是否具有稳定的角点属性:

其中,λ1,λ2 是协方差矩阵M 的特征值,k 是一个自由参数,通常取 0.04~0.06。当 R 较大时,表示该区域具有较强的角点特征。

3.3 角点检测与筛选

通过对每个像素窗口应用上述公式计算响应值,然后通过阈值处理,找出响应值大于预定阈值的点作为角点候选。进一步,可以采用非极大值抑制去除边缘响应较高的假阳性点。

在室内三维全景图拼接中,首先利用Harris角点检测方法分别从各个相邻视图中找到稳定的特征点。接着,运用如SIFT、SURF等更稳健的特征描述符提取特征点的描述向量,进行两两视图之间的特征匹配。

匹配成功后,通过几何变换(如单应性矩阵H或本质矩阵E)估计不同视图间的关系,从而实现图像对齐。最后,依据对齐结果采用图像融合技术拼接各视角下的图像,形成无缝的室内三维全景图。

由于篇幅限制,这里并未涵盖完整的数学推导和示意图,但在实际操作中,涉及到更多的图像处理技术与优化策略。在可视化方面,可以借助专门的数学排版工具生成对应的数学公式图片,以便更好地理解复杂的矩阵运算和相关概念。

4.部分核心程序

```dirs = 'datasheet/';% 定义文件夹路径

files = dir(dirs);% 获取文件夹内的所有文件和子文件夹信息

files = files(2:end);% 去除第一个元素

N = length(files);% 计算文件数量

Iset = {};

cnt = 1;

for i = 1:N% 遍历所有文件

if files(i).name(1) ~= '.'

% 读取图像文件,并将其路径拼接为完整路径

im = imread(strcat(dirs,files(i).name));

% 调整图像大小为640x640,并将其转换为双精度浮点数,同时归一化到[0,1]范围

im = double(imresize(im, [640, 640]))/255;

% 将处理后的图像添加到Iset中

Iset{cnt} = im;

cnt = cnt + 1;

end

end

img12=func_mix(Iset{1},Iset{2},1);

img34=func_mix(Iset{3},Iset{4},1);

img56=func_mix(Iset{5},Iset{6},0);

img78=func_mix(Iset{7},Iset{8},0);

img789=func_mix(img78,Iset{9},0);

img1234=func_mix(img12,img34,0);

img56789=func_mix(img56,img789,0);

img1234=func_mix(img12,img34,0);

img123456789=func_mix(img1234,img56789,0);

[R,C,K] = size(img123456789);

figure;

imshow(img123456789(0.4R:0.85R,0.1C:0.75C,:));

figure;

subplot(231);imshow(img12);

subplot(232);imshow(img34);

subplot(233);imshow(img56);

subplot(234);imshow(img78);

subplot(235);imshow(img789);

subplot(236);imshow(img56789);

```