有意向获取代码,请转文末观看代码获取方式~也可转原文链接获取~

1 基本定义

小波MFE_SVM_LSTM神经网络时序预测算法是一种结合了小波变换、多尺度特征提取(MFE)、支持向量机(SVM)和长短期记忆神经网络(LSTM)的复杂预测方法。下面是对该算法的详细介绍:

- 小波变换(Wavelet Transform):

- 小波变换是一种信号处理方法,能够将信号分解为不同频率和尺度的分量,并对每个分量进行时频分析。

- 通过小波变换,可以将时间序列数据转化为小波系数,这些系数能够更好地表示时间序列中的复杂模式和趋势。

- 小波变换具有处理非线性、非平稳信号的能力,因此在时序预测中非常有用。

- 多尺度特征提取(MFE):

- 在小波变换之后,利用MFE技术从每个小波系数中提取多尺度的特征。

- 这些特征可能包括统计特性、频域特性、时域特性等,它们共同描述了信号在不同尺度上的行为。

- 通过多尺度特征提取,算法能够更全面地捕捉原始信号中的复杂模式,为后续的预测模型提供更丰富、更有代表性的信息。

- 支持向量机(SVM):

- SVM是一种常用的监督学习算法,特别适用于处理分类和回归问题。

- 在时序预测中,SVM可以利用历史数据和提取的多尺度特征来训练一个预测模型。

- 该模型能够学习并捕捉到数据中的非线性关系,从而实现对未来数据点的初步预测。

- 长短期记忆神经网络(LSTM):

- LSTM是一种特殊的循环神经网络(RNN),特别擅长处理长时间序列数据。

- 在小波MFE_SVM_LSTM算法中,LSTM被用来进一步优化SVM的预测结果。

- 具体而言,每个小波系数和提取的多尺度特征被作为LSTM的输入,通过LSTM的学习和预测,可以实现对原始时间序列的更精确预测。

- LSTM的内部结构使其能够捕捉到时间序列中的长期依赖关系,从而提高预测的准确性。

综上所述,小波MFE_SVM_LSTM神经网络时序预测算法通过结合小波变换、MFE、SVM和LSTM等多种技术的优势,实现了对原始时间序列的高精度和稳定预测。在实际应用中,该算法可广泛应用于金融市场预测、气象预报、能源消耗预测等多个领域。然而,需要注意的是,该算法也存在一些潜在的局限性,例如计算复杂度高、需要大量数据等,因此在使用时需要根据实际需求进行适当的调整和优化。

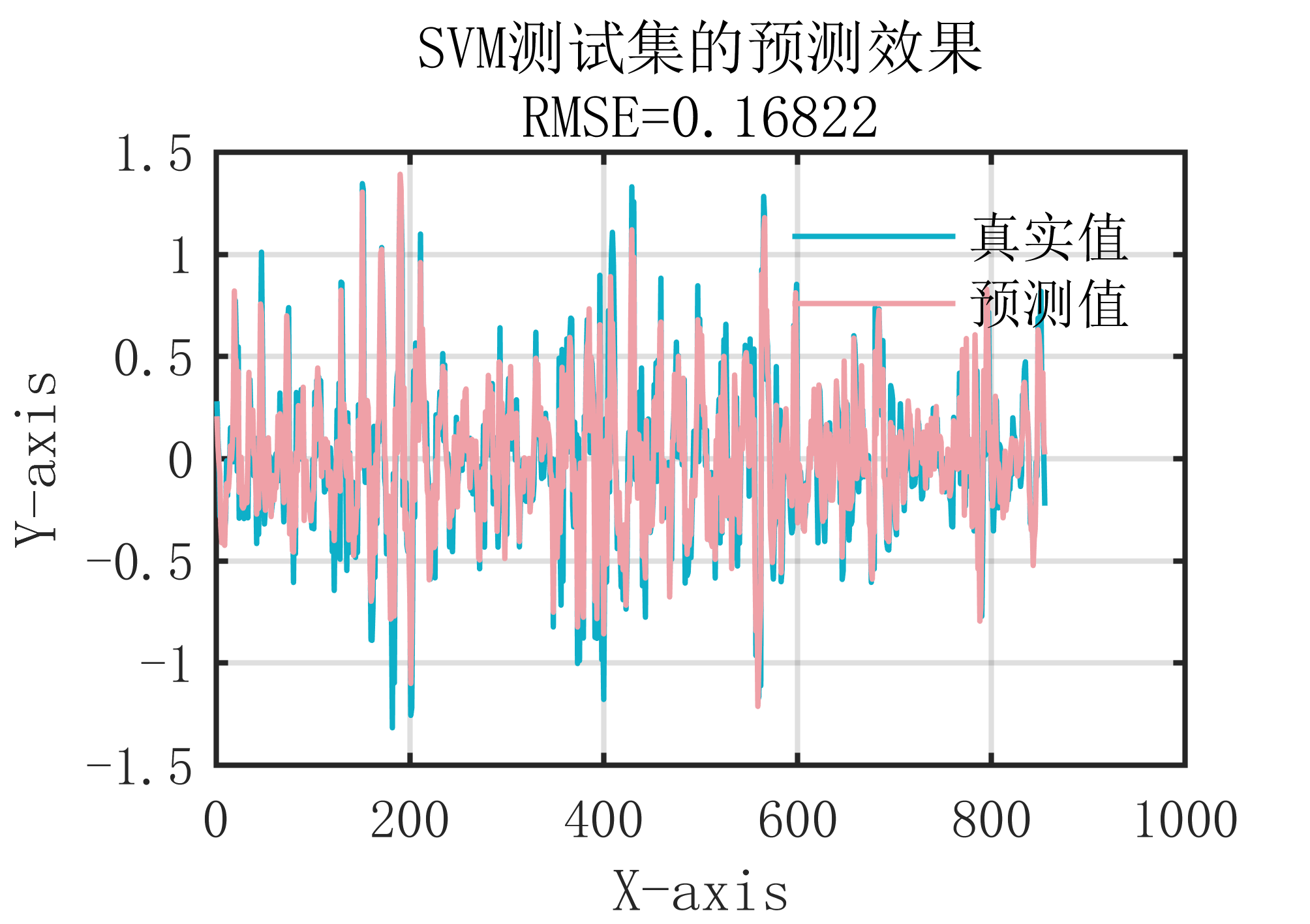

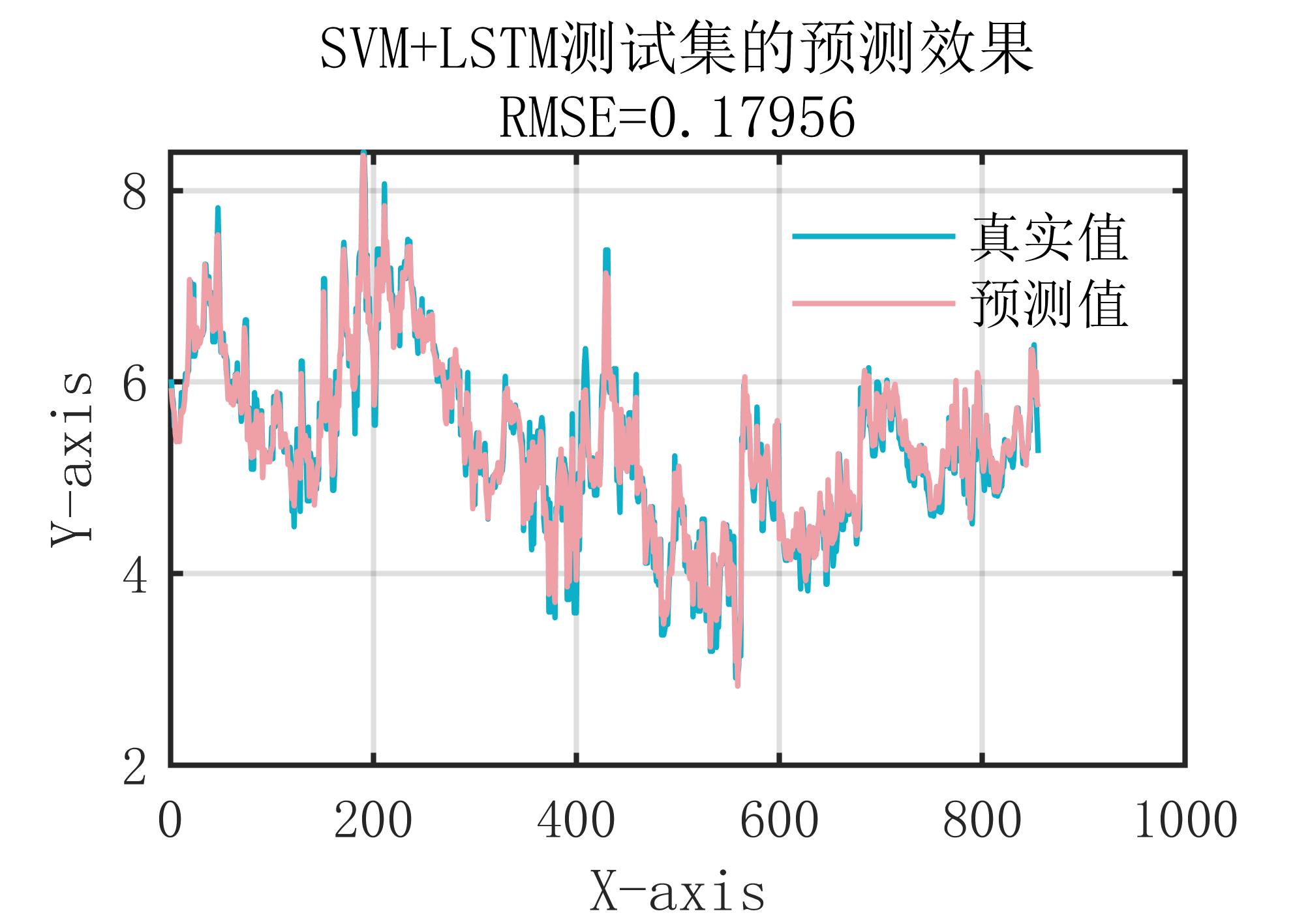

2 出图效果

附出图效果如下:

3 代码获取

【MATLAB】小波 MFE_SVM_LSTM 神经网络时序预测算法

https://mbd.pub/o/bread/ZZqXl59q

MATLAB 228 种科研算法及 23 期科研绘图合集(2024 年 2 月 21 号更新版)

https://www.aliyundrive.com/s/9GrH3tvMhKf

提取码: f0w7

关于代码有任何疑问,均可关注公众号(Lwcah)后,获取 up 的个人【微信号】,添加微信号后可以一起探讨科研,写作,代码等诸多学术问题,我们一起进步~