rec_result = inference_pipeline(audio_in="")

这个audio_in如何加载本地的音频文件?

直接用写本地路径文件,报错:

self.cmd['name_and_type'] = data_cmd

UnboundLocalError: local variable 'data_cmd' referenced before assignment

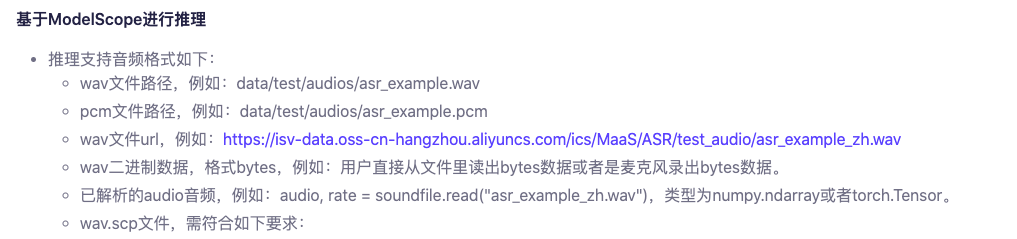

要使用本地音频文件进行自动语音识别(ASR),您可以按照以下步骤操作:

准备音频文件:将您的本地音频文件准备好,并确保其格式和编码与模型要求相匹配。通常,自动语音识别模型要求音频文件为特定的采样率、位深度和声道数。

加载音频文件:在调用inference_pipeline()方法时,将本地音频文件加载到audio_in参数中。您可以直接传递音频文件的路径作为字符串,如:

rec_result = inference_pipeline(audio_in="path/to/your/audio_file.wav")

确保替换 "path/to/your/audio_file.wav" 为您实际音频文件的路径。

如果您在直接使用本地路径时遇到错误,可能是因为代码中的问题。请确保 data_cmd 变量在使用之前已经被正确赋值。您可以检查代码中定义 data_cmd 的部分,确认是否没有出现错误。

另外,您还可以参考相关文档或示例代码,了解更多关于如何使用 auto_speech_recognition 模块处理音频文件的详细说明。

您需要将音频文件读取为numpy数组,然后将其传递给inference_pipeline函数的audio_in参数。以下是一些读取音频文件的示例代码:

使用Python的wave模块读取WAV文件:

python

Copy

import wave

with wave.open('audio.wav', 'rb') as f:

frames = f.readframes(-1)

sample_rate = f.getframerate()

num_channels = f.getnchannels()

sample_width = f.getsampwidth()

import numpy as np

audio_data = np.frombuffer(frames, dtype=np.int16)

使用第三方库librosa读取常见格式的音频文件:

python

Copy

import librosa

audio_data, sample_rate = librosa.load('audio.wav', sr=None, mono=True)

audio_data = np.int16(audio_data * 32767)

读取其他格式的音频文件,需要根据其具体的格式和编码进行调整。读取音频文件后,您可以将其传递给inference_pipeline函数的audio_in参数进行语音识别:

python

Copy

rec_result = inference_pipeline(audio_in=audio_data)

可以将本地文件路径作为输入,请确认提供文件路径是否正确,如有问题可加funasr钉钉群进行沟通(27215013275)

https://www.modelscope.cn/models/damo/speech_paraformer-large_asr_nat-zh-cn-16k-common-vocab8404-pytorch/summary