导读

继 5 月 18 日推出 VisualGLM-6B 后,智谱AI&清华KEG 潜心打磨,于近日发布并直接开源了更强大的多模态大模型——CogVLM-17B。模型已第一时间发布在魔搭社区,可体验!

CogVLM是一个强大的开源视觉语言模型,利用视觉专家模块深度整合语言编码和视觉编码,在14项权威跨模态基准上取得了SOTA性能:

CogVLM-17B 是目前多模态权威学术榜单上综合成绩第一的模型,在14个数据集上取得了state-of-the-art或者第二名的成绩

初步体验 CogVLM 的效果:

在上图中,CogVLM 能够准确识别出 4 个房子(3个完整可见,1个只有放大才能看到);作为对比,GPT-4V 仅能识别出其中的 3 个。

CogVLM的效果依赖于“视觉优先”的思想,即在多模态模型中将视觉理解放在更优先的位置,使用5B参数的视觉编码器和6B参数的视觉专家模块,总共11B参数建模图像特征,甚至多于文本的7B参数量。

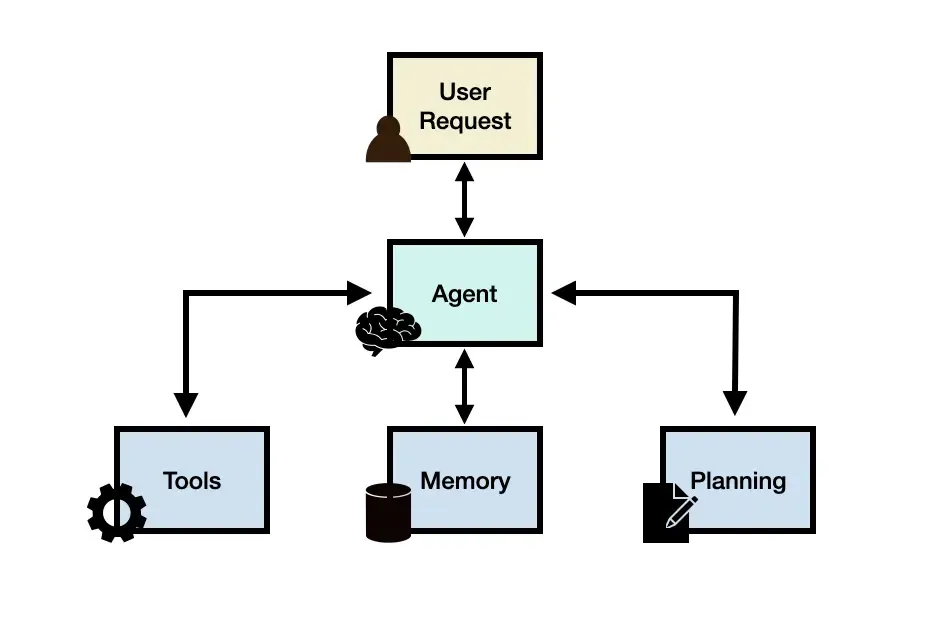

CogVLM模型架构,模型共包含四个基本组件:

ViT 编码器,MLP 适配器,预训练大语言模型(GPT-style)和视觉专家模块

接下来,可跟随教程进入魔搭社区进一步体验:

环境配置与安装

- 本文在A100的环境配置下运行 (可以单卡运行, 显存要求70G)

- python>=3.8

模型链接及下载

模型链接:https://www.modelscope.cn/models/ZhipuAI/CogVLM

模型weights下载:

from modelscope import snapshot_download model_dir = snapshot_download("ZhipuAI/CogVLM",revision='v1.0.0')

模型推理

魔搭社区开发者对接了ModelScope library和CogVLM-Chat模型,提供了推理代码,便于魔搭社区的开发者更好的使用和体验CogVLM-Chat模型

CogVLM推理代码

# 使用之前需要执行pip install en_core_web_sm -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html,下载spaCy提供的小型英语语言模型 from modelscope.utils.constant import Tasks from modelscope.pipelines import pipeline from modelscope import snapshot_download, Model local_tokenizer_dir = snapshot_download("AI-ModelScope/vicuna-7b-v1.5",revision='v1.0.0') pipe = pipeline(task=Tasks.chat, model='AI-ModelScope/cogvlm-chat', model_revision='v1.0.7', local_tokenizer=local_tokenizer_dir) inputs = {'text':'Who is the man in the picture?', 'history': None, 'image': "https://modelscope-open.oss-cn-hangzhou.aliyuncs.com/resources/aiyinsitan.jpg"} result = pipe(inputs) print(result["response"]) inputs = {'text':'How did he die?', 'history': result['history']} result = pipe(inputs) print(result["response"])

创空间体验

创空间体验链接:

https://modelscope.cn/studios/AI-ModelScope/CogVLM/summary

示例效果展示:

多模态国际惯例,先看图像描述:

手写OCR识别效果:

此前的数数题,能“洞察”到角落里的第四座房子的屋檐:

细节捕捉和图像理解:

除如上示例所示外,还可参考官方的一些有趣的案例 CogVLM:智谱AI 新一代多模态大模型

直达链接:https://modelscope.cn/studios/AI-ModelScope/CogVLM/summary