本文介绍高等数学中的leaky ReLU,以及在神经网络中的应用。

函数原型

leaky ReLU(带泄露的ReLU)

$$ f(x) = \begin{cases} x, & \text{if } x \geq 0 \\ \lambda x, & \text{if } x < 0 \end{cases} $$

其中$\lambda$为泄露率,取 $(0,1) 内的数$

导数的函数原型

$$ f(x)' = \begin{cases} 1, & \text{if } x \geq 0 \\ \lambda, & \text{if } x < 0 \end{cases} $$

适用范围

默认全部

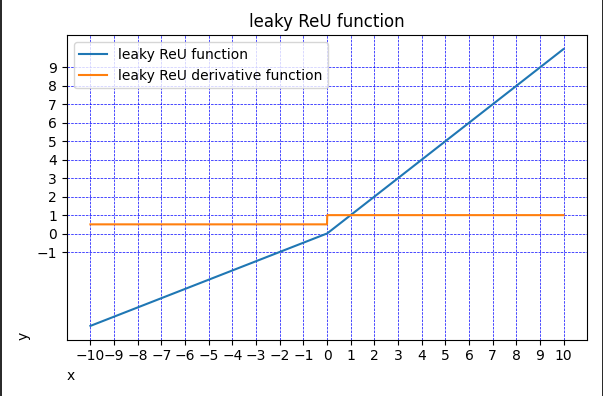

函数图像

Python代码实现

def main():

x = np.arange(-10, 10, 0.01)

lambda1 = 0.5

y = list(map(lambda x: x if x > 0 else lambda1 * x, x))

plt.figure(figsize=(6, 4))

plt.title('leaky ReU function')

plt.xlabel('x', loc='left')

plt.ylabel('y', loc='bottom')

# ReU图像

plt.plot(x, y, label='leaky ReU function')

# ReU导数图像

der_y = list(map(lambda x: 1 if x > 0 else lambda1, x))

plt.plot(x, der_y, label='leaky ReU derivative function')

plt.xticks(np.arange(-10, 11, 1))

plt.yticks(np.arange(-1, 10, 1))

plt.legend()

plt.grid(True, color='b', linewidth='0.5', linestyle='dashed')

plt.tight_layout()

plt.show()

![深度学习基础入门篇[四]:激活函数介绍:tanh、sigmoid、ReLU、PReLU、ELU、softplus、softmax、swish等](https://ucc.alicdn.com/pic/developer-ecology/fnj5anauszhew_1d1e4ebac87c4e6e868a0f92a34632c7.jpeg?x-oss-process=image/resize,h_160,m_lfit)