这是4月刚刚发布在arxiv上的论文,介绍了一种名为“Gradformer”的新型图Transformer,它在自注意力机制中引入了指数衰减掩码。以下是主要创新点:

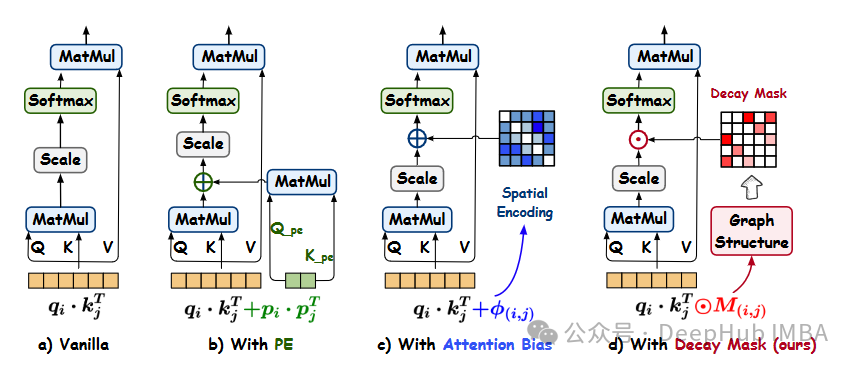

- 指数衰减掩码: Gradformer在其自注意力模块中集成了衰减掩码。该掩码随着图结构中节点之间的距离减小而呈指数递减。这种设计使模型能够在保留远距离信息捕获能力的同时,更专注于本地信息。

- 可学习约束: Gradformer为衰减掩码引入了一种可学习的约束,使不同的注意力头可以学习到不同的掩码。这使得注意力头多样化,提高了模型对图中多样结构信息的吸收能力。

- 归纳偏差的整合: Gradformer的设计将归纳偏差整合到自注意力机制中,增强了它对图结构化数据的建模能力。与之前仅使用位置编码或注意力偏差的方法相比,这种整合更有效。

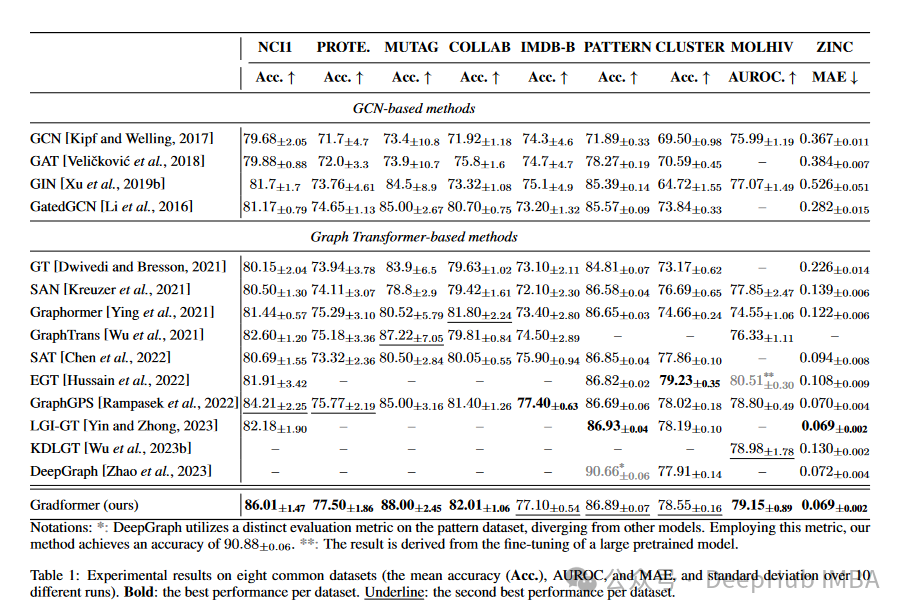

- 与现有方法的比较: Gradformer在各种数据集上与14种基线模型进行了比较,包括图神经网络(GNN)和图Transformer模型。实验结果表明,Gradformer在图分类和回归等任务中,始终优于这些模型。

- 处理深层架构: Gradformer在深层架构中同样有效,随着网络深度的增加,其准确度得以保持甚至增强,这与其他转换器显著下降的准确度形成鲜明对比。

Gradformer通过引入带有可学习约束的指数衰减掩码,为图Transformer提供了一种新的方法,有效地捕捉了图结构中的本地和全局信息。这种设计将其与之前的模型区分开来,并提高了其在各种任务中的表现。

性能提升

- 准确率提升:- NCI1: Gradformer在NCI1数据集上的准确率为86.01%,相比GraphGPS提升了1.8个百分点。- PROTEINS: 在PROTEINS数据集上,Gradformer准确率为77.50%,相比之前的方法也有显著提升。- MUTAG: Gradformer在MUTAG数据集上的准确率为88.00%,超过之前所有基线模型。- CLUSTER: 在CLUSTER数据集上,Gradformer在浅层模型中表现良好,并在深层模型中持续保持或提高了准确度。

- 效率与处理速度:- 时间: 在ZINC数据集上,Gradformer在每个epoch的运行时间在30到60秒之间,相比Graphormer和GraphGPS更加高效。- 内存: Gradformer在ZINC和CLUSTER数据集上显示出对GPU内存的合理使用,进一步支持其效率优势。

- 处理深层模型的稳定性:- Gradformer在深层架构中表现稳定。例如,在NCI1数据集中,Gradformer的准确率在12层和24层之间分别为84.31%和84.25%,保持稳定,而GraphGPS的准确率则下降了近14.4个百分点。

- 低资源环境下的性能:- 在NCI1数据集中,当使用5%数据进行训练时,Gradformer准确率为71.20%,相比GraphGPS的69.54%有提升。在10%数据训练下,Gradformer准确率提升至76.38%。

Gradformer不仅在准确率上显示出显著提升,在效率与处理深层模型的稳定性上也表现良好。其综合性能在多种任务和数据集中超过了之前的基线模型。

论文作者主要观点

- 方法的优势:- 融合了GNN和GT的优势: Gradformer被认为是GNN和GT模型的一种更广义的形式,结合了GNN的本地处理能力和GT的全局聚合能力。- 在处理深层模型时的稳定性: Gradformer展示了在深层模型中持续保持或提高准确度的能力,这与其他GT模型在深层模型中准确度显著下降的表现形成对比。- 多样化的注意力头: 通过引入可学习的衰减掩码,Gradformer使不同的注意力头能够学习到不同的结构信息,从而更有效地融合了多样化的图形结构信息。- 减少信息冗余: 由于衰减掩码的设计,Gradformer能够限制远距离节点的影响,有效减少了信息冗余。

- 局限性:- MPNN模块的必要性: 在分析Gradformer时,作者指出,在某些情况下移除MPNN模块会导致性能的明显下降。如何保持在没有MPNN模块的情况下依然取得良好表现是潜在的改进空间。- 效率改进的潜力: 尽管Gradformer在效率上显示出优于某些模型,但在时间和内存消耗上仍有进一步改进的空间。

- 与先前研究的对比:- 增强了对图结构信息的捕获: 相比之前的方法,Gradformer更有效地整合了图的结构信息。这使其在准确度上有所提高。- 在深层模型中的表现: 与其他GT模型相比,Gradformer在深层模型中保持了稳定的准确度,这是一个显著的优势。

Gradformer通过其设计融合了GNN和GT的优势,同时在处理深层模型时表现稳定,尽管如此,其在改进MPNN模块依赖和效率方面仍有潜在提升空间。

总结

论文介绍了Gradformer,一种新型的图Transformer,结合了指数衰减掩码来增强自注意力机制,以更有效地处理图形任务。该掩码根据图结构信息衰减,确保了对图形局部和全局信息的有效捕捉。论文还引入了可学习的掩码参数,使不同注意力头能够学习到多样化的图形结构信息。Gradformer在多个基准数据集上进行了广泛的实验,展示了其在图分类和回归任务中优于其他图神经网络和图Transformer模型的性能。此外,Gradformer在深层架构中仍能保持或提高准确度,相比其他图Transformer更为稳定。论文总结了Gradformer的卓越性能及潜在改进方向,包括探索更高效的结构和更好的图形信息融合策略。

论文地址:

Gradformer: Graph Transformer with Exponential Decay

https://avoid.overfit.cn/post/ce4d852480a347ffb41c1eabf8cba71f