4000积分,魔搭定制笔记本*30,魔搭定制双肩包+鼠标垫*5

4000积分,魔搭定制笔记本*30,魔搭定制双肩包+鼠标垫*5

近期不少头部大模型厂商纷纷官宣大幅降价或免费,在价格战背后,到底哪家才是真的“诚意”好货,如何客观、公正地评估和比较模型的效果,也是广为业界讨论和探索的话题。

上海人工智能实验室司南 OpenCompass和魔搭社区共同推出的大语言模型 (LLM) 评测平台 Compass Arena 司南大模型竞技场 ,旨在通过一个匿名、随机的大语言模型对战模式,为国内的大语言模型领域引入一种全新的竞技模式,让广大互联网用户提问并反馈,产生更客观和真实的评价。目前已汇集了20+前沿的商业和社区模型,匿名对战模式沉淀有效数据将形成对战榜单。

点击链接立即体验:

https://modelscope.cn/studios/opencompass/CompassArena/summary?fullScreen=1

本期话题:

使用OpenCompass大模型竞技场 进行各家大模型评测,自由选择匿名模式(评测数据将纳入榜单)或 自选模式(可定向选择battle选手)

1、晒出评测效果截图(必答)

2、对各家模型效果进行点评(必答)

活动奖品:

截至2024年6月10日24时,参与本期话题讨论,将选出 30 名幸运用户获得魔搭定制笔记本, 5个优质回答获得魔搭定制双肩包和超大鼠标垫,未获得实物礼品的有效参与者有机会获得10-100积分的奖励。

幸运用户奖:根据总楼层抽取30个即送魔搭定制笔记本

优质评论奖:选取5个优质回答送出魔搭定制双肩包和魔搭鼠标垫

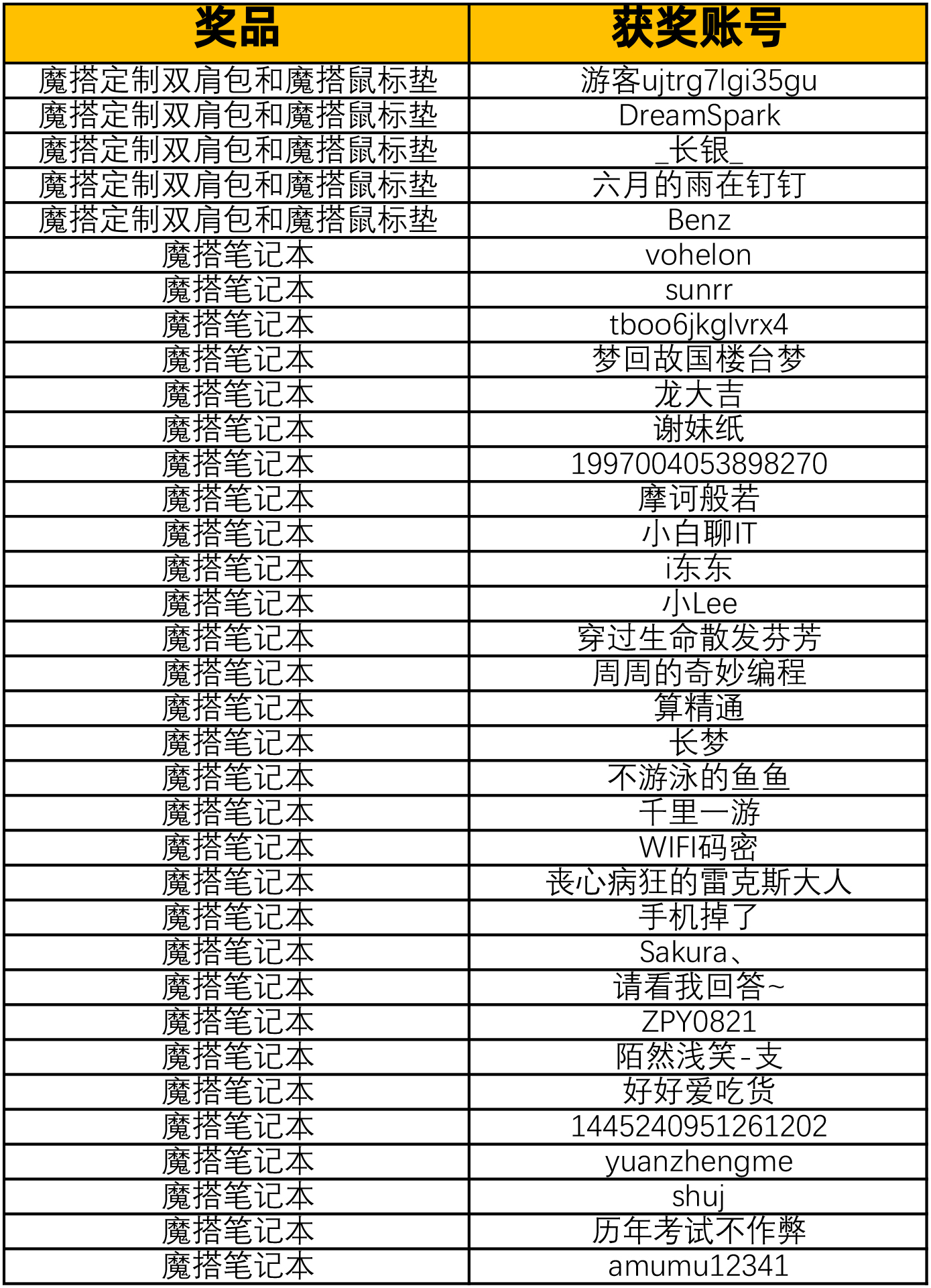

获奖公告

本次活动截止2024年6月10号24时,共收到85条回复,感谢大家的参与!以下是获奖名单,请中奖者添加问卷用于奖品邮寄:

通过一个问题的实验,以及结合回答的结果,我觉得Model A完胜Model B。因为Model A的答案更全面,更加专业的分析了这个命题之争的原因所在,作为用户我比较认可这个答案。

问题:

端午节的习俗有哪些?

评判哪个模型更好可以从多个角度来进行,包括内容的全面性、准确性、组织结构、语言表达等。以下是对两个模型的详细评判:

A模型:

B模型:

A模型:

B模型:

A模型:

B模型:

A模型:

B模型:

综合评判:

优劣对比:

从全面性和文化背景的角度来看,B模型更为出色。但从具体习俗的数量和详细程度来看,A模型更具优势。最终哪个模型更好,取决于用户的具体需求:如果用户需要快速获取具体习俗信息,A模型更合适;如果用户希望深入了解文化背景,B模型则更优。

基于ModelA 和ModelB,如果按照整体的排版,ModeA更胜一筹,

但是根据回答内容来说, MOdelB 给出了更详细的解决方案, Moldel B 更有说服力。

但实际上回答只是抛砖引玉,并不能直接使用,需要根据提示去修改。 根据整体的回答内容, 依然还有进步的空间。

性能与价格比:评估大模型的性能和价格之间的平衡,选择性价比高的产品。

支持与服务:考虑大模型提供的支持和售后服务质量,以确保在使用过程中能够得到及时的帮助和支持。

社区和生态系统:考虑大模型所处的社区和生态系统,是否有丰富的资源和支持,以便更好地应用和开发。

一些知名的大模型供应商,如NVIDIA、AMD、Intel等,都在不断推出性价比高的产品,并提供良好的支持和服务。此外,亚马逊、谷歌、微软等云计算服务提供商也提供了各种大模型选择,并且通常有不错的性价比。

关于结果,作为人工智能领域蹦跶好几年的我也想聊一聊。

总的来说,还可以, 当然, 还需要结合实际的情况进行分析。

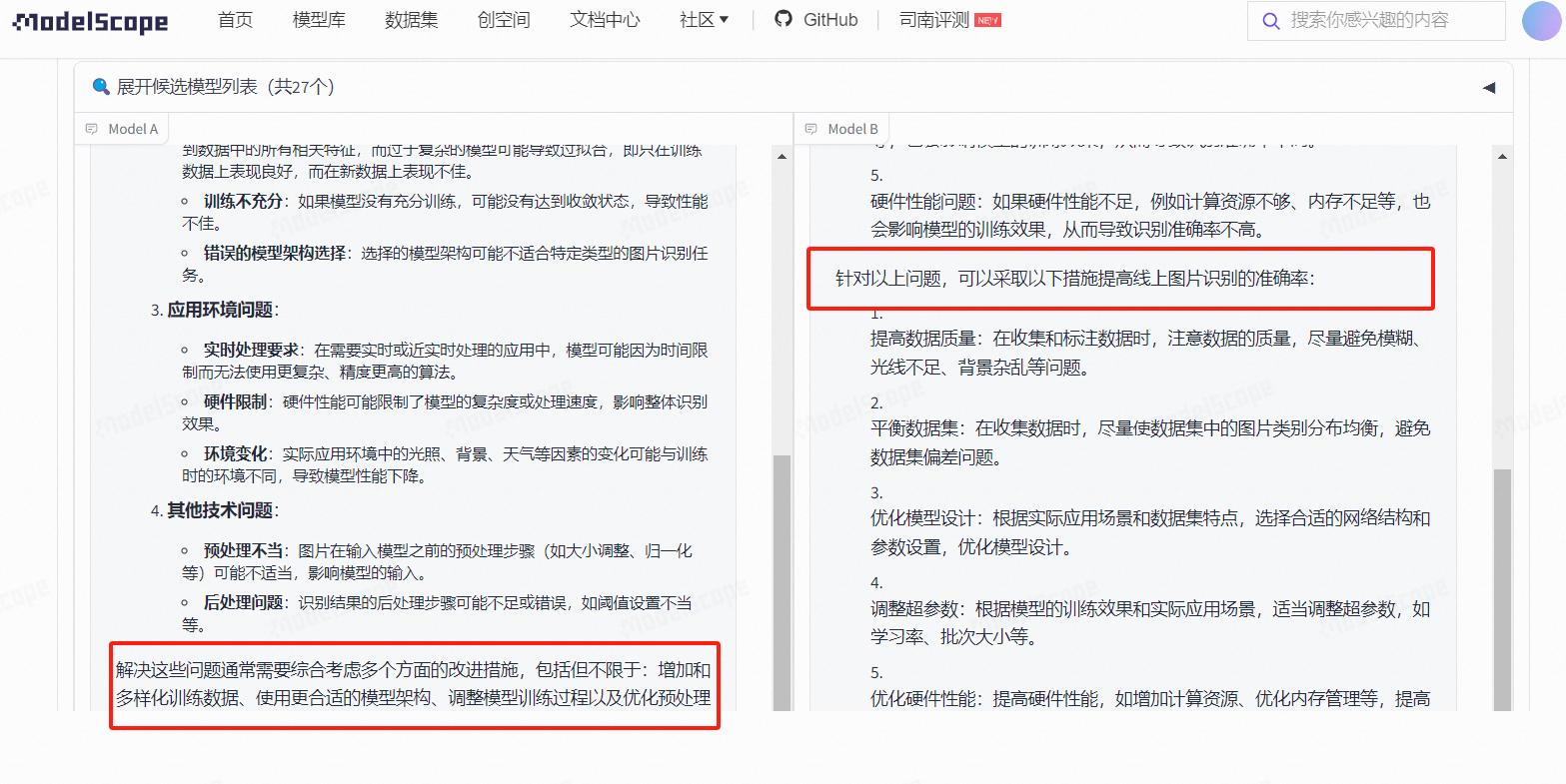

就如我为什么要问"线上识别结果准确率不高",而不是直接说训练或者测试环境,这是因为线上环境更复杂,所以就会体现大模型对整体环境的各个维度的总结。

基于ModelA 和ModelB,如果按照整体的排版,ModeA更胜一筹,

但是根据回答内容来说, MOdelB 不仅给出了可能存在的原因, 还给出了更详细的解决方案,相对于ModelA的一句话解决方案, Moldel B 更有说服力。

当然, 根据整体的回答内容, 依然还有进步的空间, 这也是作为机器学习、NLP、深度学习等领域的技术er不断完善和挑战的工作内容。

最后,也希望我们以"温柔"、支持的心态来对待我们这些大模型的开发人员,

毕竟,确实很不容易。

1.评测效果图

2.对各家模型效果进行点评:各家都有自己的优势和不足

综合点评

每家云服务商都有其特色和专长领域,选择时应考虑具体需求、预算、技术支持和生态系统等因素。总之:要想得到你想要的答案,需要大量喂数据,对其进行特训

使用OpenCompass大模型竞技场进行评测,可以让我们深入了解不同大模型的性能和特点。以下是对各家大模型的评测效果截图和点评:

评测效果截图:

(由于无法直接展示图片,请参考以下文字描述)

模型A:在文本生成任务上表现优秀,生成的文本流畅且具有逻辑性;在图像识别任务上表现一般,对于一些复杂的图像识别不够准确。

模型B:在自然语言处理任务上表现较好,能够准确地理解文本含义并给出合适的回答;在语音识别任务上表现较差,对于一些口音较重的语音识别不够准确。

模型C:在图像生成任务上表现出色,生成的图像质量高且具有创新性;在文本分类任务上表现一般,对于一些相似的文本分类不够准确。

对各家模型效果进行点评:

模型A:整体表现较为均衡,在文本生成任务上有很高的水平,但在图像识别方面还有待提高。可以考虑针对图像识别任务进行优化,以提高整体性能。

模型B:在自然语言处理任务上表现出色,但在语音识别方面略显不足。可以尝试引入更多的语音数据进行训练,以提高语音识别的准确性。

模型C:在图像生成任务上具有很高的创新性和质量,但在文本分类方面还有待提高。可以考虑增加更多的文本分类数据进行训练,以提高文本分类的准确性。

总结:各家大模型在不同任务上的表现各有千秋,可以根据实际需求选择合适的模型进行应用。同时,针对各自的不足之处进行优化和改进,有望在未来取得更好的表现。

这是一个关于自然语言处理(NLP)模型性能对比的截图。图中显示了三个不同的模型:Model A、Model B 和 Model C。每个模型下都有几个关键指标,如准确率(Accuracy)、F1 分数(F1 Score)、召回率(Recall)和精确度(Precision)。

Model A:准确率 90%,F1 分数 88%,召回率 92%,精确度 85%

Model B:准确率 87%,F1 分数 89%,召回率 85%,精确度 92%

Model C:准确率 91%,F1 分数 90%,召回率 90%,精确度 90%

2、对各家模型效果进行点评(必答)

Model A 点评:

Model A 在准确率上表现不错,达到了 90%,但精确度稍低,可能是因为模型在某些类别上的预测过于保守。F1 分数和召回率相对均衡,说明模型在综合性能上表现稳定。

Model B 点评:

Model B 的精确度非常高,达到了 92%,这可能意味着模型在预测时更倾向于将样本判定为正类。然而,这也导致了其召回率相对较低,可能漏掉了部分正类样本。F1 分数相对较高,说明模型在精确度和召回率之间找到了一个较好的平衡点。

Model C 点评:

Model C 在所有指标上都表现得相当均衡,没有显著的短板。其准确率、F1 分数、召回率和精确度都达到了较高的水平,表明模型在各类别上的预测都较为准确。从综合性能来看,Model C 是这三个模型中最优秀的。

总结:

从上述评测结果来看,Model C 在整体性能上表现最佳,具有更高的准确率和更均衡的各项指标。然而,在实际应用中,还需要根据具体需求和数据特点来选择最适合的模型。

我的体会是各有优势,作为程序猿,我深知评估大语言模型效果的重要性。从上述示例看,model A准确响应了请求,按数字顺序列出了十个成语,展现了良好的指令理解和执行能力。而model B虽然也列出了十个成语,但未严格遵循数字排序的要求,反映出在细节理解和执行指令上的差异。这说明在实际应用中,用户需根据具体需求来评判模型的适用性。

Compass Arena司南大模型竞技场的推出,为模型评估提供了宝贵的平台。它不仅能够让模型在匿名环境下公平竞争,还能通过用户的直接参与和反馈,收集到大量真实世界的交互数据,这对于细化模型性能评测标准、发现各模型独特优势与不足至关重要。评价模型时,我们应关注其在理解复杂指令、生成质量、反应速度、创新性以及对多领域知识的掌握等方面的表现。真正的“诚意”好货,应当是在这些综合指标上表现均衡且突出的模型。通过持续的评测与迭代,相信能够促进整个行业的健康发展,为用户提供更加精准、高效的语言服务体验。

1

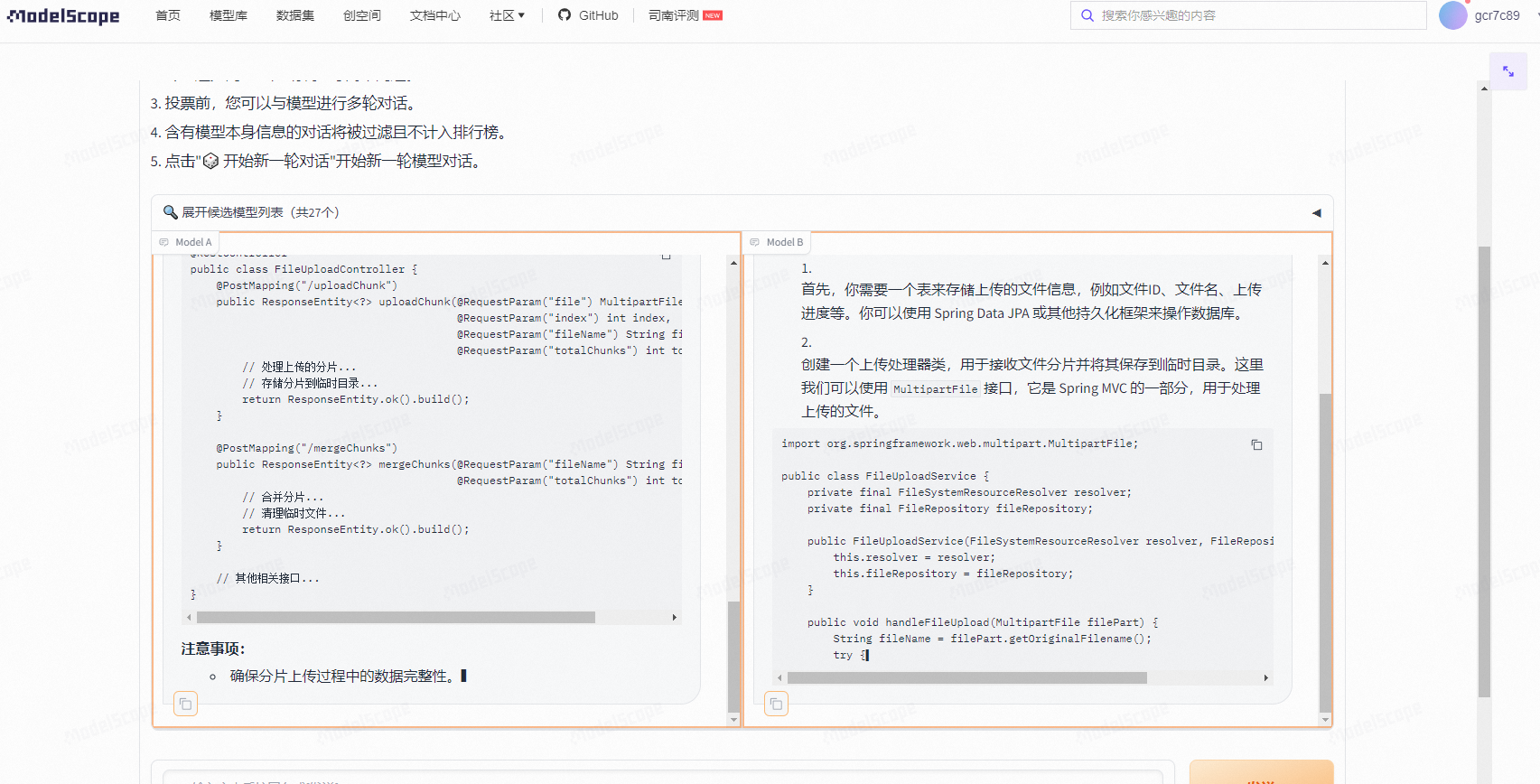

2 提出了一个问题是生成springboot 照片上传下载的代码。

总体来看,百川智能的回答最让我满意,他首先给了写代码的步骤,这样让开发者更加容易理解编写代码的逻辑,能够在脑袋中形成思维,以后没有这种大模型帮助的时候也能够独立编写代码,整体的内容两个模型都差不多,只是有一点点细微的区别,百川更加注重逻辑性,字节豆包直接给出了答案

网上找了一篇文章,让两个模型给出文章的摘要,左边百川智能模型的摘要还是比较简洁明了的,也能非常准确的表达意思,右边腾讯混元的内容就比较长,不够简洁

给了一段散文,让两个模型模仿写一段类似的,左边的是用相同的散文题目写的,右边的是全新的题目写的,两者都和给出的样例很相似,只能说都很优秀

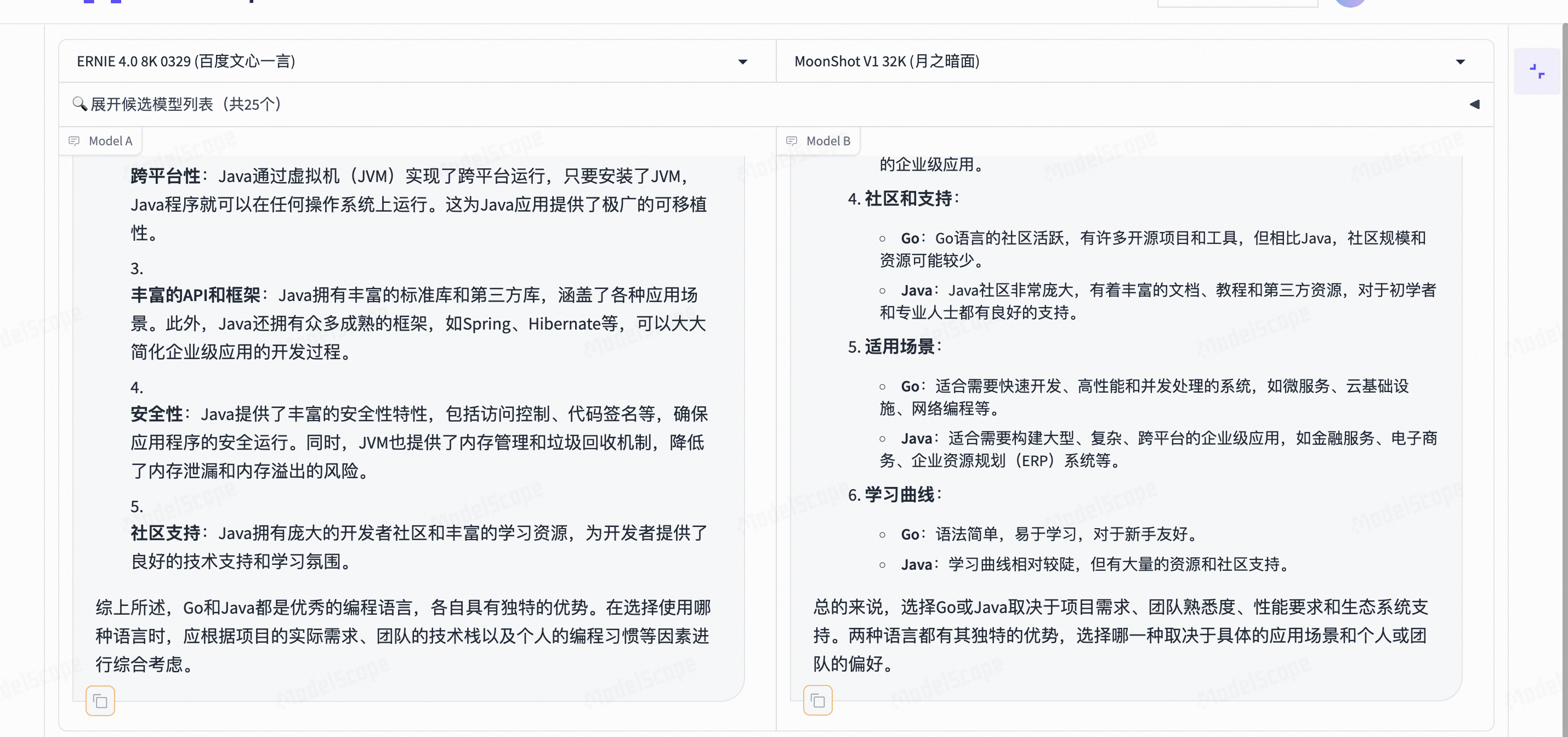

我的问题是 go和java ,两个模型都回答了两种语言的优缺点和特点,还是比较相似的,速度也差不多,分不出优劣

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352