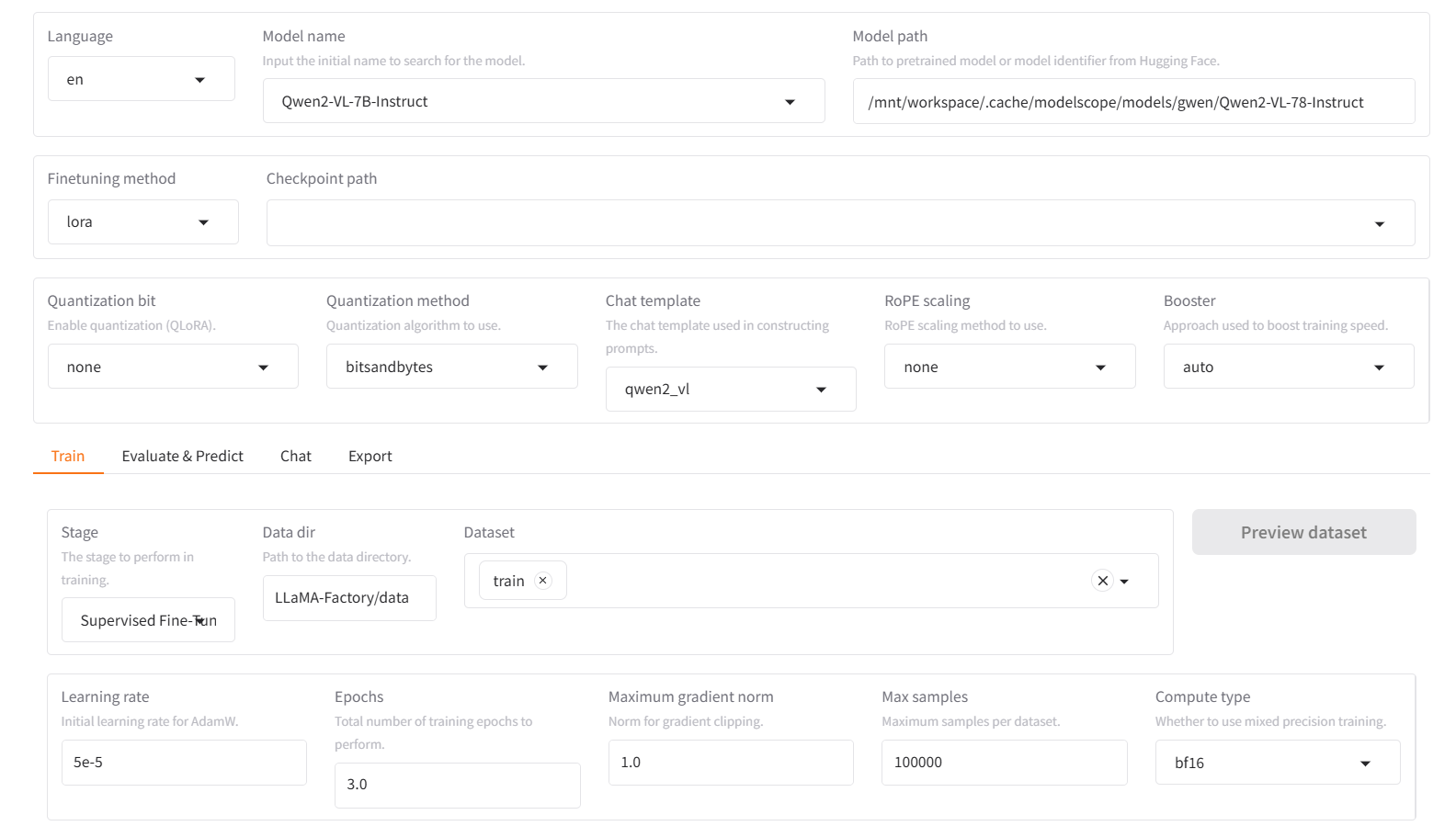

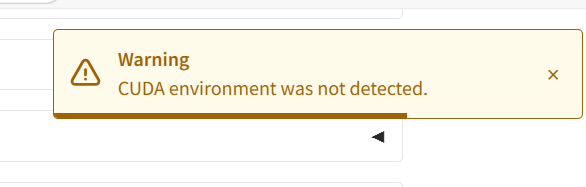

在modelscope平台利用llama factory进行Qwen2-VL-7Binstruct模型微调时,报错:CUDA未被检测。

我的GPU配置:Ubuntu22.04-CUDA12.1.0-PY310-TORCH2.3.1-TORCH2.3.1 -tf2.16.1-1.23.0

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352