modelscope-funasr的run_server.sh 只能用量化模型吗?用pytorch模型报错

modelscope-funasr 是阿里云开发的语音识别服务组件,它支持使用不同的模型类型进行服务部署。关于您提到的 run_server.sh 脚本只能用量化模型而不能直接使用 PyTorch 模型并报错的问题,这可能与几个因素相关:

模型兼容性:modelscope-funasr 的服务脚本可能为了提高推理效率,默认或优化后主要支持经过量化的模型(如INT8模型),因为量化模型在推理时对资源消耗更小,速度更快。未经量化的PyTorch模型可能因内存占用大、推理速度慢而不直接被支持。

环境配置:确保您的运行环境中已正确安装了所有必要的依赖,包括PyTorch以及与模型兼容的版本。有时候,错误可能是由于环境配置不匹配导致的。

模型转换:如果脚本确实只接受特定格式的模型,您可能需要将PyTorch模型转换为所需的格式。对于FunASR,这通常涉及到将PyTorch模型转换为ONNX格式或者进行模型量化。您可以查阅FunASR的官方文档,了解如何将您的PyTorch模型转换成能够被服务端支持的格式。

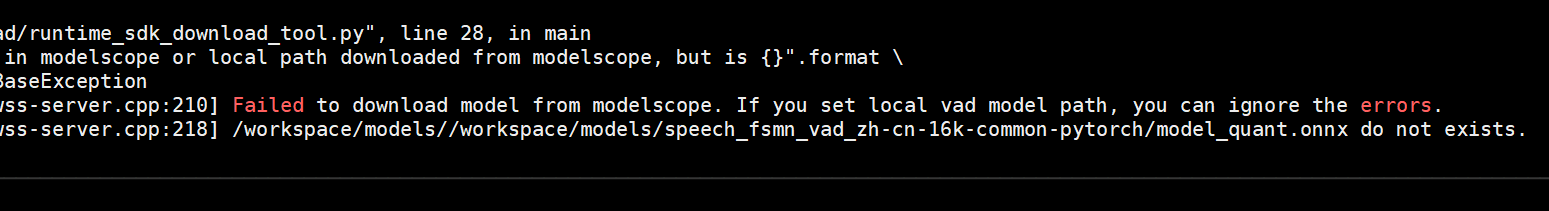

查看错误日志:具体报错信息是解决问题的关键。请仔细查看运行时的错误日志,它会提供关于为何PyTorch模型无法使用的具体原因,比如缺少某些库、模型结构不兼容或是其他运行时错误。

官方文档和社区支持:建议参考阿里云ModelScope或FunASR的官方文档,看是否有针对不同模型格式的具体部署指南。同时,加入相关的开发者社区或论坛,如阿里云开发者社区,提问并寻求帮助,可能会有遇到过类似问题的开发者能提供解决方案。

如果您的项目需求中必须使用未量化的PyTorch模型,且当前工具不直接支持,考虑反馈给阿里云ModelScope团队,询问是否有计划增加对原生PyTorch模型的支持,或者寻找是否有其他工作流程可以绕过这一限制。