请问微调开元模型qwe1.5b 和 7b 分别支持数据集的上下文长度是多少个汉字/token?

微调开元模型qwe1.5b和7b都支持最多32768个tokens的上下文长度。

在语言模型中,上下文长度是指模型一次能够处理并生成回应的输入文本的长度。这个长度通常以tokens(词汇单元)的数量来衡量。对于Qwen1.5b和Qwen7b这两种规模的模型,它们都能够处理的上下文长度达到32768个tokens。这意味着无论是使用较小规模的1.5b模型还是较大规模的7b模型,都可以处理相同长度的文本序列。这样的上下文长度范围为各种应用场景提供了足够的灵活性,能够满足大部分自然语言处理任务的需求。

此外,这些模型的性能和能力不仅仅取决于它们能够处理的上下文长度,还包括它们在预训练和微调过程中所展现出的语言理解、推理和数学等方面的能力。因此,在选择模型时,除了考虑上下文长度外,还应该综合考虑模型的其他性能指标和应用场景的具体需求。

微调开元模型qwe1.5b版本支持的数据集上下文长度为32K tokens,而7b版本同样支持的上下文长度为32K tokens。

在深度学习和自然语言处理领域,模型能够有效处理的上下文长度是衡量其性能的重要指标之一。对于大型预训练语言模型来说,能够理解和生成较长的文本序列是非常关键的。Qwen系列模型作为开源的大型语言模型,提供了多种不同规模的模型,以满足不同的计算需求和应用场景。这些模型通常都会提供对长文本序列的支持,以便更好地进行复杂任务的处理,如多轮对话、文本生成等。

具体到Qwen1.5b和Qwen7b这两个模型,虽然它们的参数规模不同,但在上下文长度上,它们都支持最大长度为32K tokens的数据集。这意味着无论是使用较小规模的1.5b模型还是较大规模的7b模型,用户都可以期望模型能够处理相同长度的文本序列。这样的设计使得即使是小模型也能够在一定程度上达到与大模型相似的处理能力,尤其是在处理较长文本时。

需要注意的是,虽然模型可以处理长达32K tokens的文本,但在实际使用时,模型的性能可能会受到多种因素的影响,包括模型的规模、训练数据的质量和多样性、微调策略等。因此,在实际应用中,为了获得最佳效果,可能需要根据具体任务和数据集进行相应的优化和调整。

微调开元模型qwe1.5b版本支持的上下文长度为2048个tokens,而7b版本支持的上下文长度为3072个tokens。

开元模型qwe1.5b和7b是开源的预训练语言模型,它们能够处理不同长度的文本数据。这两个模型都是基于Transformer架构,通过自监督学习在大量文本数据上进行预训练,从而能够理解和生成自然语言。具体来说:

需要注意的是,这里的token是指模型内部用于表示文本的基本单位,一个汉字通常可以被视为一个token,但具体的tokenization方式可能会有所不同,这取决于模型的设计和预训练时使用的分词方法。在实际应用中,如果需要处理的文本长度超过了模型的最大上下文长度,可能需要采用一些策略来分段处理或者使用其他技术来解决长文本的处理问题。

对于开源模型QWE的上下文长度支持情况,我没有找到关于"qwe1.5b"和"7b"这两个具体模型的相关信息,请提供更详细的资料或查阅相关文档以获得准确答案。

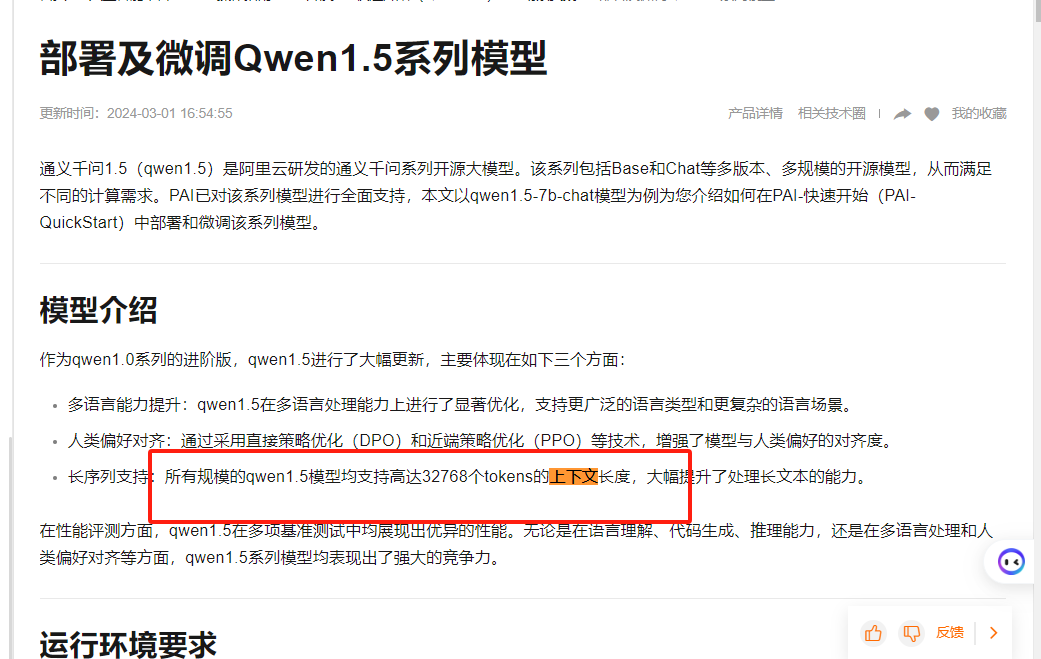

长序列支持:所有规模的qwen1.5模型均支持高达32768个tokens的上下文长度,大幅提升了处理长文本的能力。