1.算法仿真效果

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

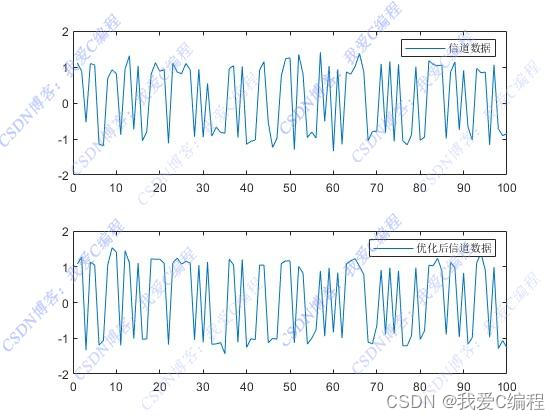

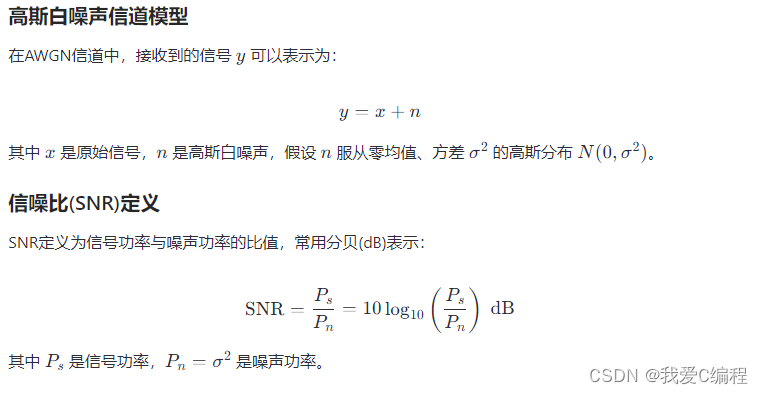

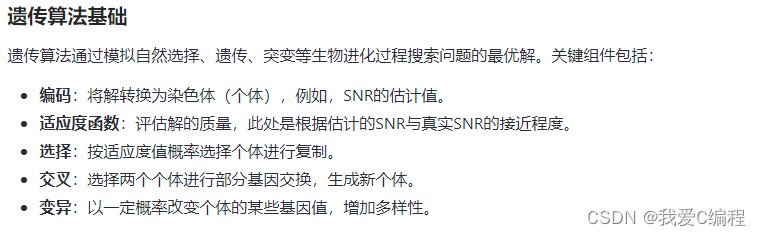

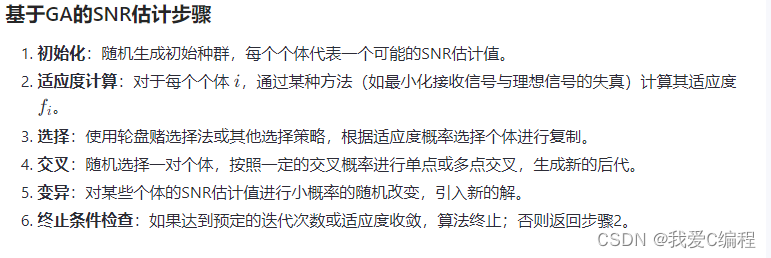

基于遗传算法(Genetic Algorithm, GA)的高斯白噪声信道(Additive White Gaussian Noise, AWGN)信噪比(Signal-to-Noise Ratio, SNR)估计方法是一种利用生物进化原理进行全局优化的技术,旨在寻找最优解,以准确估计通信系统中信号与噪声的比例。在通信领域,准确估计SNR对于评估系统性能、优化传输参数、设计抗干扰策略至关重要。

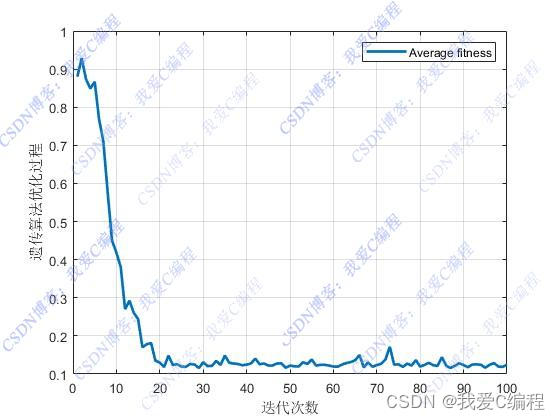

通过上述过程,遗传算法能够逐渐逼近真实的SNR值,尤其是在面对复杂信道条件和高噪声环境下,传统方法难以准确估计的情况。此方法的灵活性和全局搜索能力使其成为处理非线性、非凸优化问题的有效工具。

3.MATLAB核心程序

while gen < MAXGEN;

[gen,ij]

Pe0 = 0.9995;

pe1 = 0.0005;

FitnV=ranking(Objv);

Selch=select('sus',Chrom,FitnV);

Selch=recombin('xovsp', Selch,Pe0);

Selch=mut( Selch,pe1);

phen1=bs2rv(Selch,FieldD);

for a=1:1:NIND

X = phen1(a);

%计算对应的目标值

[epls] = func_obj(X);

E = epls;

JJ(a,1) = E;

end

IDX = find(JJ > 100000000);

JJ(IDX)=[];

Objvsel=(JJ);

[Chrom,Objv]=reins(Chrom,Selch,1,1,Objv,Objvsel);

gen=gen+1;

Error(gen) = mean(JJ);

[VV,II] = min(JJ);

end

figure;

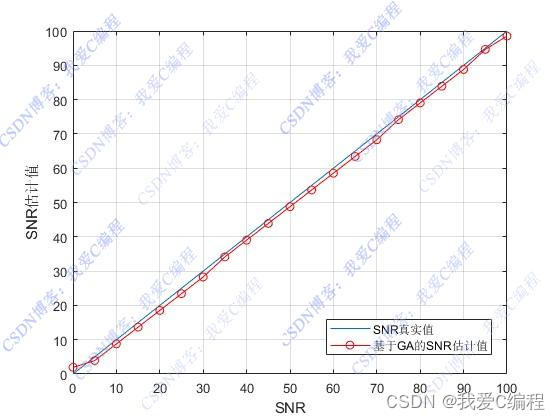

plot(SNRs,SNRs);

hold on

plot(SNRs,SNRest,'r-o');

xlabel('SNR');

ylabel('SNR估计值');

grid on

legend('SNR真实值','基于GA的SNR估计值');

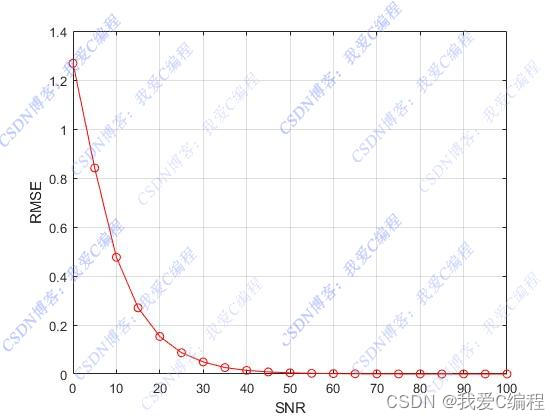

figure;

plot(SNRs,RMSE2,'r-o');

xlabel('SNR');

ylabel('RMSE');

grid on

0X_062m