问题一:Flink CDC里有没有遇到这些情况,啊?

Flink CDC里有没有遇到这些情况,啊? 如果任务不重启, 不管是新增删除编辑都是没有问题的, 只要有一端的flink任务重启了, 就会出现以下问题: mysql同步到kafka(采集数据), 再由kafka同步kafka(搬运数据), 再由kafka同步到mysql(数据落库), 当停止采集或者落库任务后, 再次启动采集或者落库任务, 现在出现以下几个问题

现在现象: ① 源表新增数据同步同步到目标表, 可以对新增的数据进行编辑同步到目标表, 可以新增的数据进行删除, 目标也会同步删除

② 源表旧数据进行编辑, 目标表也会同步编辑的数据, 但是如果编辑后再删除源表数据, 目标表数据会还原成编辑之前的数据, 实质上源表数据已经删除了

③ 源表删除旧数据, 目标表不会同步删除

参考回答:

看这个state。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/592310

问题二:Flink CDC里cdc后面是不是不能接窗口函数呢?

Flink CDC里cdc后面是不是不能接窗口函数呢?

参考回答:

Flink CDC中的CDC源表不支持直接使用窗口函数。如果需要对CDC数据进行窗口分组和聚合操作,可以在捕获到CDC数据后,使用Flink的窗口和开窗函数来处理最终的聚合结果。

在Flink中,CDC(Change Data Capture)是一种用于捕获数据库变更的技术,它可以实时地监控数据库的变化并将这些变化数据同步到下游系统。由于CDC源表的特殊性,它们通常不支持直接在其上应用窗口函数。这是因为CDC源表主要用于捕获和传输数据变更,而不是执行复杂的计算操作。

因此,当需要在数据处理流程中加入窗口函数时,应该在CDC源表之后的数据流中进行。具体来说,可以先将CDC数据转换为普通的数据流,然后在该数据流上应用窗口函数进行处理。这样,就可以利用Flink的强大计算能力来实现复杂的数据分析和处理任务。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/592311

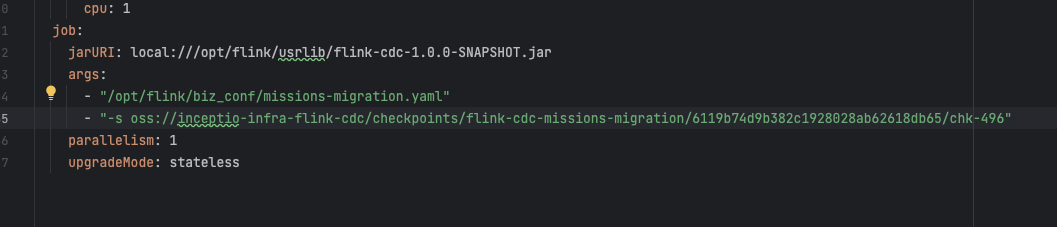

问题三:Flink CDC里每次重新启动任务它都会新建的话如何保证断点续传呢?

Flink CDC里我的flink任务每次启动都会在我给的checkpoint目录下面用随机字符串建立子目录,这样我每次重新启动任务它都会新建的话如何保证断点续传呢? 我是通过FlinkDeployment部署到云上,启动的时候我尝试这样加过参数,但是貌似起不了作用,可能因为我这个目录是checkpoint自动生成的,不是我手动savepoint的?

参考回答:

checkpoint是系统做的,系统出错重试的时候,自己会去找checkpoint目录的检查点,默认是不持久化的

savepoint是手动做的,配合job的迭代使用

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/592313

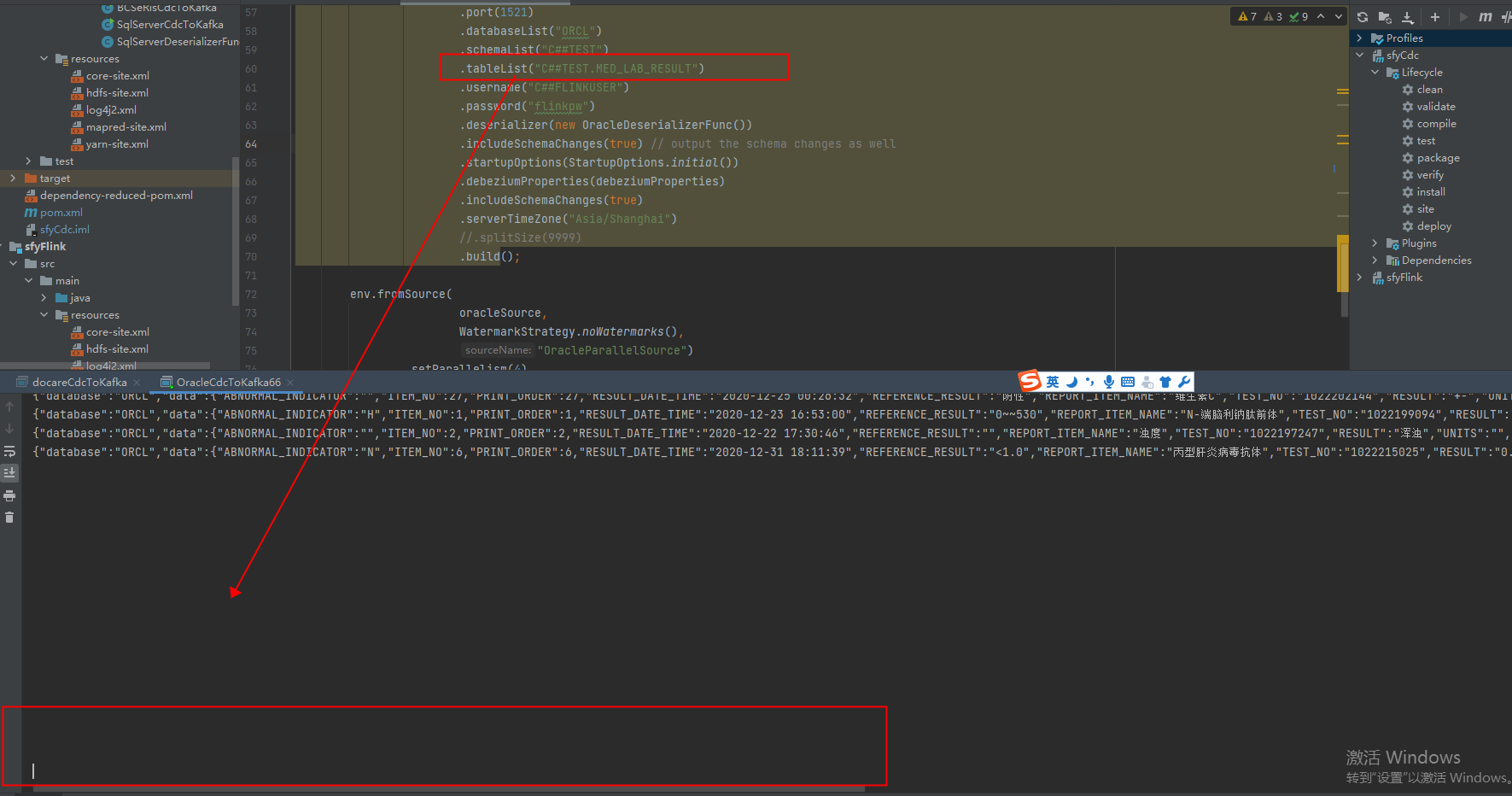

问题四:Flink CDCOraclecdc JdbcIncrementalSource 为啥捕获不到数据?

Flink CDC里Oraclecdc JdbcIncrementalSource 捕获不到数据也不报错,什么情况,如何定位问题? Oracle日志也没报错怎么回事?

参考回答:

如果Flink CDC的Oraclecdc JdbcIncrementalSource捕获不到数据也不报错,可能是以下原因:

- 检查数据库连接是否正常,可以尝试使用其他工具连接数据库,确认连接是否成功。

- 检查JdbcIncrementalSource的配置是否正确,特别是表名和字段名是否正确。

- 检查Flink任务的并行度是否设置正确,如果并行度设置过高,可能会导致数据无法正常消费。

- 检查Flink任务的checkpoint是否配置正确,如果checkpoint配置不正确,可能会导致数据无法正常消费。

- 检查Oracle数据库的日志,查看是否有异常或错误信息。

如果以上方法都无法解决问题,可以联系Flink社区或Oracle技术支持寻求帮助。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/592314

问题五:Flink CDC里我是想自动做断点续传,比如我某个任务的容器crash了,我需要重启任务怎么办?

Flink CDC里我是想自动做断点续传,比如我某个任务的容器crash了,我需要重启任务,这个时候没法预知去手动savepoint,该如何处理呢?

参考回答:

Flink CDC 支持断点续传功能,您可以通过以下步骤实现自动断点续传:

- 启用检查点:要启用Flink CDC的断点续传功能,首先需要启用检查点。您可以在Flink任务中通过调用

env.enableCheckpointing(interval)方法来启用检查点,其中interval参数表示检查点的间隔时间。 - 配置检查点存储:您需要为检查点指定一个可靠的存储位置,这样在任务失败后可以从最近的检查点恢复数据流的处理。

- 使用增量快照框架:为了提高CDC Connector的能力,Flink CDC引入了增量快照框架,这使得即使在没有手动savepoint的情况下,也能在任务失败后从最近的状态恢复。

- 监控和日志:确保您的监控系统能够捕捉到任务失败的情况,并记录足够的日志信息,以便在任务失败后能够快速定位问题并采取措施。

- 测试和验证:在实际生产环境中启用断点续传之前,建议在测试环境中进行充分的测试和验证,以确保断点续传机制能够正常工作。

总的来说,通过上述步骤,即使您的Flink任务容器发生了crash,也能够通过检查点机制自动恢复到最近的状态,从而实现断点续传,减少数据丢失的风险。此外,Flink CDC的设计是分布式的,可以满足海量数据同步的业务场景。因此,您可以放心地在生产环境中使用Flink CDC来实现数据的实时同步和处理。

关于本问题的更多回答可点击原文查看:https://developer.aliyun.com/ask/592315