问题一:Flink CDC sql-client内同步mysql表没有数据是什么情况 lib内集成了?

Flink CDC sql-client内同步mysql表没有数据是什么情况

lib内集成了sql-connector-mysql包?binlog是开的,SET 'execution.checkpointing.interval' = '3s';这个嘛?

参考答案:

Flink CDC sql-client 内的同步 MySQL 表没有数据,可能是以下原因:

MySQL 的 binlog 日志没有开启。

MySQL 的 binlog 日志没有以 binlog-row-image 模式记录。

Flink CDC sql-client 的配置不正确。

要解决这个问题,可以检查以下几个方面:

检查 MySQL 的 binlog 日志是否开启。

检查 MySQL 的 binlog 日志是否以 binlog-row-image 模式记录。

检查 Flink CDC sql-client 的配置是否正确。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/546475?spm=a2c6h.13066369.question.43.2ac075eb8Ifc19

问题二:Flink CDC中同步数据时,半夜零点几分,会丢失update操作的情况什么原因?

Flink CDC中同步数据时,半夜零点几分,会丢失update操作的情况吗,flink 1.14.5, mysql cdc 2.2.1,什么原因?同步到doris。

参考答案:

在 Flink CDC 中,半夜零点几分丢失 update 操作的情况可能由以下原因引起:

- 时间窗口选择不正确:请确保您的 Flink 窗口或时间窗口操作(如 Tumble Window、Sliding Window)的定义正确,并且覆盖了需要捕获的更新操作。如果窗口的起始时间不正确,可能会导致一些更新操作被忽略。

- MySQL 数据库配置:在 MySQL CDC 连接器中,确保您正确配置了 Binlog 的相关参数,如

startup.mode和startup.timestamp-millis,以便正确地从指定的位置开始读取 Binlog。如果配置不正确,可能会导致某些更新操作无法被捕获。 - Flink CDC 作业异常或停止:检查 Flink CDC 作业是否在半夜零点几分期间发生了异常或被停止。如果作业未能正常运行,将导致数据同步中断和丢失。

- 目标系统 (Doris) 配置问题:确保目标系统(例如 Doris)的配置正确,并且可以正常处理和接收更新操作。如果目标系统配置有问题,可能会导致数据同步失败或部分更新操作丢失。

建议您检查和验证上述方面,以确定造成半夜零点几分丢失 update 操作的具体原因。同时,检查相关日志文件以获取更多的错误信息和上下文。

如果问题仍然存在,请提供更多详细信息,例如 Flink CDC 作业的配置、相关日志片段和其他上下文信息,以便我们更深入地分析和解决问题。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/535995?spm=a2c6h.13066369.question.42.2ac075eb2RUpqO

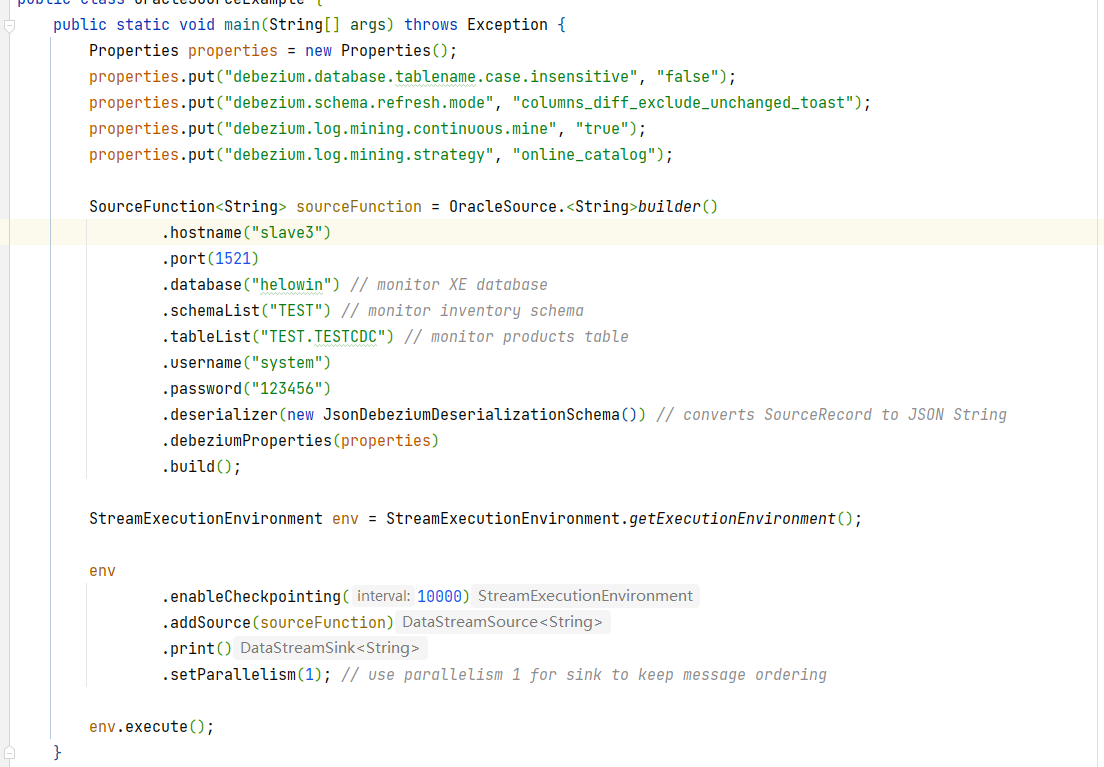

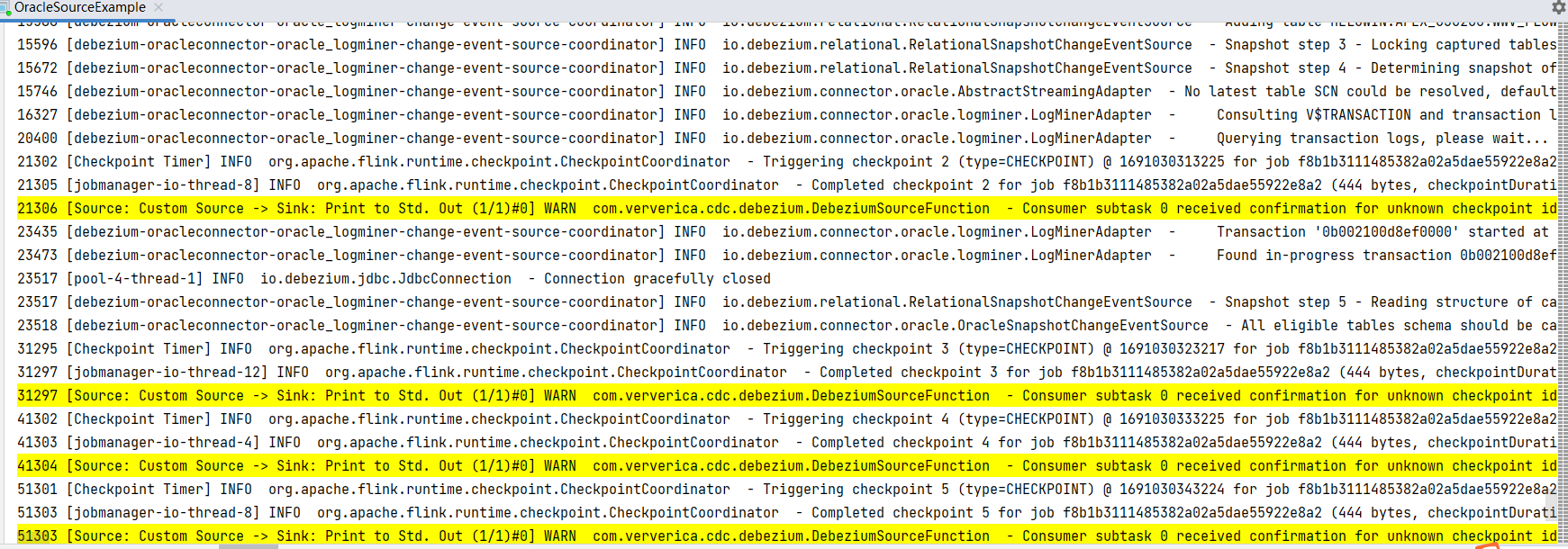

问题三:Flink CDC中oracle 2.4.1 没法同步数据是什么原因呢?

"Flink CDC中oracle 2.4.1 没法同步数据是什么原因呢?

"

参考答案:

Flink CDC 的版本号。

Oracle 数据库的版本号。

Flink CDC 的配置信息,包括连接参数、表配置等。

错误日志或异常堆栈跟踪,以便更准确地分析问题。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/541372?spm=a2c6h.13066369.question.45.2ac075eb4M5vOt

问题四:Flink CDC全量的时候由于数据量太大不适合同步进行,你们的解决方案是啥样的啊?不想添加mq增加维护负担

Flink CDC全量的时候由于数据量太大不适合同步进行,你们的解决方案是啥样的啊?不想添加mq增加维护负担

参考答案:

数据大,增加并行度,

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/545985?spm=a2c6h.13066369.question.44.2ac075ebflMzZx

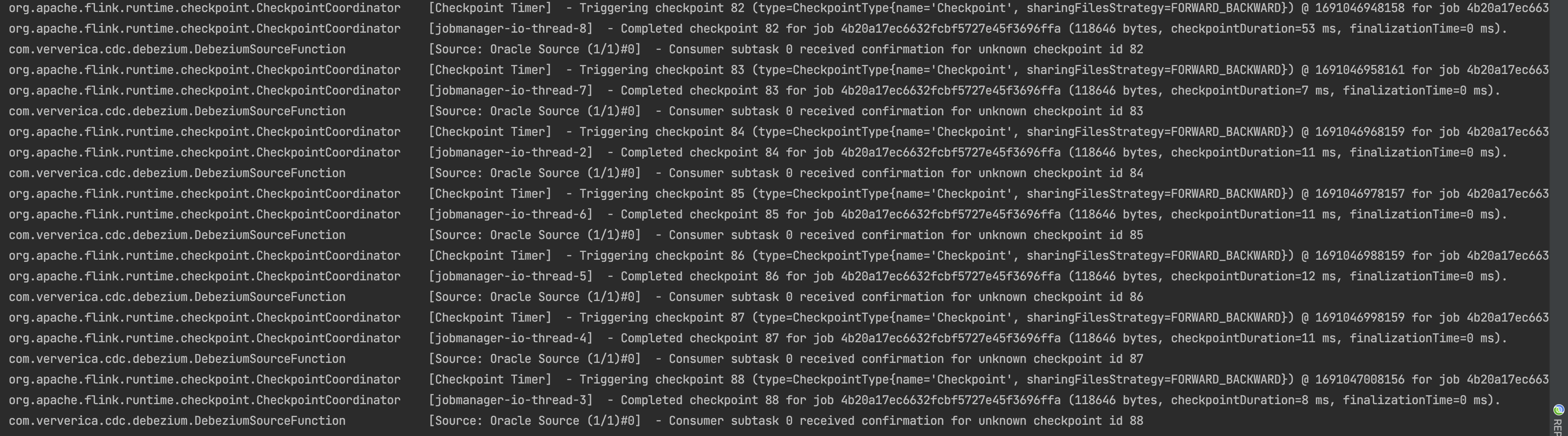

问题五:Flink CDC中同样的代码在cdc 2.4 打印这些日志,无法同步数据什么原因?

Flink CDC中

同样的代码在cdc 2.4 打印这些日志,无法同步数据

在cdc 2.3 能打印全量数据 不嫩怪打印增量,开了checkpointOracle版本是11.2.0.1Flink版本是1.14.6CDC 2.4 版本Oracle 这是啥问题啊?

参考答案:

不会Oracle,推荐2.4.1的cd。

关于本问题的更多回答可点击进行查看:

https://developer.aliyun.com/ask/541335?spm=a2c6h.13066369.question.47.2ac075eb4Bw1fU