梦笔生花伟

已加入开发者社区988天

勋章

专家博主

专家博主

星级博主

星级博主

乘风问答官

乘风问答官

技术博主

技术博主

一代宗师

一代宗师

我关注的人

粉丝

技术能力

兴趣领域

- C语言

- 芯片

- Python

- Android开发

- 人工智能

- 智能网卡

- 小程序

擅长领域

技术认证

暂时未有相关云产品技术能力~

凡事预则立,不预则废

暂无精选文章

暂无更多信息

2024年09月

-

09.11 22:47:00

发表了文章

2024-09-11 22:47:00

发表了文章

2024-09-11 22:47:00

使用CLion进行ROS开发

1.安装基本的ROS环境 ROS环境的安装请参考安装ROS。 安装CLion 下载CLion Linux的下载地址如下:CLion 解压CLion 将下载的CLion复制到/opt目录下(你可以解压到适合自己的文件夹,只要保证后续使用的路径一致即可),然后在这个目录下使用终端将其解压,命令如下所示(其中CLion-xxxx.xx.xx.tar.gx为下载的安装包名): sudo tar -zxvf CLion-xxxx.xx.xx.tar.gx 使用脚本安装CLion 运行解压后的文件夹中的clion.sh脚本,进行安装: 1.运行安装 2.登录激活可以选择教 -

09.10 21:54:22

发表了文章

2024-09-10 21:54:22

发表了文章

2024-09-10 21:54:22

关于粒子滤波的解析

粒子滤波流程 基本原理:随机选取预测域的 N NN 个点,称为粒子。以此计算出预测值,并算出在测量域的概率,即权重,加权平均就是最优估计。之后按权重比例,重采样,进行下次迭代。 初始状态:用大量粒子模拟X(t),粒子在空间内均匀分布; 预测阶段:根据状态转移方程,每一个粒子得到一个预测粒子; 校正阶段:对预测粒子进行评价,越接近于真实状态的粒子,其权重越大; 重采样:根据粒子权重对粒子进行筛选,筛选过程中,既要大量保留权重大的粒子,又要有一小部分权重小的粒子; 滤波:将重采样后的粒子带入状态转移方程得到新的预测粒子,即步骤2。 1. 初始状态 我们假设 GPS 的位置及航向输出 -

09.09 22:49:48

发表了文章

2024-09-09 22:49:48

发表了文章

2024-09-09 22:49:48

C++ 之 perf+火焰图分析与调试

简介 在遇到一些内存异常的时候,经常这部分的代码是很难去进行分析的,最近了解到Perf这个神器,这里也展开介绍一下如何使用Perf以及如何去画火焰图。 1. Perf 基础 1.1 Perf 简介 perf是Linux下的一款性能分析工具,能够进行函数级与指令级的热点查找。利用perf剖析程序性能时,需要指定当前测试的性能时间。性能事件是指在处理器或操作系统中发生的,可能影响到程序性能的硬件事件或软件事件 1.2 Perf的安装 ubuntu 18.04: sudo apt install linux-tools-common linux-tools-4.15.0-106-gen -

09.08 21:28:35

发表了文章

2024-09-08 21:28:35

发表了文章

2024-09-08 21:28:35

Transformer图解以及相关的概念解析

前言 transformer是目前NLP甚至是整个深度学习领域不能不提到的框架,同时大部分LLM也是使用其进行训练生成模型,所以transformer几乎是目前每一个机器人开发者或者人工智能开发者不能越过的一个框架。接下来本文将从顶层往下去一步步掀开transformer的面纱。 transformer概述 Transformer模型来自论文Attention Is All You Need。 在论文中最初是为了提高机器翻译的效率,它使用了Self-Attention机制和Position Encoding去替代RNN。后来大家发现Self-Attention的效果很好,并且在其它的地 -

09.06 22:26:16

发表了文章

2024-09-06 22:26:16

发表了文章

2024-09-06 22:26:16

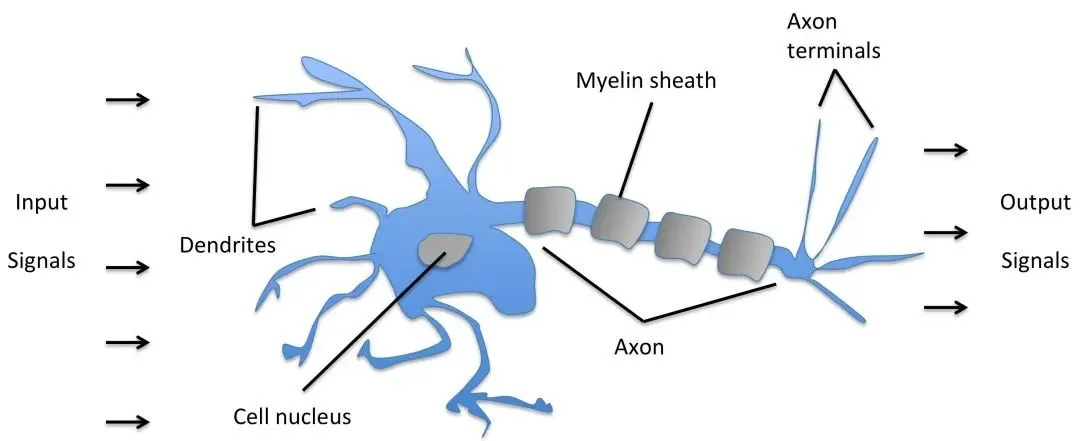

对深度学习概念的基础理解与认识

一、神经网络的组成 人工神经网络(Artificial Neural Networks,简写为ANNs)是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。 这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的,并具有自学习和自适应的能力。神经网络类型众多,其中最为重要的是多层感知机。为了详细地描述神经网络,我们先从最简单的神经网络说起。 感知机 感知机是1957年,由Rosenblatt提出会,是神经网络和支持向量机的基础。 感知机是有生物学上的一个启发,他的参照对象和理论依据可以参照下图:(我们的大脑可以认为是一个神经网络,

-

09.05 23:48:36

发表了文章

2024-09-05 23:48:36

发表了文章

2024-09-05 23:48:36

LDO的原理及测试方法

一、基本结构 这是LM317芯片的核心,这个电路单元称为Bandgap Reference带隙基准源。属于模拟集成电路中的经典电路结构。 LDO拓扑结构图 常见的基本结构 利用VBE的负温度系数,而VT是正温度系数,正负温度系数抵消就的得到稳定的基准参考电压了(三极管的方程VBE=VT*In(lC/IS))。 二、测试意义 了解集成电路的内部结构对测试有意义么? 1、了解内部结构,才能更好的理解测试原理或者设计测试方案2、可以学习提升对电路结构的理解能力。 针对LM317,了解了内部简单原理,可以知道1、内部结构设计针对的是温度系数,因此可能受温度的影响,实际也是会受到温度的影 -

09.04 22:15:11

发表了文章

2024-09-04 22:15:11

发表了文章

2024-09-04 22:15:11

开关电源DC-DC电源应用

DC-DC指直流转直流电源(Direct Current)。是一种在直流电路中将一个电压值的电能变为另一个电压值的电能的装置。如,通过一个转换器能将一个直流电压(5.0V)转换成其他的直流电压(1.5V或12.0V),我们称这个转换器为DC-DC转换器,或称之为开关电源或开关调整器。 DC-DC转换器一般由控制芯片,电感线圈,二极管,三极管,电容器构成。在讨论DC-DC转换器的性能时,如果单针对控制芯片,是不能判断其优劣的。其外围电路的元器件特性,和基板的布线方式等,能改变电源电路的性能,因此,应进行综合判断。 DC-DC转换器的使用有利于简化电源电路设计,缩短研制周期,实现最佳指标等,被 -

09.03 21:30:06

发表了文章

2024-09-03 21:30:06

发表了文章

2024-09-03 21:30:06

关于LDO,读懂这一篇就够了

在电子设计中,我们经常需要用到不同的直流电压给不同器件供电,其中广泛常见的就是通过LDO稳压芯片来实现得到不同的直流电压输出,因为成本低、性能好,且使用起来也很简单,让低压差线性稳压器(下文简称LDO)用的也越来越多,几乎每款电子产品里都有其身影。 说它好用,是因为在普通设计里,只需要加入合适的输入电压,和几个滤波电容即可得到想要的输出电压,非常简单,然而也正因为这看似简单的用法也要工程师熟悉LDO的主要参数结合自己的具体设计。LDO是靠自身的反馈环路控制主功率管,与负载分压,保持输出端电压的稳定。不同于 DC-DC,LDO 的输入电流,输出电流,和负载电流相等,属于串联关系,因此 LDO -

09.02 21:53:10

发表了文章

2024-09-02 21:53:10

发表了文章

2024-09-02 21:53:10

DC-DC产品设计PCB注意事项

DC-DC的电路比LDO会复杂很多,噪声也更大,布局和layout要求更高,layout的好坏直接影响DC-DC的性能,所以了解DC-DC的layout至关重要。 一、Bad Layout EMI,DC-DC的SW管脚上面会有较高的dv/dt, 比较高的dv/dt会引起比较大的EMI干扰; 地线噪声,地走线不好,会在地线上面会产生比较大的开关噪声,而这些噪声会影响到其它部分的电路; 布线上产生电压降,走线太长,会使走线上产生压降,而降低整个DC-DC的效率; 二、一般原则 开关大电流回路尽量短; 信号地和大电流地(功率地)单独走线,并在芯片GND处单点连接; ① 开关回路短

2024年08月

-

08.28 23:03:11

发表了文章

2024-08-28 23:03:11

发表了文章

2024-08-28 23:03:11

关于LDO,读懂这一篇就够了

在电子设计中,我们经常需要用到不同的直流电压给不同器件供电,其中广泛常见的就是通过LDO稳压芯片来实现得到不同的直流电压输出,因为成本低、性能好,且使用起来也很简单,让低压差线性稳压器(下文简称LDO)用的也越来越多,几乎每款电子产品里都有其身影。 说它好用,是因为在普通设计里,只需要加入合适的输入电压,和几个滤波电容即可得到想要的输出电压,非常简单,然而也正因为这看似简单的用法也要工程师熟悉LDO的主要参数结合自己的具体设计。LDO是靠自身的反馈环路控制主功率管,与负载分压,保持输出端电压的稳定。不同于 DC-DC,LDO 的输入电流,输出电流,和负载电流相等,属于串联关系,因此 LDO -

08.27 22:50:11

发表了文章

2024-08-27 22:50:11

发表了文章

2024-08-27 22:50:11

C语言的二叉树

1.树概念及结构 1.1树的概念 树是一种非线性的数据结构,它是由n(n>=0)个有限结点组成一个具有层次关系的集合。把它叫做树是因为它看起来像一棵倒挂的树,也就是说它是根朝上,而叶朝下的。 补充定义: 有一个特殊的结点,称为根结点,根节点没有前驱结点。除根节点外,其余结点被分成M(M>0)个互不相交的集合T1、T2、……、Tm,其中每一个集合Ti(1<= i <= m)又是一棵结构与树类似的子树。每棵子树的根结点有且只有一个前驱,可以有0个或多个后继。因此,树是递归定义的。 1.2 树的相关概念 节点的度:一个节点含有的子树的个数称为该节点的度; 如上图:A的为6 叶节点或终端 -

08.25 22:06:46

发表了文章

2024-08-25 22:06:46

发表了文章

2024-08-25 22:06:46

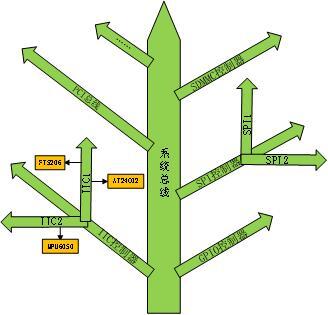

基于RT-Thread的智能家居助手

一、项目简介 智能家居助手主要基于RT-Thread开发的,该系统主要分为语音子系统,环境监测子系统,智能控制子系统,智能网关子系统,音乐播放器,云端以及应用软件七大部分。语音子系统可通过语音进行人机交互来控制家电设备。环境监测子系统为智能家居提供环境信息输入,实时监测室内的环境信息。智能控制子系统为智能家居提供控制接口,用户可根据实际需求来控制家电设备。 智能网关是整个系统的核心和枢纽,为整个智能家居提供网络,同时与云平台进行交互,不断更新室内信息,实时将数据上传至云端,用户就能在远程进行查室内的各种环境信息,实时掌握家中的最新动态。音乐播放器为用户提供音乐服务。云端部分为智能家居系统云 -

08.23 23:10:59

发表了文章

2024-08-23 23:10:59

发表了文章

2024-08-23 23:10:59

一款基于AB32VG1的桌面智能坞

项目简介: 我基于这个开发板制作了一款桌面小工具,它是一个小巧、功能丰富、具有实用价值的桌面物联网“控制中枢”。可以实现: 精灵播放音乐时内部有一颗呼吸灯的效果; 精灵可以通过OLED显示当前音乐名字、播放状态; 精灵可以自动连接到MQTT服务器,实现网络交互; 精灵可以通过红外遥控,实现音乐切换和暂停播放; 精灵可以通过手机连接热点配网,配置联网信息,连接 WIFI; 精灵连接有功放模块实现播放TF卡中的音乐; 精灵连接有一个RGB彩灯,在一个精致小夜灯中实现彩虹灯的效果; 精灵连接有一个灯管,实现联网控制灯管,冬天再也不用下床关灯了; 精灵配有自主设计的微信小程序端应用,通过MQTT服务 -

08.22 23:00:09

发表了文章

2024-08-22 23:00:09

发表了文章

2024-08-22 23:00:09

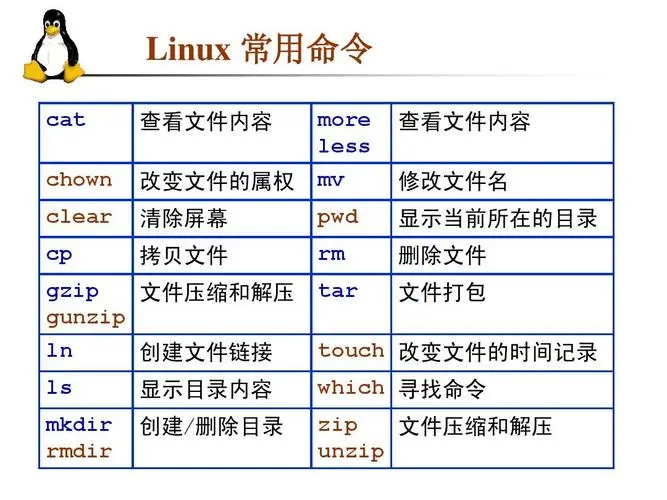

Linux基础知识介绍,安装

SRPM 包,比 RPM 包多了一个“S”,是“Source”的首字母,所以 SRPM 可直译为“源代码形式的 RPM 包”。也就是说,SRPM 包中不再是经过编译的二进制文件,都是源代码文件。可以这样理解,SRPM 包是软件以源码形式发布后直接封装成 RPM 包的产物。 从表中可以看到,SRPM 包的命名与 RPM 包基本类似,唯一区别在于 SRPM 包多了“src”标志,即 SRPM 包采用“包名-版本号-发布次数-发行商-src.rpm”的方式进行命名,比如“MySQL-5.5.29-2.el6.src.rpm”。 rpmbuild 命令的安装 rpmbuild 命令也是一个程序,但 -

08.20 22:28:09

发表了文章

2024-08-20 22:28:09

发表了文章

2024-08-20 22:28:09

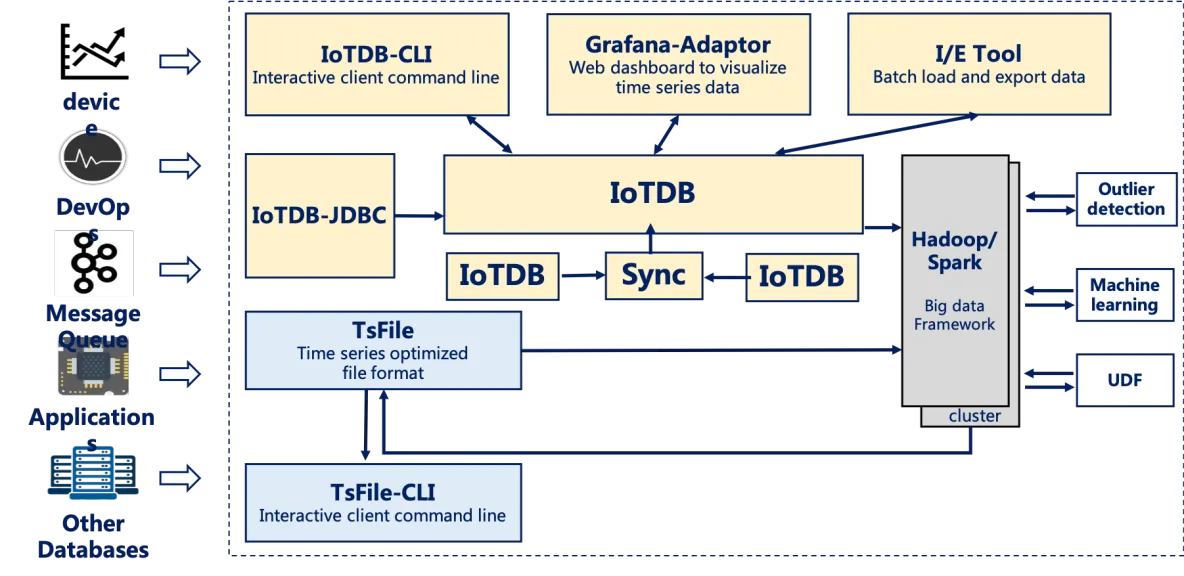

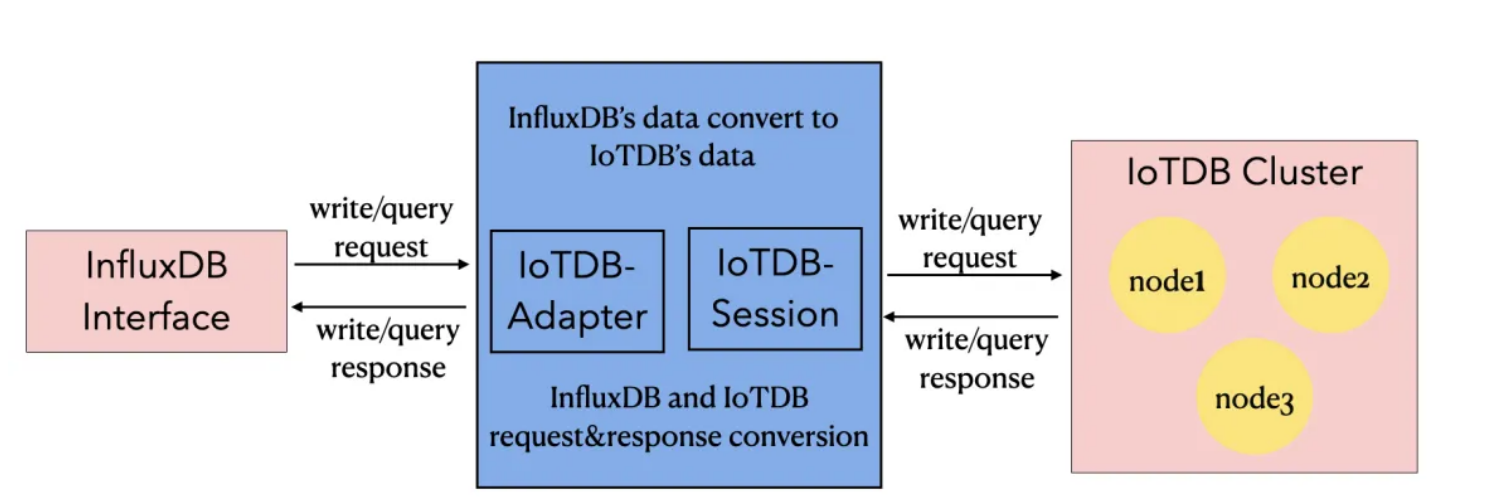

Apache IoTDB进行IoT相关开发实践

当今社会,物联网技术的发展带来了许多繁琐的挑战,尤其是在数据库管理系统领域,比如实时整合海量数据、处理流中的事件以及处理数据的安全性。例如,应用于智能城市的基于物联网的交通传感器可以实时生成大量的交通数据。据估计,未来5年,物联网设备的数量将达数万亿。物联网产生大量的数据,包括流数据、时间序列数据、RFID数据、传感数据等。要有效地管理这些数据,就需要使用数据库。数据库在充分处理物联网数据方面扮演着非常重要的角色。因此,适当的数据库与适当的平台同等重要。由于物联网在世界上不同的环境中运行,选择合适的数据库变得非常重要。 原创文字,IoTDB 社区可进行使用与传播 一、什么是IoTDB 我

-

08.19 23:15:09

发表了文章

2024-08-19 23:15:09

发表了文章

2024-08-19 23:15:09

Linux设备树(DTS)

Dts:DTS即Device Tree Source,是一个文本形式的文件,用于描述硬件信息。一般都是固定信息,无法变更,无法overlay。 设备树由来 linux内核源码中,之前充斥着大量的平台相关(platform Device)配置,而这些代码大多是杂乱且重复的,这使得ARM体系结构的代码维护者和内核维护者在发布一个新的版本的时候有大量的工作要做,以至于LinusTorvalds 在2011年3月17日的ARM Linux邮件列表中宣称“Gaah.Guys,this whole ARM thing is a f*cking pain in the ass”这使得整个ARM社区不得不 -

08.18 15:19:05

发表了文章

2024-08-18 15:19:05

发表了文章

2024-08-18 15:19:05

Visual Studio版本的AI编程助手

Visual Studio 是一个出色的 IDE,可用于构建适用于 Windows、Mac、Linux、iOS 和 Android 的丰富、精美的跨平台应用程序。 使用一系列技术(例如 WinForms、WPF、WinUI、MAUI 或 Xamarin)构建丰富。 1、安装 点击上方工具栏拓展选项,选择管理拓展选项 接着在联机页面中搜索"FItten Code",并点击下载,下载完成后重启Visual Studio 在扩展选项中选中fitten,选择Open Chat Window进入登录界面,完成注册登录 2、智能补全 打开代码文件,输入一段代码,Fitten Code 就会为您 -

08.16 22:57:19

发表了文章

2024-08-16 22:57:19

发表了文章

2024-08-16 22:57:19

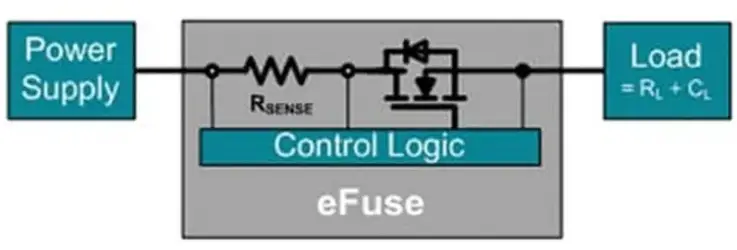

eFuse电子保险丝

热保险丝作为一种基本的电路保护器件,已经成功使用了150多年。热保险丝有效可靠、易用,具有各种不同的数值和版本,能够满足不同的设计目标。然而,对于寻求以极快的速度切断电流的设计人员来说,热保险丝不可避免的缺点就是其自复位能力,以及在相对较低的电流下的工作能力。对于这些设计人员来说,电子保险丝(通常用eFuse或者e-Fuse表示)是一种很好的解决方案,有时还可以取代热保险丝,但通常是对热保险丝功能的补充。 eFuse基于一个简单概念,即通过测量已知电阻器上的电压来检测电流,然后在电流超过设计限值时,通过场效应晶体管(FET)切断电流。eFuse具有热保险丝无法实现特性、灵活性和功能。 本文

-

08.15 23:53:43

发表了文章

2024-08-15 23:53:43

发表了文章

2024-08-15 23:53:43

Linux zip命令:压缩文件或目录

我们经常会在 Windows 系统上使用 “.zip”格式压缩文件,其实“.zip”格式文件是 Windows 和 Linux 系统都通用的压缩文件类型,属于几种主流的压缩格式(zip、rar等)之一,是一种相当简单的分别压缩每个文件的存储格式,本节要讲的 zip 命令,类似于 Windows 系统中的 winzip 压缩程序,其基本格式如下: [root@localhost ~]#zip [选项] 压缩包名 源文件或源目录列表 注意,zip 压缩命令需要手工指定压缩之后的压缩包名,注意写清楚扩展名,以便解压缩时使用。 下面给大家举几个例子。 【例 1】zip 命令的基本使用。 [r

-

08.14 22:24:25

发表了文章

2024-08-14 22:24:25

发表了文章

2024-08-14 22:24:25

Linux环境下运行介绍

1. 文件编程函数介绍 如果在Linux系统下学习C语言,就会了解到两套文件编程接口函数: C语言标准的文件编程函数: fopen、fread、fwrite、fclose Linux下提供的文件编程函数: open、read、write、close 传参的区别: 基于文件指针: fopen fclose fread fwrite 比较适合操作普通文件。 基于文件描述符: open close read write 比较适合操作设备文件。 2. C语言标准库提供的文件编程函数 下面介绍C语言标准库提供的文件编程函数,一般对文件常用的操作就是:创建(打开)、读、写、关闭。 其他的 -

08.13 23:31:18

发表了文章

2024-08-13 23:31:18

发表了文章

2024-08-13 23:31:18

C++函数重载

在实际开发中,有时候我们需要实现几个功能类似的函数,只是有些细节不同。例如希望交换两个变量的值,这两个变量有多种类型,可以是 int、float、char、bool 等,我们需要通过参数把变量的地址传入函数内部。在C语言中,程序员往往需要分别设计出三个不同名的函数,其函数原型与下面类似: void swap1(int *a, int *b); //交换 int 变量的值 void swap2(float *a, float *b); //交换 float 变量的值 void swap3(char *a, char *b); //交换 char 变量的

-

08.12 21:15:25

发表了文章

2024-08-12 21:15:25

发表了文章

2024-08-12 21:15:25

Linux设备树(DTS)

Dts:DTS即Device Tree Source,是一个文本形式的文件,用于描述硬件信息。一般都是固定信息,无法变更,无法overlay。 设备树由来 linux内核源码中,之前充斥着大量的平台相关(platform Device)配置,而这些代码大多是杂乱且重复的,这使得ARM体系结构的代码维护者和内核维护者在发布一个新的版本的时候有大量的工作要做,以至于LinusTorvalds 在2011年3月17日的ARM Linux邮件列表中宣称“Gaah.Guys,this whole ARM thing is a f*cking pain in the ass”这使得整个ARM社区不得不

-

08.09 22:31:48

发表了文章

2024-08-09 22:31:48

发表了文章

2024-08-09 22:31:48

PID算法原理分析及优化

今天为大家介绍一下经典控制算法之一的PID控制方法。PID控制方法从提出至今已有百余年历史,其由于结构简单、易于实现、鲁棒性好、可靠性高等特点,在机电、冶金、机械、化工等行业中应用广泛。 在大学期间,参加的智能汽车竞赛中就使用到了PID经典控制算法,对于智能小车的调试更加的方便。 一、PID原理 PID控制方法将偏差的比例(proportional)、积分(integral)、微分(derivative)通过线性组合构成控制量,对被控对象进行控制。 常规的PID控制系统如图所示: 系统的输入r(t)为控制量的目标输出值,输出y(t)为控制量的实际输出值,e(t)为输出量目标值与实际值 -

08.08 23:05:07

发表了文章

2024-08-08 23:05:07

发表了文章

2024-08-08 23:05:07

在Ubuntu安装RPM文件

Ubuntu软件源包含数千个deb软件包,可以从Ubuntu软件中心或使用apt命令行安装。 Deb是所有基于Debian的Linux发行版,例如包括Ubuntu,Linux mint等发行版使用的安装包格式。 如果某些软件在Ubuntu软件源中不可用,可以通过启用适当的软件源来安装,然后使用APT命令安装。 在大多数情况下,当软件开发者不提供软件源时,他们都有一个下载页面,您可以在该页面下载并安装deb软件包,或者下载源码然后编译。 虽然不常见,但某些软件开发者可能会仅发布RPM包格式的文件。RPM是Red Hat及其衍生的Linux发行版,例如如CentOS,Fedora使用软件包 -

08.07 22:49:46

发表了文章

2024-08-07 22:49:46

发表了文章

2024-08-07 22:49:46

C++语言的基本语法

想掌握一门编程语言,第一步就是需要熟悉基本的环境,然后就是最重要的语法知识。 C++ 程序可以定义为对象的集合,这些对象通过调用彼此的方法进行交互。现在让我们简要地看一下什么是类、对象,方法、即时变量。 对象 - 对象具有状态和行为。例如:一只狗的状态 - 颜色、名称、品种,行为 - 摇动、叫唤、吃。对象是类的实例。 类 - 类可以定义为描述对象行为/状态的模板/蓝图。 方法 - 从基本上说,一个方法表示一种行为。一个类可以包含多个方法。可以在方法中写入逻辑、操作数据以及执行所有的动作。 即时变量 - 每个对象都有其独特的即时变量。对象的状态是由这些即时变量的值创建的。 完整关键字 -

08.06 22:46:09

发表了文章

2024-08-06 22:46:09

发表了文章

2024-08-06 22:46:09

Ubuntu系统上定制文件系统

基于全志T507H处理器设计研发的OKT507-C开发板为例进行介绍。 Forlinx Desktop(Ubuntu)系统基于Ubuntu官方为嵌入式设备制作的操作系统-Lubuntu,该操作系统具备apt-get、ldd等常用的命令,若需要安装软件则直接apt-get在线安装即可,不需进行交叉编译移植等繁琐操作。但是每次重新烧写镜像之后,之前安装的软件就得重新安装,比较繁琐,如果需要批量操作则每块开发板都需要去apt-get安装,这样会大幅增加工作量,很不便于批量化生产。 能不能把软件一起打包到镜像呢?这样每次烧写完就不用再去apt-get在线安装了。答案当然是肯定的,这就涉及到文件系统 -

08.05 22:37:25

发表了文章

2024-08-05 22:37:25

发表了文章

2024-08-05 22:37:25

Linux环境下运行

1. 文件编程函数介绍 如果在Linux系统下学习C语言,就会了解到两套文件编程接口函数: C语言标准的文件编程函数: fopen、fread、fwrite、fclose Linux下提供的文件编程函数: open、read、write、close 传参的区别: 基于文件指针: fopen fclose fread fwrite 比较适合操作普通文件。 基于文件描述符: open close read write 比较适合操作设备文件。 2. C语言标准库提供的文件编程函数 下面介绍C语言标准库提供的文件编程函数,一般对文件常用的操作就是:创建(打开)、读、写、关闭。 其他的 -

08.04 15:41:13

发表了文章

2024-08-04 15:41:13

发表了文章

2024-08-04 15:41:13

C++的基类和派生类构造函数

基类的成员函数可以被继承,可以通过派生类的对象访问,但这仅仅指的是普通的成员函数,类的构造函数不能被继承。构造函数不能被继承是有道理的,因为即使继承了,它的名字和派生类的名字也不一样,不能成为派生类的构造函数,当然更不能成为普通的成员函数。 在设计派生类时,对继承过来的成员变量的初始化工作也要由派生类的构造函数完成,但是大部分基类都有 private 属性的成员变量,它们在派生类中无法访问,更不能使用派生类的构造函数来初始化。 这种矛盾在C++继承中是普遍存在的,解决这个问题的思路是:在派生类的构造函数中调用基类的构造函数。 下面的例子展示了如何在派生类的构造函数中调用基类的构造函数: -

08.03 21:01:01

发表了文章

2024-08-03 21:01:01

发表了文章

2024-08-03 21:01:01

eFuse电子保险丝

热保险丝作为一种基本的电路保护器件,已经成功使用了150多年。热保险丝有效可靠、易用,具有各种不同的数值和版本,能够满足不同的设计目标。然而,对于寻求以极快的速度切断电流的设计人员来说,热保险丝不可避免的缺点就是其自复位能力,以及在相对较低的电流下的工作能力。对于这些设计人员来说,电子保险丝(通常用eFuse或者e-Fuse表示)是一种很好的解决方案,有时还可以取代热保险丝,但通常是对热保险丝功能的补充。 eFuse基于一个简单概念,即通过测量已知电阻器上的电压来检测电流,然后在电流超过设计限值时,通过场效应晶体管(FET)切断电流。eFuse具有热保险丝无法实现特性、灵活性和功能。 本文 -

08.01 22:43:41

发表了文章

2024-08-01 22:43:41

发表了文章

2024-08-01 22:43:41

RA8D1-Vision Board上OSPI-Flash实践

Vision-Board 开发板是 RT-Thread 推出基于瑞萨 Cortex-M85 架构 RA8D1 芯片,拥有Helium和TrustZone技术的加持,性能非常强大。 内核:480 MHz Arm Cortex-M85,包含Helium和TrustZone技术 存储:集成2MB/1MB闪存和1MB SRAM(包括TCM,512KB ECC保护) 外设:兼容xSPI的四线OSPI(带XIP和即时解密/DOTF)、CAN-FD、以太网、USBFS/HS、16位摄像头接口和I3C等 高阶安全性:卓越的加密算法、TrustZone、不可变存储、带DPA/SPA攻击保护的防篡改功能、

2024年07月

-

07.31 22:49:29

发表了文章

2024-07-31 22:49:29

发表了文章

2024-07-31 22:49:29

大模型技术的发展与实践

一、大模型的概念 大型语言模型,也称大语言模型、大模型(Large Language Model,LLM;Large Language Models,LLMs) 。 大语言模型是一种深度学习模型,特别是属于自然语言处理(NLP)的领域,一般是指包含数干亿(或更多)参数的语言模型,这些参数是在大量文本数据上训练的,例如模型GPT-3,PaLM,LLaMA等,大语言模型的目的是理解和生成自然语言,通过学习大量的文本数据来预测下一个词或生成与给定文本相关的内容。 参数可以被理解为模型学习任务所需要记住的信息,参数的数量通常与模型的复杂性和学习能力直接相关,更多的参数意味着模型可能具有更强的学习 -

07.30 23:08:17

发表了文章

2024-07-30 23:08:17

发表了文章

2024-07-30 23:08:17

C++中的AI编程助手添加

今天为大家推荐一款适配了 Viusal Studio(本文使用),VS Code(本文使用),JetBrains系列以及Vim等多种编译器环境的插件 Fitten Code,Fitten Code 是由非十大模型驱动的 AI 编程助手,它可以自动生成代码,提升开发效率,帮您调试 Bug,节省您的时间,另外还可以对话聊天,解决您编程碰到的问题。 Fitten Code免费且支持 80 多种语言:Python、C++、Javascript、Typescript、Java等。 -

07.29 22:55:11

发表了文章

2024-07-29 22:55:11

发表了文章

2024-07-29 22:55:11

Apache IoTDB进行IoT相关开发实践

The article introduces IoTDB, an open-source time-series database designed for efficient management of IoT-generated data. It addresses challenges like real-time integration of massive datasets and security. IoTDB supports high-performance storage,

-

07.28 13:05:48

发表了文章

2024-07-28 13:05:48

发表了文章

2024-07-28 13:05:48

C语言文件编程-Linux环境下运行

本文介绍了在Linux环境下使用C语言进行文件编程时的两种主要接口:C标准库函数与Linux系统调用。C标准库提供了`fopen`, `fread`, `fwrite`, 和 `fclose`等函数,适用于普通文件操作;而Linux系统调用如`open`, `read`, `write`, 和 `close`则更适合处理设备文件,同时也可用于普通文件。这两种方法的主要区别在于前者使用文件指针,后者使用文件描述符。文章还给出了两个示例程序:一个使用C标准库函数实现文件复制,另一个则使用Linux系统调用完成相同任务。 -

07.25 22:53:21

发表了文章

2024-07-25 22:53:21

发表了文章

2024-07-25 22:53:21

俄罗斯方块游戏编程

设计了一款基于AT89C51单片机的俄罗斯方块游戏,使用LCD12864作为显示界面,并通过按键控制方块移动与变形。系统包括电源、单片机最小系统、显示模块和按键模块。实现了方块随机生成、匀速下落及玩家交互控制等功能。游戏支持得分与计时显示,当方块堆至顶端无法消除时游戏结束。通过Proteus仿真验证了系统的功能性和稳定性,满足设计需求。提供的C代码片段展示了方块碰撞检测与地图检查逻辑。 -

07.24 23:14:27

发表了文章

2024-07-24 23:14:27

发表了文章

2024-07-24 23:14:27

嵌入式工程师需要掌握哪些技术?

嵌入式系统是科技核心,涉及生活多领域。入行需掌握C/C++编程,理解硬件基础如电路与处理器架构,熟悉RTOS及操作系统原理,掌握通信协议如UART、I2C,擅长调试与领域知识,如汽车、医疗。综合软硬件、设计、算法、网络、安全及团队协作能力,方能胜任嵌入式开发。 -

07.23 22:21:57

发表了文章

2024-07-23 22:21:57

发表了文章

2024-07-23 22:21:57

嵌入式Linux的学习误区

**嵌入式Linux学习误区摘要** 1. **过度聚焦桌面Linux** - 许多学习者误将大量时间用于精通桌面Linux系统(如RedHat、Fedora、Ubuntu),认为这是嵌入式Linux开发的基石。 - 实际上,桌面Linux仅作为开发工具和环境,目标不应是成为Linux服务器专家,而应专注于嵌入式开发工具和流程。 2. **盲目阅读Linux内核源码** - 初学者在不了解Linux基本知识时试图直接研读内核源码,这往往导致困惑和挫败感。 - 在具备一定嵌入式Linux开发经验后再有针对性地阅读源码,才能有效提升技能。 -

07.21 22:25:11

发表了文章

2024-07-21 22:25:11

发表了文章

2024-07-21 22:25:11

QT设置widget背景图片

该内容介绍如何在Qt中为控件添加背景图片。主要方法包括:1) 在样式表中使用`border-image`属性指定控件及其背景图片;2) 使用调色板`QPalette`设置图片,但可能导致窗口显示不下;3) 在`paintEvent`中绘制图片,适合自定义绘图但不适用于子窗口;4) 通过覆盖一个大小与窗口相同的`QLabel`来设置背景图片,可实现动态背景。推荐使用样式表设置背景,简单高效且适合子窗口。 -

07.20 22:50:28

发表了文章

2024-07-20 22:50:28

发表了文章

2024-07-20 22:50:28

Linux设备树(DTS)介绍

**设备树(DTS)是Linux中用于描述硬件信息的文本文件,旨在减少内核与平台相关代码的耦合。DTS文件包含静态硬件配置,不支持动态变更。它被编译成DTB二进制文件,供内核在启动时解析以了解硬件布局。设备树解决了ARM体系结构代码维护的复杂性问题,通过解耦实现vendor修改的独立和共二进制目标。设备树overlay允许对配置进行增量修改,遵循特定规则,如dts覆盖dtsi,先引用后修改。调试时,可使用内置工具反编译dtb或dtbo映像为dts文本以检查内容。** -

07.19 22:51:54

发表了文章

2024-07-19 22:51:54

发表了文章

2024-07-19 22:51:54

Apache IoTDB进行IoT相关开发实践

IoTDB是专为物联网(IoT)设计的开源时间序列数据库,提供数据收集、存储、管理和分析。它支持高效的数据写入、查询,适用于处理大规模物联网数据,包括流数据、时间序列等。IoTDB采用轻量级架构,可与Hadoop和Spark集成,支持多种存储策略,确保数据安全和高可用性。此外,它还具有InfluxDB协议适配器,允许无缝迁移和兼容InfluxDB的API和查询语法,简化物联网项目的数据管理。随着物联网设备数量的快速增长,选择适合的数据库如IoTDB对于数据管理和分析至关重要。 -

07.18 22:11:59

发表了文章

2024-07-18 22:11:59

发表了文章

2024-07-18 22:11:59

DC-DC产品设计PCB注意事项

DC-DC电路Layout设计对性能影响大,不良布局可导致EMI干扰、地线噪声和电压降,影响效率。关键原则包括:缩短开关大电流回路,电感、输入电容靠近对应管脚,单点接地以隔离信号地和功率地。布局时,输入输出电容地应紧密连接,敏感信号远离SW管脚。遵循制造商规格书中的layout指南可确保更好的稳定性和效率。 -

07.17 23:24:22

发表了文章

2024-07-17 23:24:22

发表了文章

2024-07-17 23:24:22

C++中的语法知识虚继承和虚基类

**C++中的多继承可能导致命名冲突和数据冗余,尤其在菱形继承中。为解决这一问题,C++引入了虚继承(virtual inheritance),确保派生类只保留虚基类的一份实例,消除二义性。虚继承通过`virtual`关键字指定,允许明确访问特定路径上的成员,如`B::m_a`或`C::m_a`。这样,即使基类在继承链中多次出现,也只有一份成员副本,简化了内存布局并避免冲突。虚继承应在需要时提前在继承声明中指定,影响到从虚基类派生的所有后代类。** -

07.16 21:56:30

发表了文章

2024-07-16 21:56:30

发表了文章

2024-07-16 21:56:30

Linux环境变量及作用

Linux中的环境变量是系统配置参数,如HOME指示用户家目录,MAIL指邮件位置。`env`命令显示所有环境变量。系统有数百个变量,但了解关键的几个足够,如PATH、HOME、TERM等。环境变量由变量名和值组成,可自定义,如WORKDIR。局部变量需用`export`使其全局有效,以便其他用户使用。`su`命令用于切换用户,展示不同用户环境下变量值的差异。

-

07.14 21:13:19

发表了文章

2024-07-14 21:13:19

发表了文章

2024-07-14 21:13:19

Ubuntu系统下编译OpenCV4.8源码

在Ubuntu上源码安装OpenCV 4.8分为三步:1) 下载源码包,使用`wget`命令;2) 安装依赖,如`g++`, `cmake`, `make`等;3) 创建编译目录,运行`cmake`配置,接着`make`编译,最后`sudo make install`安装。安装完成后,通过编写和运行一个简单的OpenCV C++程序来验证环境配置正确性。 -

07.13 21:56:07

发表了文章

2024-07-13 21:56:07

发表了文章

2024-07-13 21:56:07

采用Visual Studio版本的AI编程助手

Visual Studio 是多平台IDE,用于构建Windows、Mac、Linux、iOS和Android应用。安装Fitten Code插件可增强其功能,如智能补全、AI问答、代码生成、翻译、注释自动生成、代码解释和测试用例创建。通过扩展商店搜索安装Fitten Code,登录后体验上述特性。支持VS Code、JetBrains IDE、Visual Studio和Vim。访问[https://code.fittentech.com/](https://code.fittentech.com/)获取更多信息。 -

07.12 23:21:39

发表了文章

2024-07-12 23:21:39

发表了文章

2024-07-12 23:21:39

cout.tellp()和cout.seekp()语法介绍

C++ 中的 `cout.tellp()` 用于获取输出流缓冲区的当前位置,而 `seekp()` 可以改变这个位置。数据先存入缓冲区,待缓冲区刷新后才输出。`tellp()` 返回一个表示位置的 `streampos`(通常可转换为整数),在无数据时为0,失败时为-1。`seekp()` 用于设置下一个字符的输出位置,接受一个位置参数或偏移量和方向,允许在缓冲区中移动并覆盖已有数据。例如,可以使用 `seekp()` 改变输出流中的部分数据,然后继续写入。 -

07.11 23:09:46

发表了文章

2024-07-11 23:09:46

发表了文章

2024-07-11 23:09:46

深拷贝和浅拷贝介绍

这篇文章讨论了C++中的数据拷贝,特别是浅拷贝和深拷贝的概念。对于基本类型和简单对象,拷贝是按位复制,即浅拷贝,类似于`memcpy()`函数的效果。当类包含动态分配的内存或其他资源时,需要显式定义拷贝构造函数以实现深拷贝,确保对象间的独立性。文中通过一个自定义的变长数组类`Array`示例说明了深拷贝的必要性,并展示了不使用深拷贝可能导致的问题。通常,如果类有指针成员,大部分情况需要深拷贝;否则,浅拷贝可能就足够了。文章还提到了在创建对象时需要预处理的情况,如记录对象创建时间或计数,这也需要深拷贝。 -

07.10 22:41:57

发表了文章

2024-07-10 22:41:57

发表了文章

2024-07-10 22:41:57

采用get()和put()读写文件

C++ 中的 `fstream` 类提供了 `put()` 和 `get()` 方法来处理文件的字符级输入输出。`put()` 用于向文件写入单个字符,如 `ofstream` 对象调用 `put(c)` 将字符 `c` 写入文件。而 `get()` 用于从文件读取单个字符,`ifstream` 对象的 `get()` 可将读取到的字符存储到变量中。文件操作涉及缓冲区,大量数据会先存储在缓冲区,然后一次性写入或读出,提高效率。

-

发表了文章

2024-12-02

发表了文章

2024-12-02

深入解析PID控制算法:从理论到实践的完整指南

-

发表了文章

2024-12-01

发表了文章

2024-12-01

负载开关IC:简化电源管理与提升系统稳定性的关键

-

发表了文章

2024-11-27

发表了文章

2024-11-27

ROS2:从初识到深入,探索机器人操作系统的进化之路

-

发表了文章

2024-11-26

发表了文章

2024-11-26

从基础到人脸识别与目标检测

-

发表了文章

2024-11-24

发表了文章

2024-11-24

基于波特图的控制系统设计算法

-

发表了文章

2024-11-18

发表了文章

2024-11-18

ROS机器视觉入门:从基础到人脸识别与目标检测

-

发表了文章

2024-11-17

发表了文章

2024-11-17

负载开关IC:简化电源管理与提升系统稳定性的关键

-

发表了文章

2024-11-15

发表了文章

2024-11-15

ROS进阶:使用URDF和Xacro构建差速轮式机器人模型

-

发表了文章

2024-11-13

发表了文章

2024-11-13

C++ 之 perf+火焰图分析与调试

-

发表了文章

2024-11-10

发表了文章

2024-11-10

ROS2:从初识到深入,探索机器人操作系统的进化之路

-

发表了文章

2024-11-08

发表了文章

2024-11-08

一款基于AB32VG1的桌面智能坞

-

发表了文章

2024-11-06

发表了文章

2024-11-06

codigger体验过程记录

-

发表了文章

2024-10-30

发表了文章

2024-10-30

配置C++的学习环境

-

发表了文章

2024-10-29

发表了文章

2024-10-29

Ubuntu系统编译OpenCV4.8源码

-

发表了文章

2024-10-28

发表了文章

2024-10-28

C++中的AI编程助手添加

-

发表了文章

2024-10-28

发表了文章

2024-10-28

通过文字图像——代码图形注释自动生成

-

发表了文章

2024-10-26

发表了文章

2024-10-26

多线程;顺序容器;智能指针

-

发表了文章

2024-10-25

发表了文章

2024-10-25

ROS 编程入门的介绍

-

发表了文章

2024-10-24

发表了文章

2024-10-24

PID算法原理分析

-

发表了文章

2024-10-23

发表了文章

2024-10-23

基于51单片机的6位密码锁设计

滑动查看更多

-

回答了问题

2024-07-07

回答了问题

2024-07-07

乘风问答官3月排位赛开启!AirPods 3代等你赢!

重在参与赞2 踩0 评论0 -

回答了问题

2024-07-07

回答了问题

2024-07-07

作为一个经典架构模式,事件驱动在云时代为什么会再次流行呢?

在全行业数字化转型的时代,事件驱动架构(EDA)的流行并非偶然,而是多重因素共同作用的结果。 应对不确定性和快速变化 随着技术的快速发展和市场环境的不断变化,企业面临着越来越多的不确定性和快速变化的业务需求。传统的架构模式往往难以高效地应对这些挑战,因为它们通常较为僵化,难以快速适应变化。而事件驱动架构以其松耦合、灵活性和可扩展性,能够更好地适应这种不确定性。通过事件的发布和订阅模式,不同组件可以独立地进行开发、部署和扩展,提高了系统的灵活性和可维护性。 云计算和大数据的推动 云计算和大数据技术的快速发展为事件驱动架构的流行提供了重要支撑。云计算提供了强大的弹性和可伸缩性,使得事件驱动架构能够轻松应对高峰和变化的工作负载。同时,大数据技术带来了海量数据和复杂的业务流程,传统的架构模式难以高效处理这些数据。而事件驱动架构通过实时的事件处理和响应,能够快速地捕捉和处理不断涌现的数据事件,支持实时洞察和决策。 与微服务架构和云原生应用的契合 事件驱动架构与微服务架构和云原生应用相互契合,共同推动了数字化转型的深入发展。微服务架构强调将应用拆分成多个独立的服务,每个服务都可以独立地进行开发、部署和扩展。而事件驱动架构通过事件作为微服务之间的通信媒介,进一步增强了系统的灵活性和可维护性。同时,云原生应用强调以容器、微服务、DevOps等技术为基础,构建弹性、可伸缩的应用系统。事件驱动架构与这些技术的结合,使得企业能够构建更加灵活、可扩展的系统,快速响应市场变化。 提高开发效率和降低成本 事件驱动架构通过松耦合的通信方式,降低了组件之间的依赖关系,使得开发人员可以更加专注于单个组件的开发和优化。这种并行开发的方式大大提高了开发效率,缩短了产品上市时间。同时,由于事件驱动架构支持资源的弹性伸缩,企业可以根据实际需求动态调整资源分配,降低了运营成本。 实时数据处理和即时业务响应 在实时数据处理和分析场景中,事件驱动架构具有显著的优势。它能够快速地捕捉和处理不断涌现的数据事件,支持实时洞察和决策。这对于需要快速响应市场变化和客户需求的企业来说至关重要。通过事件驱动架构,企业可以实时地监控业务状况,及时调整策略,提高市场竞争力。 综上所述,事件驱动架构在云时代背景下再次流行并成为焦点的原因是多方面的。它不仅能够应对不确定性和快速变化的业务需求,还与云计算、大数据、微服务架构和云原生应用等技术相互契合,共同推动了数字化转型的深入发展。随着技术的不断进步和市场环境的不断变化,事件驱动架构的应用前景将更加广阔。赞0 踩0 评论0 -

回答了问题

2024-01-22

回答了问题

2024-01-22

你完整阅读过源码吗?

对于“读源码太枯燥,没啥意思”的观点,可以从多个角度理解和回应: 学习阶段与兴趣点:对于初学者或者对编程、软件架构尚不深入理解的开发者来说,直接阅读复杂的源代码确实可能感觉枯燥且难以吸收。他们可能更需要从基础概念、API文档和教学示例入手,逐步建立系统的知识体系。然而,随着技术能力和经验的增长,理解并研究高质量的源码能够帮助开发者提升设计思维和解决问题的能力,从而可能会发现其中的乐趣。 学习方法论:阅读源码并非一蹴而就的过程,也不是单纯地逐行扫描代码。有效的源码阅读应当结合问题导向、模块化分析以及适当的调试实践。通过了解项目背景、明确目标、拆分功能模块,甚至参与到社区讨论中,都可以让这个过程变得更有意义和吸引力。 价值体现:源码是众多优秀工程师智慧的结晶,尤其是开源项目中的顶级源码,它们代表了业界的最佳实践和创新思路。通过阅读源码,我们可以学习到如何优化性能、处理复杂逻辑,以及良好的编码规范和设计模式等,这对于个人成长和技术进步具有极大的价值。 挑战与乐趣:如同解谜一样,阅读源码有时就像解开一个精心设计的技术难题,克服挑战后所获得的成就感也是无法忽视的。此外,随着对源码理解的加深,逐渐掌握其运行机制,能更好地驾驭这项技术,这本身也是一种乐趣所在。 总之,“读源码枯燥”这一看法因人而异,取决于个体的学习阶段、方法及对技术探索的态度。在实践中找到适合自己的学习方式,将源码阅读融入日常开发和学习过程中,往往能收获更多有价值的经验和技能提升。赞2 踩0 评论0 -

回答了问题

2024-01-22

回答了问题

2024-01-22

预见2024,你对技术革新有哪些猜想?

边缘计算的普及:随着物联网设备的快速增长和边缘计算技术的成熟,边缘计算将在2024年得到更广泛的应用。边缘计算可以将数据处理和分析推向离终端设备更近的地方,减少数据传输延迟和带宽占用,提高响应速度和用户体验。 量子计算的商业化:量子计算作为一项前沿技术,具有在某些特定场景下超越传统计算能力的潜力。预计到2024年,量子计算将进一步商业化,云服务提供商可能会开始提供量子计算能力,以支持解决复杂问题和优化算法。 安全性和隐私保护的增强:随着云计算的普及,对于数据安全性和隐私保护的需求也越来越高。未来,云计算服务提供商将加强数据加密、访问控制和身份认证等安全机制,以确保用户数据的安全和隐私。 融合AI和云计算:人工智能(AI)在各个行业的应用越来越广泛,而云计算作为支持大规模数据处理和模型训练的基础设施,将与AI融合得更加紧密。未来,云服务提供商可能会提供更强大的AI平台和工具,使开发者能够更轻松地构建和部署AI应用。 可持续性和能源效率的关注:云计算数据中心的能源消耗一直是一个重要的问题。随着对可持续性的关注不断增加,云计算服务提供商将更加注重节能和环保,采用更高效的硬件设备和数据中心设计,以减少能源消耗和碳排放。赞2 踩0 评论0 -

回答了问题

2023-07-14

回答了问题

2023-07-14

乘风问答官5月排位赛开启!话题、问题双赛道,Apple 妙控键盘等你赢!

积极参与赞0 踩0 评论0 -

回答了问题

2023-05-15

回答了问题

2023-05-15

百问求答(4)Flink专场!回答问题赢小爱智能音箱等好礼

积极参与赞1 踩0 评论0 -

回答了问题

2023-03-19

回答了问题

2023-03-19

你使用过哪些云产品组合进行开发?

作为开发者,我们都知道云计算已经成为了当今软件开发行业的主要趋势。而阿里云作为国内领先的云计算服务提供商,不仅提供了各种云产品服务,还为开发者提供了方便易用的开发工具和平台,使得开发者可以更加轻松地进行开发和部署。 在阿里云的云产品组合中,常见的组合方式包括ECS + RDS、ECS + SLB、OSS + CDN和Function Compute + API Gateway等,不同的组合方式可以满足不同的业务需求和应用场景。 例如,我们在开发一个电商网站时,通常需要使用ECS来部署网站应用程序,使用RDS来存储用户数据和订单信息,使用SLB来实现负载均衡和高可用性。此时,我们可以使用阿里云的ECS、RDS和SLB服务来快速搭建一个高可用性的电商网站,从而为用户提供更好的体验。 云原生时代的到来,使开发者自己完成应用从开发到部署成为了可能。CloudBase 提供的各种基础设施,令开发者无需再纠结于各种服务器配置之中,这极大地解放了生产力,让你的想法可以快速实现和快速上线。开发者快来拥抱 Serverless 吧! uniapp云开发(云数据库) 赞0 踩0 评论0 -

回答了问题

2023-03-19

回答了问题

2023-03-19

ModelScope社区上线,怎么看待它在AIGC发展中起到的作用?

随着人工智能技术的不断发展,越来越多的企业和个人开始涉足这个领域,但由于人工智能技术的门槛较高,很多人在开始学习时都会感到困难重重。而Modelscope的上线则为这个问题提供了一个可行的解决方案,我记得Modelscope它能够让企业和个人开发者更方便地体验各种人工智能模型,然后就可以加速人工智能技术的普及和发展。AI模型的体量已经跃升至万亿的规模,但大模型的弊端日益凸显:大算力、强算法、大模型。这些都让一些普通开发者望而却步。通过开源,让技术壁垒和计算资源不再是阻碍,降低AI的应用门槛。达摩院的ModelScope正是在这样的共识下应运而生,一经推出就引起AI界极大的关注。赞1 踩0 评论0 -

回答了问题

2023-03-19

回答了问题

2023-03-19

乘风问答官2月排位赛开启!话题、问题双赛道,Beats蓝牙耳机等你赢!

积极学习,重在参与,技术迭代。赞0 踩0 评论0 -

回答了问题

2023-03-19

回答了问题

2023-03-19

开发者参与开源软件项目有哪些好处?

对于目前开源项目的一些思考: 1.随着国家对于技术的越来越重视,越来越多的开源平台和开源项目开始出现,例如目前也有很多的托管平台让技术开发者使用。比如说国际上最大的托管平台GitHub,国内知名的托管平台码云等等。 2.很多的开源项目也随之产生,方便了更多的开发者,我们可以使用更多的开源项目,参考别人优秀的想法,提高自己对于项目的认知水平。赞8 踩0 评论0 -

回答了问题

2022-12-27

回答了问题

2022-12-27

2022年你和社区发生了哪些故事?

我与阿里云社区之间的故事,从今年开始入驻社区之后,便参加了很多的活动,也获得了很多的奖励。一开始接触到阿里云的时候,是朋友的推荐,后面自己开始进一步接触,感觉社区挺不错的,输出了很多优质的文章,对自己的技术提升也有很大的帮助。后面自己也有幸写了自己的第一篇博客,很幸运的签约成为了阿里云社区的一员,由此开始了我的写作之路。从一开始的签约博主,到后来的星级博主,再到后来的专家博主,自己获得荣誉的同时,也创作了很多的文章,为社区的建设贡献了自己的力量。对于即将结束的2022年,我有很多的感悟,与社区之间也产生了很多的感情,希望在2023年阿里云社区能够越来越好,我也可以持续输出更多的优质文章,既能够提升自己的能力,又可以为社区的建设尽自己的力量。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

OpenSearch如何添加自建MySQL数据源

在网站上添加了 OpenSearch 功能以后,IE 7.0 和 Firefox 2.0 以上的浏览器(好吧,我承认在 Opera 和 Chrome 里没找到这个功能,但是 IE 8.0 RC 和 Firefox 3.05 是绝对没有问题的)就能够在自带的搜索栏里面添加这个网站的搜索功能了。 要添加 OpenSearch 功能,一共分三步: 第一步:实现 OpenSearch 功能; 第二步:编写 OpenSearch 描述文件; 第三步:添加对 OpenSearch 描述文件的引用。 ———————————————— 版权声明:本文为CSDN博主「happytdw」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。 原文链接:https://blog.csdn.net/weixin_30045597/article/details/113320448赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

DataV到期被释放如何恢复

释放SWAP 监控报警一个PVE节点的SWAP使用满了。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

kibana如何开启公网访问

配置Kibana私网访问白名单时,需要先打开Kibana私网访问开关(默认关闭)再进行操作。 Kibana公网访问默认开启(绿色),关闭Kibana公网访问功能,公网入口隐藏,您将无法通过公网进入Kiban...赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

Elasticsearch新购实例长时间生效中怎么办

一般情况下,通过操作系统write接口写到磁盘的数据先到达 Elastic:在 Elasticsearch 中计算摄取延迟并存储摄取时间以提高可观察性 Elastic 中国社区官方博客赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

DataWorks写到外表单个文件超过5G如何处理

减小JAR文件。DataWorks执行MapReduce作业的时候,需要在本地执行,所以保留Main函数即可。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

Quick Bi 如何连接PolarDB MySQL

通过公网连接阿里云PolarDB for MySQL 添加白名单。 公网连接阿里云PolarDB for MySQL之前,需要将Quick BI的IP地址加入到阿里云PolarDB for MySQL的白名单。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

DataWorks如何计费

每小时出账:每个小时统计前一个小时的实际使用量,并从账户余额中扣除实际消费的金额。 例如,当前时间是9:30,结算的是8:00~9:00期间产生的费用。 每日出账:每个自然日开始时,统计前一个自然日的实际使用量,并从账户余额中扣除实际消费的金额。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

E-MapReduce如何创建集群

登录阿里云 E-MapReduce 控制台。 在上方选择所在的地域(Region),所创建集群将会在对应的地域内,一旦创建后不能修改。 单击创建集群,进行创建。赞0 踩0 评论0 -

回答了问题

2022-11-25

回答了问题

2022-11-25

Quick BI是否支持本地部署

支持赞0 踩0 评论0

滑动查看更多

暂无更多信息