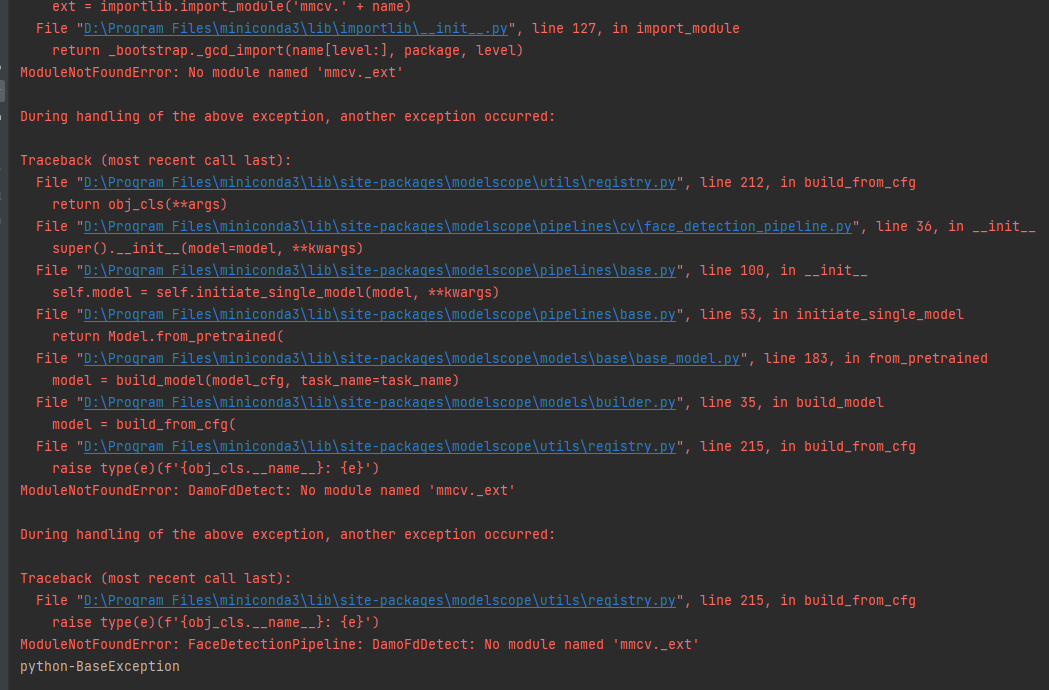

https://modelscope.cn/models/iic/cv_ddsar_face-detection_iclr23-damofd-34G/summary 源码在windows下报错:

ModelScope中的问题怎么解决?

在Windows环境下运行ModelScope中的模型时,可能会遇到与操作系统兼容性相关的问题。以下是针对您提到的iic/cv_ddsar_face-detection_iclr23-damofd-34G模型源码报错的解决方案,结合知识库资料提供详细指导:

ModelScope中的模型通常基于Linux环境开发和测试,因此在Windows下运行时需要确保以下依赖项已正确配置: - Python版本:确认安装了模型所需的Python版本(通常为3.7或更高)。 - 依赖库:使用requirements.txt或setup.py文件安装所有依赖库。如果某些库不支持Windows,可能需要寻找替代方案或使用兼容的库版本。 - Git LFS:部分模型文件较大,需通过Git LFS下载。如果未安装Git LFS,请先安装并初始化:

git lfs install

重要提示:如果模型依赖CUDA或GPU加速,Windows下的CUDA工具链可能与Linux存在差异,建议优先使用Linux环境或WSL2(Windows Subsystem for Linux 2)。

为了避免Windows环境的兼容性问题,推荐使用Docker容器运行模型。以下是具体步骤:

docker pull egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04

docker run -d -t --network=host --gpus all \

-v ${LOCAL_SAVE_PATH}:/data \

egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04 \

/bin/bash -c "git-lfs clone https://www.modelscope.cn/models/iic/cv_ddsar_face-detection_iclr23-damofd-34G.git /data"

docker logs -f <container_id>

docker run -d -t --network=host --gpus all \

-v ${LOCAL_SAVE_PATH}:/data \

egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04 \

/bin/bash -c "vllm serve"

如果必须在Windows下直接运行模型代码,请检查以下内容: - 路径分隔符:Windows使用反斜杠\,而Linux使用正斜杠/。确保代码中路径处理逻辑兼容Windows。 - 文件权限:Windows文件系统可能不支持Linux风格的权限设置(如chmod)。修改代码以跳过不必要的权限操作。 - 多线程/进程:某些模型可能依赖Linux特有的多线程或多进程库。尝试替换为跨平台库(如concurrent.futures)。

如果仍然报错,请按照以下步骤排查问题: 1. 查看错误日志:记录完整的错误信息,定位问题来源。 2. 检查依赖冲突:使用pip check命令检查依赖库是否存在版本冲突。 3. 联系社区支持:访问ModelScope官网,提交问题至模型页面的“Issues”区域,或参考官方文档获取帮助。

为了最大程度减少兼容性问题,建议采用以下方法之一: - 切换到Linux环境:使用Ubuntu或其他Linux发行版运行模型。 - 使用WSL2:在Windows上安装WSL2,并在其中运行Linux环境。 - 使用云服务:通过阿里云GPU实例部署模型,避免本地环境配置的复杂性。

通过上述方法,您可以有效解决Windows下运行ModelScope模型时的报错问题。如果仍有疑问,请提供更多具体的错误信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352