ModelScope清除缓存后,重新 训练,重命名、移动目录,再推理还是报错 ?

在使用ModelScope时,如果清除缓存后重新训练、重命名或移动目录,仍然出现推理报错的情况,可能是由于以下几个原因导致的。以下是详细的分析和解决方法:

即使您手动清除了缓存,某些模型文件可能仍残留在本地环境中,导致路径冲突或加载错误。

~/.cache/modelscope,您可以执行以下命令清理缓存:

rm -rf ~/.cache/modelscope

from modelscope.hub.snapshot_download import snapshot_download

snapshot_download('LLM-Research/Meta-Llama-3-8B-Instruct', cache_dir='.', revision='master')

在重命名或移动目录后,模型加载路径可能未正确更新,导致推理时无法找到模型文件。

/mnt/new_path/,需要在推理代码中更新路径:

model_path = '/mnt/new_path/Meta-Llama-3-8B'

在重新训练或推理时,Python环境或依赖库版本可能发生变化,导致兼容性问题。

modelscope和transformers:

pip install modelscope==1.12.0 transformers==4.37.0

python3 -m venv myenv

source myenv/bin/activate

pip install -r requirements.txt

在移动或重命名目录时,模型文件可能被意外修改或损坏,导致推理失败。

md5sum或sha256sum检查文件哈希值是否与官方提供的一致。如果使用了推理服务(如ACK或函数计算),可能存在服务配置未同步更新的问题。

MODEL_ID或模型路径已更新为新的位置。例如,在ACK中部署推理服务时,需修改启动参数:

arena serve custom \

-name=modelscope \

-version=v1 \

-gpus=1 \

-replicas=1 \

-restful-port=8000 \

-image=kube-ai-registry.cn-shanghai.cr.aliyuncs.com/kube-ai/quick-deploy-llm:v1 \

"MODEL_ID=/mnt/new_path/Meta-Llama-3-8B python3 server.py"

arena serve del modelscope

arena serve custom ...

如果上述方法仍未解决问题,建议通过日志排查具体错误原因。

kubectl logs <pod_name>

根据知识库资料,上述问题通常由缓存未清理、路径配置错误、环境依赖不一致或模型文件损坏引起。建议按照以下步骤逐一排查: 1. 清理缓存并重新下载模型。 2. 确保路径配置正确且使用绝对路径。 3. 固定依赖版本并使用虚拟环境。 4. 验证模型文件完整性。 5. 更新推理服务配置并重启服务。 6. 查看日志以定位具体错误。

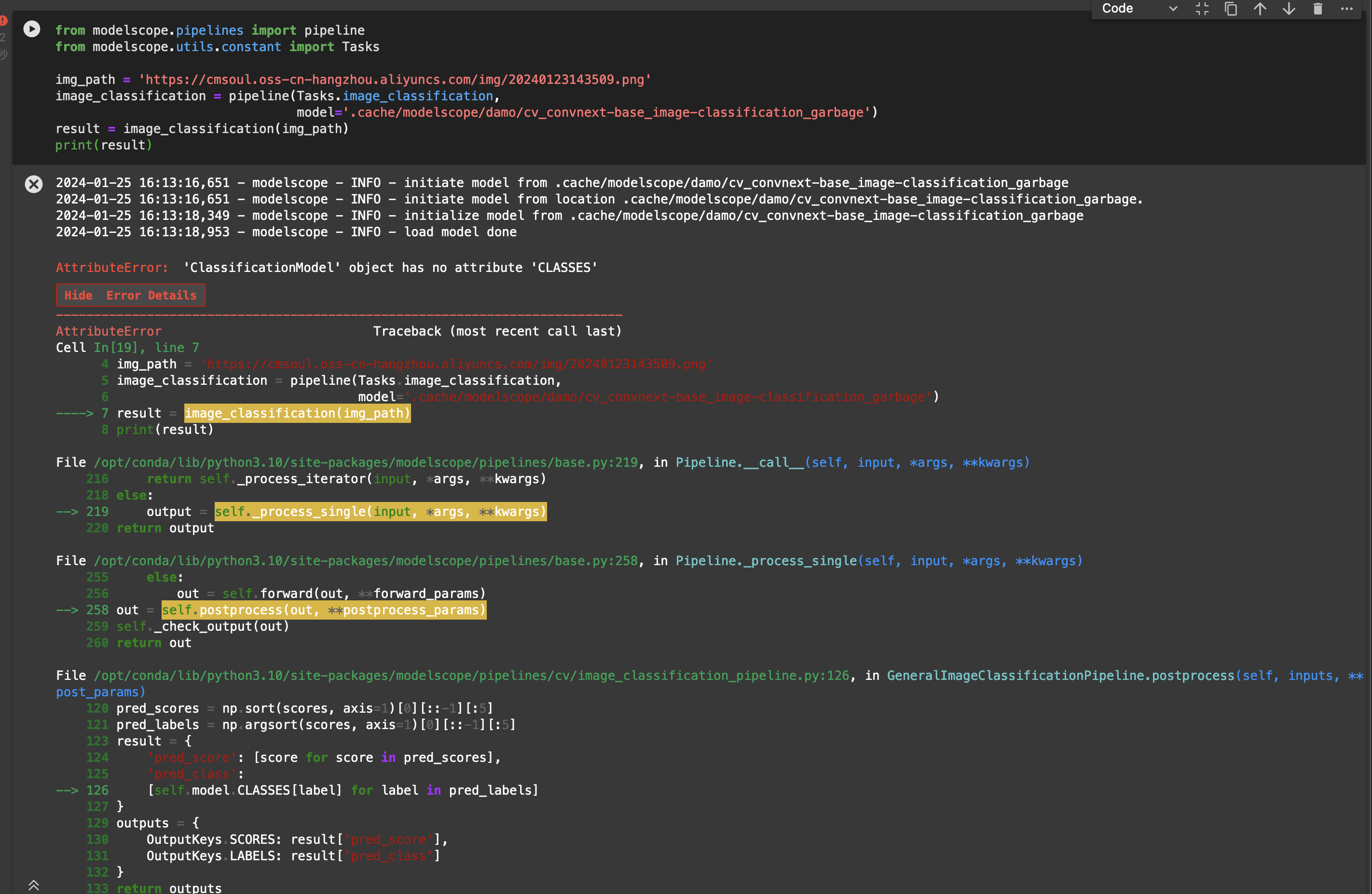

如果问题仍未解决,请提供更多错误日志信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352