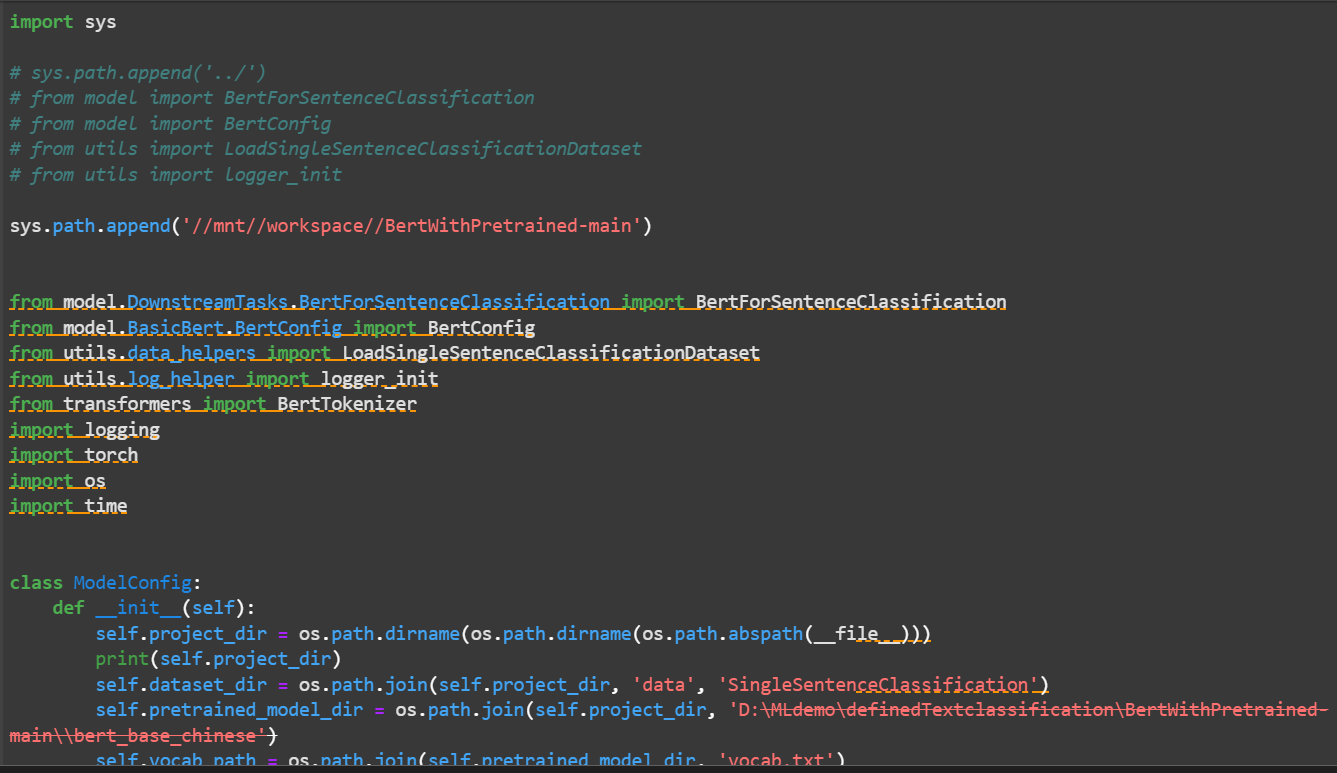

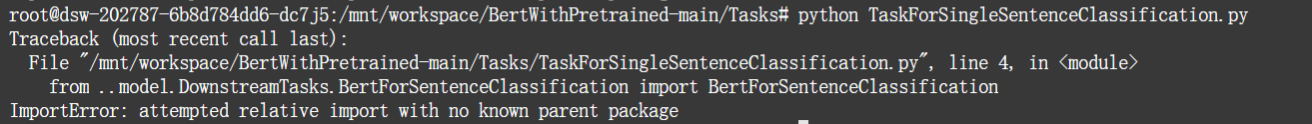

解压之后遇到了点问题,在本地电脑 ModelScope可以运行在平台上无法运行?

在本地电脑上解压并运行 ModelScope 模型时正常,但在平台上无法运行的问题,可能与文件权限丢失或环境差异有关。以下是详细的分析和解决方案:

根据知识库中的相关资料,以下可能是导致该问题的原因: - 文件权限丢失:在本地开发环境中(如 Windows 或 macOS),使用某些压缩工具打包文件时,可能会丢失文件或文件夹的属性(例如可执行权限)。当这些文件被上传到平台(如函数计算或容器服务)并在 Linux 环境中解压后,文件可能不再具备可执行权限,从而导致 permission denied 错误。 - 环境差异:本地开发环境与平台运行环境可能存在差异,例如依赖库版本不一致、缺少必要的运行时环境等。

在平台上赋予权限

如果文件已经上传到平台,可以通过以下命令为文件添加执行权限:

chmod +x 文件名

kubectl exec 进入容器内部执行该命令。确保压缩工具保留权限

在本地开发时,建议使用支持保留文件权限的压缩工具(如 tar 或 zip 命令行工具),并确保文件具有 755 权限。例如:

tar -czvf model.tar.gz --owner=0 --group=0 model/

为了避免因操作系统差异导致的权限问题,建议直接在 Linux 环境下进行开发和打包操作。这样可以确保文件权限在打包过程中得到正确保留。

如果文件权限无误,但模型仍然无法运行,可能是由于运行环境缺少必要的依赖。请按照以下步骤排查: 1. 检查依赖库

确保平台上的运行环境已安装所有必要的依赖库。例如,ModelScope 模型可能需要特定版本的 Python、CUDA 或其他运行时环境。

验证 GPU 配置

如果模型需要 GPU 支持,请确认平台上的 GPU 资源已正确配置。例如,在 PAI 平台上部署大语言模型时,建议选择合适的 GPU 实例规格(如 ml.gu7i.c16m60.1-gu30)。

测试运行环境

在平台上手动运行模型推理命令,验证是否能够正常启动。例如:

curl -XPOST http://localhost:8000/generate -H "Content-Type: application/json" -d '{"text_input": "什么是人工智能?", "parameters": {"stream": false}}'

如果返回预期结果,则说明环境配置正确;否则需要进一步排查依赖问题。

通过以上方法,您可以有效解决 ModelScope 模型在本地运行正常但在平台上无法运行的问题。如果仍有疑问,请提供更多上下文信息(如具体错误日志或平台环境),以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352