flink任务一直报错,怎么解决?

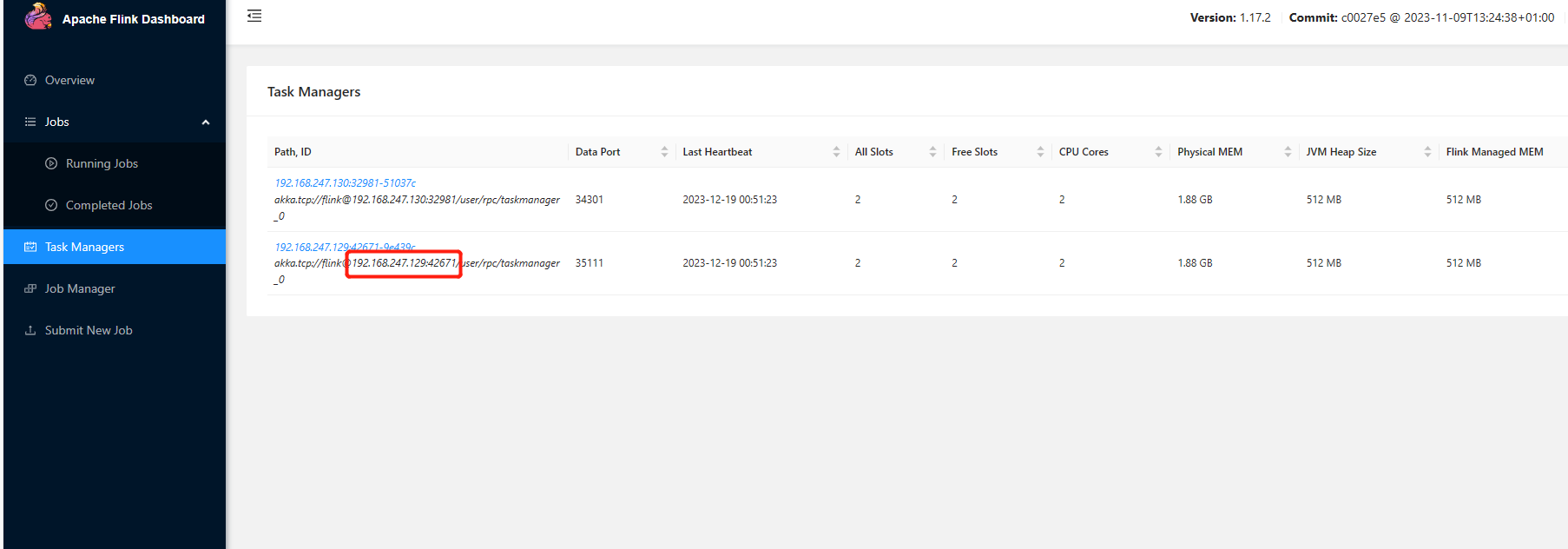

我尝试定位了一下问题,我把taskmanager.host改为localhost后,这里就可以正常运行了,但是这里会显示localhost点灯,我不确定是不是akka通信出了问题,ip地址应该没有问题,因为slot、cpu等显示都是正常的。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当您将 Flink 的 taskmanager.host 配置为 localhost 后,任务能够运行,但存在 Akka 通信相关的问题,这表明虽然本地任务管理器可以启动并监听请求,但是可能存在与其他 TaskManager 或 JobManager 的网络通信问题。这样的问题首先需要分析 Flink 的日志文件,查看日志输出以获取详细错误信息,查看更详细的错误信息,这些信息通常能提供关于 Akka 连接拒绝的具体原因然后检查配置文件,确认网络连接状况,检测防火墙和安全策略设置。

如果你在将taskmanager.host改为localhost后能够正常运行,但是出现了localhost点灯的问题,可能是由于Akka通信出现了问题导致的。

在Flink中,Akka是用于任务管理器之间进行通信的框架。当你将taskmanager.host配置为localhost时,Flink会尝试使用本地主机进行通信。如果在Akka通信过程中出现了问题,你可以检查一下是不是端口冲突了?如果端口没问题在检查下防火墙配置,有时防火墙或网络配置可能会干扰Akka通信,最后检查下主机的域名解析

。

相关解决如下:

依赖问题:检查 Flink 任务的依赖是否正确,包括库、jar包等。如果依赖有问题,可能会导致 Flink 任务无法启动或运行时出错。

网络问题:检查 Flink 节点之间的网络连接是否正常,以及 Flink 与外部系统的网络连接是否正常。如果网络有问题,可能会导致 Flink 任务无法正确地读写数据。

版本兼容性问题:检查使用的 Flink 版本是否与其他组件或依赖库兼容。如果不兼容,可能会导致 Flink 任务报错。

日志问题:检查 Flink 任务的日志信息,查看是否有异常堆栈信息或错误提示,并根据日志信息定位问题。

查看日志信息:首先,检查Flink任务的日志信息,以获取错误的具体信息和堆栈跟踪。这有助于确定问题发生的原因。

确认资源分配:确保为Flink任务分配了足够的资源,包括内存、CPU等。资源不足可能导致任务失败。

检查依赖项:确保Flink任务所依赖的所有外部系统或服务都可用且可访问。

版本兼容性:确认Flink版本与所使用的库和依赖项版本兼容。

配置参数:检查Flink任务的配置参数,确保所有必需的参数都已正确设置。

重启策略:如果问题是由于某个特定配置或外部因素导致的,您可以尝试重新启动Flink任务,以清除可能存在的问题。

增加异常处理:在代码中增加异常处理逻辑,以捕获和处理潜在的异常和错误,从而避免任务中断。

寻求社区支持:如果问题仍然无法解决,可以向Flink社区寻求帮助,或在相关的技术论坛上寻求专业人士的建议。

Flink 任务一直报错可能有多种原因,以下是一些常见问题和解决方案:

配置问题:检查 Flink 任务的配置是否正确,包括任务名称、并行度、输入输出路径等。确保所有配置项都符合要求,并且没有遗漏或错误的配置项。

数据问题:检查输入数据是否符合 Flink 的要求,包括数据的格式、类型、大小等。如果输入数据有问题,可能会导致 Flink 任务报错。

资源问题:检查 Flink 集群的资源是否足够,包括内存、CPU、磁盘等。如果资源不足,可能会导致 Flink 任务崩溃或报错。

依赖问题:检查 Flink 任务的依赖是否正确,包括库、jar包等。如果依赖有问题,可能会导致 Flink 任务无法启动或运行时出错。

网络问题:检查 Flink 节点之间的网络连接是否正常,以及 Flink 与外部系统的网络连接是否正常。如果网络有问题,可能会导致 Flink 任务无法正确地读写数据。

版本兼容性问题:检查使用的 Flink 版本是否与其他组件或依赖库兼容。如果不兼容,可能会导致 Flink 任务报错。

日志问题:检查 Flink 任务的日志信息,查看是否有异常堆栈信息或错误提示,并根据日志信息定位问题。

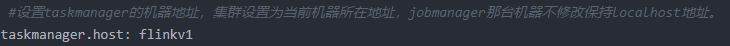

楼主你好,看了你的问题,需要你设置taskmanager的机器地址,而且集群设置为当前机器所在地址,jobmanager那台机器不修改保持localhost地址,具体如下所示:

这个没有报错原因,暂时不能直接下定论,主要还是用异常日志自动分析功能查看一下,登录实时计算控制台。在Flink全托管页签,单击目标工作空间操作列下的控制台。单击左侧导航栏的作业运维,单击目标作业名称。单击作业探查页签。

检查错误日志以获取更多关于错误的信息。这可以帮助你了解出错的原因和出错的位置,从而更精确地定位问题。

确保Flink作业的并行度设置正确,错误的并行度可能导致任务无法正常运行。

对Flink程序的配置文件进行检查,确保所有配置项都设置正确。特别要注意的是,如果遇到checkpoint失败的情况,需要检查checkpoint的配置是否正确。

查看Flink作业的重启策略。当Task发生故障时,Flink会尝试重启出错的Task以及其他受影响的Task,使作业恢复到正常执行状态。你可以根据实际需求通过修改flink-conf.yaml文件来调整重启策略。

如果使用了CDC源,请确保CDC Offset配置正确,否则可能会导致重复读取数据。

检查数据源和数据目标的配置是否正确,并且可以正常访问和读写数据。

Flink任务在集群模式下报错,而将TaskManager的地址设置为localhost后可以正常运行,这可能意味着在使用非localhost地址时存在网络配置或服务发现的问题。当TaskManager通过其主机名或IP地址无法被其他组件(如ResourceManager或JobManager)正确识别和连接时,可能会导致任务执行失败。

针对你的描述,有以下几点排查建议:

网络配置检查:

确保所有节点间网络是联通的,防火墙规则没有阻止必要的端口通信。

如果TaskManager是在分布式环境中部署,请验证配置文件中指定的hostname是否可从集群内的其他节点上正确解析,并且能ping通。

Akka通信:

Flink内部依赖于Akka进行远程过程调用(RPC)。需要确认Akka的配置参数,特别是与网络相关的参数,例如akka.remote.netty.tcp.hostname和akka.remote.netty.tcp.port,确保它们指向正确的网络接口和开放的端口。

检查是否有类似于之前提到的TooLongFrameException那样的异常,如果有,可能是消息大小超过默认限制,需要调整相关配置。

服务发现机制:

日志分析:

环境一致性:

资源管理器连接问题:

如果确实怀疑是Akka通信问题,可以进一步查看Flink的Akka配置部分,以及Akka的日志级别设定,以便抓取更多的调试信息来定位问题所在。

出现 Flink 任务报错的情况,可以按照以下步骤进行排查和解决:

检查异常栈信息:仔细阅读报错信息,找出异常的根源。根据异常的栈跟踪信息,定位到代码中出问题的具体位置。这样可以快速定位和解决问题。

检查网络连接:确保Flink与外部系统的网络连接正常。如果Flink无法连接到外部系统,例如Kafka、HDFS等,可能会导致任务报错。检查网络连接是否稳定,防火墙和安全组设置是否允许Flink访问外部系统。

检查资源限制:如果Flink任务的资源不足,例如内存、CPU等,可能会导致任务报错。检查Flink任务的资源配置是否合理,根据实际情况调整资源分配。

更新Flink版本:如果你使用的是较旧的Flink版本,可能会存在已知的bug或者不兼容问题。尝试更新Flink到最新版本,看看问题是否得到解决。

查看日志文件:Flink的日志文件通常会记录详细的错误信息和异常栈跟踪。通过查看日志文件,可以找到更多关于报错的线索。

寻求社区帮助:如果以上方法都无法解决问题,你可以在Flink的社区论坛上发帖求助。描述清楚问题的情况和报错信息,提供相关代码和配置文件,以便社区成员更好地帮助你解决问题。

通过以上方法,你可以尝试解决Flink任务报错的问题。在解决问题的过程中,请保持耐心和仔细,逐步排查问题原因。

Flink集群无法正确地解析主机名,或者无法正确地与TaskManager通信。

解决这个问题的方法有几个:

检查网络配置:确保你的Flink集群中的所有节点都可以互相通信。你可以尝试ping一下其他节点,看看是否可以正常通信。

检查主机名解析:确保Flink集群中的所有节点都可以正确解析主机名。你可以尝试在每个节点上ping一下其他节点的主机名,看看是否可以正常解析。

检查Akka配置:Akka是Flink用于内部通信的框架。你可以检查Flink的配置文件,看看是否有任何与Akka相关的配置错误。

查看日志:查看Flink的日志文件,可能会有更详细的错误信息,帮助你定位问题。

更新Flink版本:如果你使用的是较旧的Flink版本,可能会有一些已知的问题。尝试更新到最新的稳定版本,看看问题是否得到解决。

Apache Flink 是一个开源的大规模流批一体式计算引擎,用于实时与离线分析场景。当您看到 Task Manager 显示为 localhost 或者无法访问某个特定 IP 地址的问题时,可能是由于以下原因:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。