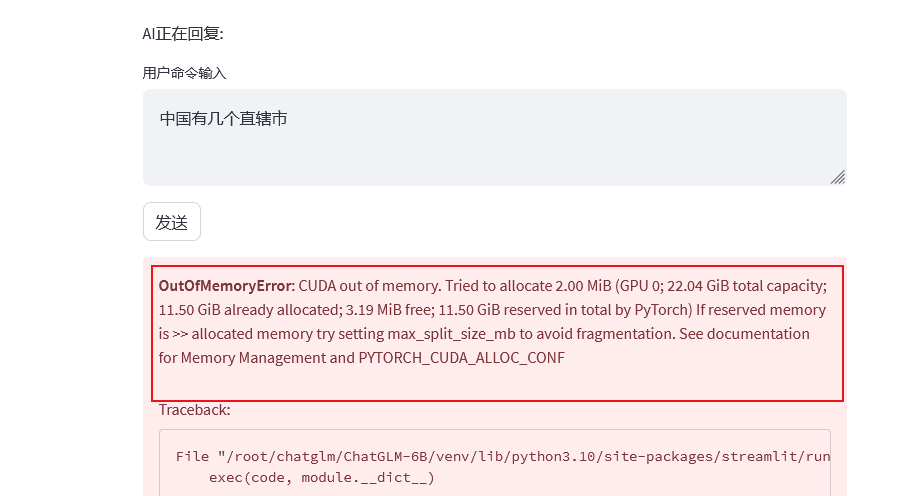

ChatGLM 报 CUDA 内存 溢出 怎么处理?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可以尝试以下几种处理方法:

减少批量大小:减少一次传输给模型的数据量,这样可以减少模型所需的内存。

减小模型的大小:可以选择更小的模型,或者通过减小模型的隐藏层数、神经元数等参数来减小模型的大小。

降低数据精度:可以将数据转换为低精度的格式,例如fp16或int8格式,这样可以减少内存占用。

增加显存:可以通过增加显存的方式来避免CUDA内存溢出的问题。可以使用更高容量的显卡,或者通过多卡并行的方式来增加显存。

减少模型并行度:可以将模型的并行度设置为1,这样可以减少模型所需的内存。

减少其他程序的内存占用:可以通过关闭其他程序或者减少其他程序的内存占用来释放更多的内存供模型使用。

看着应该是有别的进程占用了,显存不够了,把别的进程kill一下。chatglm 6B的权重是6B,显存占用的话6B*sizeof(half) = 12B,就是12GB显存了,还不包含中间变量。节省显存很困难了—此回答来自钉群“AIGC方案-阿里云支持群”

当在神龙AI的ChatGLM模型中遇到CUDA内存溢出错误时,可以尝试以下几种方法来处理:

减少批量大小(Batch Size):通过减小每个批次的样本数量来降低内存使用量。减少批量大小可能会导致一次推理处理的时间增加,但可以减少内存需求。

缩小输入文本长度:如果输入文本过长,可以尝试截断或缩小文本长度。这样可以减少模型处理的数据量,从而降低内存占用。

使用更小的模型:如果您的显存容量有限,可以考虑使用更小的模型进行推理。对于ChatGLM,可以选择较小的模型规模或者使用基于蒸馏(Distillation)的方法来训练一个精简版本的模型。

降低精度:将浮点数精度从32位(float32)降低为16位(float16)可以减少内存使用。请注意,在降低精度时需要权衡模型性能和推理结果的准确性。

使用多卡并行:如果您有多个GPU卡可用,并且框架支持多卡并行计算,可以尝试将模型参数分布在多个设备上进行并行计算,以减少单张卡上的内存压力。

更新显卡驱动和框架版本:确保您使用的CUDA版本、显卡驱动和框架版本是兼容并且最新的。有时,更新显卡驱动或框架版本可能会解决一些已知的内存管理问题。