gpt3是语言模型,这里数据加载分为src和tgt,请问内部是怎么合并到一起的?没有找到这块的代码?

OpenAI 的 GPT-3(第三代通用预训练 Transformer)是一个大型的语言模型,它通常不需要显式地分为源(src)和目标(tgt)数据,因为它采用了无监督学习的训练方式,主要依赖于大量文本数据进行自回归训练。在这种训练过程中,模型通过预测下一个单词来学习语言的模式。

然而,您提到的“src”和“tgt”这两个术语通常用在机器翻译或序列到序列(seq2seq)的任务中,其中“src”代表源语言文本,而“tgt”代表目标语言文本或者是响应文本。在这种情况下,数据通常是成对的,模型的任务是学习如何将“src”文本转换为“tgt”文本。

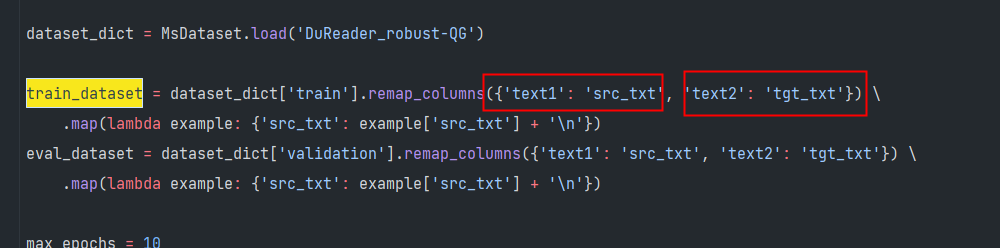

如果您在使用一个基于 GPT-3 架构但是执行具体任务(如翻译、文本生成等)的模型,那么“src”和“tgt”可能是在预处理阶段被合并的。通常,这种合并涉及到将“src”和“tgt”文本连接在一起,可能还会加入一些特殊的分隔符或标记以帮助模型理解文本的不同部分。

您好,可以参考 text generation preprocessor 中对于输入文本的处理,其实主要是做了拼接,不过训练阶段还有一些额外的 loss mask 操作,此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”