实验背景介绍

本手册为阿里云MVP Meetup Workshop《云计算·大数据:海量日志数据分析与应用》的《数据分析展现:可视化报表及嵌入应用》篇而准备。主要阐述如何使用Quick BI制作报表,将前面几个实验处理分析得来的数据进行有效的展现和洞察。

《数据加工:用户画像》实验中的结果表数据已经事先导入RDS中,表名为rpt_user_info_all_d。该表包含了:用户id、地区、性别、年龄范围、星座、访问设备、PV 等访问信息。

实验目标

承接前述实验加工好的数据表,通过Quick BI完成网站用户分析画像的仪表板。

- 在该仪表板中,将展示用户的地区分布、设备分布和访问明细记录。

- 并能够根据年龄范围的查询条件,动态更新图表数据内容。

涉及大数据产品

实验环境准备

必备条件:

确保阿里云账号处于登录状态。

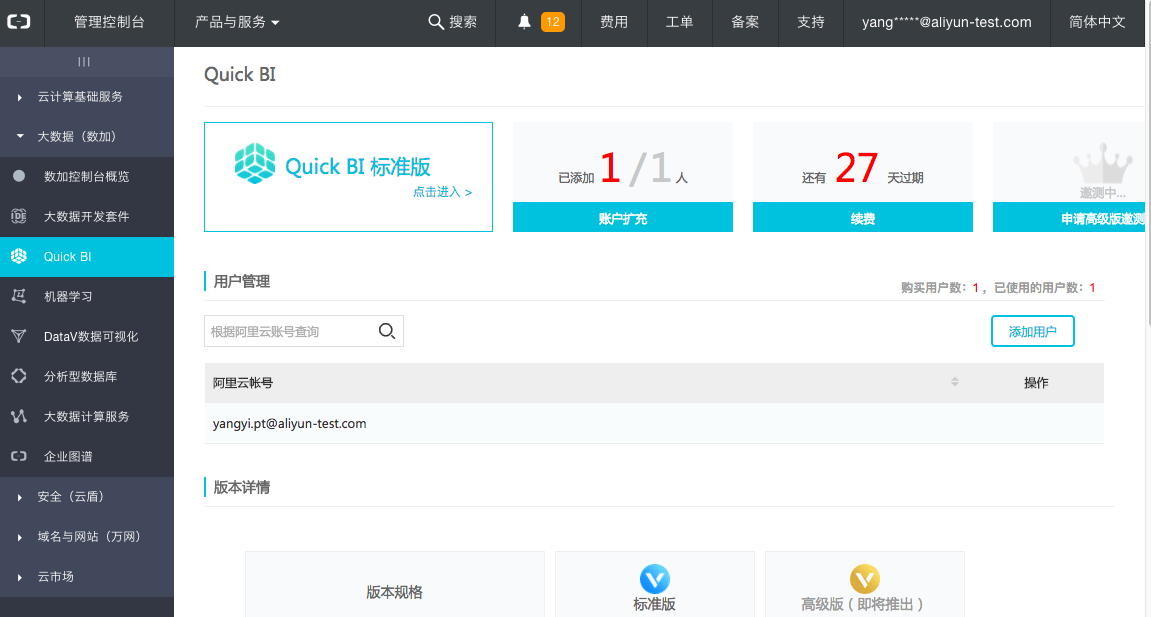

- step1:点击进入大数据(数加)管理控制台>Quick BI tab页面下。

- step2:点击购买Quick BI标准版。

- step3:在购买页面中,点击立即购买。

- step4:在确认订单页面中点击去支付,并确认支付。

- step5:成功开通Quick BI。

进入Quick BI

确保阿里云账号处于登录状态。

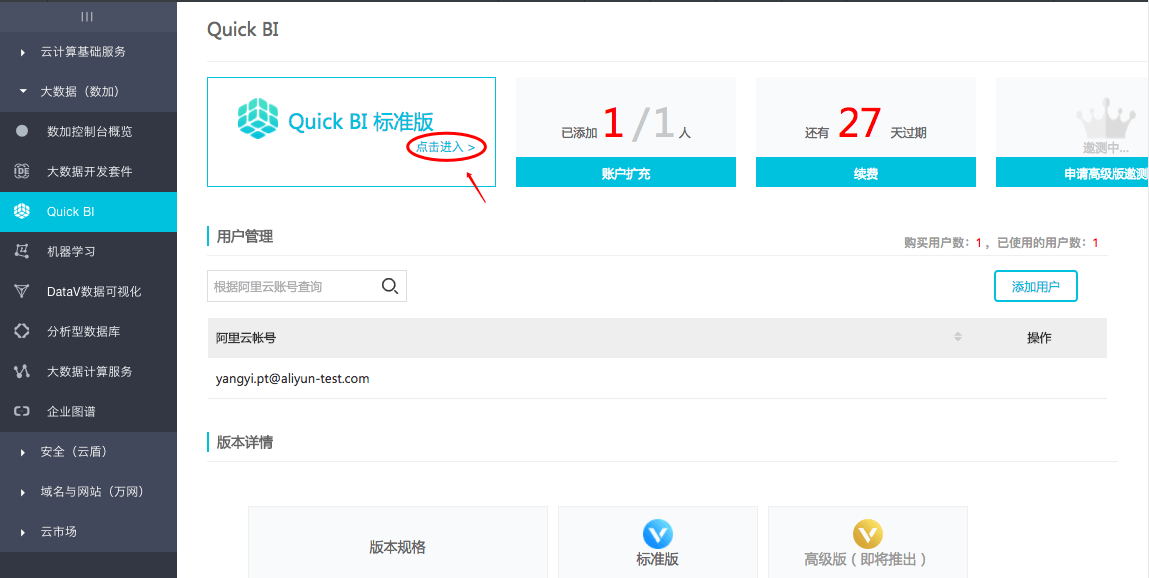

- step1:点击进入Quick BI管理控制台。

- step2:点击进入Quick BI标准版。

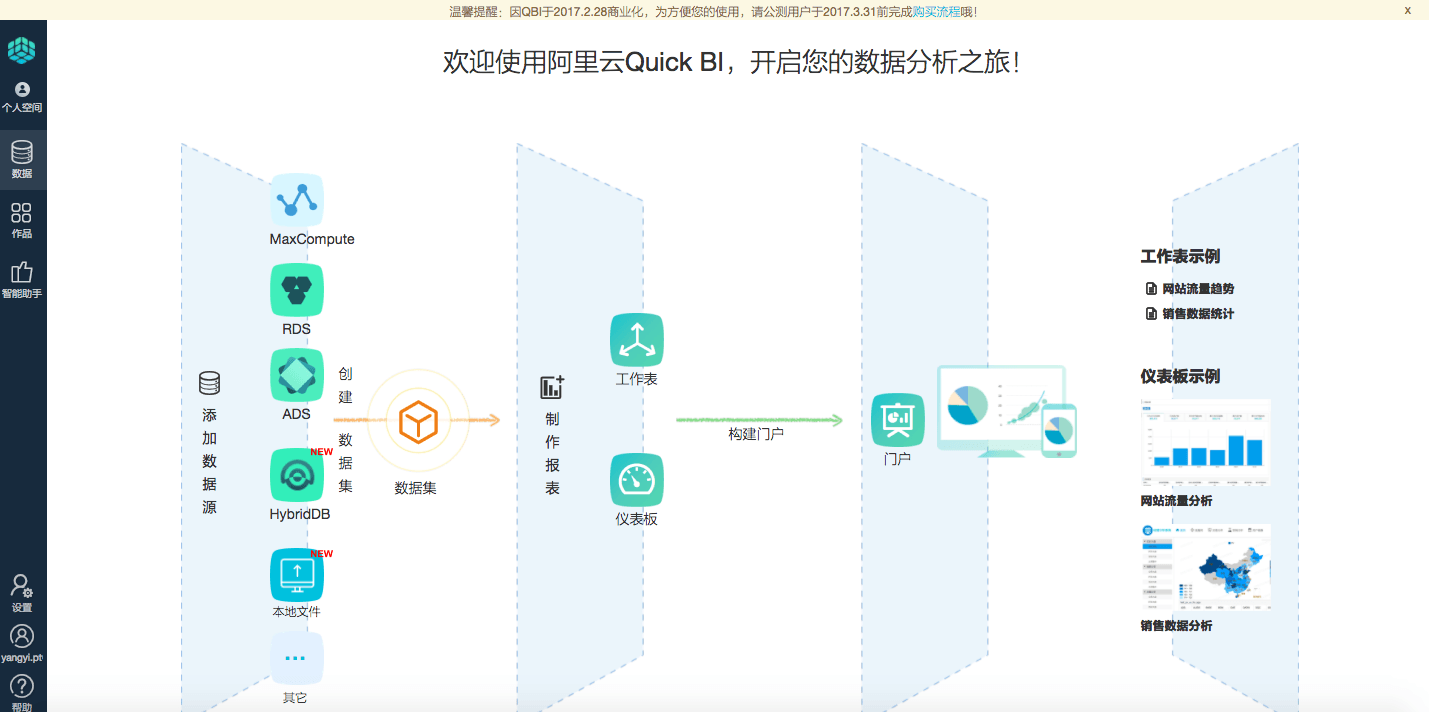

添加数据源

《数据加工:用户画像》实验将数据导入云数据库RDS后,可以利用Quick BI添加为数据源进行分析和展示。本章节为了大家快速的掌握Quick BI的使用提前将数据给大家拷贝了一份在官方的RDS里,大家只需要配置即可用。

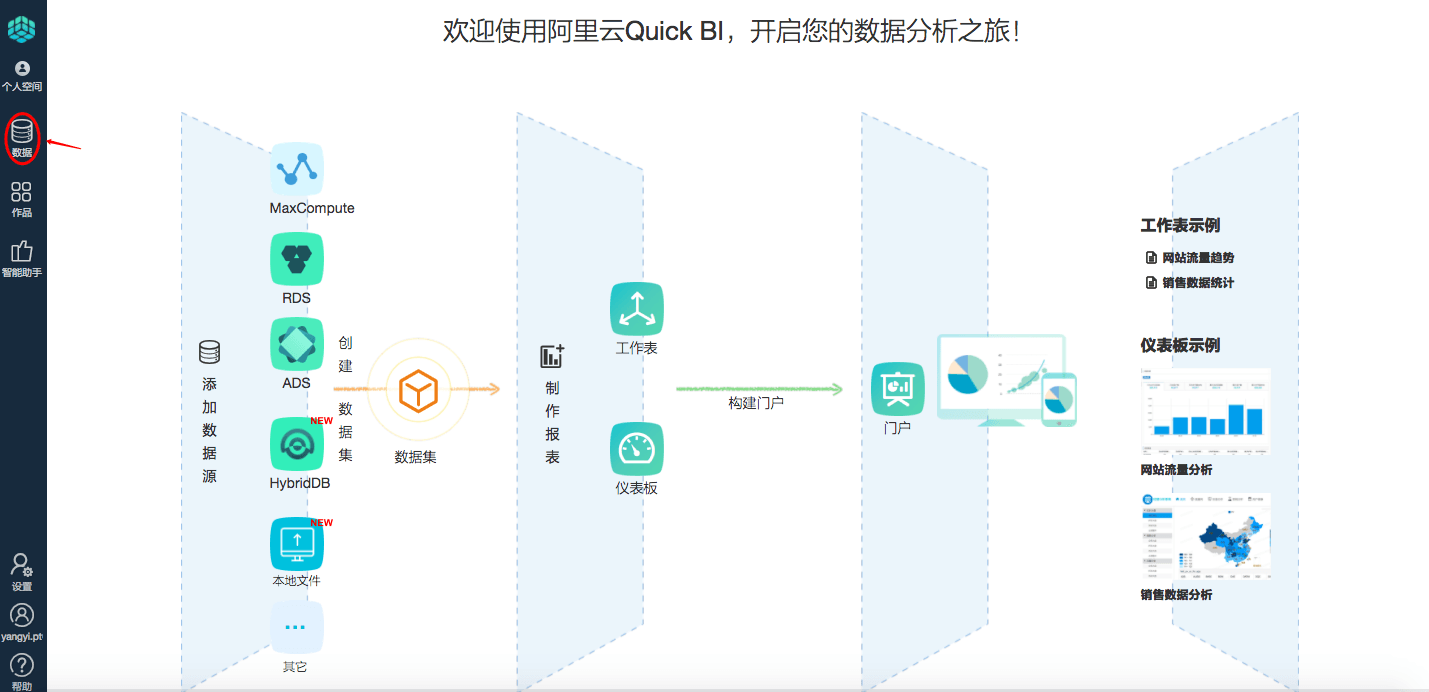

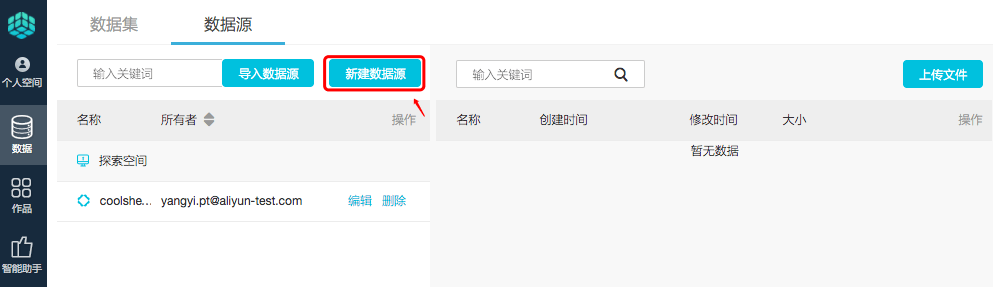

- step1:点击左侧数据,进入数据管理页。

- step2:切换至数据源标签页,点击新建数据源。

[说明] 数据量千万级别,响应速度秒级。添加RDS数据源,可以直联任何一个云上RDS数据库,或ECS中用户自建的RDS。

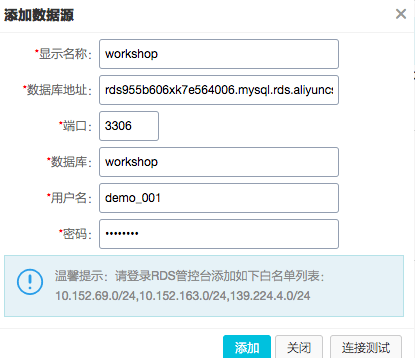

- step3:在新建数据源对话框中,选择并点击RDS for MySQL。

- step4:配置RDS for MySQL数据源,并点击测试连通性,待连通性测试通过后,点击添加保存现有配置信息。

RDS for MySQL数据源配置信息如下:

- 显示名称:workshop

- 数据库地址:

rm-bp1z69dodhh85z9qa.mysql.rds.aliyuncs.com

- 端口:3306

- 数据库:workshop

- 用户名/密码:workshop/workshop#2017

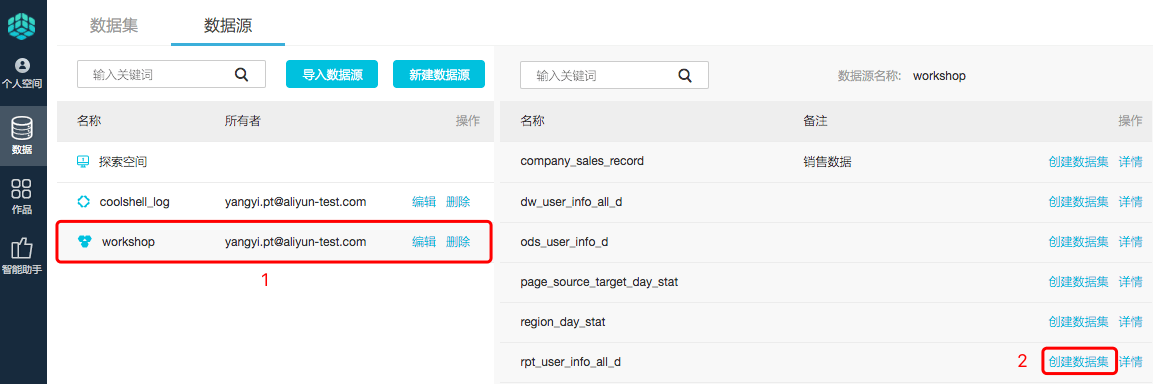

- step5:点击数据源列表页中workshop数据源这行,显示该数据源下的数据表,找到表rpt_user_info_all_d,并点击创建数据集按钮生成数据集。

编辑数据集

说明:

- 将对表的加工过程固化保存下来以避免重复操作。

- 常见加工:维度、度量的切换、修改维度的类型、

增加计算字段、创建层次结构、修改字段的数据类型、更改度量聚合方式、

制作关联模型。

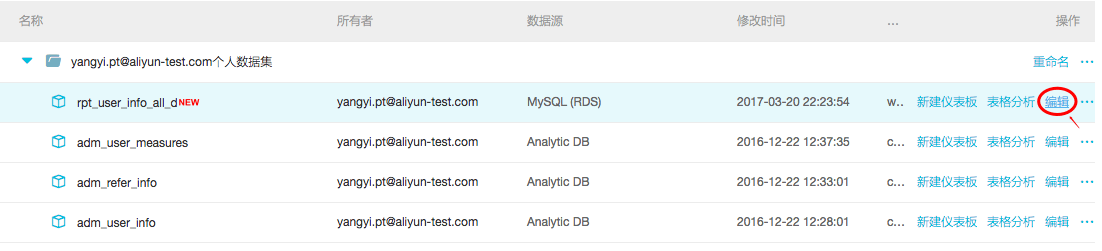

- step1:点击编辑按钮,进入编辑数据集页面。

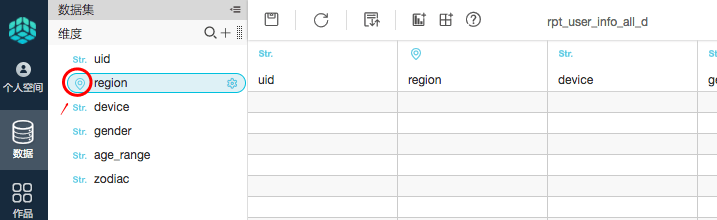

- step2:转换包含地理信息的字段的维度类型(一般字段不需要转换)。选择region字段->右键->维度类型切换->地理信息->省/直辖市。如下图所示:

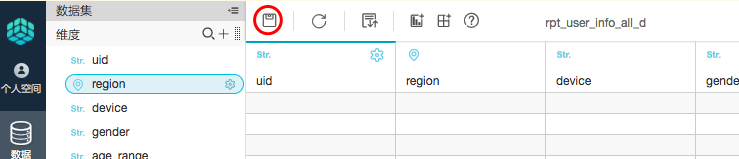

转换成功后,在左侧维度栏中会看到region字段前多一个地理位置图标,如下图所示:

- step3:点击保存,保存数据集。

制作工作表

说明:

- 主要用于对于数据全方位的探索分析。

- 支持随意对维度、度量进行拖拽选择后进行查询,得到工作表内容,支持对维度、度量的过滤,支持排序,支持报表样式的设置。

- 保存的工作表,可以做为下一章节【制作仪表板】的数据来源,直接展现

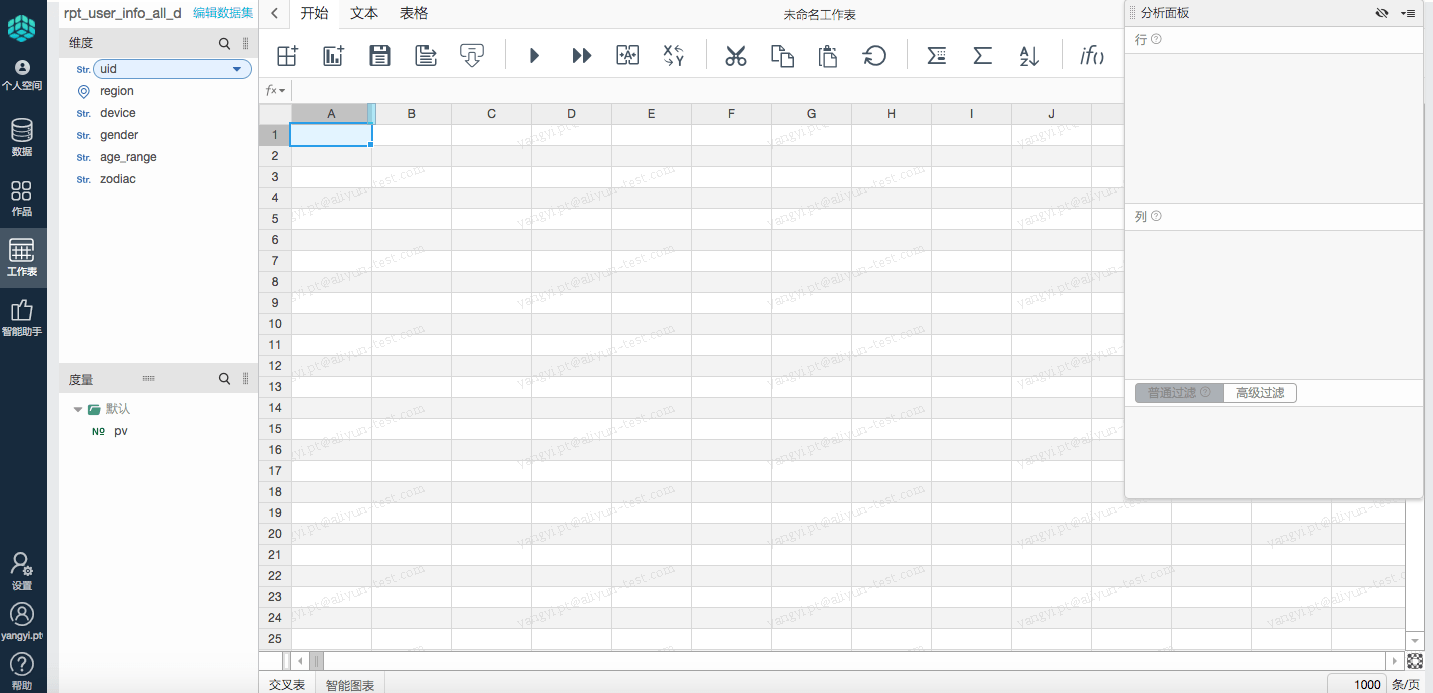

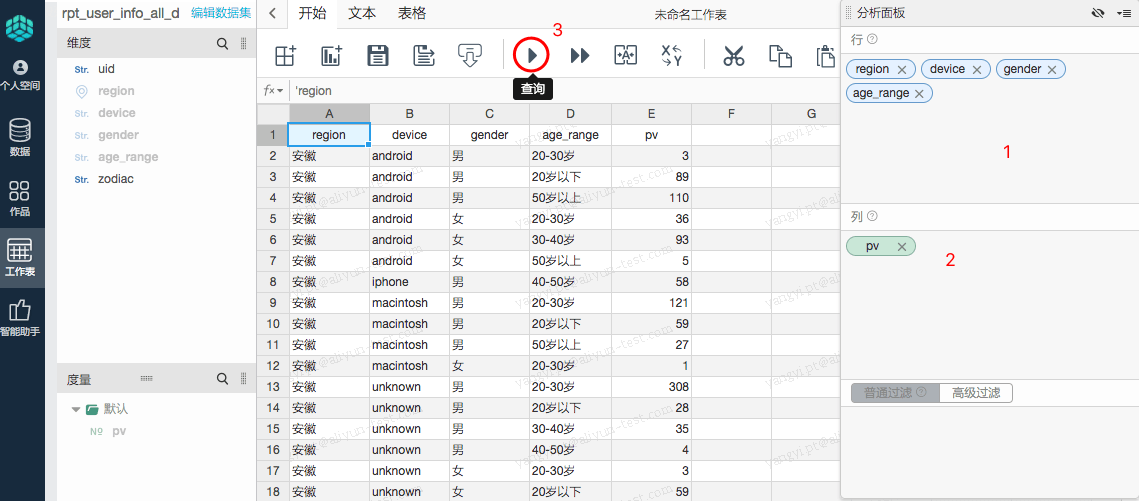

下面希望获得每个地区(region),不同设备(device),不同性别(gender),不同年龄范围(age_range)的访问网站的pv量。

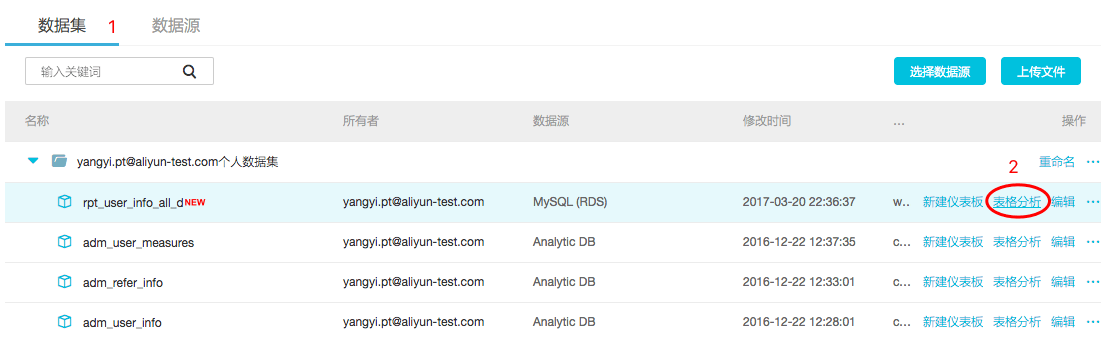

- step1:点击左侧数据,找到数据集rpt_user_info_all_d 这行,点击表格分按钮,就会新建一个工作表对该数据集进行多维分析。

- step2:分别选择需要分析的维度:region、device、gender、age_range并拖拽至分析面板行中,选择度量pv拖拽至分析面板中的列中,点击查询按钮, 得到每个地区、不同设备、不同性别、不同年龄范围的访问网站的pv量。

- step3:点击保存,保存工作表名称为:访问明细。

制作仪表板

与上一节衔接,将分析结果固化为可视化报表。随着数据的更新,报表可视化展现最新数据。我们把这个过程叫制作仪表板。

制作思路:确定内容->确定布局和样式->制作图表->实现动态联动查询。

制作模板如下:

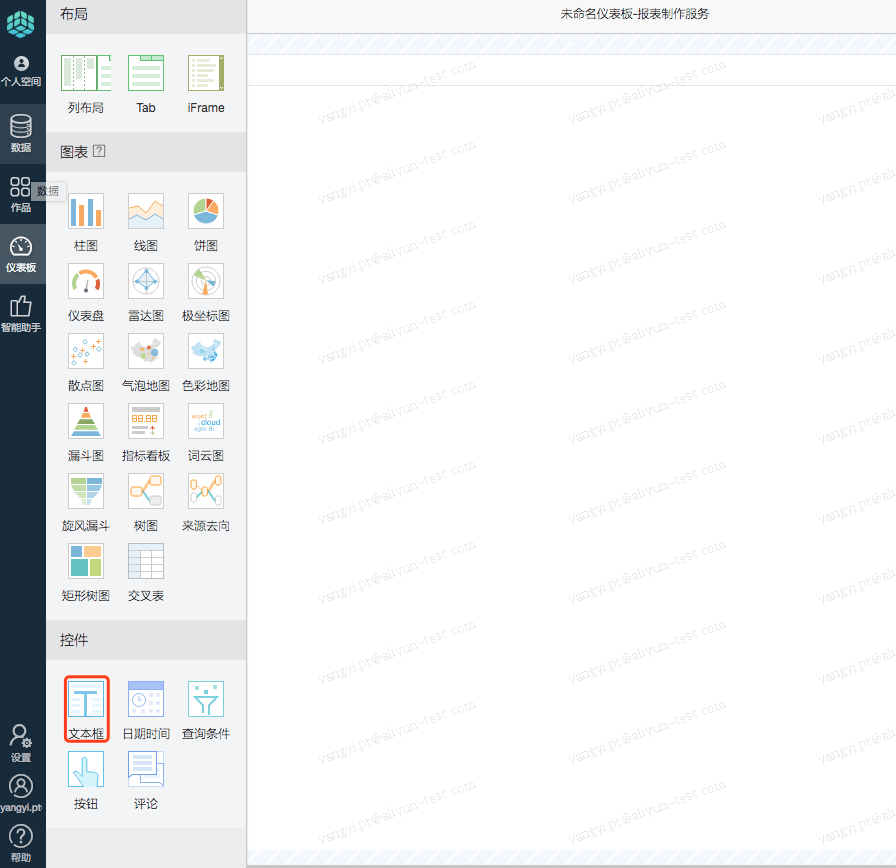

【说明】仪表板创作界面的工具布局:

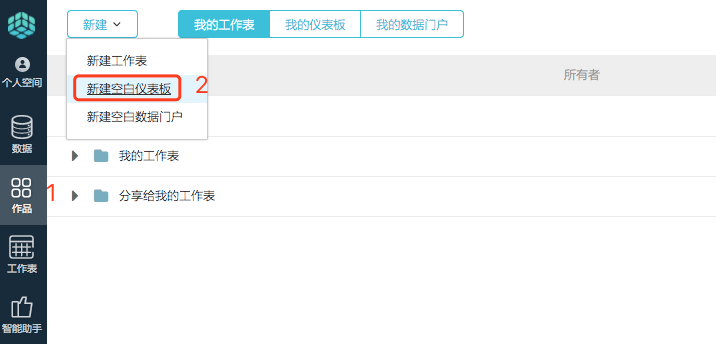

- step1:点击主导航上的作品菜单,点击新建下拉菜单下的新建空白仪表板按钮,就可以开始创建一个仪表板。

- step2:从仪表板空间中向画布拖入文本框并命名为网站用户画像。

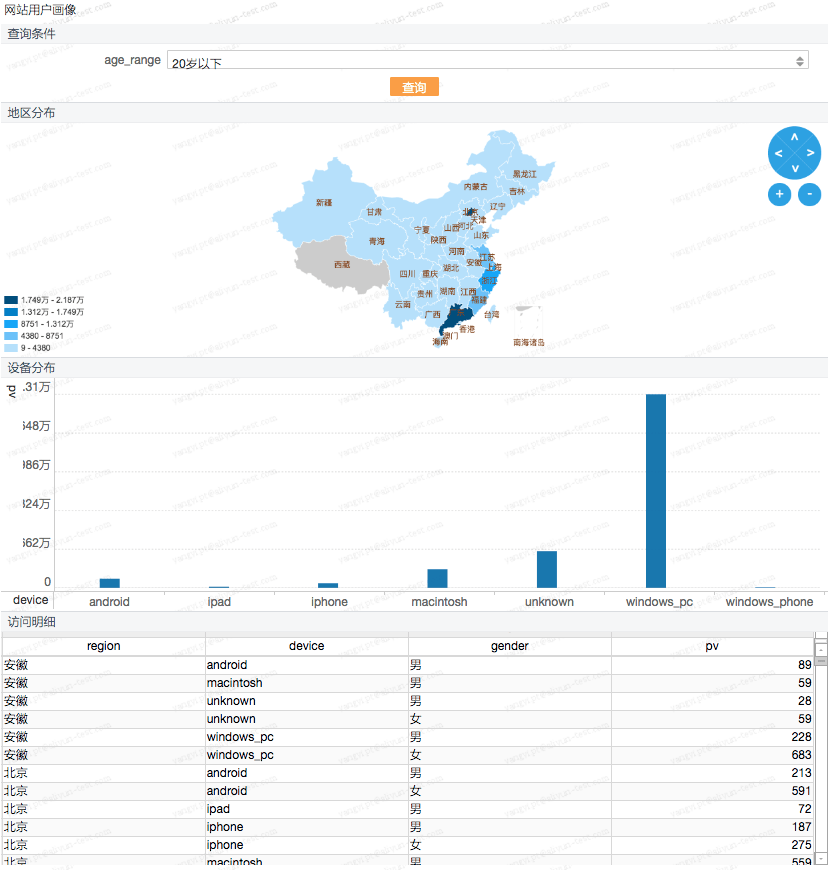

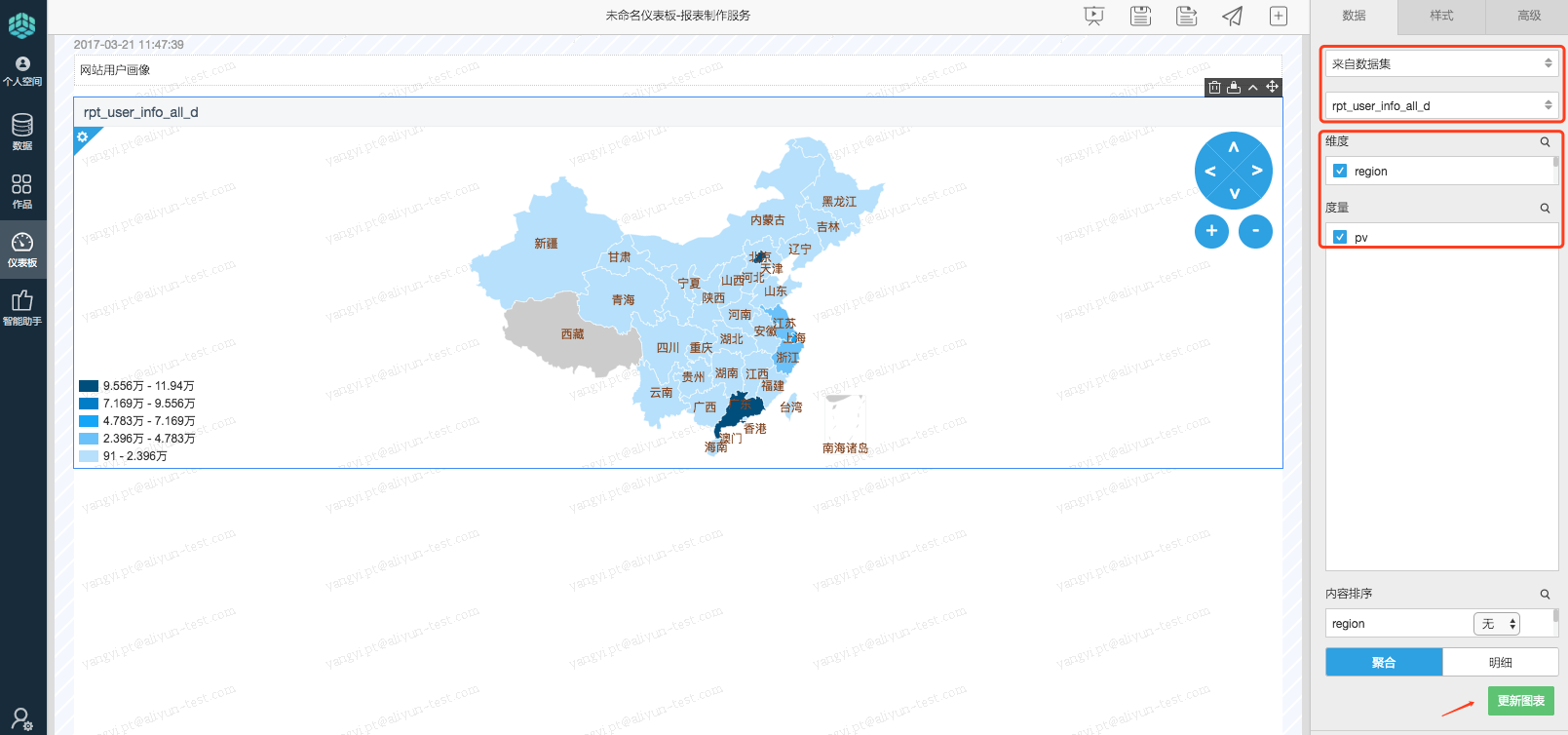

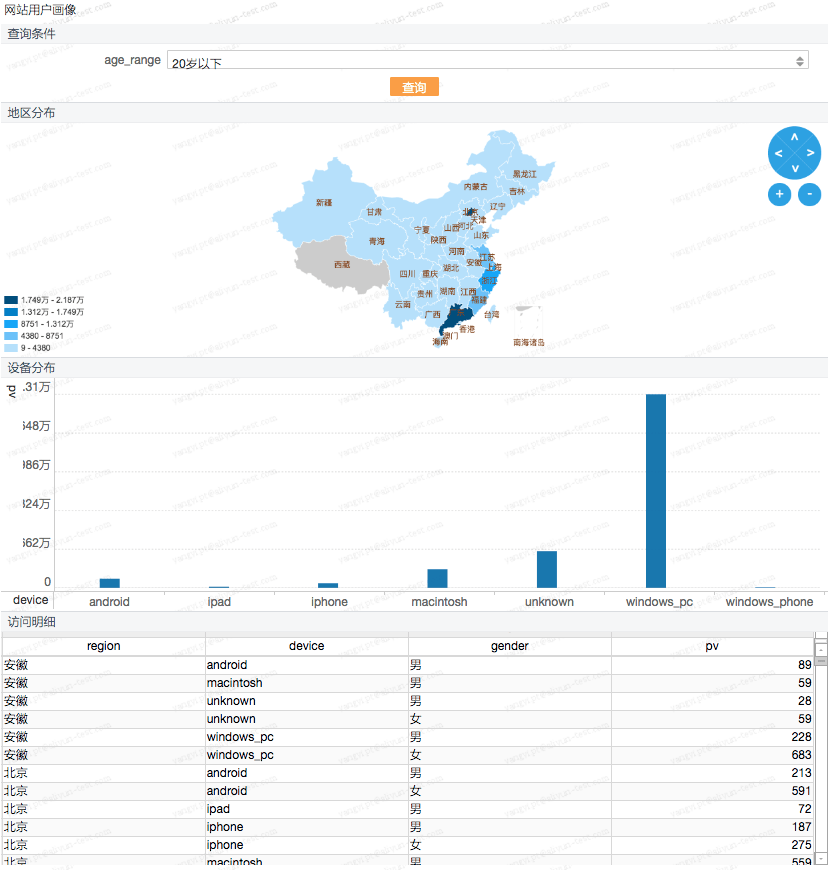

- step3:点击图表区域内的色彩地图,并选择数据源来源为来自数据集rpt_user_info_all_d,选择维度为region(地区)、度量为pv,选择完成后点击更新图表按钮,结果如下:

业务目的:查看访问用户的地域分布情况。

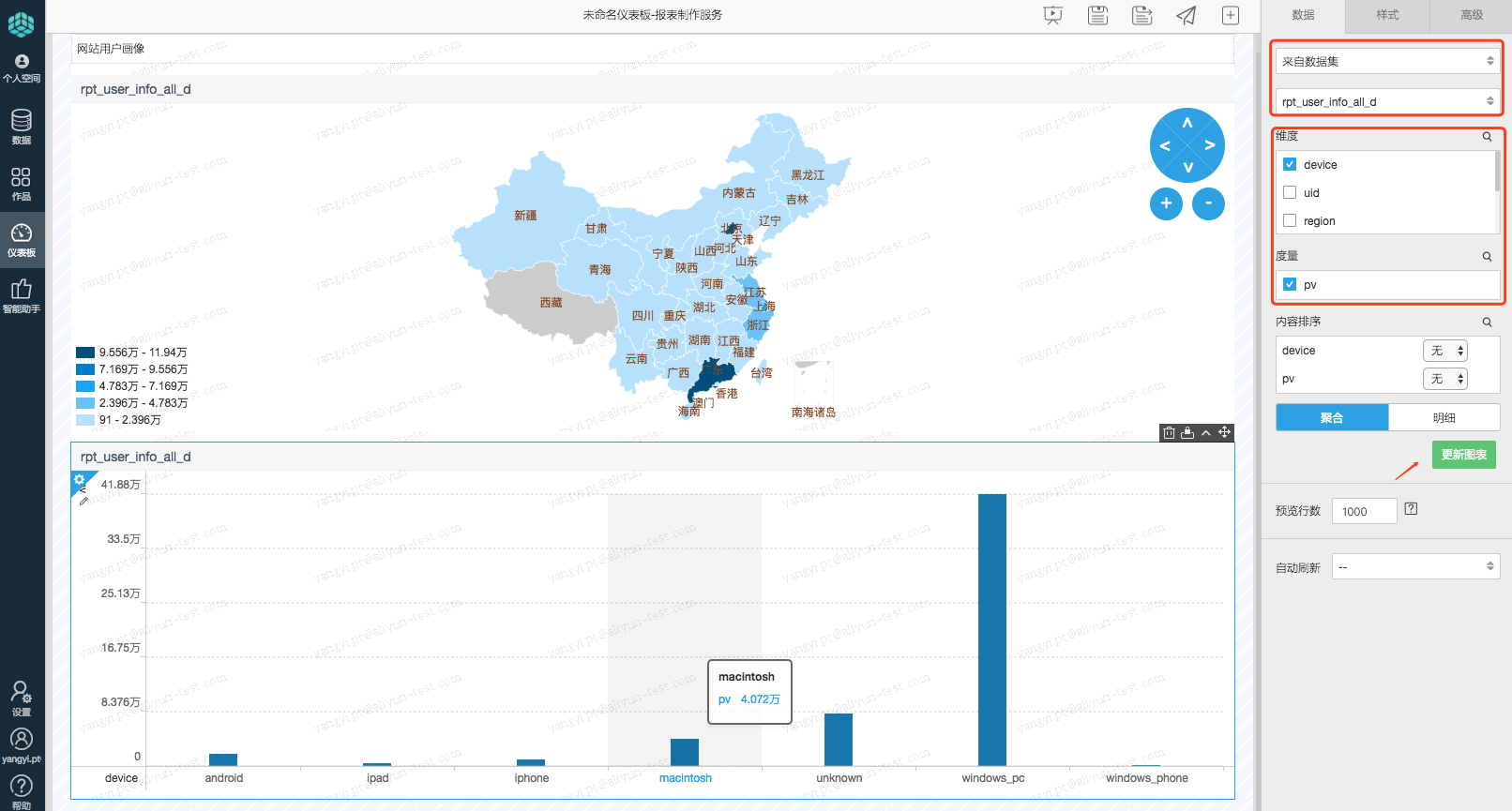

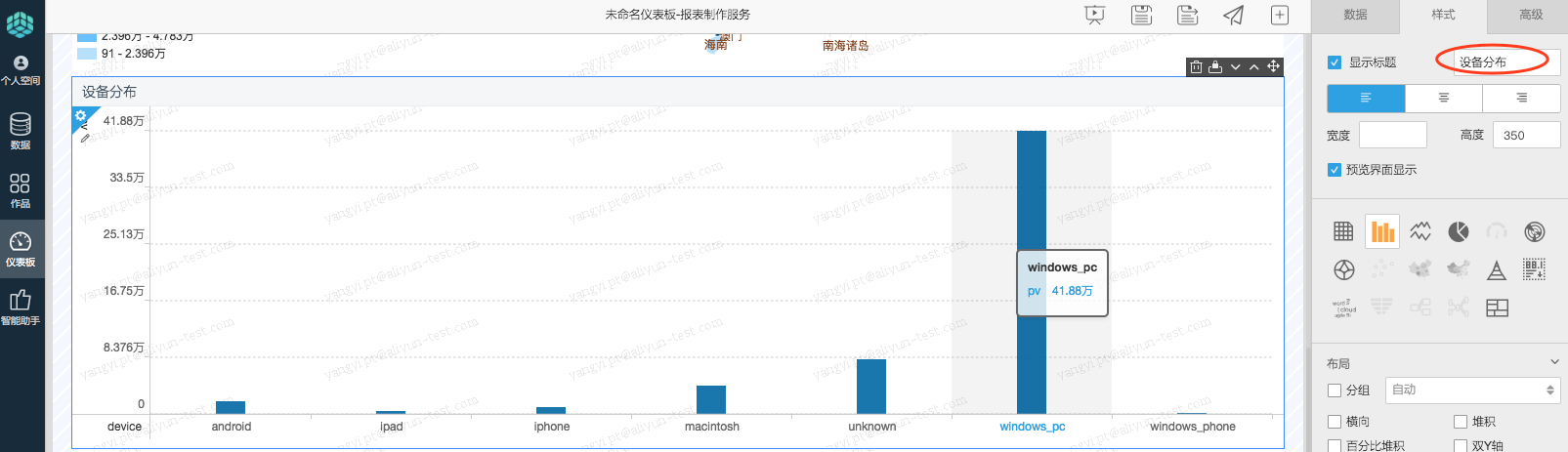

- step4:将图表区域内的柱图拖拽至右侧画布,并配置选择数据来源为来自数据集rpt_user_info_all_d,选择维度为device(设备)、度量为pv,点击更新图表,

结果如下:

业务目的:查看访问设备的分布情况.

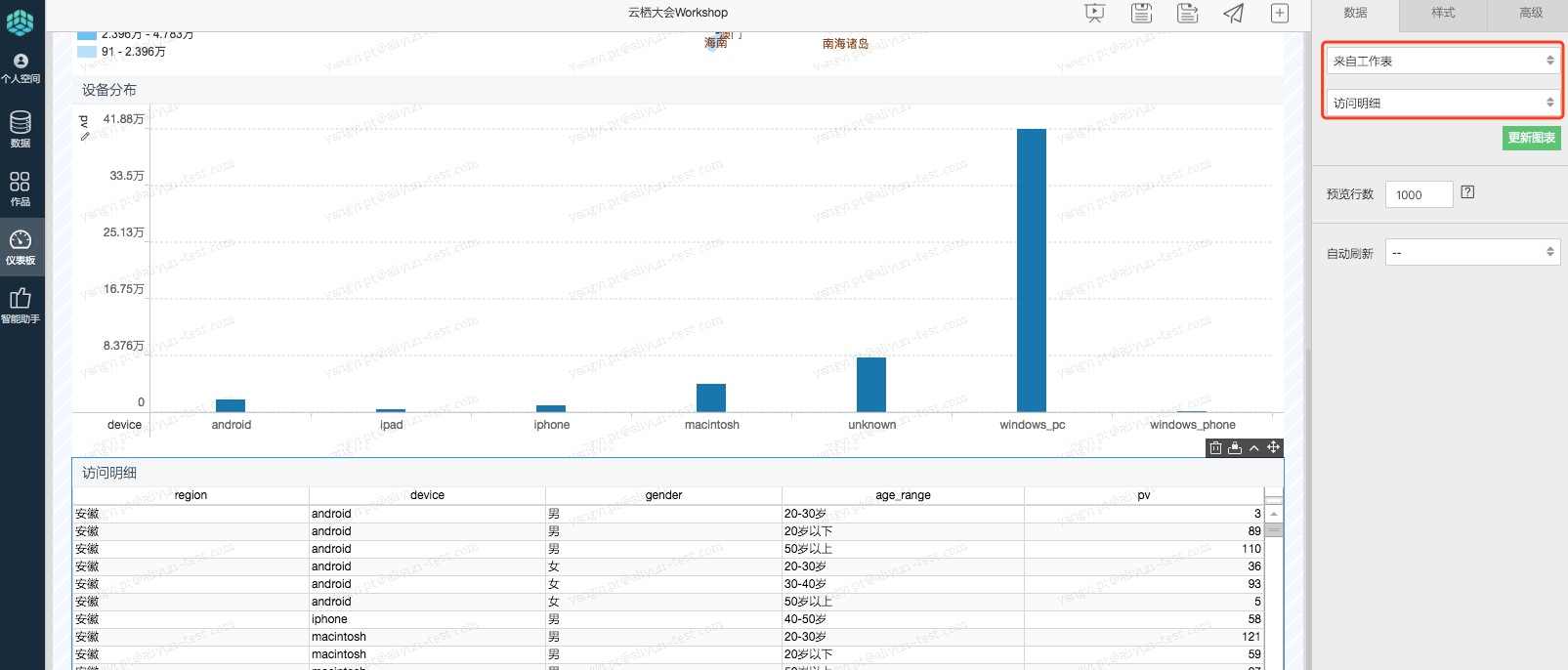

- step5:点击图表区域内的交叉表,并选择数据源>来自工作表>访问明细(上述步骤中保存的工作表),点击更新图表按钮,结果如下:

业务目的:查看每个地区(region)、不同设备(device)、不同性别(gender),不同年龄范围(age_range)的访问网站的pv量。

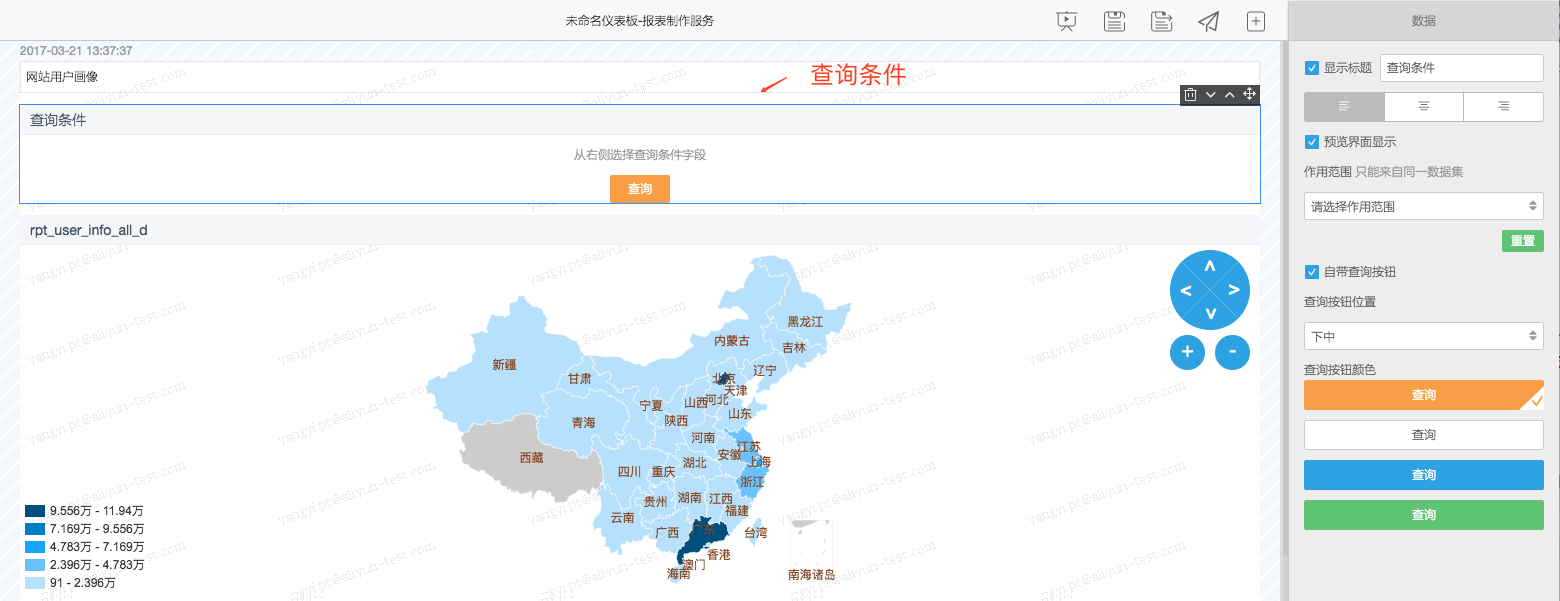

- step6:向画布中拖入控件区域内的查询条控件,在拖动指示分隔线落到文本框和气泡地图之间的时候,放下查询条件控件。

业务目的:增加查询条件年龄范围,实现动态图表。

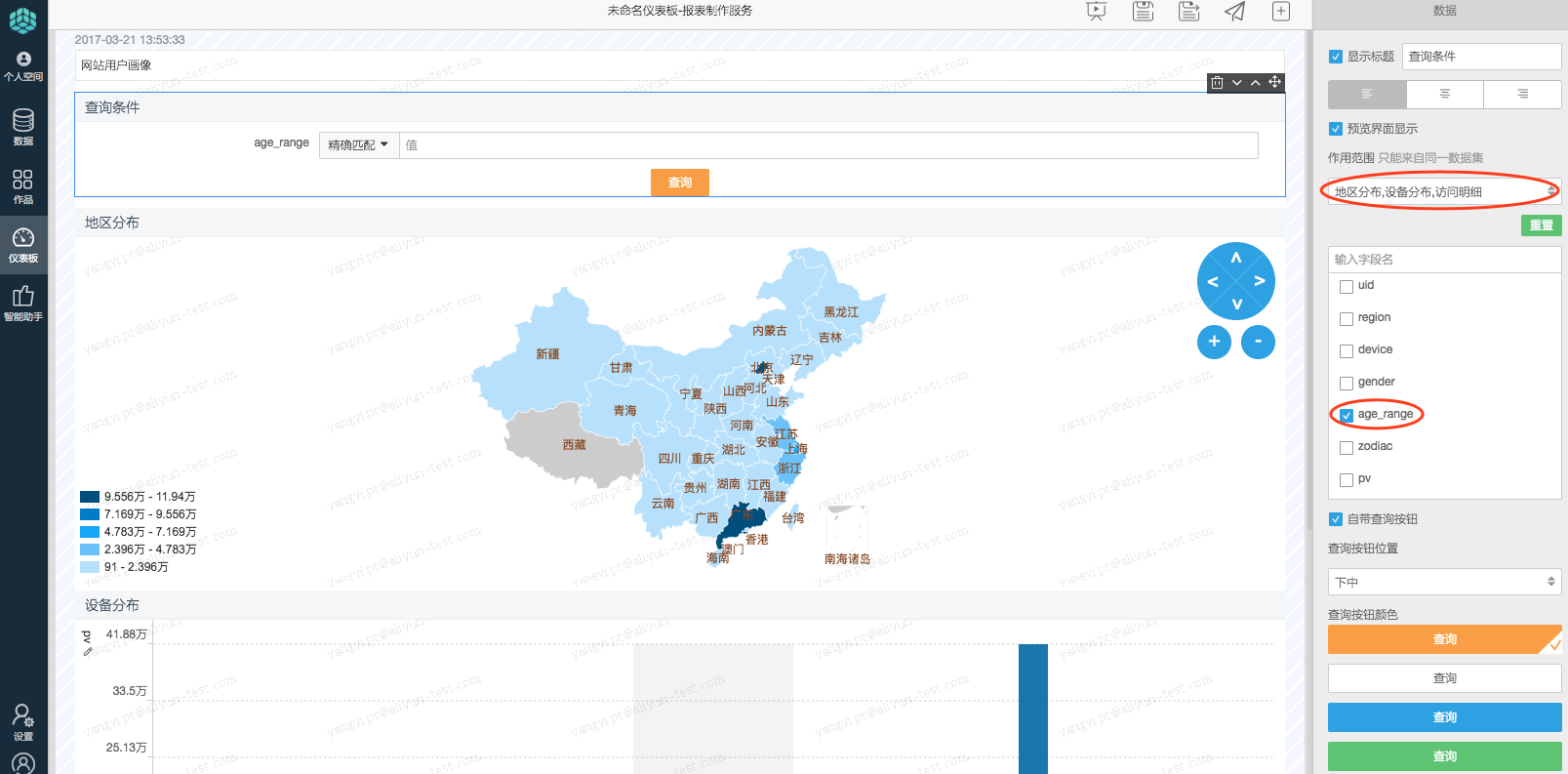

拖动结束后,设置查询条件对应的字段、作用范围和样式:

- step6.1:首先将前面制作好的色彩地图、柱状图和交叉表控件的标题依次改为,地区分布和设备分布。

- step6.2:接着,点击并设置查询条件对应到哪个字段和作用范围(上述配置的两个控件名称):变化的时候能影响到哪些图表控件。

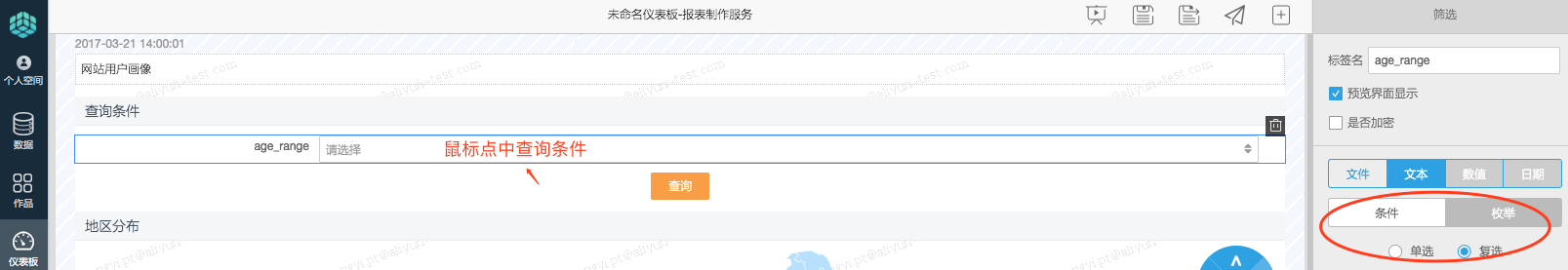

- step6.3:然后设置查询条件的显示样式,这里设置为枚举类型复选框样式。

[注意]鼠标选中查询条件的输入框后,样式设置界面才会出现。

- step7:点击保存仪表板,名称为云栖大会workshop。

- step8:点击预览仪表板。

修改年龄范围为不同的值,看仪表板的各个区块的图表的数据是否随着查询条件的变化而变化。

恭喜各位已经完成了数据清洗、加工到展现的链路。更多的关于Quick BI的进阶教程,详见:更多案例(销售数据分析、仪表板制作)