GPT-3在AI Dungeon游戏中富有争议的表现一度让它被推到了大众讨论的风口浪尖,不过我们现在来讨论一下它的另一种应用:问题解答和搜索引擎。

近日,一篇题为《重新思考搜索:从菜鸟到大师》的论文称,直接向用户展示搜索到结果是一种「认知负担」,而该论文则通过提高自然语言处理系统(NLP)的能力,从而可以给用户提供更优质的结果。

高达1,750亿个参数!史上最大模型:GPT-3

GPT-3是迄今为止最大的预训练模型,具有1,750亿个参数,使其能够针对各种语言任务给出结果。

与大多数设计为执行单个特定任务的AI系统不同,GPT-3设计具有通用性,「文本输入-输出」界面可以执行任意数量的操作,并给出具体的提示建议。

GPT-3更像是在和一个专家交流,以对话的形式来对用户的问题进行解答,极大地减少用户的工作量。终于可以告别「在搜索引擎上找不到想要的结果是怎样的一种体验?」了。

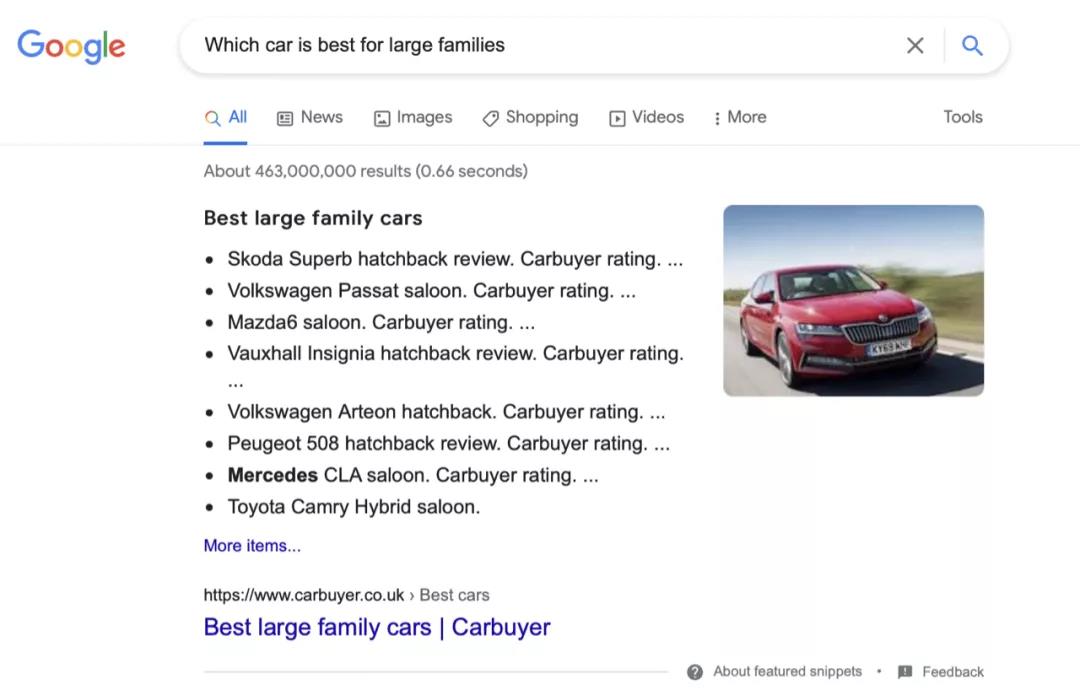

话不多说,我们这就来尝试一个问题:「最适合七口之家的车是什么?」

这个答案非常令人满意。沃尔沃XC90确实是适合七口之家的汽车,并且其强大的安全功能也广受喜爱。

我们再来看看谷歌搜索给出的答案:

的确回答了我们的问题,不过如此之多的选择会大大增加了用户的决策成本。用乔布斯的话说就是「选择会降低意志力」。

表现比GPT-3更权威

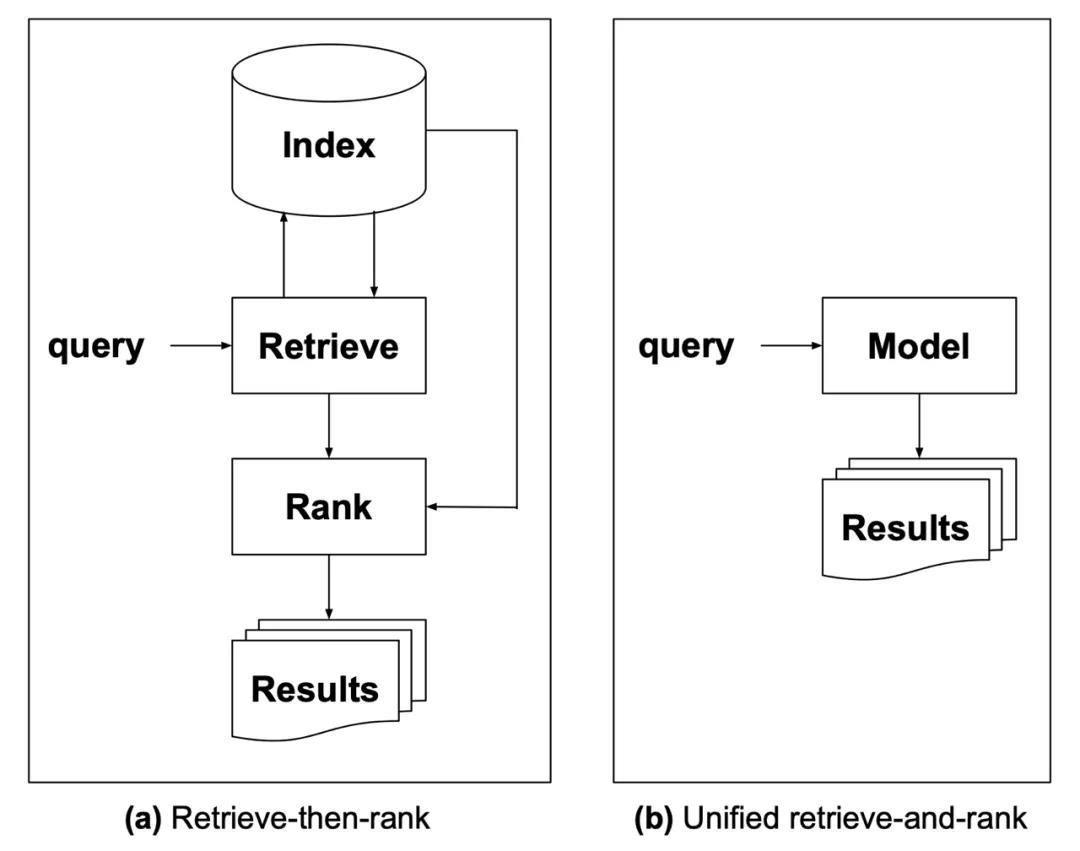

回到论文上来,该论文提出了对多域预言响应类型的改进,其中,这些响应可以从深度学习自回归语言模型(例如GPT-3)中获得。

主要改进:a)准确地对来源进行引用;b)防止模型发明不存在的源材料。

这其中的语言模型将在各种领域(包括图像和文本)上进行训练, 除此之外,它还会学习知识的来源,这是GPT-3所不具备的。

「要用一个统一的模型替换搜索索引,模型本身必须有可能像传统索引一样维度的知识。实现此目的方法是使用语料库模型,对术语-术语,术语-文档和文档-文档之间的关系进行联合建模。」

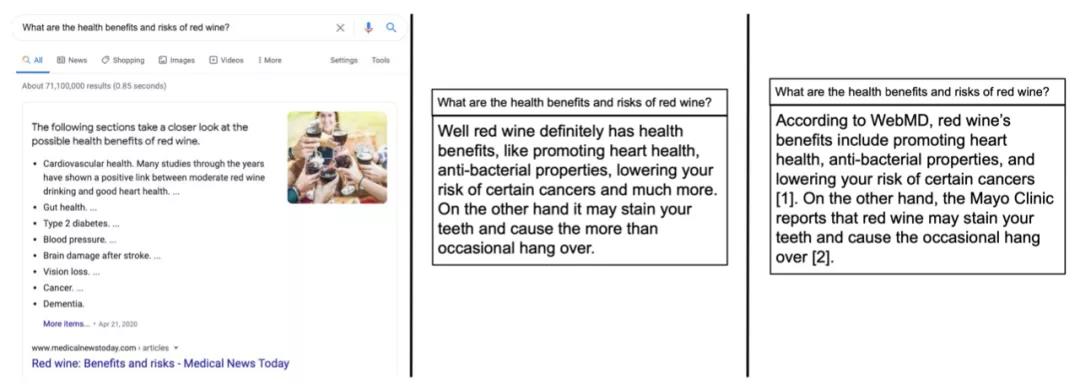

上图是对用户搜索的三种回答:

左:Google的算法给出的搜索结果,答案具有一定的先后顺序。

中:GPT-3风格的答案,清晰明了,但是不能证明引用来源的合理性。

右:论文提出的系统,其将搜索结果中的「最佳答案」直接整合到回答中,并用注脚的形式指出答案的来源。

强人工智能已经可以实现了?

研究人员指出,这个系统还不能被称为强人工智能(AGI),因为其同样面临着在自然语言处理的背景下,给出具有普适性的专业回答的挑战。

文章对这种专业的「高质量」答案提出了五项要求:

- 权威

答案应该通过从权威性很高的来源中产生。这就是为什么在术语序列和文档元数据之间建立更明确的联系如此重要的另一个原因。如果语料库中的所有文档都标注有权威性分数,则在训练模型和生成答案时都应该考虑该分数。

- 透明度

只要有可能,就应该向用户提供答案的来源。并且应该思考,这个回答的首选信息来源是什么?

- 处理偏见

预先训练的语言模型的设计目的不是评估经验的真实性,而是对数据中的主要趋势进行概括和优先排序。这为攻击提供了可能的模式,那么就需要使用辅助系统来防止系统做出这种偏见性的回答。

- 多样性的观点

答案应该具有各种不同的观点,且不应两极分化。例如,对于有争议的问题,应以公平的方式涵盖争议双方。这也与模型对偏见性信息的处理紧密联系。

- 无障碍语言

除了为使用不同于答案来源的语言的用户提供准确的翻译之外,其答案应「尽可能用原义写成」。

看来实现强人工智能的路还有很长一段要走。