分布式TensorFlow

如果一台计算机上有很多GPU,那么通过GPU并行运算的方式可以得到很好的加速效果。但是一台计算机可携带的GPU毕竟有限,要想进一步提升速度,可以将TensorFlow分布地运行在多台机器上。2016年4月14日,Google发布了分布式TensorFlow。

分布式TensorFlow有一些基本概念,下面对其进行介绍。

(1)task:一个task一般会关联到某个单一的TensorFlow服务端的处理过程,属于一个特定的Job,并且在该Job的任务列表中有唯一的索引,可以将其理解为每台机器上的一个进程。

(2)Job:Job分为ps、worker两种,一个Job包含一系列致力于某个相同目标的task。例如,一个叫ps的Job会处理存储与更新变量相关的工作,而一个叫worker的Job会承载那些用于计算密集型任务的无状态节点。一般来说,一个Job中的task会运行在不同的机器中。

(3)Cluster(集群):一个TensorFlow集群包含一个或者多个TensorFlow服务端,集群被切分为一系列Job,而每个Job又会负责一系列的task。一个集群会专注于一个相对高层的目标,如用多台机器并行地训练一个神经网络。

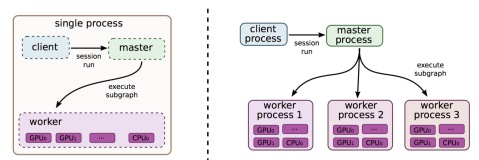

使用分布式TensorFlow训练深度学习模型有两种方式。第一种是计算图内分布式(In-graph模式),在该模式中,所有的计算任务使用同一个计算图中的变量。第二种是计算图间分布式(Between-graph模式),在该模式下,数据并行,每台机器使用完全相同的计算图,每个计算图都是独立的,但数据同步比较困难。

分布式TensorFlow

2024-07-03

30

版权

版权声明:

本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《

阿里云开发者社区用户服务协议》和

《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写

侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

简介:

【7月更文挑战第3天】分布式TensorFlow。

目录

相关文章

|

4月前

|

UED

存储

数据管理

深度解析 Uno Platform 离线状态处理技巧:从网络检测到本地存储同步,全方位提升跨平台应用在无网环境下的用户体验与数据管理策略

【8月更文挑战第31天】处理离线状态下的用户体验是现代应用开发的关键。本文通过在线笔记应用案例,介绍如何使用 Uno Platform 优雅地应对离线状态。首先,利用 `NetworkInformation` 类检测网络状态;其次,使用 SQLite 实现离线存储;然后,在网络恢复时同步数据;最后,通过 UI 反馈提升用户体验。

109

0

0

|

5月前

|

机器学习/深度学习

存储

TensorFlow

|

7月前

|

机器学习/深度学习

运维

监控

TensorFlow分布式训练:加速深度学习模型训练

【4月更文挑战第17天】TensorFlow分布式训练加速深度学习模型训练,通过数据并行和模型并行利用多机器资源,减少训练时间。优化策略包括配置计算资源、优化数据划分和减少通信开销。实际应用需关注调试监控、系统稳定性和容错性,以应对分布式训练挑战。

272

0

0

|

机器学习/深度学习

数据可视化

Java

|

存储

监控

TensorFlow

|

机器学习/深度学习

人工智能

分布式计算

5月14日Apache Spark中国社区技术直播【Analytics Zoo上的分布式TensorFlow训练AI玩FIFA足球游戏】

近年来,由于对通用人工智能研究的潜在价值,训练AI玩游戏一直是一个火热的研究领域。FIFA实时视频游戏场景复杂,需要结合图像,强化学习等多种不同的AI技术,同时也要求agents响应有实时性,因此是一个非常好的试验场,可以用来探索不同类型的AI技术。本次分享主要介绍我们在训练AI玩FIFA视频游戏方面的一些工作。

740

0

0

|

算法框架/工具

TensorFlow

机器学习/深度学习

ElasticDL:蚂蚁金服开源基于TensorFlow的弹性分布式深度学习系统

“ElasticDL”,基于 Eager Execution 模式的开源项目,它是一个 Kubernetes 原生深度学习框架,根据介绍,ElasticDL 主要有四大特点:容错性、弹性调度、易用性、高效,其中又以容错与弹性调度特性最具特色。

1325

0

0

热门文章

最新文章

1

Kubeflow实战系列:利用TensorFlow Serving进行模型预测

2

tensorflow object detection API训练公开数据集Oxford-IIIT Pets Dataset

3

tensorflow:流程,概念和简单代码注释

4

CNN-RNN中文文本分类,基于TensorFlow 实现

5

用GPU进行TensorFlow计算加速

6

动手实验 - TensorFlow和TensorBoard自然语言分析

7

TensorFlow 2.0开发者测试版来啦,正式版推出指日可待

8

TensorFlow的开源与Hadoop的开源有什么不同?

9

如何用TensorFlow构建RNN?这里有一份极简的教程

10

Ubuntu 14.04 关于 TensorFlow 环境的配置

1

使用TensorFlow进行深度学习入门

63

2

深度学习:Pytorch 与 Tensorflow 的主要区别(2)

104

3

Python 与 TensorFlow2 生成式 AI(一)(4)

84

4

Python 与 TensorFlow2 生成式 AI(一)(3)

83

5

Python 与 TensorFlow2 生成式 AI(五)(3)

79

6

Python 与 TensorFlow2 生成式 AI(五)(2)

61

7

Python 与 TensorFlow2 生成式 AI(五)(1)

77

8

TensorFlow检测GPU是否可用

108

9

在有GPU的windows上安装TensorFlow

122

10

【环境配置】tensorflow11.1.0编译

57