0. 前言

按照国际惯例,首先声明:本文只是我自己学习的理解,虽然参考了他人的宝贵见解及成果,但是内容可能存在不准确的地方。如果发现文中错误,希望批评指正,共同进步。

在深度学习领域,PyTorch作为一款广受欢迎的开源机器学习库,以其灵活、动态的计算图模型和强大的GPU支持能力而受到广大研究者与开发者的青睐。其中,Tensor是PyTorch的核心数据结构,也是进行各种数学运算和构建神经网络的基础。本文将详细解析PyTorch中的基本数据类型——Tensor,帮助读者深入理解其概念、特性和应用。

1. Tensor的基本介绍

Tensor(张量)在PyTorch中是对多维数组的抽象表示,类似于NumPy中的ndarray。它可以在CPU或GPU上存储和处理数据,并且提供了丰富的数学运算方法。无论是简单的标量、向量、矩阵,还是高维度的数据,都可以用Tensor来表示。

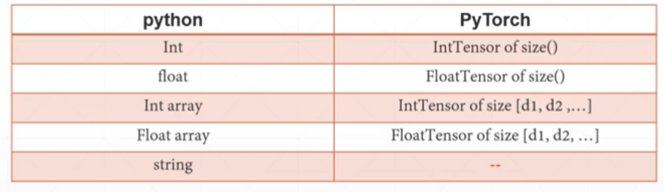

下面通过Python与PyTorch的数据类型对比来说明Tensor:

以上数据是存储在CPU中。如果使用.cuda(),会返回一个GPU上的引用:

import torch a = torch.tensor([1,2]) c = a.cuda print(c) print(type(c)) -----输出------ D:\Users\Lenovo\anaconda3\python.exe C:/Users/Lenovo/Desktop/pythonProject2/main.py <built-in method cuda of Tensor object at 0x000002A03434CA00> <class 'builtin_function_or_method'> Process finished with exit code 0

2. Tensor属性

- .shape:返回Tensor的维度信息。

- .dtype:返回Tensor的数据类型,如torch.float32、torch.int64等。

- .device:返回Tensor所在的设备,即CPU或某个GPU编号。

3. Tensor的常见使用方法及代码实例

3.1生成tensor方法

import torch a = torch.rand(3, 3) #生成指定大小的,元素范围[0,1]的tensor print(a) b = torch.rand_like(a) #生成与对象tensor大小一致的tensor print(b) c = torch.randint(1,10,(3,3)) #生成(3,3)大小,[1,10)范围的tensor(包括1,但不包括10) print(c) d = torch.randn(2,4) #生成均值为0,方差为1的随机tensor print(d) e = torch.full([2,5],0) #生成全部一样的tensor print(e) f = torch.arange(0,10) #生成顺序tensor print(f) g = torch.linspace(0,9,steps=8) #生成[0,9],等分成8个的tensor print(g) print(torch.ones(3,1), torch.zeros(4,5), torch.eye(6)) #生成全1,全0,单位矩阵tensor

3.2 tensor的切片与索引

import torch a = torch.rand(3, 7) #生成指定大小的,元素范围[0,1]的tensor print(a) print("*"*100) print(a[0]) #取一行 print("*"*100) print(a[:2,4:]) #指定一块子区域 print("*"*100) print(a[:,2]) #取一列 print("*"*100) print(a[:,0:7:2]) #[0,7]行隔2行取样 print("*"*100) print(a.index_select(1,torch.tensor([2,6]))) #指定切片位置 print("*"*100) mask = a.ge(0.8) print(torch.masked_select(a,mask)) #通过掩码条件切片(注意切片后会被flatten) print(mask) #看看mask矩阵

3.3 tensor的维度变换(重点)

基本操作:

- view/reshape

- squeeze/unsqueeze

import torch a = torch.rand(3,4,2) #生成指定大小的,元素范围[0,1]的tensor print(a) # view方法:变换tensor的形状 print(a.view(3, 8)) #压缩维度 print(a.view(3,2,2,2)) #扩展维度 # unsqueeze方法:在指定地方插入一维(squeeze方法同理会消除一维) print(a.unsqueeze(1)) print(a.squeeze(1)) #squeeze只有在原有维度为1才有用,试试把上面改成rand(3,1,2)看看效果

3.4 tensor的叠加和分割

```python import torch #cat操作 a = torch.rand(4,1,3) b = torch.rand(3,1,3) # print(a) # print(b) c = torch.cat((a,b)) #合并tensor(只能在其他dimension一致的情况下才能合并) # print(c) # print(c.shape) #stack操作 d = torch.rand(4,1) e = torch.rand(4,1) # print(d) # print(e) f = torch.stack((d,e)) #合并tensor,与cat不同的是,stack会增加一个更高的维度 # print(f) # print(f.shape) #split操作 g = torch.rand(5,2,1) h,i = g.split([1,4]) # print(g) # print(h) # print(i)

3.5 tensor的数学运算

import torch #基本加减乘除 a = torch.zeros(4,3) b = torch.ones(3) # print(a+b) #这样会报错,正确做法如下 # print(torch.add(a, b)) #结果全是1,broadcast运算逻辑 c = torch.tensor([[1,2,3],[4,5,6],[7,8,9]]) d = torch.eye(3) # print(torch.add(c,d)) # print(c+d) #不采用broadcast逻辑时,这样也可以 # print(c*d) # print(c/d) # print(c**2) #平方 # print(c**0.5) #开平方 #矩阵相乘 # print(torch.matmul(torch.ones(3,3),torch.ones(3,3))) # print(torch.ones(3,3)@torch.ones(3,3)) #用@的效果是一样的 #高维度的矩阵相乘 e = torch.rand(4,3,2,3) f = torch.rand(4,3,3,5) g = e@f # print(g) # print(g.shape) #可以看到,本质上也是二维矩阵相乘的规律 #clamp算法 print(c.clamp(4)) #把小于4的值全部都替换成4

3.6 tensor的统计相关操作

import torch #norm方法(求范数) a = torch.arange(10,dtype=float) b = a.view(2,5) print(a.norm(1)) print(b.norm(1)) print(a.norm(2,dtype=float)) #同理求二范数 print(b) print(b.norm(1,dim=1,dtype=float)) #求指定维度的范数 #求最大、最小、平均、求和 print(a.sum()) print(a.min()) print(a.max()) print(a.mean()) #top N的值 c = torch.tensor([1,2,3,3,4,4,4,5,5,5,5,6,8,8],dtype=float) print(c.topk(3)) print(c.topk(3, largest=False)) #找到前N最小的值 print(c.kthvalue(4)) #找到第k小的值 #比较 print(a>4) print(a!=8) #where cond = torch.tensor([[1,2],[3,4]],dtype=float) #用where组合2个tensor d = torch.zeros(2,2) e = torch.ones(2,2) print(torch.where(cond>2,d,e))

4. Tensor与计算图

PyTorch的Tensor结合了动态图模式,这意味着每一步运算都会被记录在后台的一个“计算图”中。当调用torch.autograd.backward()进行反向传播时,PyTorch会自动根据这个图来计算梯度。

关于计算图的说明可以参考我的另一篇博客:基于TorchViz详解计算图(附代码)

5. 结语

掌握PyTorch的Tensor是深度学习实践的第一步。了解其构造、操作和与计算图的互动,不仅能够提升我们的编程效率,更能使我们更好地理解和运用PyTorch这一强大工具,为深度学习项目的设计与实施打下坚实基础。在实际的深度学习项目中,Tensor不仅是数据的基本载体,更是实现复杂神经网络结构和优化算法的关键要素。