ModelScope有没有符合qwen-vl-chat-int4这个模型输出检测框的数据集样例?

根据现有知识库资料,ModelScope支持的模型中确实包括qwen-vl-chat-int4模型,并且该模型是基于通义千问Qwen-VL-Chat的量化版本。Qwen-VL-Chat本身是一个多模态大语言模型,能够以图像、文本和检测框作为输入,并输出文本和检测框。因此,qwen-vl-chat-int4模型也具备类似的能力。

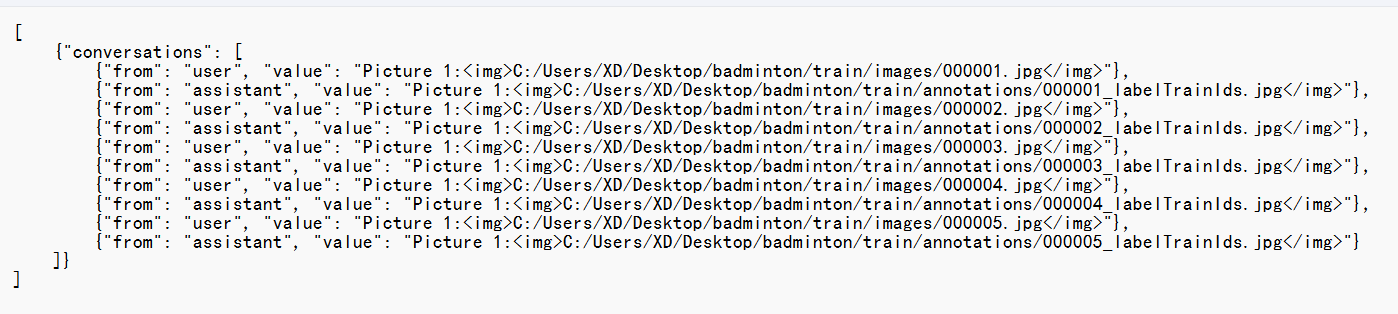

虽然知识库中没有直接提到qwen-vl-chat-int4模型的具体数据集样例,但可以参考Qwen-VL-Chat的相关背景信息。Qwen-VL-Chat支持以下交互方式: 1. 多图输入与问答:用户可以上传多张图片并进行多轮对话。 2. 检测框标注:模型能够生成或处理图片中的检测框信息。 3. 多语言支持:天然支持中文、英文等多语言对话。

为了验证模型的检测框输出能力,您可以使用以下方法获取相关样例: 1. 通过WebUI测试: - 部署qwen-vl-chat-int4模型后,启动WebUI服务。 - 在WebUI页面上传图片,并在对话框中输入与检测框相关的指令(例如“请标注图片中的物体”)。 - 模型会返回包含检测框的结果,您可以查看其输出格式和内容。

{

"input": {

"image": "base64_encoded_image",

"text": "请标注图片中的物体"

}

}

qwen-vl-chat-int4支持检测框输出,但其量化版本可能会在精度上略有损失。如果对检测框精度要求较高,建议使用非量化版本(如qwen-vl-chat)。ml.gu7i.c16m60.1-gu30),以确保推理性能稳定。如果您需要进一步的样例数据或具体操作指导,可以通过ModelScope平台的官方文档或社区获取更多支持。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352