flinkcdc pg到pg全量数据可以同步,update数据的时候checkpoint一直IN_PROGRESS状态,数据也没法更新,这是什么原因啊?

Tm日志有错误2024-04-15 15:04:29

Tm日志有错误2024-04-15 15:04:29

java.lang.IllegalAccessError: tried to access class io.debezium.embedded.EmbeddedEngineChangeEvent from class com.ververica.cdc.debezium.internal.DebeziumChangeConsumer

at com.ververica.cdc.debezium.internal.DebeziumChangeConsumer.commitOffset(DebeziumChangeConsumer.java:80)

at com.ververica.cdc.debezium.DebeziumSourceFunction.notifyCheckpointComplete(DebeziumSourceFunction.java:486)

at org.apache.flink.streaming.api.operators.AbstractUdfStreamOperator.notifyCheckpointComplete(AbstractUdfStreamOperator.java:126)

at org.apache.flink.streaming.runtime.tasks.StreamOperatorWrapper.notifyCheckpointComplete(StreamOperatorWrapper.java:104)

at org.apache.flink.streaming.runtime.tasks.RegularOperatorChain.notifyCheckpointComplete(RegularOperatorChain.java:145)

at org.apache.flink.streaming.runtime.tasks.SubtaskCheckpointCoordinatorImpl.notifyCheckpoint(SubtaskCheckpointCoordinatorImpl.java:479)

at org.apache.flink.streaming.runtime.tasks.SubtaskCheckpointCoordinatorImpl.notifyCheckpointComplete(SubtaskCheckpointCoordinatorImpl.java:413)

at org.apache.flink.streaming.runtime.tasks.StreamTask.notifyCheckpointComplete(StreamTask.java:1412)

at org.apache.flink.streaming.runtime.tasks.StreamTask.lambda$notifyCheckpointCompleteAsync$15(StreamTask.java:1353)

at org.apache.flink.streaming.runtime.tasks.StreamTask.lambda$notifyCheckpointOperation$18(StreamTask.java:1392)

at org.apache.flink.streaming.runtime.tasks.StreamTaskActionExecutor$SynchronizedStreamTaskActionExecutor.runThrowing(StreamTaskActionExecutor.java:93)

at org.apache.flink.streaming.runtime.tasks.mailbox.Mail.run(Mail.java:90)

at org.apache.flink.streaming.runtime.tasks.mailbox.MailboxProcessor.runMail(MailboxProcessor.java:398)

at org.apache.flink.streaming.runtime.tasks.mailbox.MailboxProcessor.processMailsWhenDefaultActionUnavailable(MailboxProcessor.java:367)

at org.apache.flink.streaming.runtime.tasks.mailbox.MailboxProcessor.processMail(MailboxProcessor.java:352)

at org.apache.flink.streaming.runtime.tasks.mailbox.MailboxProcessor.runMailboxLoop(MailboxProcessor.java:229)

at org.apache.flink.streaming.runtime.tasks.StreamTask.runMailboxLoop(StreamTask.java:831)

at org.apache.flink.streaming.runtime.tasks.StreamTask.invoke(StreamTask.java:780)

at org.apache.flink.runtime.taskmanager.Task.runWithSystemExitMonitoring(Task.java:935)

at org.apache.flink.runtime.taskmanager.Task.restoreAndInvoke(Task.java:914)

at org.apache.flink.runtime.taskmanager.Task.doRun(Task.java:728)

at org.apache.flink.runtime.taskmanager.Task.run(Task.java:550)

at java.lang.Thread.run(Thread.java:750)

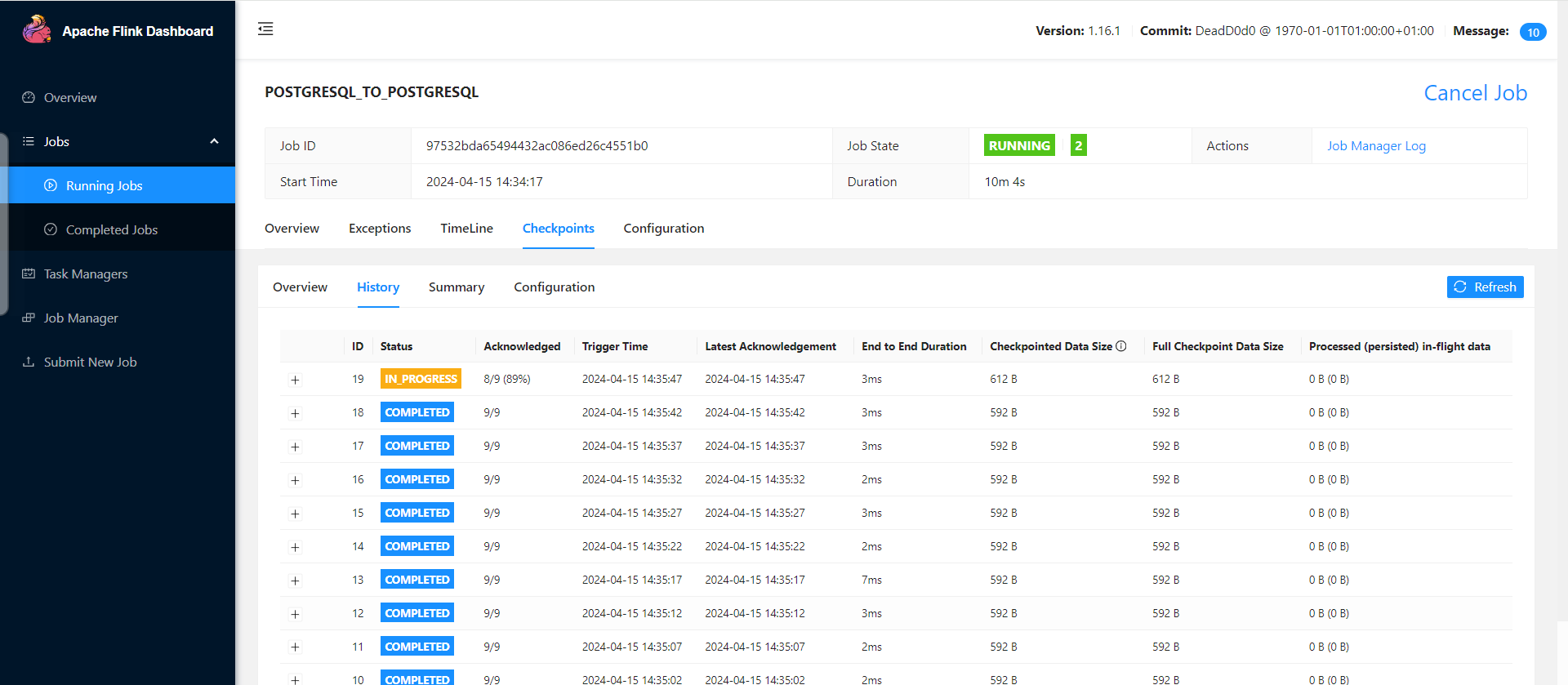

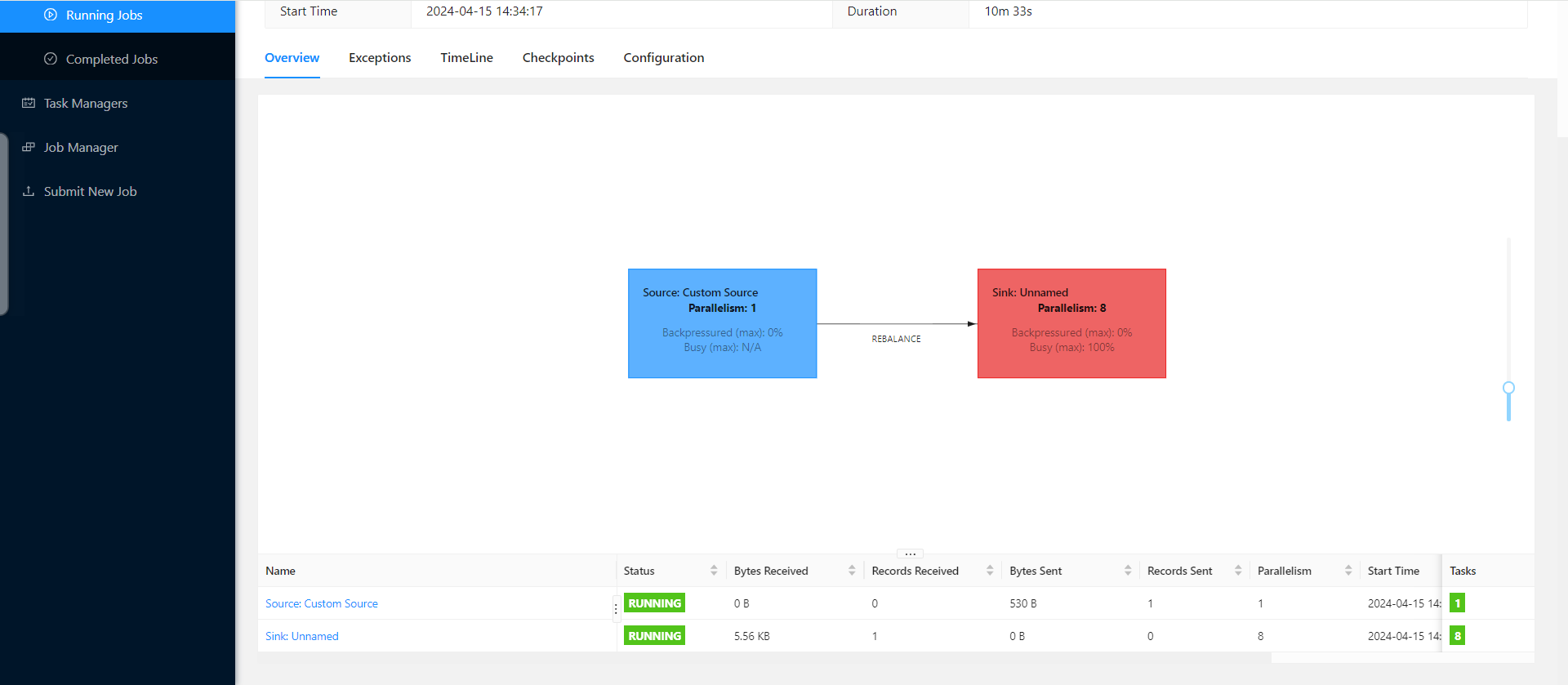

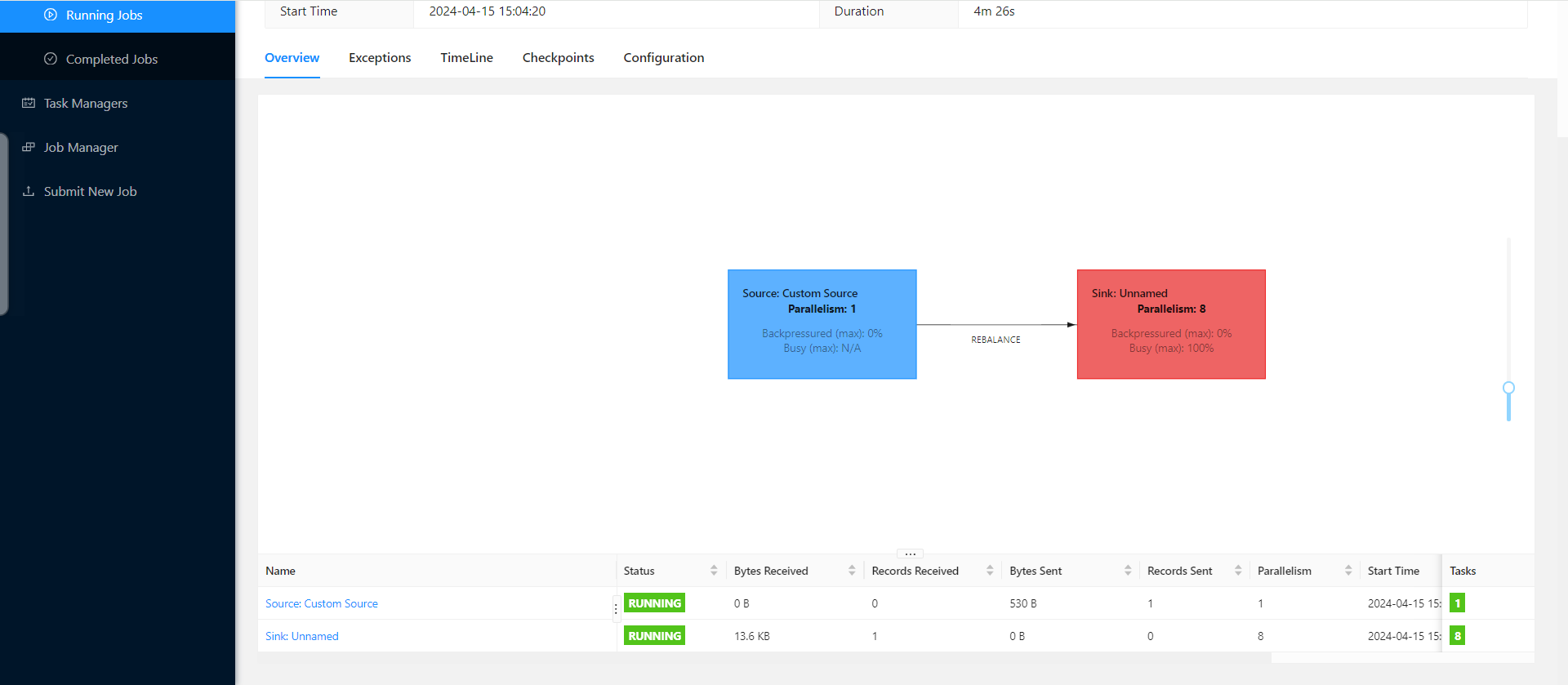

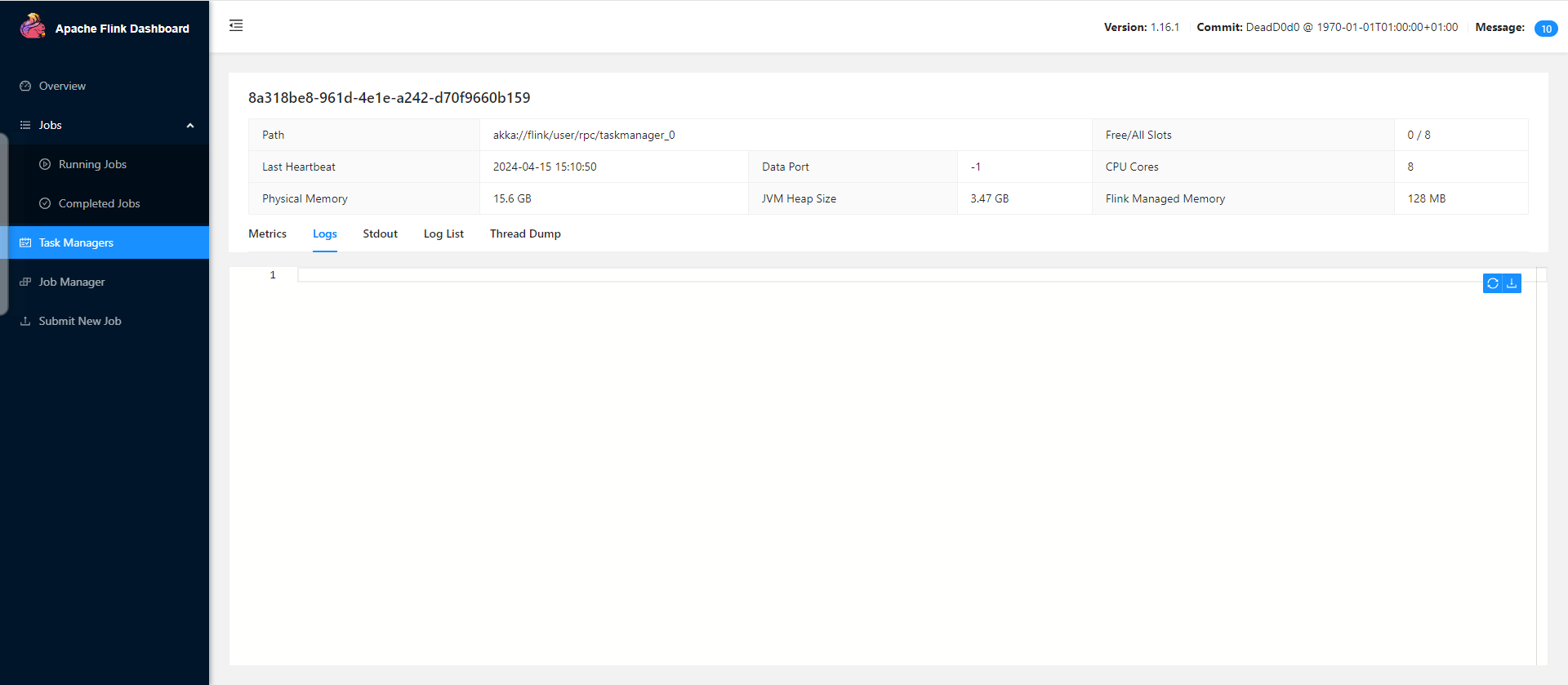

环境没有部署flink,直接datastream代码跑的,tm日志在哪里打开的啊?为啥我这空白?我换了个依赖不报错了,但是更新的时候checkpoint一直过不去为啥?sink是不是背压了?

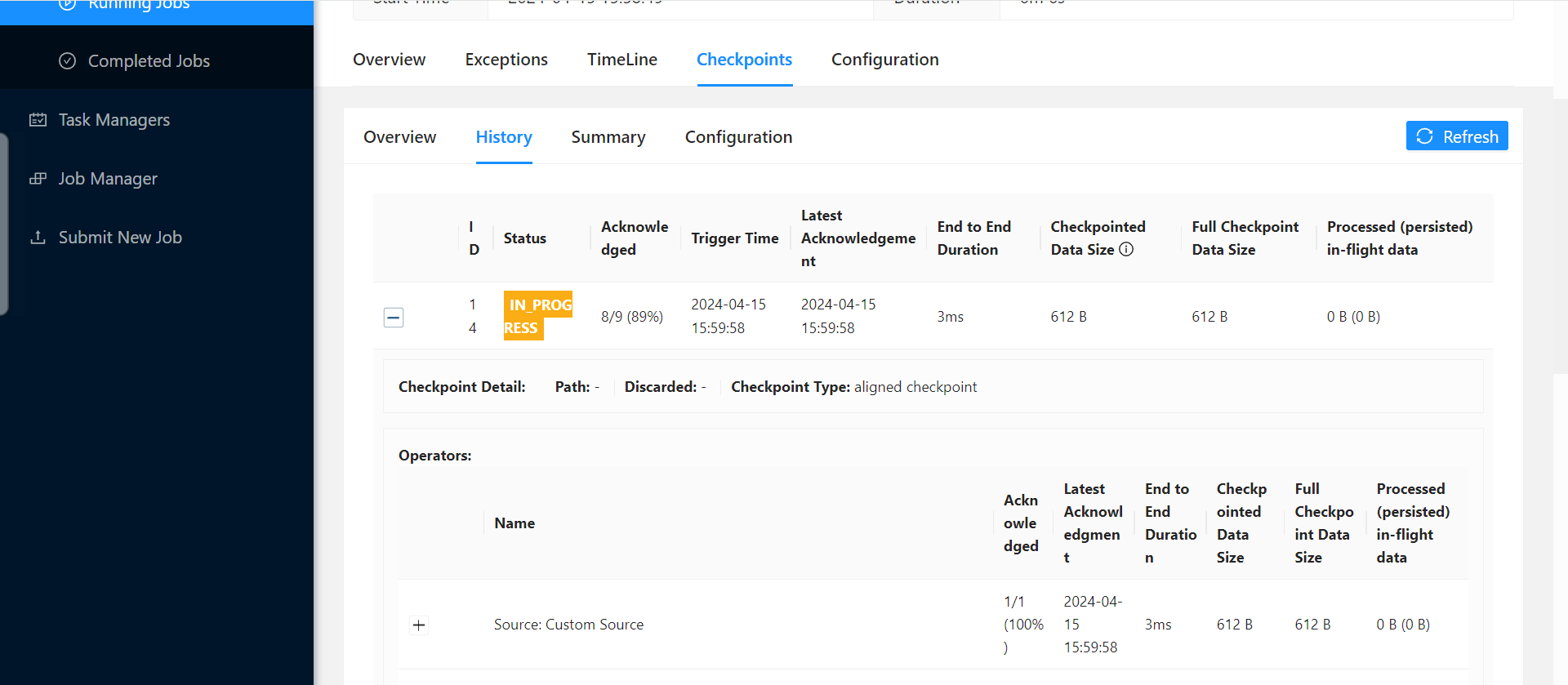

环境没有部署flink,直接datastream代码跑的,tm日志在哪里打开的啊?为啥我这空白?我换了个依赖不报错了,但是更新的时候checkpoint一直过不去为啥?sink是不是背压了? checkpoint一直不成功啊?

checkpoint一直不成功啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,以下是可能的原因及解决方案:

IN_PROGRESS 状态的原因Checkpoint 长时间处于 IN_PROGRESS 状态通常由以下原因导致:

背压(Backpressure)

如果下游 Sink 的处理能力不足,可能会导致数据积压,从而引发背压。背压会阻塞上游算子的处理,进而影响 Checkpoint 的完成。

解决方法: - 检查 Flink Web UI 中的背压监控指标,确认是否存在背压。 - 如果存在背压,可以尝试优化 Sink 的写入性能,例如增加并行度、调整批量写入大小等。

Debezium 嵌入式引擎的兼容性问题

您提到的错误日志中显示了 java.lang.IllegalAccessError,这表明可能存在依赖冲突或版本不兼容问题。Flink CDC 使用 Debezium 作为底层增量数据捕获工具,如果 Debezium 的版本与 Flink CDC 不匹配,可能会导致异常。

解决方法: - 确保使用的 Flink CDC 和 Debezium 版本是兼容的。建议参考官方文档,选择经过验证的版本组合。 - 如果您已经更换了依赖,请确保新依赖的版本与当前环境完全兼容。

Checkpoint 配置不合理

如果 Checkpoint 的时间间隔过短,或者状态数据量过大,可能会导致 Checkpoint 无法及时完成。

解决方法: - 调整 Checkpoint 的时间间隔,例如设置为 execution.checkpointing.interval=30s。 - 启用增量 Checkpoint(Incremental Checkpoint),以减少每次 Checkpoint 的开销。

TM(TaskManager)日志为空白可能是由于以下原因:

日志路径配置错误

如果未正确配置日志路径,日志文件可能未生成或存储在其他位置。

解决方法: - 检查 log4j.properties 或 logback.xml 文件中的日志路径配置,确保日志输出路径正确。 - 默认情况下,Flink 的日志文件通常位于 $FLINK_HOME/log 目录下。

运行环境问题

如果您未部署 Flink 集群,而是直接运行 DataStream 代码,可能会导致日志输出被重定向到控制台或其他位置。

解决方法: - 在本地运行时,可以通过 IDE 的控制台查看日志输出。 - 如果需要更详细的日志信息,可以在代码中显式添加日志记录器(如 Log4j 或 SLF4J)。

除了上述背压和依赖问题外,更新数据时 Checkpoint 无法完成还可能与以下因素有关:

Sink 写入性能瓶颈

如果目标 PostgreSQL 数据库的写入性能不足,可能会导致 Sink 端积压,进而影响 Checkpoint 的完成。

解决方法: - 增加 Sink 的并行度,分散写入压力。 - 调整 PostgreSQL 的配置参数(如 max_connections 和 work_mem),以提高写入性能。

事务未提交

如果 Sink 端的事务未及时提交,可能会导致 Checkpoint 无法完成。

解决方法: - 检查 Sink 端的事务管理逻辑,确保事务能够及时提交。 - 如果使用的是 JDBC Sink,可以尝试调整批量写入大小(batch.size)和提交间隔(batch.interval)。

以下是具体的排查步骤:

检查背压情况

验证依赖版本

调整 Checkpoint 配置

30s。优化 Sink 性能

batch.size 和 batch.interval。查看详细日志

PostgreSQL 备库限制

根据知识库资料,PostgreSQL 备库本身不支持读取增量数据。如果您尝试从备库同步增量数据,可能会导致失败。建议使用主库进行增量同步。

Python UDF 性能问题

如果您的作业中包含 Python UDF,可能会因为缓存数据过多而导致 Checkpoint 变慢。可以通过调整以下参数优化性能:

python.fn-execution.bundle.size=50000

python.fn-execution.bundle.time=500

根据您的描述,问题可能涉及背压、依赖冲突、Checkpoint 配置不合理或 Sink 性能瓶颈。建议按照上述步骤逐一排查,并重点关注背压和依赖版本的兼容性问题。如果问题仍未解决,请提供更详细的日志信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。