"

为什么modelscope还没开始推理GPU就被沾满了?

"

在ModelScope(阿里云的模型开放平台)中,GPU内存被占用满可能是由于以下几个原因:

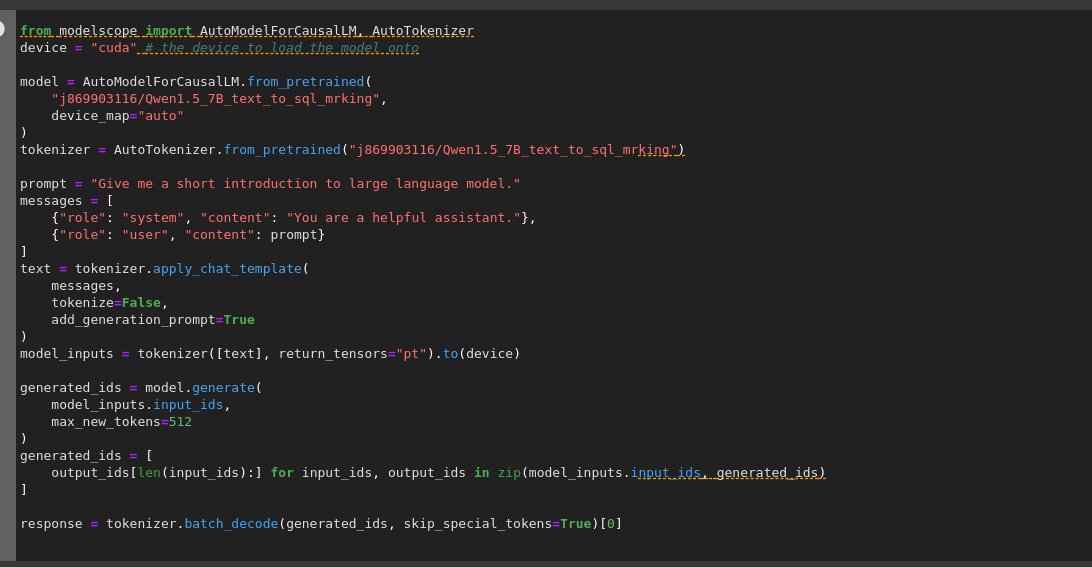

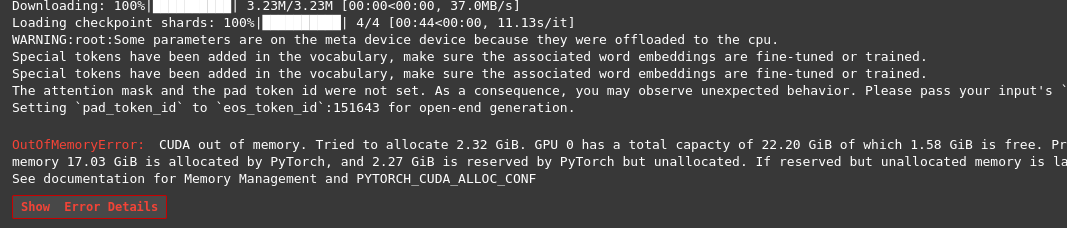

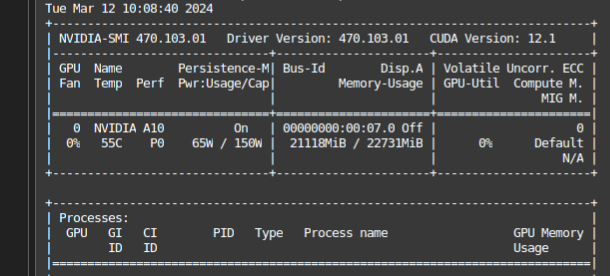

初始化和加载模型:深度学习模型特别是大型预训练模型,在初始化时可能会一次性加载整个模型参数到GPU显存中,导致显存被占满。即使尚未开始推理,仅仅是加载模型就可能占用大量显存。

默认配置:某些情况下,服务端或框架在启动时为了加速后续推理过程,会预先分配尽可能多的GPU资源,以便模型运行过程中不需要额外的时间进行内存分配。

资源管理问题:如果模型或者任务调度没有正确地释放之前计算所占用的资源,可能导致GPU显存累积占用直至满载。

并行处理:如果你同时使用多个GPU,且每个GPU都被分配了模型副本或任务,那么所有GPU的内存都可能会被迅速填满。

内存泄漏:代码中可能存在内存泄漏,即程序未能正确释放不再使用的GPU内存,从而导致显存持续增长。

要解决这个问题,可以尝试以下措施:

请参照ModelScope官方文档或技术支持获取具体的解决方案。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352