在modelscope-funasr如果使用GPU的话这个编译需要改什么?

在ModelScope-FunASR中使用GPU进行编译时,需要对环境和配置进行一些调整以确保能够充分利用GPU的计算能力。以下是具体的操作步骤和注意事项:

在使用GPU之前,请确保您的环境满足以下条件: - Python版本:需要安装Python 3.7或更高版本。 - PyTorch版本:FunASR依赖于PyTorch,因此需要安装支持GPU的PyTorch版本。可以通过以下命令安装支持CUDA的PyTorch:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

注意:请根据您的CUDA版本选择合适的PyTorch安装命令。例如,

cu118表示CUDA 11.8版本。如果不确定CUDA版本,可以运行nvidia-smi命令查看。

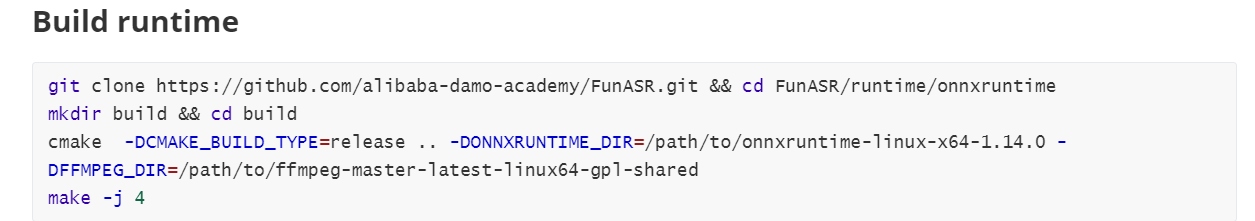

按照以下步骤安装FunASR并启用GPU支持: 1. 克隆代码仓库:

git clone https://github.com/alibaba-damo-academy/FunASR.git

cd FunASR

安装依赖包: 在安装依赖时,确保所有依赖都支持GPU加速。运行以下命令安装依赖:

pip install -r requirements.txt

安装FunClip: FunClip是FunASR中的语音合成工具包,支持GPU加速。通过以下命令安装:

pip install funasr[clip]

验证安装: 安装完成后,运行以下命令验证FunClip是否成功安装并支持GPU:

python -c "import funasr.utils.cli_utils; funasr.utils.cli_utils.print_info()"

如果输出显示FunClip已成功安装,并且PyTorch检测到可用的GPU,则说明配置正确。

在使用FunASR时,默认情况下会自动检测并使用可用的GPU。如果需要手动指定GPU设备或调整相关参数,可以参考以下方法:

设置环境变量: 在运行脚本前,可以通过设置CUDA_VISIBLE_DEVICES环境变量来指定使用的GPU设备。例如:

export CUDA_VISIBLE_DEVICES=0

上述命令表示仅使用编号为0的GPU。

修改启动脚本: 如果您使用的是自定义启动脚本(如server.py),可以在脚本中添加以下代码以确保模型加载到GPU上:

import torch

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

调整推理参数: 在调用FunASR的推理接口时,可以通过参数指定使用GPU。例如:

from funasr import AutoModel

model = AutoModel(model="your_model_name", device="cuda")

torch.distributed模块实现多GPU分布式训练或推理。通过以上步骤,您可以成功在ModelScope-FunASR中启用GPU支持,并充分利用GPU的计算能力来加速语音处理任务。