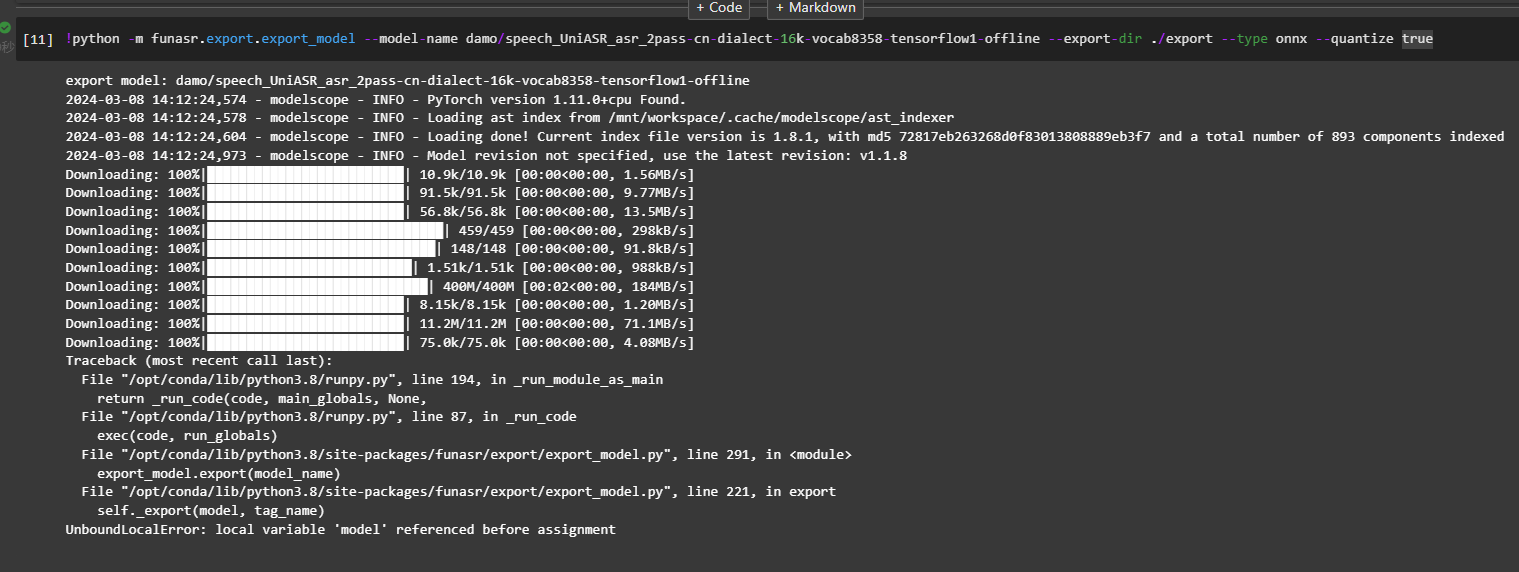

modelscope-funasr这个问题怎么解决?这个UniASR语音识别-中文方言-通用-16k-离线模型,iic/speech_UniASR_asr_2pass-cn-dialect-16k-vocab8358-tensorflow1-offline能不能导出成onnx后, 在funasr-runtime-sdk-cpu-0.4.3这个cpu服务里用呢?用的modelscope的jupyter环境funasr==0.7.1modelscope==1.8.1torch==1.11.0+cpu执行onnx导出命令的时候遇到了问题

模型地址: https://www.modelscope.cn/models/iic/speech_UniASR_asr_2pass-cn-dialect-16k-vocab8358-tensorflow1-offline/summary

要解决您提到的问题,即将iic/speech_UniASR_asr_2pass-cn-dialect-16k-vocab8358-tensorflow1-offline模型导出为ONNX格式并在funasr-runtime-sdk-cpu-0.4.3中使用,以下是详细的分析和解决方案:

根据您提供的信息,目标模型是基于TensorFlow 1.x的离线语音识别模型。而funasr-runtime-sdk-cpu-0.4.3是一个支持ONNX格式的运行时环境。因此,将模型从TensorFlow 1.x转换为ONNX格式是关键步骤。

需要注意的是: - TensorFlow 1.x模型通常需要通过tf2onnx工具进行转换。 - 转换过程中可能会遇到以下问题: - 模型中可能存在不支持的操作(Ops),导致转换失败。 - 需要确保模型的输入输出格式与ONNX兼容。

建议操作: 1. 确保安装了tf2onnx工具,并且版本与TensorFlow 1.x兼容。

pip install tf2onnx

使用tf2onnx工具尝试导出模型:

python -m tf2onnx.convert --saved-model <path_to_saved_model> --output model.onnx --opset 13

其中,<path_to_saved_model>是目标模型的路径,--opset 13指定了ONNX的算子集版本。

如果转换失败,请检查错误日志,确认是否存在不支持的操作。如果存在,可能需要手动修改模型或寻找替代方案。

funasr-runtime-sdk-cpu-0.4.3中使用ONNX模型假设成功将模型导出为ONNX格式,接下来需要验证其是否可以在funasr-runtime-sdk-cpu-0.4.3中运行。

重要前提: - funasr-runtime-sdk-cpu-0.4.3对ONNX模型的支持依赖于其内部实现。请确保该SDK支持您导出的ONNX模型的算子集和输入输出格式。 - 如果SDK对模型有特定要求(如输入形状、数据类型等),需要在导出ONNX模型时进行调整。

建议操作: 1. 将导出的ONNX模型加载到funasr-runtime-sdk-cpu-0.4.3中,测试其推理功能。

import onnxruntime as ort

# 加载ONNX模型

session = ort.InferenceSession("model.onnx")

# 测试推理

inputs = {"input_name": input_data} # 替换为实际输入名称和数据

outputs = session.run(None, inputs)

print(outputs)

onnxruntime支持。TensorFlow 1.x模型可能包含复杂的自定义操作,这些操作在tf2onnx中可能无法直接支持。如果遇到此类问题,可以尝试以下方法: - 使用TensorFlow 2.x重新实现模型,并利用tf2onnx进行转换。 - 寻找社区中是否有类似模型的ONNX版本。

funasr-runtime-sdk-cpu-0.4.3的兼容性如果funasr-runtime-sdk-cpu-0.4.3对ONNX模型有特定限制(如仅支持某些算子集或输入格式),需要根据其文档调整模型导出参数。

tf2onnx工具将TensorFlow 1.x模型转换为ONNX格式,注意检查不支持的操作并进行调整。funasr-runtime-sdk-cpu-0.4.3中加载并测试ONNX模型,确保其推理功能正常。特别提醒:

由于iic/speech_UniASR_asr_2pass-cn-dialect-16k-vocab8358-tensorflow1-offline模型的具体结构未完全公开,可能存在未知的兼容性问题。建议联系ModelScope团队获取更多技术支持。

希望以上解答能够帮助您解决问题!