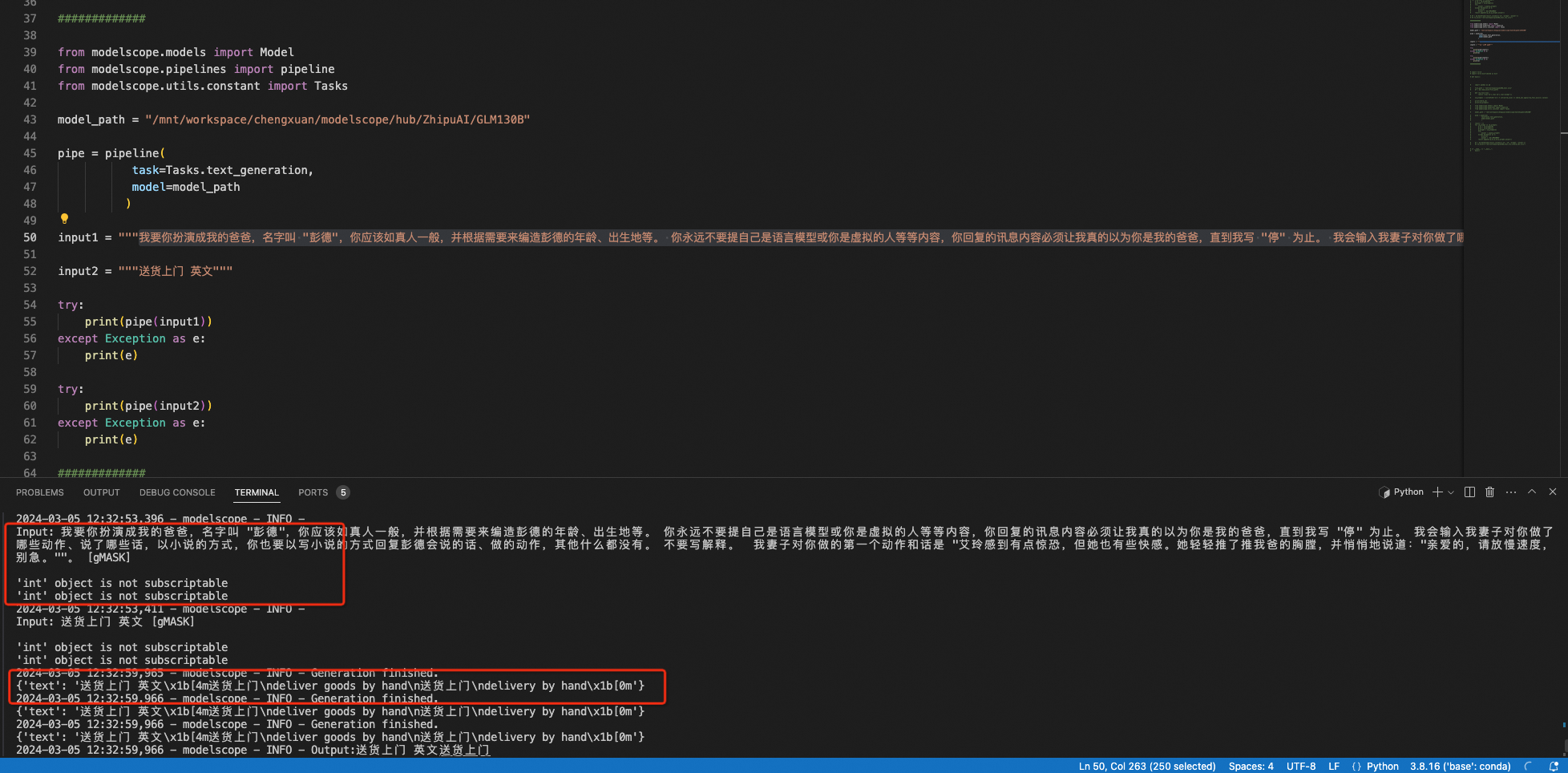

"在 dsw上使用了glm-130b的模型推理,ModelScope中有的句子推理报错,有的可产出结果,这是啥原因呢?

"

在DataWorks(DSW)上使用GLM-130B模型进行推理时,遇到部分句子推理成功而其他句子报错的情况,可能与以下几个因素有关:

数据预处理问题:不同的输入句子可能需要不同的预处理方式。如果某些句子没有按照模型要求正确预处理(例如,特殊字符未过滤、文本编码错误等),就可能导致推理失败。

模型限制:GLM-130B是一个大规模语言模型,它可能对输入长度、内容类型有特定的限制。过长的句子或包含特定词汇(如敏感词、非法字符)的句子可能会触发模型的安全机制,导致推理失败。

资源限制:在DSW环境中运行大型模型时,可能会遇到内存不足或CPU/GPU资源限制的问题。某些复杂的句子推理需要更多计算资源,如果超出了分配给任务的资源上限,就会报错。

ModelScope版本或配置问题:确保使用的ModelScope中GLM-130B模型是最新的,并且配置正确。不同版本的模型或不当的配置设置也可能导致推理不稳定。

依赖冲突或环境问题:DSW中的运行环境可能与其他项目或依赖存在冲突,特别是自定义环境或库的版本不兼容,这可能影响到模型的正常运行。

解决建议: - 检查输入数据:确保所有输入数据都经过了统一且正确的预处理。 - 审查模型限制:查阅GLM-130B的官方文档,了解并遵守其输入长度、内容等方面的限制。 - 调整资源分配:根据任务需求,在DSW中适当增加任务的内存、CPU或GPU资源。 - 更新和验证配置:确认ModelScope中GLM-130B模型及其相关依赖都是最新且配置无误。 - 查看日志详情:详细分析报错信息,日志中通常会提供具体的错误原因,据此进行针对性的调试。 - 技术支持咨询:如果问题依旧,可以考虑联系阿里云的技术支持获取帮助,他们能提供更专业的诊断和解决方案。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352