Flink CDC里1.18 planner使用哪个版本?我看有个planner-loader和一个指定scala版本的。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Apache Flink 1.18版本的Flink CDC通常会指定一个与之兼容的Table & SQL Planner。从Flink 1.11开始,Flink引入了 Blink Planner作为默认的SQL执行引擎,它提供了更好的性能和更丰富的特性。

对于Flink CDC,在使用Flink 1.18时,你应该选择与该版本兼容且性能最优的Planner。在配置Flink CDC作业时,并不需要直接指定planner-loader,因为这是在启动Flink集群或者提交Flink作业时通过全局配置来决定的。

关于Scala版本,Flink发行版通常会提供针对不同Scala版本的构建,比如2.11或2.12。在集成Flink CDC到项目中时,需要确保使用的Scala版本与Flink发行版中的Scala版本保持一致。

具体来说,在构建或运行Flink CDC作业时,请参考以下步骤:

flink-conf.yaml配置文件中,无需特别设置 planner-loader,只需正确配置Flink CDC相关的连接器、源表和目标表等信息即可。Flink CDC 1.18版本通常需要与Flink 1.18版本的Planner相配套使用。

在Apache Flink中,Planner是负责生成查询执行计划的组件。从1.18版本开始,Flink对Planner进行了更新,增加了新的功能和改进。因此,如果要在Flink中使用CDC(Change Data Capture)并且指定了1.18版本,那么应该确保使用的Planner版本与Flink 1.18版本兼容。通常情况下,Flink的每个主要版本都会包含一个与之兼容的Planner版本,以确保整个系统的稳定性和功能的完整性。

此外,Flink还提供了一个称为“planner-loader”的机制,它允许用户在运行时动态加载不同版本的Planner。这样做的好处是可以在不重启作业的情况下升级或切换Planner版本。但是,这通常需要用户有一定的经验来处理可能出现的版本兼容性问题。

至于Scala版本的指定,Flink是用Scala编写的,因此在使用Flink时需要指定Scala的版本。Flink 1.18版本通常会推荐使用某一特定版本的Scala,以确保兼容性。在选择Scala版本时,应参考官方文档或者社区的指导,以选择与Flink 1.18版本兼容的Scala版本。

综上所述,为了确保Flink CDC 1.18能够正常工作,需要使用与之兼容的Flink 1.18版本的Planner,并根据官方推荐选择合适的Scala版本。在实际操作中,应当参考Flink官方文档或者社区的建议,以便正确配置环境。

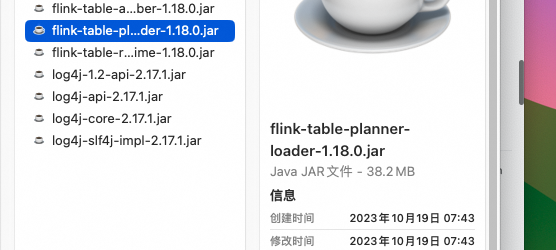

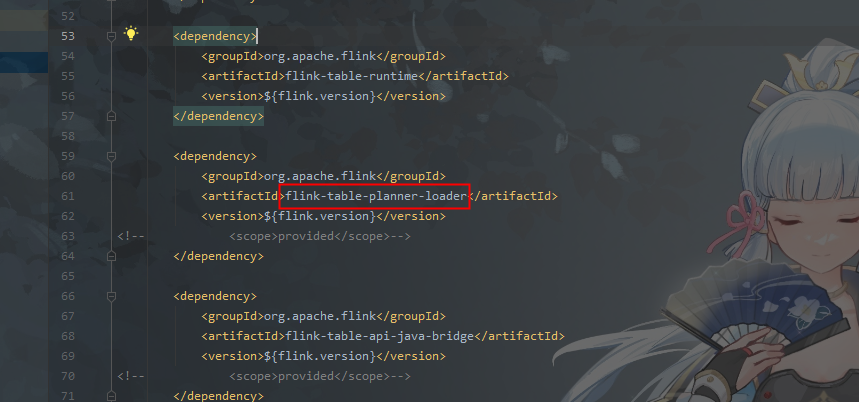

我记得是如果不用hive的话,默认的这个就行了。 1.18要使用planner loader这个,然后也要额外添加runtime依赖,指定scala的那个planner内部依赖的某个类方法不太对。

1.18要使用planner loader这个,然后也要额外添加runtime依赖,指定scala的那个planner内部依赖的某个类方法不太对。 此回答来自钉群Flink CDC 社区。

此回答来自钉群Flink CDC 社区。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。