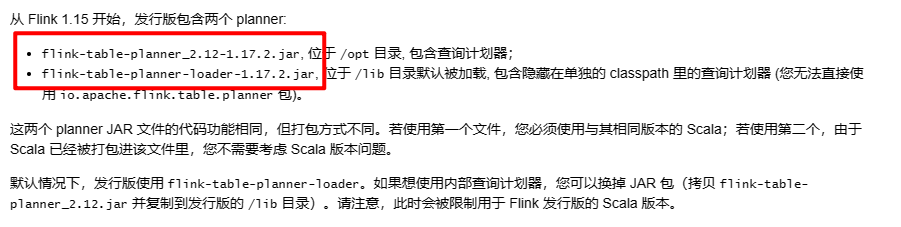

Flink CDC两个planner包,用loader包,tableAPI应该咋使用呀?

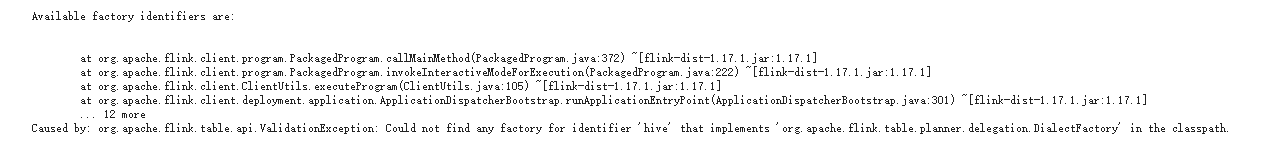

用loader不用前面那个就会报这个错,有人遇到过不

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC时,如果需要通过loader包来加载连接器,并结合Table API进行开发,您可能会遇到一些配置或依赖相关的问题。以下是针对您问题的详细解答和操作步骤:

根据您的描述,您在使用Flink CDC时选择了loader包(即ververica-classloader相关的JAR包),但未正确配置或加载连接器时出现了错误。这通常与以下原因有关: - 依赖冲突:Flink CDC连接器的依赖未正确管理,导致类加载冲突。 - ClassLoader配置不当:未正确设置loader包的类加载路径。 - Table API与连接器的兼容性问题:某些连接器可能需要额外的配置才能与Table API配合使用。

在本地运行和调试包含连接器的作业时,必须确保所有依赖的JAR包都已正确加载。具体操作如下: 1. 下载必要的JAR包: - 下载ververica-classloader相关的JAR包(如ververica-classloader-1.15-vvr-6.0-SNAPSHOT.jar)。 - 下载Flink CDC连接器的uber JAR包(如flink-sql-connector-mysql-cdc-2.1.0.jar)。 2. 配置pipeline.classpaths: 在代码中创建环境时,增加pipeline.classpaths配置,指定uber JAR的路径。例如:

Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/your-connector-uber.jar");

EnvironmentSettings envSettings = EnvironmentSettings.newInstance().withConfiguration(conf).build();

TableEnvironment tEnv = TableEnvironment.create(envSettings);

注意:该配置仅用于本地调试,在上传到阿里云实时计算Flink版之前需删除。

为了使Flink能够正确加载连接器的运行类,需将ververica-classloader的JAR包添加到运行时的类加载路径中。以IntelliJ IDEA为例,操作步骤如下: 1. 打开运行配置窗口,点击“Modify options”,勾选“Modify classpath”。 2. 在新增的“Modify classpath”栏中,点击“+”号,选择下载的ververica-classloader JAR包。 3. 保存运行配置。

在使用Table API时,确保SQL语句与连接器的配置一致。例如,对于MySQL CDC Source,tableList选项需要包含数据库名和表名:

CREATE TABLE mysql_source (

id INT,

name STRING,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-hostname',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table'

);

重要提示:tableList选项的值格式为yourDatabaseName.yourTableName,而不是DataStream API中的表名。

如果仍然报错,可能是由于依赖冲突导致的。建议采取以下措施: 1. 排除冲突依赖: 在Maven项目的pom.xml中,对Flink相关依赖添加<scope>provided</scope>,避免重复引入。例如:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>1.15.0</version>

<scope>provided</scope>

</dependency>

janino)版本与Flink兼容。如果存在类冲突,可以通过以下参数解决:

classloader.parent-first-patterns.additional: org.codehaus.janino

如果出现java.lang.NoSuchMethodError,通常是由于依赖版本不匹配或使用了非公开API。解决方法如下: - 确保只调用Flink中明确标注为@Public或@PublicEvolving的方法。 - 检查Flink CDC连接器的版本是否与Flink版本兼容。

如果出现org.codehaus.janino.CompilerFactory cannot be cast to org.codehaus.commons.compiler.ICompilerFactory,说明存在类加载冲突。解决方法如下: - 在运行参数中添加以下配置:

classloader.parent-first-patterns.additional: org.codehaus.janino

如果报错Failed to create the job graph for the job,可能是自定义连接器未正确上传到OSS。解决方法如下: - 将自定义连接器上传到OSS,并确保作业能够正常访问。

pipeline.classpaths和ververica-classloader配置正确,避免依赖冲突。如果您仍有疑问或遇到其他问题,请提供更多报错信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。