ModelScope中pipline构建的时候貌似只传cpu或者gpu怎么设置?

ModelScope中pipline构建的时候貌似只传cpu或者gpu怎么设置?

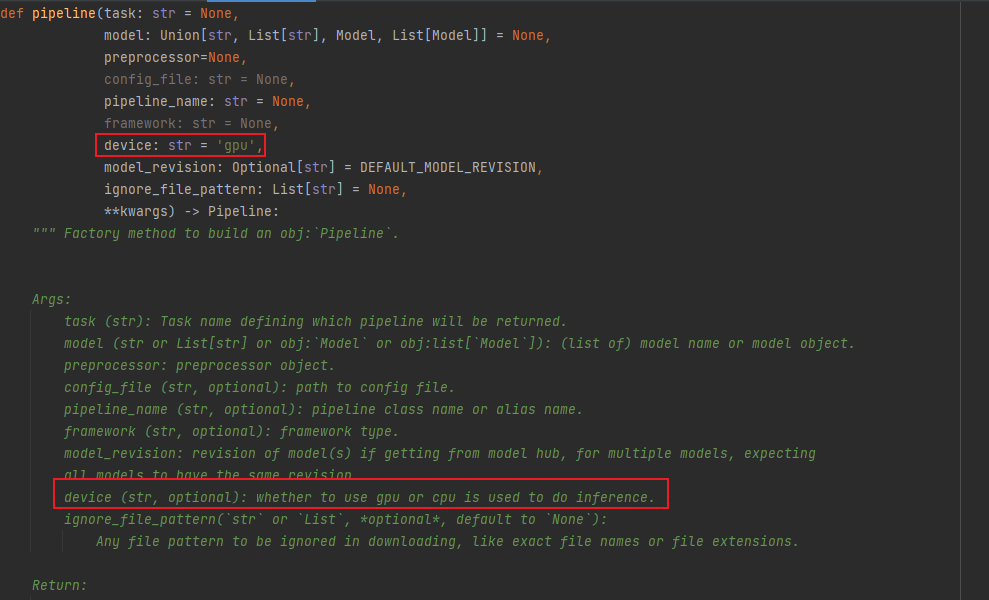

在ModelScope中,通过Pipeline构建模型时,如果需要指定计算资源(如CPU或GPU),可以通过设置设备参数来实现。以下是详细的配置方法和操作步骤:

在ModelScope中,Pipeline的设备参数通常通过device字段进行配置。该字段用于指定模型运行的硬件设备,支持以下两种主要选项: - CPU:将模型加载到CPU上运行。 - GPU:将模型加载到GPU上运行。

具体配置方式如下:

from modelscope.pipelines import pipeline

# 指定使用CPU

pipe = pipeline('task_name', model='model_id', device='cpu')

# 指定使用GPU(默认使用第0号GPU)

pipe = pipeline('task_name', model='model_id', device='cuda:0')

如果您的环境中存在多个GPU,可以通过cuda:<gpu_id>的方式指定具体的GPU设备。例如:

# 使用第1号GPU

pipe = pipeline('task_name', model='model_id', device='cuda:1')

如果您希望利用所有可用的GPU进行分布式推理,则需要结合框架的分布式功能(如PyTorch的torch.distributed模块)进行额外配置。

ModelScope还支持自动检测可用设备的功能。如果未显式指定device参数,Pipeline会根据当前环境自动选择设备: - 如果检测到GPU,则优先使用GPU。 - 如果未检测到GPU,则默认使用CPU。

示例代码如下:

# 自动选择设备

pipe = pipeline('task_name', model='model_id')

--gpus参数来指定GPU资源。例如:

docker run --gpus '"device=0"' -it your_image_name

具体操作可参考ECS实例中NVIDIA Container Toolkit的配置方法。

通过上述方法,您可以灵活地在ModelScope中为Pipeline指定计算设备(CPU或GPU)。根据实际需求选择合适的设备配置,能够显著提升模型推理性能,尤其是在处理大规模模型时。

如果您有更多关于设备配置的具体问题,欢迎进一步咨询!

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352