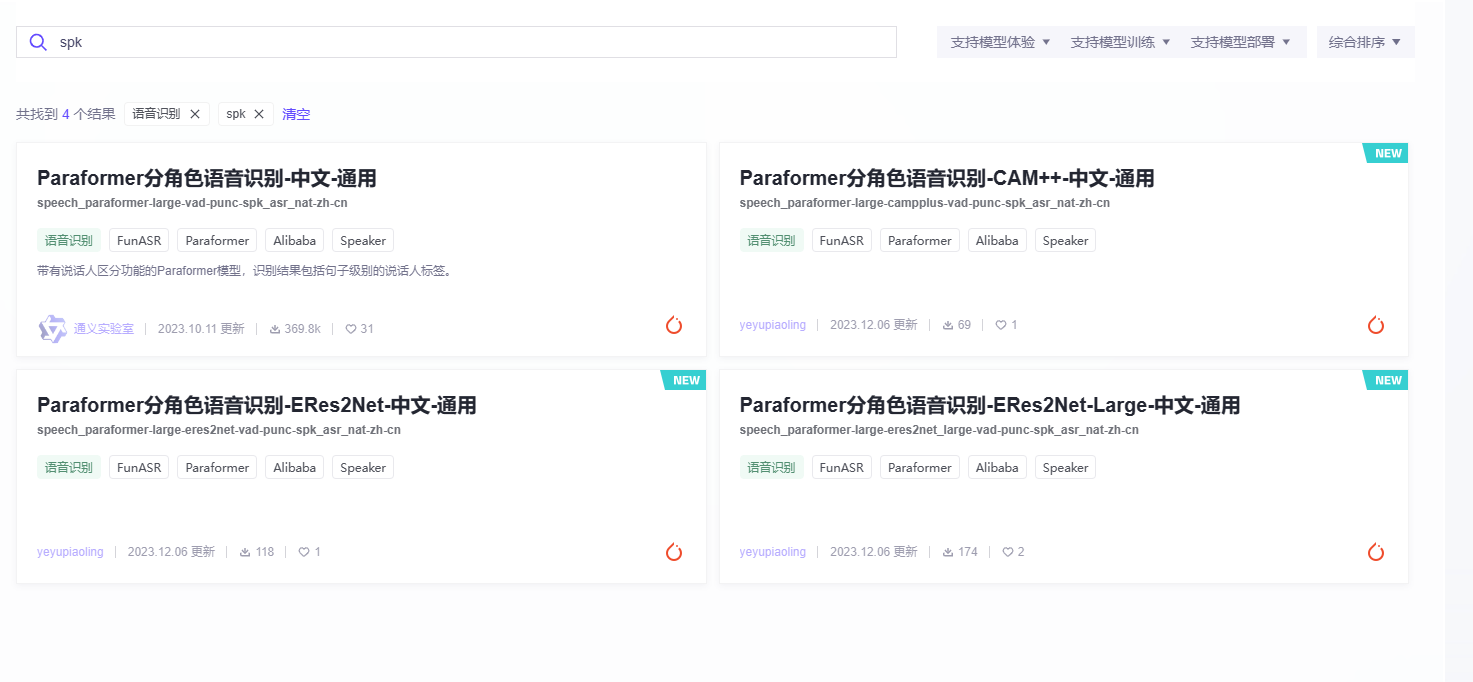

modelscope-funasr 怎么使用可以识别说话人的模型?

要使用其他模型,您可以按照以下步骤进行操作:

首先,确保您已经正确安装了ModelScope-FunASR所需的依赖库和工具。您可以在ModelScope-FunASR的GitHub仓库中查看安装说明。

下载并准备您想要使用的模型文件。通常,这些模型文件是以特定的格式(如ONNX、TensorFlow等)保存的。请确保您已经获得了适用于ModelScope-FunASR的模型文件。

在您的应用程序中,使用适当的API或SDK加载并配置您选择的模型。具体的加载和配置方法可能因您选择的模型类型而有所不同。例如,如果您使用的是ONNX模型,可以使用ONNX运行时来加载和运行模型;如果您使用的是TensorFlow模型,可以使用TensorFlow的加载和运行功能。

根据您的需求,对输入数据进行预处理并将其传递给模型进行推理。这可能涉及到将音频数据转换为特征向量、添加额外的上下文信息等操作。具体的预处理方法取决于您选择的模型和应用场景。

获取模型的输出结果并进行后处理。根据您选择的模型和应用场景,可能需要对模型的输出结果进行进一步的处理,以获得最终的结果。例如,您可以对识别到的文字进行后处理,如去除停用词、纠错等。

请注意,以上步骤仅为一般指导,具体操作可能因您选择的模型类型、编程语言和应用场景而有所不同。建议您参考相关文档和示例代码,以便更好地理解和使用其他模型与ModelScope-FunASR集成。

Modelscope-FunASR是一个开源的语音识别框架,它支持多种模型的训练和推理。要使用其他模型,你可以按照以下步骤操作:

选择一个模型:首先,你需要选择一个你想要使用的模型。这个模型应该是一个语音识别模型,并且应该支持PyTorch或者TensorFlow框架。你可以从各种开源库中找到这样的模型,例如Kaldi、DeepSpeech、ESPnet等。

获取模型文件:找到模型的权重文件(通常是一个.pth或.ckpt文件),这是模型的训练结果,包含了模型的所有参数。

导入模型:在Python中,你可以使用PyTorch或TensorFlow的API来导入模型。例如,如果你使用的是PyTorch,你可以使用torch.load()函数来加载模型权重,然后使用torch.nn.DataParallel()来并行处理多个GPU。

准备数据:你需要准备一些音频数据来测试模型。这些数据可以是wav文件,也可以是音频流。你需要将音频数据转换为模型可以接受的格式。

进行推理:使用模型进行推理,将音频数据转换为文本。这通常涉及到将音频数据输入到模型中,然后模型会输出一些文本。

评估模型:最后,你可以评估模型的性能。这可以通过比较模型的输出和真实文本来实现。

以上就是使用Modelscope-FunASR使用其他模型的基本步骤。需要注意的是,不同的模型可能需要不同的预处理和后处理步骤,因此你可能需要查阅模型的文档来了解具体的用法。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352