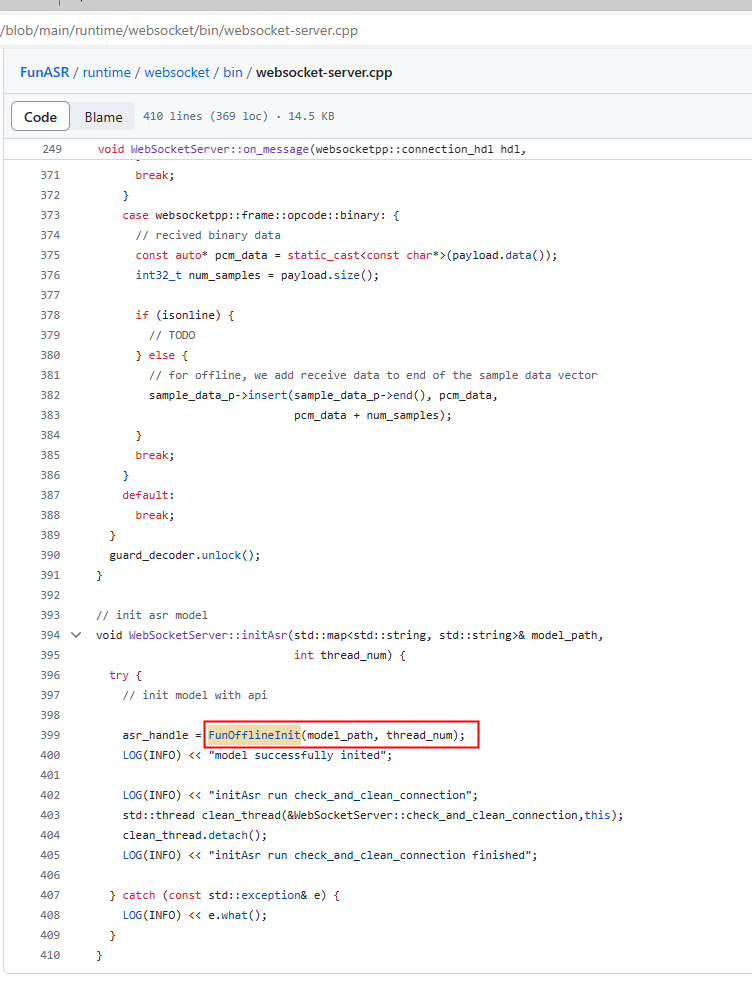

图中modelscope-funasr这个函数的定义在哪里?就是我想把这个模型部署到tensorRT上,或者其他边缘设备上呢?

图中modelscope-funasr这个函数的定义在哪里?就是我想把这个模型部署到tensorRT上,或者其他边缘设备上呢?

根据您提供的问题和知识库中的参考资料,以下是关于如何将modelscope-funasr模型部署到TensorRT或其他边缘设备上的详细解答:

在部署之前,首先需要确认modelscope-funasr模型是否支持TensorRT或目标边缘设备的执行框架。根据知识库中的信息: - TensorRT-LLM对模型的支持存在版本限制,具体支持情况可以通过tensorrt_llm/examples中的说明文档查看。 - 如果modelscope-funasr模型未明确列出在支持矩阵中,则可能需要手动转换模型格式以适配TensorRT。

建议操作: - 检查modelscope-funasr模型的官方文档,确认其是否提供TensorRT兼容的版本。 - 如果不支持,可以尝试使用NVIDIA提供的工具(如trtexec)将模型转换为TensorRT格式。

为了部署模型,您需要从ModelScope平台下载modelscope-funasr模型的权重文件和相关代码。根据知识库中的描述: - 您可以通过ModelScope平台获取模型的MODEL_ID、TASK和REVISION信息,并保存到本地。 - 如果模型是非公开的,还需要获取SDK访问令牌(ACCESS_TOKEN),并将其配置到环境变量中。

操作步骤: 1. 登录ModelScope平台,找到modelscope-funasr模型页面。 2. 获取以下信息: - MODEL_ID:模型的唯一标识符。 - TASK:模型的任务类型(例如语音识别)。 - REVISION:模型的具体版本号(例如v1.0.0)。 3. (可选)如果模型需要访问令牌,请在ModelScope首页的左侧导航栏中获取SDK访问令牌。

如果modelscope-funasr模型本身不支持TensorRT,您需要将其转换为TensorRT兼容的格式。根据知识库中的信息: - 转换过程通常涉及将原始模型文件(如PyTorch或ONNX格式)转换为TensorRT引擎文件(.engine)。 - 转换示例可以参考构建TensorRT LLM模型的相关文档。

操作步骤: 1. 确保已安装NVIDIA TensorRT工具链和相关依赖。 2. 使用以下命令将模型转换为TensorRT格式:

trtexec --onnx=<path_to_onnx_model> --saveEngine=<output_engine_file>

其中: - <path_to_onnx_model>:原始ONNX模型文件路径。 - <output_engine_file>:生成的TensorRT引擎文件路径。 3. 验证生成的TensorRT引擎文件是否可用。

完成模型转换后,需要将模型文件上传到阿里云对象存储(OSS)以便后续部署。根据知识库中的描述: - 模型目录结构应遵循特定格式,例如:

${model_root_path}

/engines

...

其中engines目录存放转换后的TensorRT引擎文件。

操作步骤: 1. 创建一个OSS Bucket,并确保其具有足够的存储空间。 2. 将模型文件上传到OSS Bucket,目录结构如下:

${model_root_path}

/engines

- <converted_engine_file>

在阿里云平台上创建TensorRT模型服务,具体步骤如下: 1. 登录云原生应用开发平台(CAP)控制台,进入目标项目。 2. 单击新建服务,选择模型服务类型。 3. 在基础信息区域: - 单击更多模型来源,选择对象存储 OSS。 - 填写OSS Bucket的路径(需指定为模型根路径)。 - 在执行框架中选择TensorRT。 4. 设置GPU规格,确保显存比转换后的引擎文件至少大20%。 5. 配置角色权限,确保aliyundevsdefaultrole具有访问OSS的AliyunOSSReadOnlyAccess权限。 6. 单击预览&部署,等待服务部署完成。

部署完成后,您可以通过API接口调用模型服务。根据知识库中的描述: - 使用Python代码发送POST请求,调用模型服务。

示例代码:

import requests

import json

service_url = 'YOUR_SERVICE_URL'

token = 'YOUR_SERVICE_TOKEN'

request = {"input": {"text": "测试语音识别"}}

resp = requests.post(service_url, headers={"Authorization": token}, data=json.dumps(request))

result = json.loads(resp.text)

print(result)

如果目标是将模型部署到其他边缘设备(如Jetson Nano、Raspberry Pi等),可以参考以下步骤: 1. 确保边缘设备支持TensorRT运行时环境。 2. 将转换后的TensorRT引擎文件复制到边缘设备。 3. 使用NVIDIA Triton Inference Server或其他推理框架加载引擎文件并运行推理。

通过以上步骤,您可以成功将modelscope-funasr模型部署到TensorRT或其他边缘设备上。如果有进一步的问题,请随时联系技术支持团队。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352