modelscope-funasr啥时候支持gpu部署呀?

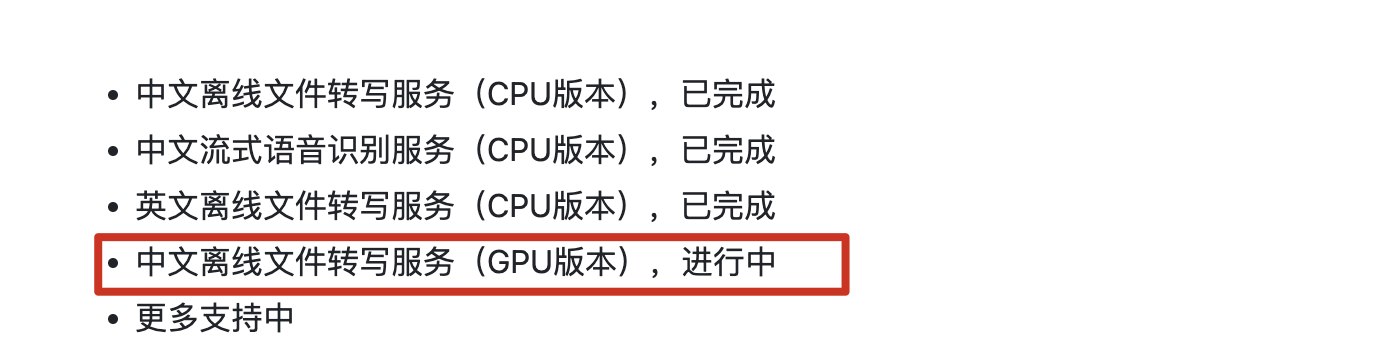

根据现有知识库资料,目前尚未明确提到ModelScope-FunASR具体支持GPU部署的时间节点。不过,从相关文档中可以推测出一些可能的线索和操作方式,供您参考:

在阿里云的相关产品中(如PAI、ACK等),已经提供了对多种模型的GPU部署支持。例如: - 在PAI平台中,大语言对话模型(如ChatGLM系列)可以通过指定GPU资源配置进行部署,建议选择ml.gu7i.c16m60.1-gu30或更高规格的GPU实例。 - 在ACK集群中,通过Arena工具可以快速部署基于GPU的大语言模型服务,并且支持自定义模型ID和版本。

这些说明表明,阿里云的基础设施已经具备了对复杂模型(包括语音处理模型)进行GPU加速的能力。

虽然目前没有直接提到FunASR支持GPU部署的具体时间,但根据ModelScope平台的通用部署流程,以下几点可能对您有帮助: - 自定义模型部署:如果FunASR模型支持GPU运行,您可以通过自定义部署的方式手动配置GPU资源。例如,在PAI平台中,您可以选择合适的GPU实例类型(如ml.gu7i.c16m60.1-gu30),并在环境变量中指定模型ID和任务类型。 - ACK中的GPU支持:如果您使用的是ACK集群,可以通过Arena工具部署FunASR模型,并指定GPU卡数(如-gpus=1)。这种方式需要确保模型本身支持GPU推理,并且容器镜像中包含必要的依赖。

为了确认FunASR模型是否已经支持GPU部署,您可以采取以下步骤: 1. 检查ModelScope官网:访问ModelScope平台,查看FunASR模型的详细页面,确认其是否标注了GPU支持的相关信息。 2. 联系技术支持:如果文档中未明确提及,建议通过阿里云的技术支持渠道咨询FunASR模型的GPU支持计划。 3. 尝试自定义部署:如果您已经获取了FunASR模型的ID和版本信息,可以尝试在PAI或ACK中按照GPU部署流程进行测试。

ack.aliyun.com/nvidia-driver-version:525.105.17指定驱动版本。综上所述,虽然目前没有明确的时间表说明ModelScope-FunASR何时支持GPU部署,但您可以通过自定义部署的方式尝试在GPU环境中运行该模型。同时,建议密切关注ModelScope平台的更新公告,或直接联系阿里云技术支持以获取最新进展。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352