数据表比较大, 有几千万行。

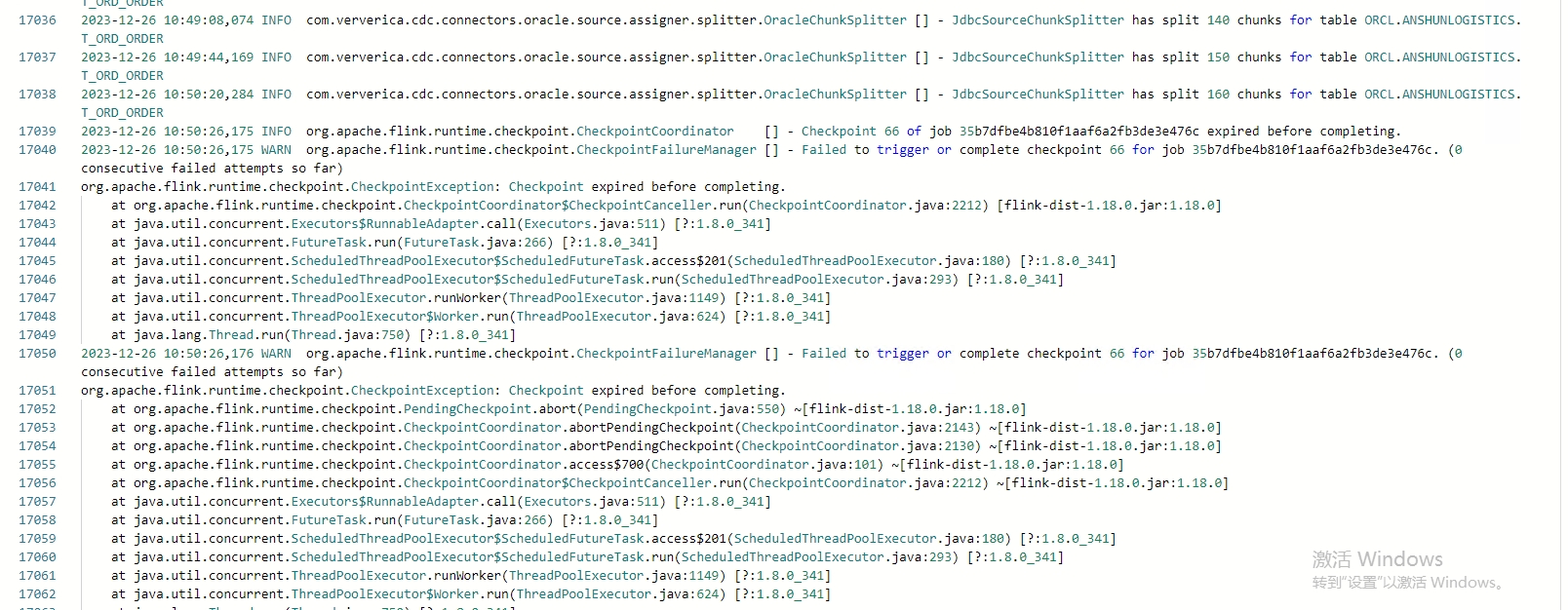

首先提示 :Use unevenly-sized chunks for table ORCL.ANSHUNLOGISTICS.T_ORD_ORDER, the chunk size is 8096

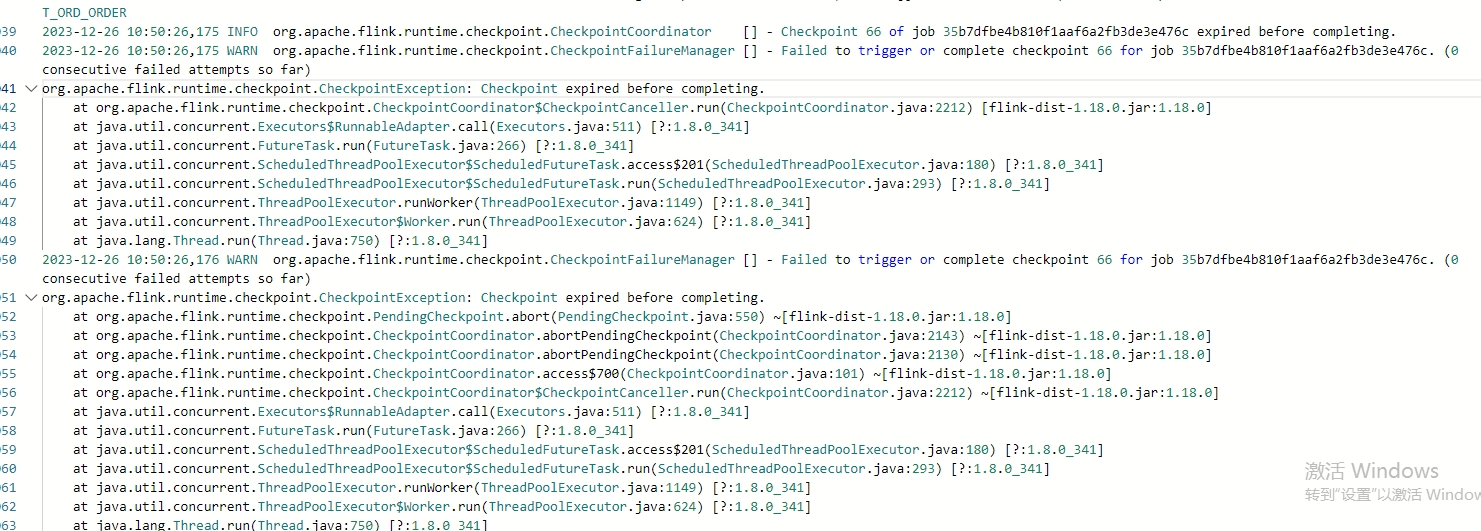

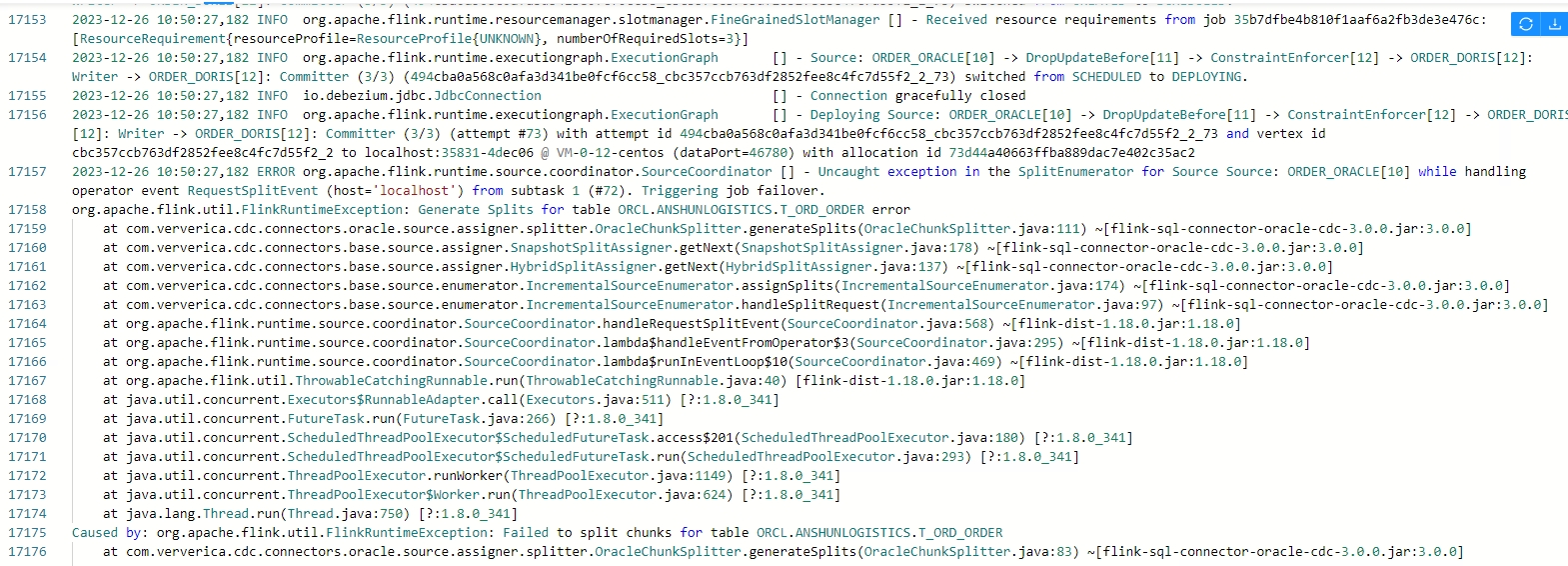

然后执行到10分钟左右,就开始报错。 请专家帮忙看看

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个错误提示"Use unevenly-sized chunks for table ORCL.ANSHUNLOGISTICS.T_ORD_ORDER, the chunk size is 8096"表示你在处理ORCL.ANSHUNLOGISTICS.T_ORD_ORDER这张大数据表时,使用的块大小是8096。对于大数据表,使用均匀大小的块可能会导致内存和性能问题。

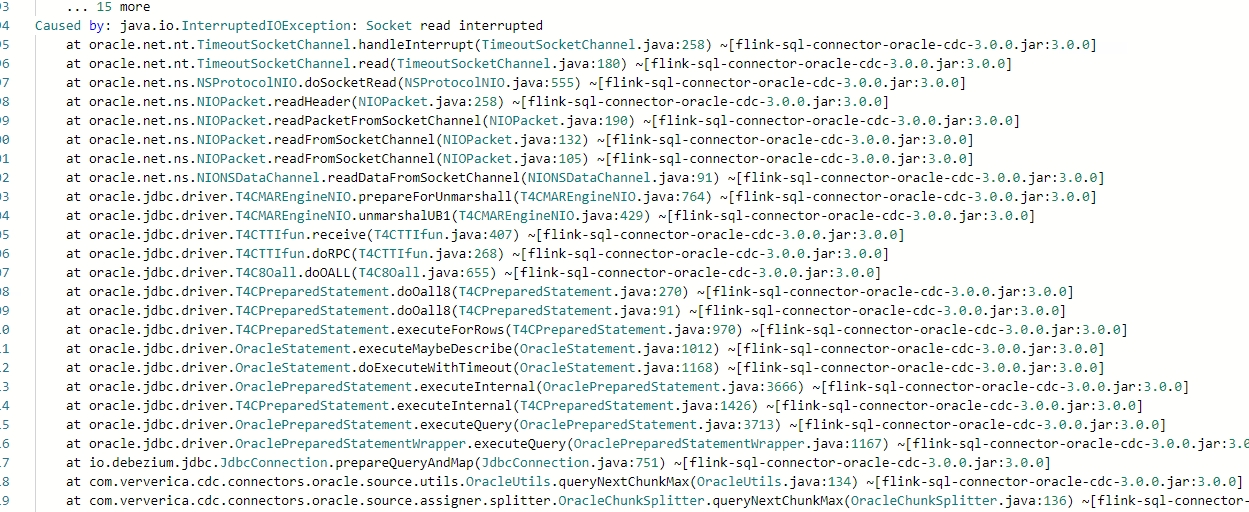

然后在执行10分钟左右开始报错,可能是由于以下原因:

内存不足:

超时问题:

锁冲突:

索引问题:

硬件限制:

为了解决这个问题,你可以尝试以下步骤:

同时,你也可以考虑使用一些大数据处理工具或者技术,如分区表、并行查询、外部排序等,来更有效地处理大数据表。