您好,目前实时FLINK是否支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步,即源ADB POSTGRESQL库发生的数据变化实时或者准实时的同步到DORIS上。

谢谢

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

参考链接

Flink 可以支持从阿里云AnalyticDB PostgreSQL版到Doris的数据实时同步。Flink 的CDC(Change Data Capture)功能可以捕获AnalyticDB PostgreSQL中的数据变更,并将这些变更实时传输至Doris。利用Flink的CDC能力和Doris Connector,可以构建一个从AnalyticDB PostgreSQL到Doris的准实时数据同步管道。不过,请注意具体的实现细节会依赖于所使用的Flink版本、connector以及Doris版本的功能支持情况。。

从官方文档总看到目前,Apache Flink本身并没有直接提供从云原生数据仓库AnalyticDB PostgreSQL到Doris的实时数据同步的功能。但是网上有解决楼主问题的方案可以通过以下步骤实现该功能:

实时FLINK是否支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步,即源ADB POSTGRESQL库发生的数据变化实时或者准实时的同步到DORIS上,看看能不能兼容。

使用CDC(Change Data Capture)工具:对于 PostgreSQL,有如 Debezium 这样的 CDC 工具可以捕获数据变更,然后通过 Flink 任务实时或准实时地同步到 Doris。

自定义开发:根据 Flink 的 DataStream 或 DataSet API,可以自定义一个 Flink 任务来实现从 PostgreSQL 到 Doris 的数据同步。

使用 Flink 与其他中间件集成:有些中间件或平台可能已经实现了从 PostgreSQL 到 Doris 的数据同步功能,并支持与 Flink 集成,例如 Apache Kafka、Apache Nifi 等。

实时FLINK是否支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步,即源ADB POSTGRESQL库发生的数据变化实时或者准实时的同步到DORIS上,目前尚无明确的结论。

如需了解实时FLINK是否支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步.

楼主你好,据我所知目前Apache Flink本身并不直接支持云原生数据仓库AnalyticDB PostgreSQL到Doris的实时数据同步,但是你可以通过使用Flink的Debezium Connector来实现这样的同步。

这种方式可以实现AnalyticDB PostgreSQL到Doris的实时数据同步,但你需要额外配置Debezium Connector来监控AnalyticDB PostgreSQL,以及根据Doris的数据结构编写相应的Flink逻辑和Doris Sink。

Flink并不直接支持从云原生数据仓库AnalyticDB PostgreSQL实时同步数据到Doris。实时数据同步通常需要特定的数据流处理和传输工具或中间件,如Apache Kafka、Debezium或GoldenGate等。

但是,您可以使用一些方法实现这一目标:

1.使用CDC(Change Data Capture)工具:对于PostgreSQL,您可以使用如pg_逻辑复制和debezium之类的工具来捕获数据变化,然后通过Flink实时处理这些变化数据。

2.自定义开发:根据您的需求,可以自定义开发一个Flink任务,该任务定期轮询AnalyticDB PostgreSQL的数据变化,并使用Flink的Table API或SQL API将变化的数据写入Doris。

3.使用消息队列:将AnalyticDB PostgreSQL的数据变化发送到消息队列(如Kafka),然后使用Flink消费这些消息并将数据写入Doris。

目前官方文档里边没有关于云原生数据仓库同步到DORIS的记录,目前只有从RDS到阿里云DB包版本之间的数据同步迁移,可以通过导入导出的情况,然后根据相关字段对对齐,看看能不能兼容。

目前还没有完整的方案支持实时FLINK从云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步。

但可以先通过Flink读写AnalyticDB PostgreSQL数据,再把Flink的数据同步到Doris。

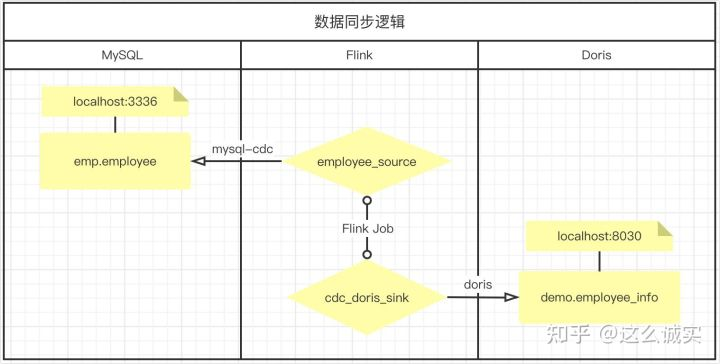

使用 Flink CDC 接入 Doris 示例

-- enable checkpoint

SET 'execution.checkpointing.interval' = '10s';

CREATE TABLE cdc_mysql_source (

id int

,name VARCHAR

,PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = '127.0.0.1',

'port' = '3306',

'username' = 'root',

'password' = 'password',

'database-name' = 'database',

'table-name' = 'table'

);

-- 支持删除事件同步(sink.enable-delete='true'),需要 Doris 表开启批量删除功能

CREATE TABLE doris_sink (

id INT,

name STRING

)

WITH (

'connector' = 'doris',

'fenodes' = '127.0.0.1:8030',

'table.identifier' = 'database.table',

'username' = 'root',

'password' = '',

'sink.properties.format' = 'json',

'sink.properties.read_json_by_line' = 'true',

'sink.enable-delete' = 'true',

'sink.label-prefix' = 'doris_label'

);

insert into doris_sink select id,name from cdc_mysql_source;

——参考链接。

实时FLINK是否支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步,取决于具体的配置和环境。

实时FLINK可以处理无界和有界数据流,包括数据并行和流水线方式。在某些情况下,将实时FLINK与云原生数据仓库AnalyticDB PostgreSQL和DORIS结合使用,可以提供更好的资源管理和调度能力,以支持大规模的数据处理和分析工作负载。

具体来说,实时FLINK可以通过数据流连接器或自定义实现来与云原生数据仓库AnalyticDB PostgreSQL和DORIS进行集成。通过集成,实时FLINK可以从AnalyticDB PostgreSQL中读取数据,并实时或准实时地将其同步到DORIS中。

然而,需要注意的是,实现实时FLINK与云原生数据仓库AnalyticDB PostgreSQL到DORIS的同步并非易事。需要仔细考虑数据的一致性、可靠性和性能等方面的问题。同时,还需要根据具体的应用需求和环境配置进行适当的评估和调整。

综上所述,实时FLINK在某些情况下可以支持云原生数据仓库AnalyticDB PostgreSQL到DORIS的实时数据同步。但具体是否支持以及如何实现,需要结合具体的需求和环境配置进行评估和调整。

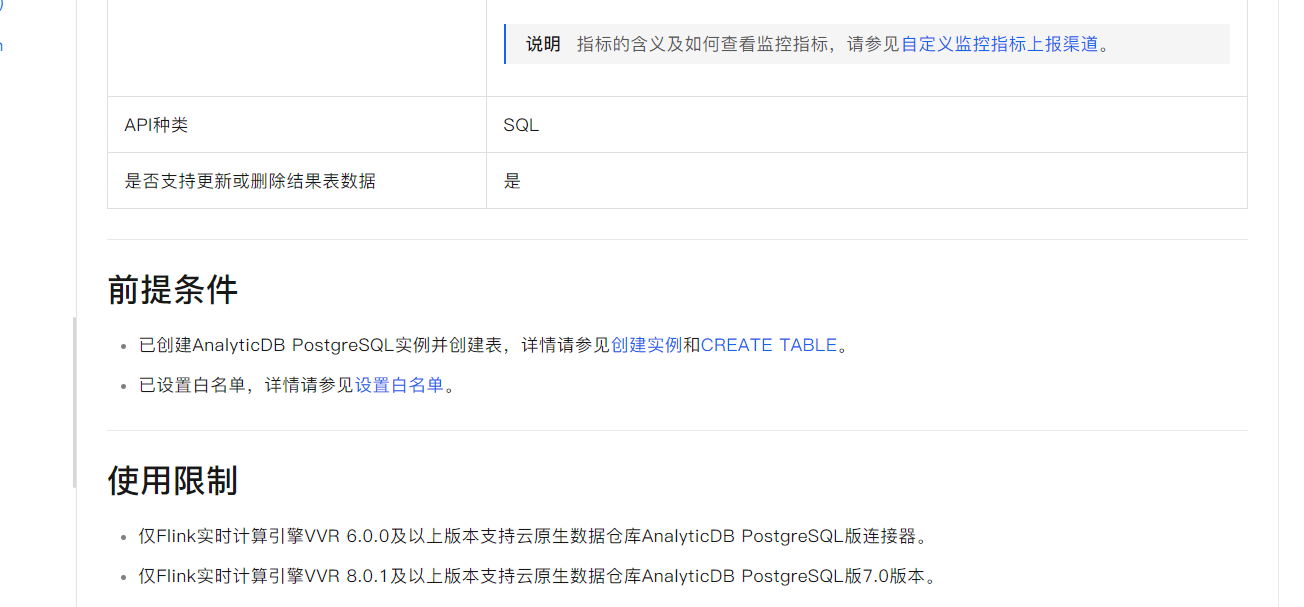

实时FLINK确实支持从云原生数据仓库AnalyticDB PostgreSQL读取数据,这种方式可以充分发挥实时FLINK确实支持从云原生数据仓库AnalyticDB PostgreSQL读取数据,这种方式可以充分发挥云原生数据仓库的优势,提高数据分析的效率和精度。然而,需要注意的是,该功能暂不支持AnalyticDB PostgreSQL版的Serverless模式。此外,仅当Flink实时计算引擎VVR 6.0.0及以上版本时,才能支持云原生数据仓库。

实时 FLINK 本身并不直接支持从云原生数据仓库 AnalyticDB PostgreSQL 到 DORIS 的实时数据同步。但是,你可以通过一些方法实现这一需求,具体取决于你的数据模型、数据量、同步频率和实时性要求。

以下是一些可能的方法:

自定义同步逻辑:

使用 Flink SQL 或 Flink DataStream API 来编写自定义的数据同步逻辑。你可以编写一个 Flink 作业,该作业读取 AnalyticDB PostgreSQL 中的数据变化,并使用 Flink 的状态管理和事件时间处理功能,将这些变化实时或准实时地同步到 DORIS。

使用 CDC(Change Data Capture)工具:

使用 CDC 工具(如 Debezium、Maxwell 等)捕获 AnalyticDB PostgreSQL 中的数据变化,并将这些变化转换为 Flink 可以处理的数据流。然后,将这个数据流连接到 Flink 作业中,实现与 DORIS 的实时同步。

利用现有的集成或中间件:

如果已经存在一些集成或中间件能够实现从 AnalyticDB PostgreSQL 到 DORIS 的实时同步,你可以考虑使用这些工具来简化你的实现。例如,一些开源项目或商业解决方案可能已经提供了这样的集成。

批处理和流处理结合:

你可以将批处理和流处理结合起来,实现一种混合的数据同步方式。例如,你可以使用批处理作业定期将大量数据从 AnalyticDB PostgreSQL 同步到 DORIS,同时使用流处理作业来实时捕获和处理数据变化。

您好,目前实时FLINK支持将云原生数据仓库AnalyticDB PostgreSQL的数据同步到DORIS上。您可以使用Flink的DTS(Data Transmission Service)功能来实现这个需求。

具体步骤如下:

虽然目前没有直接关于Flink CDC从AnalyticDB PostgreSQL到Doris实时同步的具体官方文档或案例,但考虑到Flink强大的流处理能力和其支持多种数据源和sink的能力,理论上是可以实现这一场景的实时同步的。

具体实现步骤可能包括:

要实现这一目标,需要根据实际情况编写适配器或者利用现有工具,并确保所有组件兼容且能够正常工作。同时,也需要关注性能、数据一致性等问题。

仓库AnalyticDB PostgreSQL到DORIS的实时数据同步。可以使用FLINK SQL或者Java API进行数据同步。

FLINK SQL方式:

CREATE TABLE source_table (

id INT,

name STRING,

-- other columns

)

ENGINE=OLAP

DUPLICATE KEY(id)

COMMENT 'source table'

DISTRIBUTED BY HASH(id) BUCKETS 10;

CREATE TABLE target_table (

id INT,

name STRING,

-- other columns

)

ENGINE=OLAP

DUPLICATE KEY(id)

COMMENT 'target table'

DISTRIBUTED BY HASH(id) BUCKETS 10;

INSERT INTO target_table

SELECT * FROM source_table;

Java API方式:

FlinkPipeline pipeline = FlinkPipeline.create();

DataSource source = PostgreSQLDataSource.builder()

.jdbcUrl("jdbc:postgresql://localhost:5432/source_db")

.username("username")

.password("password")

.tableName("source_table")

.build();

DataSource target = DorisDataSource.builder()

.jdbcUrl("jdbc:mysql://localhost:3306/target_db")

.username("username")

.password("password")

.tableName("target_table")

.build();

pipeline.addLast(new TableSyncTransform(source, target));

pipeline.run();

阿里云的 AnalyticDB for PostgreSQL 是一款基于 PostgreSQL 扩展的云原生实时分析型数据仓库服务,而 Apache Doris(也称为 OpenDoris)是一个面向交互式分析的高性能、实时数据分析型数据库系统。

虽然我不能提供最新实时更新的信息(截至我的知识截止日期),但根据 Apache Flink 的能力和历史项目实践,Flink CDC(Change Data Capture)功能可以实现实时或准实时的数据同步,从各种数据库(如 MySQL、PostgreSQL 等)捕获变更数据并将其同步到目标系统(如 Doris)中。在实际操作中,要将 AnalyticDB PostgreSQL 的数据实时同步到 Doris,可以通过以下步骤:

由于不同的云服务商可能会对其服务有所定制,因此在使用 Flink CDC 进行数据同步之前,需要确认 AnalyticDB PostgreSQL 是否提供了兼容 PostgreSQL 的 CDC 功能,以及是否有可用的 Flink connector 支持 AnalyticDB PostgreSQL 作为 source。

建议查阅最新的阿里云 AnalyticDB PostgreSQL 文档以及 Apache Flink 官方文档,同时关注社区是否有针对这两个系统间实时同步的相关插件或实践案例出现。如果有特殊的数据同步需求,可能需要开发定制的连接器或适配器来完成这项任务。https://help.aliyun.com/zh/flink/developer-reference/analyticdb-for-postgresql-connector?spm=a2c4g.11186623.0.0.270a1461rqBNiX

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。