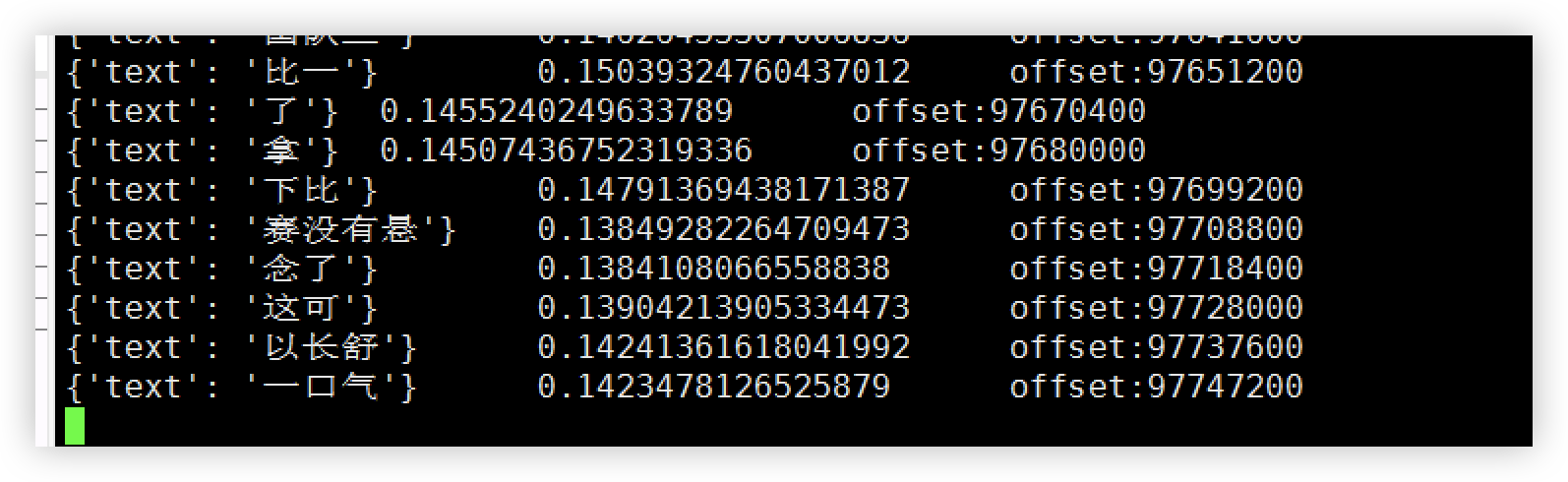

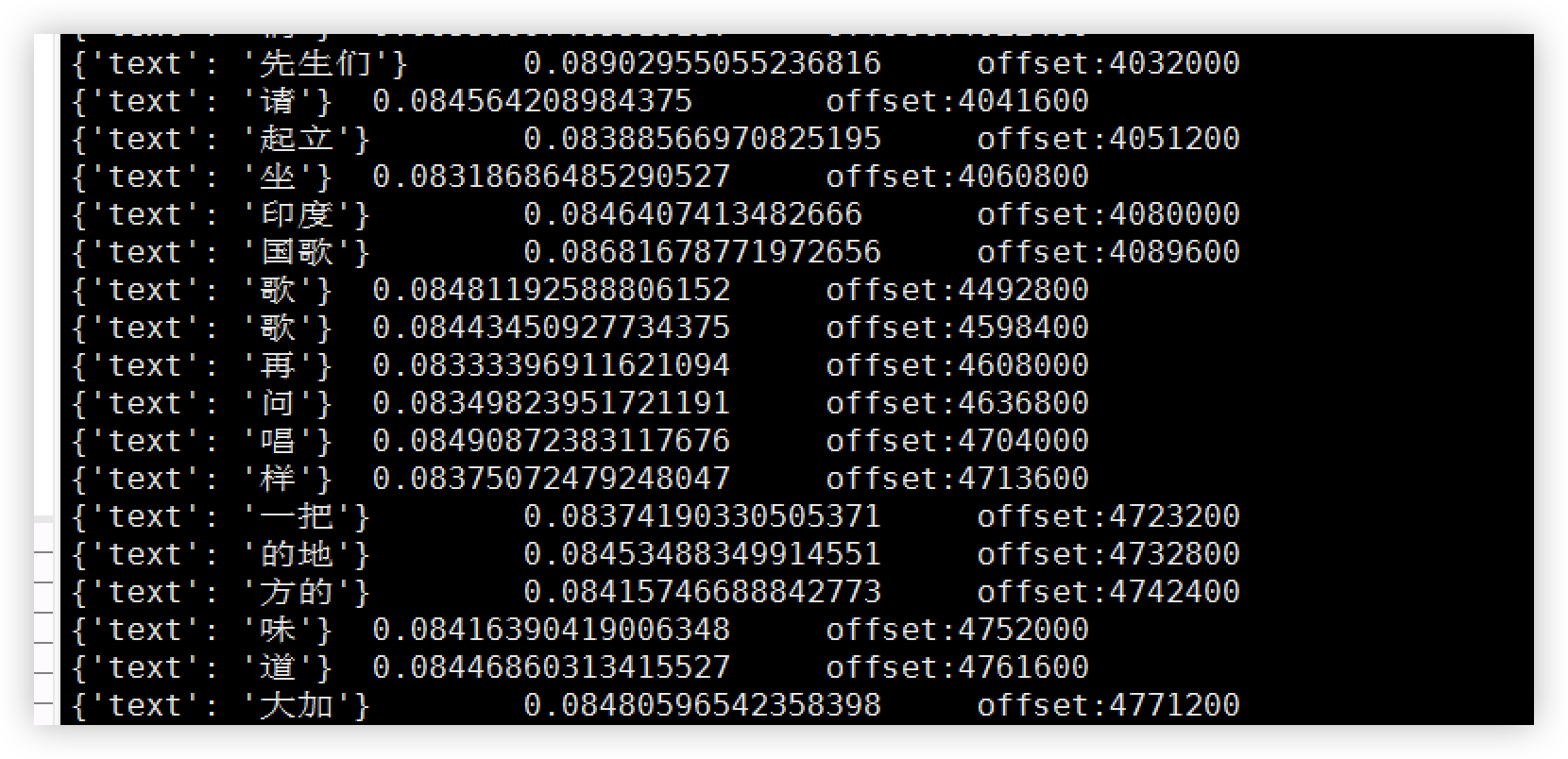

modelscope-funasr打印了推理时间和offset,目前响应时间已经逐步增加了50ms了,还在持续增加,怎么回事呢?

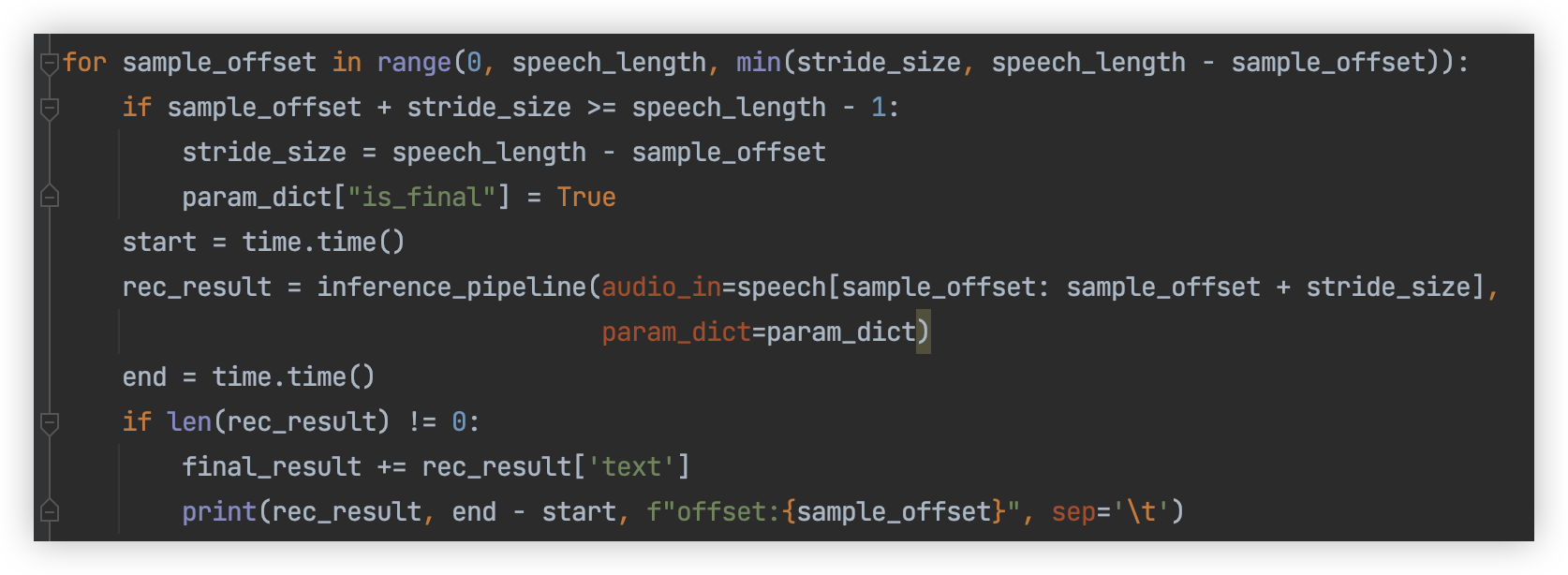

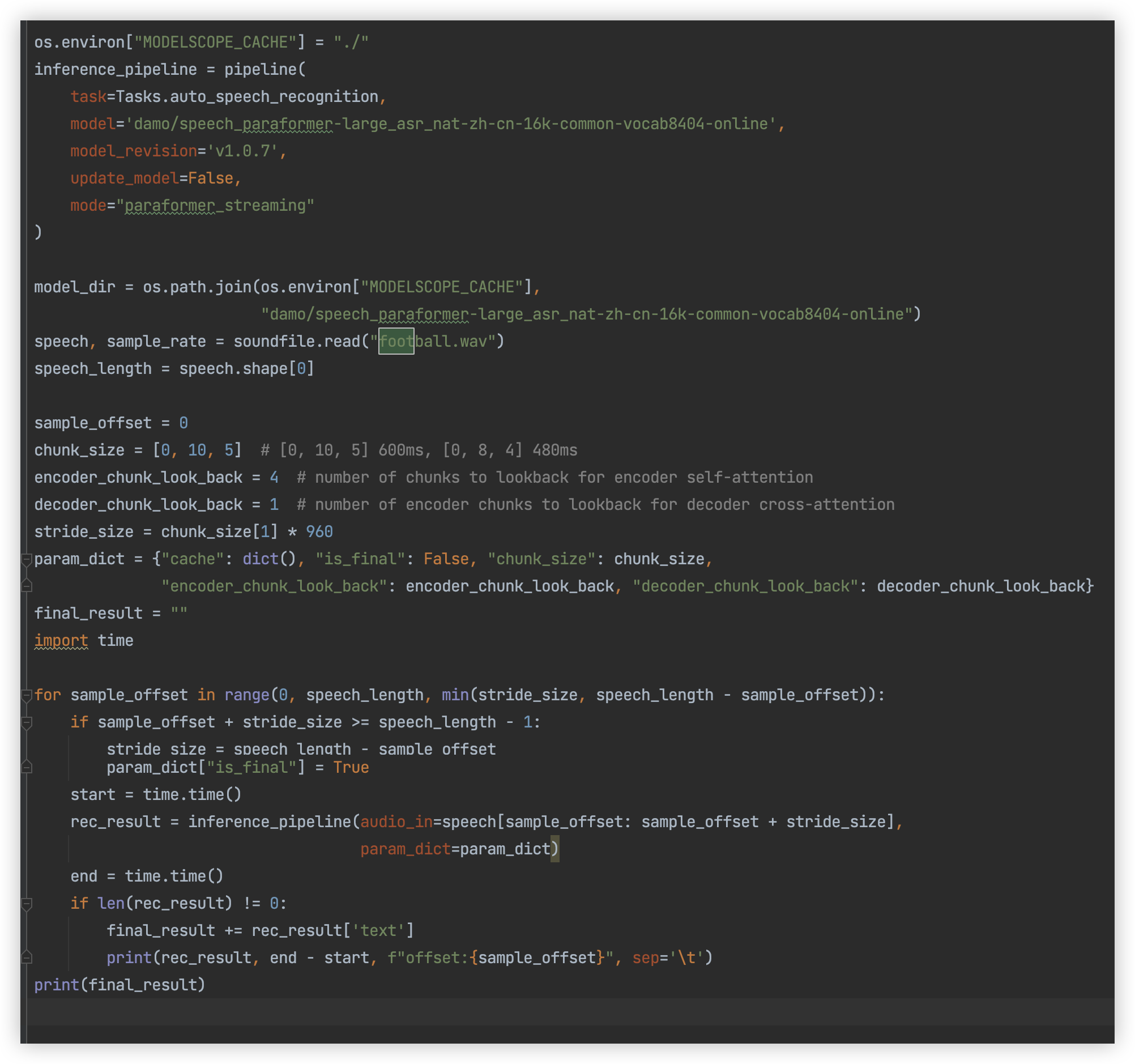

用的这个代码,只改了音频文件,打印了执行时间,其他都没改。

根据您提供的信息,modelscope-funasr 的推理时间(响应时间)逐步增加并持续上升,可能与以下几个方面的原因相关。以下是详细分析和排查建议:

随着推理任务的持续运行,系统资源(如CPU、GPU、内存或磁盘IO)可能逐渐被耗尽,导致性能下降。

可能原因:

排查方法:

nvidia-smi 命令监控显存占用,确认是否存在显存泄漏。top 或 htop 查看CPU和内存使用情况,确保没有资源耗尽的情况。iostat 或类似工具监控磁盘读写速度。解决方法:

torch.cuda.empty_cache() 清理显存。推理过程中可能存在未优化的操作,导致性能随时间逐渐下降。

可能原因:

排查方法:

Nsight Systems 或 PyTorch Profiler)分析推理过程中的瓶颈。解决方法:

如果推理服务同时处理多个请求,可能会因为并发控制不当或队列积压导致响应时间增加。

可能原因:

排查方法:

解决方法:

代码中可能存在未释放资源或未优化的逻辑,导致性能逐渐下降。

可能原因:

排查方法:

解决方法:

推理服务可能依赖外部组件(如数据库、网络服务等),这些组件的性能问题也可能导致响应时间增加。

可能原因:

排查方法:

解决方法:

根据上述分析,建议按照以下步骤逐步排查和解决问题: 1. 监控资源使用:使用 nvidia-smi 和 top 等工具检查系统资源使用情况,确认是否存在资源瓶颈。 2. 优化模型推理:确保输入尺寸一致,并使用推理优化工具(如 TensorRT 或 Deepytorch Inference)提升性能。 3. 检查代码实现:确认代码中是否存在未释放的资源或低效逻辑。 4. 分析外部依赖:检查推理服务的外部依赖,优化其性能或减少对外部服务的依赖。

如果问题仍未解决,请提供更多上下文信息(如具体的代码片段、音频文件特性、系统环境等),以便进一步分析和定位问题。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352