flink程序本地可以启动,提交到Apache Flink Dashboard上报错,怎么解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当你在本地可以成功运行Flink程序,但在提交到Apache Flink Dashboard时遇到错误,可能的原因和解决方法有很多。以下是一些常见的故障排除步骤和建议:

日志分析:

首先,查看Flink Dashboard上的Job日志或TaskManager日志。错误信息和堆栈跟踪通常会在这里显示。

如果Dashboard上的信息不够详细,你可能需要查看Flink集群的日志文件,这些文件通常位于Flink安装目录下的log文件夹中。

环境差异:

确认本地环境和集群环境是否一致,包括Flink版本、Java版本、依赖的库等。

确保所有必要的依赖都包含在提交的JAR包中,或者它们已经在集群的类路径上。

配置检查:

检查Flink的配置文件(如flink-conf.yaml和jobmanager.rpc.address等),确保集群配置正确。

如果你使用了特定的Flink功能(如检查点、保存点、状态后端等),请确认相关配置在集群中也是正确的。

资源限制:

检查集群的资源使用情况,如内存、CPU和磁盘空间。如果资源不足,可能会导致作业失败。

调整作业的并行度或资源分配,以适应集群的能力。

网络问题:

确保集群内部网络通信正常,没有防火墙或安全组策略阻止Flink组件之间的通信。

如果你的作业需要访问外部资源(如数据库、消息队列等),请检查网络连接和访问权限。

版本兼容性:

确保你的Flink程序与集群上安装的Flink版本兼容。有时,新版本会引入不兼容的更改。

依赖冲突:

如果你的JAR包和Flink集群上的库有依赖冲突,可能会导致类加载问题。使用mvn dependency:tree命令检查你的项目依赖,并尝试解决冲突。

权限问题:

确保提交作业的用户有足够的权限来访问集群资源和执行作业。

重新启动服务:

有时,简单地重启Flink集群或相关服务可以解决一些暂时性的问题。

社区支持:

如果上述步骤都无法解决问题,考虑在Flink的官方论坛、邮件列表或Stack Overflow上提问。在提问时,提供尽可能详细的信息,包括错误日志、配置文件和你的Flink版本。

记住,解决问题通常需要一步步地排查。不要忽视日志文件中的任何错误或警告信息,它们通常是解决问题的关键线索。

如果您的Flink程序在本地可以正常启动,但在提交到Apache Flink Dashboard时出现错误,可能是由于环境差异、配置问题或资源限制导致的。以下是一些建议的解决步骤:

查看错误日志:首先,仔细查看Flink Dashboard的错误日志。错误信息通常会给出问题的线索。

检查配置:确保在提交Flink作业时使用的所有配置都是正确的。这包括但不限于:flink-conf.yaml、job.properties 或任何其他特定于作业的配置。

资源限制:Flink集群可能有资源限制,例如内存或CPU。确保您的作业没有超出集群的资源限制。

依赖问题:确保所有的依赖都已正确包含在提交的jar文件中,并且与集群中的Flink版本兼容。

版本冲突:有时,不同的库版本之间可能存在冲突。确保您使用的所有库和组件都是相互兼容的。

网络问题:确保Flink Dashboard所在的机器可以访问到您的Flink程序运行的环境,并且没有防火墙或其他网络问题阻止通信。

集群状态:检查集群的健康状况和资源使用情况。有时,由于集群本身的问题,作业可能无法正常启动。

重新打包和提交:尝试重新打包您的Flink程序,并确保使用正确的命令行选项提交作业。

查看社区和文档:搜索Apache Flink的官方文档和社区论坛,看看是否有其他人遇到过类似的问题,并是否有可用的解决方案。

环境差异:确保本地开发和集群环境之间的所有环境变量、类路径和其他配置都是一致的。

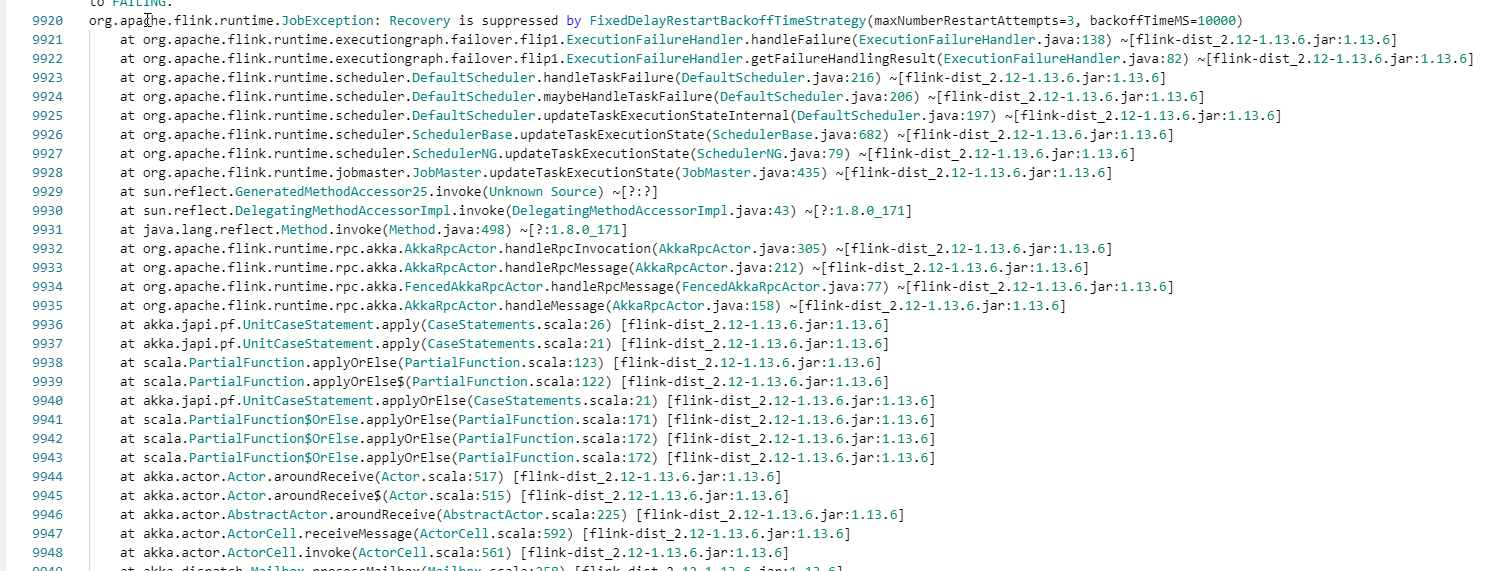

根据您提供的堆栈跟踪和错误提示,您的 Apache Flink 应用似乎遇到了一些问题,并且这些错误可能源于多个不同的原因。以下是几个常见的排查方法以及可能导致这些问题的一些常见因素:

堆栈追踪分析

从堆栈轨迹来看,有一些关键点值得特别关注:

akka.actor.ActorCell.receiveMessage() 方法抛出异常。akka.actor.Actor.aroundReceive() 方法返回未知类型的结果。akka.actor.Actor.aroundReceive($) 方法返回未知类型的值。这些异常表明可能存在以下几种情况之一:

a. 您使用的 Akka 版本或配置有问题(例如,Akka Actor 不支持某个特定的操作)。

b. 某个模块或者库未被正确地初始化或者注入。

c. 在某些情况下,可能会导致资源泄漏等问题。

排查 Akka 相关问题

请确保您的 Akka 版本是最新的,并且遵循官方文档中的最佳实践。此外,在生产环境中,强烈推荐启用 Akka监视功能,这样您可以更容易地定位问题并进行调试。

查看系统日志

收集有关应用程序行为的所有相关信息非常重要。请查阅相关的系统日log.txt文件,查找与该错误关联的关键事件。同时,还可以借助像 Prometheus 这样的监控平台来观察实时指标变化。

测试隔离环境

创建一个新的隔离环境,仅用于测试目的。在这个新环境中,尽可能模拟实际部署条件下的各种参数设置和服务交互。这有助于缩小故障源范围。

使用单元测试

对于复杂的分布式系统来说,单元测试是非常重要的。它们能有效地验证各个部分是否正常运作,而不会受到整个系统的影响。因此,如果您还没有这么做,我们建议尽快开始编写单元测试。

这个错误消息表明,Flink试图恢复(recovery)一个失败的工作进程实例,但这一行为已经被抑制(suppressed)。具体的抑制是由类名为FixedDelayRestartBackoffStrategy的对象决定的。

FixedDelayRestartBackoffStrategy是一个重启策略,其特点是每次失败之后都有固定的时间间隔才会重新尝试启动工作进程。在这个时间间隔内,如果又发现了其他失败,那么它们会被累积起来一起处理,而不是立即触发重启。

换句话说,这是一个防止过度频繁重启的方法,以减少不必要的中断和服务停机的风险。

如果你想解除这种抑制,你可以更改相关的配置,如增大最大重试次数等。但这并不是说你应该随意这么做,因为你还需要权衡性能损失和稳定性风险等因素的影响。

根据报错信息,我们可以看到问题是关于 ExecutionFailureHandler.handleFailure(ExecutionFailureHandler.java:138) 方法的。这意味着在Flink Job的执行过程中发生了未捕获到的异常。

一般来说,这种情况的原因有很多,比如Job的逻辑有问题,或者是因为硬件故障等等。然而,如果你能提供更多细节,我会更好地帮你分析问题的具体来源。

一种解决方案是从源头开始排查问题。首先,你应该检查你的Job是否有可能产生异常的地方。其次,检查你的硬件设备是否存在问题,尤其是那些被用来存放数据的硬盘驱动器。另外,你也应该考虑是否存在网络问题,以及你的操作系统是否稳定。

另一种方案是对你的Job进行详细的日志记录,这样就可以更容易地追踪到问题发生的位置。你可以使用Flink提供的Logging API来做这件事。

还有一种可能性是你正在使用的Apache Flink版本出现了已知的Bug。这时,你可以尝试降级到一个较早的版本,看是否解决了问题。

Flink无法正确地处理恢复。具体来说,错误日志中提到了"Recovery is suppressed by FixedDelayRestartBackoffTimestrategy",这意味着Flink在尝试重新启动任务时遇到了问题。

以下是一些建议,可以帮助您解决这个问题:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。