请教一下大佬们,flinkcdc同步db2的表,需要对db2做哪些配置啊?

请教一下大佬们,flinkcdc同步db2的表,需要对db2做哪些配置啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

使用Flink CDC同步DB2表需要在对DB2数据库进行以下配置:

1.启用数据库日志收集功能(logarchmeth1)。

2.配置恢复作业保留数据库日志(logged by)。

3.选择需要同步的表开启数据库日志(include table)。

4.设置数据库日志buffer大小(logbufsize)。

5.设置数据库日志组数和每个组大小(num_log_span,log_span_size)。

6.配置数据库自动归档策略(autoarchlogger)。

7.设置归档前等待时间段(logarchmeth1_delay)。

8.给cdc连接用户授予读取db2日志的权限。

9.检查数据库运行参数(dbcfg/tzone等)。

10.开启事务并发同步权限(enable_parallel_apply)。

需要注意的是,具体配置步骤可能因DB2版本、Flink CDC版本或特定应用需求而有所不同。在进行配置之前,建议参考DB2和Flink CDC的官方文档,以确保配置步骤的准确性和适用性。同时,为了确保数据同步的顺利进行,还建议进行充分的事前测试和验证。2023-09-11 09:54:49赞同 展开评论 -

要使用Flink CDC同步DB2的表,需要进行以下配置:

在DB2中创建一个用户,并授予该用户对所需数据库表的读取权限。

确保DB2数据库开启了日志记录功能。可以通过以下命令检查是否已启用:

db2 get db cfg for <database_name> | grep LOGARCHMETH1如果结果中

LOGARCHMETH1的值为OFF,则需要启用日志记录功能。可以使用以下命令启用:db2 update db cfg for <database_name> using LOGARCHMETH1 DISK:<log_archive_directory>其中,

<database_name>为数据库名称,<log_archive_directory>为日志归档目录。确保DB2数据库的日志归档目录可读取和写入。可以使用以下命令检查目录权限:

ls -l <log_archive_directory>确保Flink CDC的运行用户具有读取和写入该目录的权限。

确保DB2数据库的日志配置允许CDC连接。可以使用以下命令检查配置:

db2 get db cfg for <database_name> | grep LOGRETAIN如果结果中

LOGRETAIN的值为OFF,则需要启用CDC连接。可以使用以下命令启用:db2 update db cfg for <database_name> using LOGRETAIN RECOVERY然后重启DB2数据库以使更改生效。

2023-08-26 10:46:49赞同 展开评论 -

天下风云出我辈,一入江湖岁月催,皇图霸业谈笑中,不胜人生一场醉。

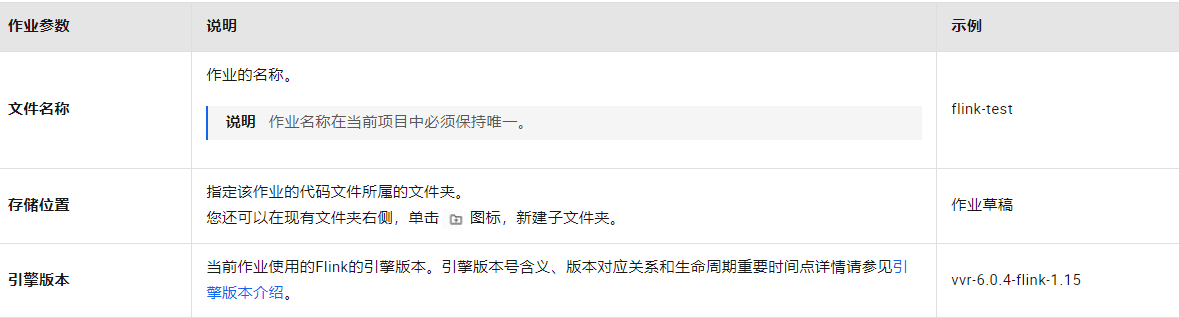

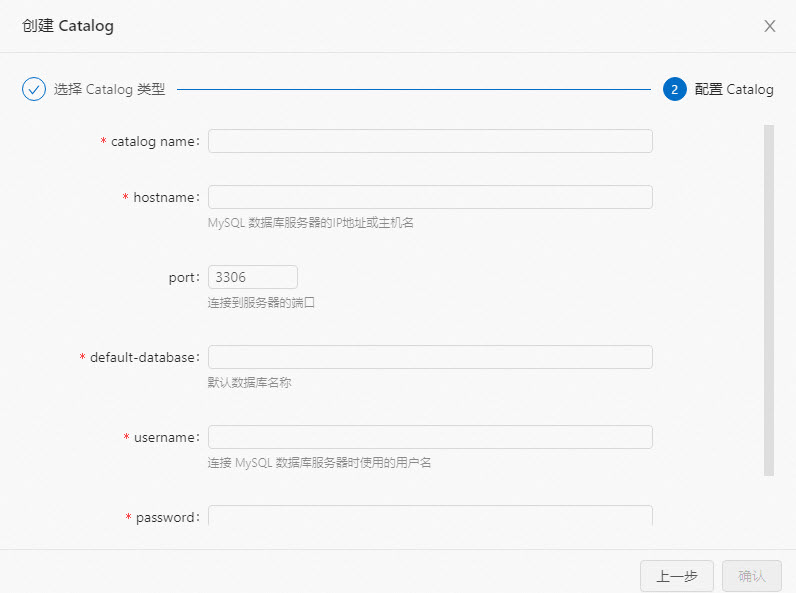

登录Flink全托管开发控制台,新建作业。

在SQL开发页面,单击新建。

单击空白的流作业草稿。

Flink全托管为您提供了丰富的代码模板和数据同步,每种代码模板都为您提供了具体的使用场景、代码示例和使用指导。您可以直接单击对应的模板快速地了解Flink产品功能和相关语法,实现您的业务逻辑,详情请参见代码模板和数据同步模版。

单击下一步。

在新建作业草稿对话框,填写作业配置信息。

单击创建。将以下作业代码拷贝到作业文本编辑区。

将tpc_ds库中所有表同步至Hologres,并将user的分库分表合并同步到Hologres的单表中。代码示例如下所示。

USE CATALOG holo;

BEGIN STATEMENT SET;

-- 同步TPCDS整库到Hologres的tpc_ds库中。

CREATE DATABASE IF NOT EXISTS tpc_ds

AS DATABASE mysql.tpc_ds INCLUDING ALL TABLES

/+ OPTIONS('server-id'='8001-8004') / ;-- 同步user分库分表到Hologres的my_user.users表中。

CREATE TABLE IF NOT EXISTS my_user.users

AS TABLE mysql.user_db[0-9]+.user[0-9]+

/+ OPTIONS('server-id'='8001-8004') /;END;

将tpc_ds库中所有表同步至Hologres使用CDAS (CREATE DATABASE AS) 语法来实现,将user的分库分表合并同步到Hologres的单表使用CTAS (CREATE TABLE AS) 语法来实现,最后再使用STATEMENT SET语法将这两条SQL语句合并在一个作业中提交。Flink会自动为Source进行优化,复用一个Source节点读取多张MySQL表的数据,这能显著降低MySQL的连接数和读取压力,提升稳定性。

在SQL开发页面,单击部署后,在弹出的对话框中,单击确认。

在作业运维页面,单击目标作业操作中的启动。填写配置信息,详情请参见作业启动。单击启动。

作业启动后,您可以在作业运维页面观察作业的运行信息和状态。

2023-08-25 15:57:31赞同 展开评论

2023-08-25 15:57:31赞同 展开评论 -

在使用 Flink CDC 同步 DB2 表时,需要对 DB2 数据库进行以下配置:

1、启用日志捕获:DB2 数据库需要启用日志捕获功能,以便 Flink CDC 能够捕获数据库的变化。可以通过以下步骤启用日志捕获:

- 使用 DB2 Control Center 或 DB2 Control Center Command Center (CCECM) 工具登录到 DB2 数据库实例。

- 在“配置”选项卡中,选择“数据库配置”。

- 在“数据库配置”页面上,选择要捕获日志的数据库,并单击“启动日志捕获”。

- 在“日志捕获”选项卡上,选择要捕获的表或模式,并配置其他选项。

2、配置日志阅读器:Flink CDC 需要能够读取 DB2 的日志文件以捕获数据库的变化。你需要为 Flink CDC 配置日志阅读器。以下是一些配置步骤供参考:

- 创建一个用户,该用户具有读取 DB2 日志文件的权限。

- 在 Flink 的配置文件(flink-conf.yaml)中,添加以下配置项:

将 your_db2_username、your_db2_password、your_db2_database_name、your_db2_host 和 your_db2_port 替换为实际的 DB2 连接信息。yaml`flink.connector.db2.username=your_db2_username flink.connector.db2.password=your_db2_password flink.connector.db2.dbname=your_db2_database_name flink.connector.db2.url=jdbc:db2://your_db2_host:your_db2_port/your_db2_database_name`

3、配置 Flink CDC:在 Flink 应用程序中,你需要配置 Flink CDC 来同步 DB2 表。以下是一些配置步骤供参考:

- 在 Flink 应用程序中,使用 Flink CDC 的 TableSource 接口定义一个表源,指定要同步的 DB2 表。

- 在 Flink 配置文件(flink-conf.yaml)中,添加以下配置项:

将 your_db2_port、your_db2_username、your_db2_password、your_db2_database_name 和 your_db2_table_name 替换为实际的连接信息。yaml`cdc.source.db2.port: your_db2_port cdc.source.db2.username: your_db2_username cdc.source.db2.password: your_db2_password cdc.source.db2.database: your_db2_database_name cdc.source.db2.table: your_db2_table_name`

这些配置步骤可以帮助你设置 Flink CDC 以同步 DB2 表

2023-08-22 16:56:00赞同 展开评论 -

十分耕耘,一定会有一分收获!

楼主你好,要使用阿里云Flink CDC同步DB2的表,需要根据具体情况进行以下配置:

配置DB2的日志模式为Archive Log Mode,以便能够通过CDC实时捕获数据变化。

在DB2上创建一个用户,并为该用户授予足够的权限,以便该用户可以访问需要同步的表。

安装DB2 JDBC驱动程序,并将其添加到Flink CDC的运行时classpath中。

在Flink CDC配置文件中指定DB2的连接信息,包括DB2的地址、端口、数据库名称、用户名和密码等。

配置Flink CDC所需的元数据表和数据表,以便能够正确地捕获和同步数据。

配置Flink CDC的运行参数,例如日志刷新时间和最大批次大小等。

启动Flink CDC并监控其运行状态,以及处理可能出现的错误和异常情况。

请注意,上述配置仅供参考,具体步骤可能因环境和需求而异。在实际使用中,请根据具体情况进行调整和优化。

2023-08-21 10:48:48赞同 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

要使用Flink CDC同步DB2的表,您需要进行以下配置:

安装和配置Flink CDC:首先,您需要安装并配置Flink CDC。可以根据文档中提供的指南进行安装和配置,包括配置Flink集群、启动CDC服务等。

配置DB2数据库:在DB2数据库中,您需要进行一些配置以支持CDC。具体的配置包括:

开启CDC日志:确保在DB2数据库中已经开启了CDC日志功能。可以通过执行

db2 update db cfg using LOGARCHMETH1 DISK:/path/to/log/archive命令来配置CDC日志的存储位置。创建CDC用户:为CDC操作创建一个专用的用户,并授予相应的权限。这个用户将用于Flink CDC连接到DB2数据库,并读取CDC日志。

配置CDC日志目标:在DB2数据库中,您需要指定CDC日志的目标。可以使用

db2start工具或在DB2配置文件中设置cdc_log_target参数来指定CDC日志的目标。例如,可以设置为dbdir://path/to/cdc/logs表示日志存储在特定目录。

配置Flink CDC连接:接下来,您需要在Flink CDC配置中指定连接到DB2数据库的相关信息。这包括DB2数据库的地址、端口、用户名、密码等。您可以在Flink CDC的配置文件中进行相应的设置。

创建Flink CDC任务:最后,您需要创建一个Flink CDC任务来定义同步DB2表的规则和目标。在任务中,您可以指定要同步的DB2表、CDC日志的位置、目标数据存储等信息。

2023-08-17 13:43:05赞同 展开评论 -

授予Flink用户访问DB2的权限:为了让Flink能够访问DB2数据库,需要在DB2中授予Flink用户相应的访问权限。可以使用DB2的授权命令来完成权限的授予。

2023-08-15 18:40:35赞同 展开评论 -

在使用Flink CDC同步DB2表数据之前,需要对DB2数据库做一些配置。具体的配置步骤如下:

确认DB2版本:Flink CDC支持DB2 v9.7及以上版本。在开始配置之前,请确保你正在使用受支持的DB2版本。

安装DB2 JDBC驱动程序:Flink CDC需要使用DB2 JDBC驱动程序来连接数据库。请从官方网站上下载并安装适用于你的DB2版本的JDBC驱动程序。

配置DB2用户权限:为了使Flink CDC能够访问DB2数据库,需要为Flink CDC所使用的用户授予适当的权限。请确保该用户至少拥有以下权限:SELECT、CONNECT、DATAACCESS、BINDADD、QUIESCE_CONNECT、CREATE_NOT_FENCED等。

开启日志记录功能:Flink CDC需要DB2数据库开启日志记录功能,以便在数据库发生更改时捕获增量变更。请确认DB2的日志记录功能已经开启,并且在数据库中至少存在一个日志文件。

配置Flink CDC参数:在Flink CDC中,需要配置以下参数来连接DB2数据库:

jdbc.driverClass:指定DB2 JDBC驱动程序的类名。jdbc.url:指定DB2数据库的连接URL。jdbc.username:指定用于连接DB2数据库的用户名。jdbc.password:指定用于连接DB2数据库的密码。database.server.name:指定要监视的DB2数据库的名称。database.history.kafka.bootstrap.servers:指定Kafka集群的地址。database.history.kafka.topic:指定用于存储数据库历史记录的Kafka主题名称。

2023-08-15 11:23:42赞同 展开评论 -

北京阿里云ACE会长

Flink CDC同步DB2表,需要在DB2数据库端做以下配置:

启用数据库日志收集功能(LOGARCHMETH1)

配置恢复作业保留数据库日志(LOGGED BY)

选择需要同步的表开启数据库日志(INCLUDE TABLE)

设置数据库日志Buffer大小(LOGBUFSIZE)

设置数据库日志组数和每个组大小(NUM_LOG_SPAN、LOG_SPAN_SIZE)

配置数据库自动归档策略(AUTOARCHLOGGER)

设置归档前等待时间段(LOGARCHMETH1_DELAY)

给CDC连接用户授予读取DB2日志的权限

检查数据库运行参数(DBCFG/TZONE等)

需要开启事务并发同步权限(ENABLE_PARALLEL_APPLY)

主要是开启数据库日志功能、配置需要追踪的表,给CDC用户正确的访问权限。

DB2数据库端配置好上述参数后,Flink CDC就可以从DB2数据库日志中读取变更数据同步了。

2023-08-14 15:40:29赞同 展开评论 -

全栈JAVA领域创作者

如果您想要使用Flink CDC同步DB2数据库的表,可以通过以下方式进行:

查看Flink CDC的配置文件:在Flink CDC的配置文件中,可以查看connector参数,以确定Flink CDC支持的数据库类型。例如,如果您的Flink CDC支持连接DB2数据库,那么您可以在connector参数中指定DB2数据库的连接信息。

查看Flink CDC的启动命令:在Flink CDC的启动命令中,可以查看--add-plugins参数,以确定Flink CDC支持的数据库类型。例如,如果您的Flink CDC支持连接DB2数据库,那么您可以在--add-plugins参数中指定DB2数据库的插件信息。

需要注意的是,如果您在生产环境中使用Flink CDC同步DB2数据库的表,那么您需要确保Flink CDC使用的是稳定版本的DB2数据库连接器。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。2023-08-14 13:50:15赞同 展开评论 -

在使用 Flink CDC 同步 DB2 数据库表之前,您需要完成以下配置:

DB2 数据库配置:首先,确保您已正确配置了 DB2 数据库。这包括安装适当的 DB2 客户端和驱动程序,并确保您具有与数据库进行连接所需的正确权限和凭据。

CDC 日志设置:DB2 支持 CDC(Change Data Capture)功能,您需要在 DB2 数据库中启用并配置 CDC 日志。请参考 DB2 的官方文档,了解如何启用 CDC 并正确配置日志。

Flink CDC 配置文件:在 Flink CDC 的配置文件中,您需要指定正确的 DB2 数据库连接信息。这包括数据库的地址、端口号、用户名和密码等。确保您的配置与实际数据库环境相匹配。

表过滤配置:如果您只想同步特定的 DB2 表,可以在 Flink CDC 的配置中添加相应的表过滤规则。这可以是正则表达式或通配符,用于指定要包含或排除的表。

数据格式转换配置:根据 DB2 表的数据类型,您可能需要在 Flink CDC 的配置中进行适当的数据格式转换。例如,将 DB2 的日期时间类型转换为 Flink 所支持的日期时间类型。

2023-08-14 10:21:15赞同 展开评论

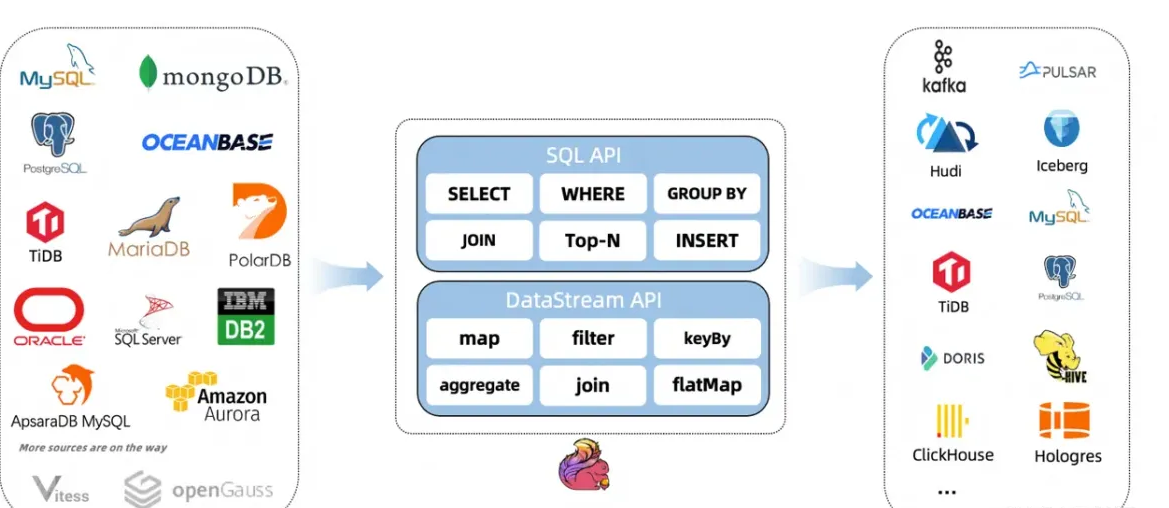

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。